Представляю вашему вниманию очередной выпуск обзора наиболее интересных материалов, посвященных теме анализа данных и машинного обучения.

Читать полностью »

Рубрика «data mining» - 74

Обзор наиболее интересных материалов по анализу данных и машинному обучению №37 (23 февраля — 1 марта 2015)

2015-03-01 в 16:07, admin, рубрики: big data, data mining, data science, data science digest, high scalability, machine learning, машинное обучениеКак мы готовим будущих специалистов по большим данным

2015-02-27 в 12:11, admin, рубрики: big data, BigData, data mining, data science, Hadoop, machine learning, nosql, Блог компании New Professions Lab, машинное обучение, метки: hadoop, it образованиеВ эту субботу стартует наша программа “Специалист по большим данным”: она получилась такой насыщенной, что, кажется, в ближайшие три месяца у слушателей не останется никакого свободного времени. В этом посте я расскажу, как именно мы будем растить специалистов по Big Data, и как будет построен процесс обучения во время первого месяца.

Центральный кейс на этот период — создание DMP-системы. DMP (data management platform) анализирует интернет-логи пользователей и, исходя из их поведения в сети, присваивает этим людям различные свойства или причисляет к определенным классам. Например, правильно настроенная DMP-система может определить пол и возраст человека и узнать, является ли он гаджетоманом или, скажем, фанатом люксовых фешн-брендов. Этот кейс мы разрабатываем совместно с компанией Data-Centric Alliance, они используют большие данные для настройки рекламных кампаний.Читать полностью »

Обучение на больших данных: Spark MLlib

2015-02-26 в 13:53, admin, рубрики: Apache, big data, data mining, Hadoop, python, spark, анализ данных, Большие данные, машинное обучение, разработкаПривет!

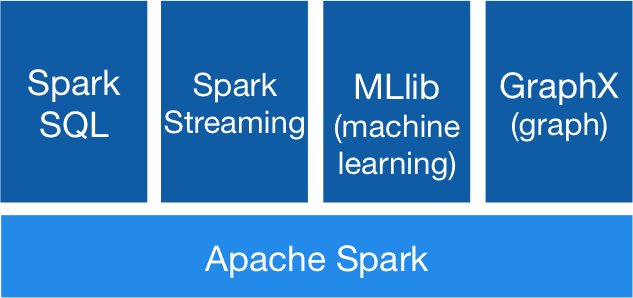

В прошлый раз мы познакомились с инструментом Apache Spark, который в последнее время становится чуть ли не самым популярным средством для обработки больших данных и в частности, Large Scale Machine Learning. Сегодня мы рассмотрим подробнее библиотеку MlLib, а именно — покажем, как решать задачи машинного обучения — классификации, регресии, кластеризации, а также коллаборативной фильтрации. Кроме этого покажем, как можно исследовать признаки с целью отбора и выделения новых (т.н. Feature Engineering, о котором мы говорили ранее, причем не один раз).

Читать полностью »

Apache Spark: что там под капотом?

2015-02-26 в 0:46, admin, рубрики: Apache, big data, big data analytics, data mining, Hadoop, mpp, spark, sparsql, параллельные вычисленияВступление

В последнее время проект Apache Spark привлекает к себе огромное внимание, про него написано большое количество маленьких практических статей, он стал частью Hadoop 2.0. Плюс он быстро оброс дополнительными фреймворками, такими, как Spark Streaming, SparkML, Spark SQL, GraphX, а кроме этих «официальных» фреймворков появилось море проектов — различные коннекторы, алгоритмы, библиотеки и так далее. Достаточно быстро и уверенно разобраться в этом зоопарке при отсутсвие серьезной документации, особенно учитывая факт того, что Spark содержит всякие базовые кусочки других проектов Беркли (например BlinkDB) — дело непростое. Поэтому решил написать эту статью, чтобы немножко облегчить жизнь занятым людям.

Небольшая предыстория:

Spark — проект лаборатории UC Berkeley, который зародился примерно в 2009г. Основатели Спарка — известные ученые из области баз данных, и по философии своей Spark в каком-то роде ответ на MapReduce. Сейчас Spark находится под «крышей» Apache, но идеологи и основные разработчики — те же люди.

Spoiler: Spark в 2-х словах

Spark можно описать одной фразой так — это внутренности движка массивно-параллельной СУБД. То есть Spark не продвигает свое хранилище, а живет сверх других (HDFS — распределенная файловая система Hadoop File System, HBase, JDBC, Cassandra,… ). Правда стоит сразу отметить проект IndexedRDD — key/value хранилище для Spark, которое наверное скоро будет интегрировано в проект.Также Spark не заботится о транзакциях, но в остальном это именно движок MPP DBMS.

RDD — основная концепция Spark

Ключ к пониманию Spark — это RDD: Resilient Distributed Dataset. По сути это надежная распределенная таблица (на самом деле RDD содержит произвольную коллекцию, но удобнее всего работать с кортежами, как в реляционной таблице). RDD может быть полностью виртуальной и просто знать, как она породилась, чтобы, например, в случае сбоя узла, восстановиться. А может быть и материализована — распределенно, в памяти или на диске (или в памяти с вытеснением на диск). Также, внутри, RDD разбита на партиции — это минимальный объем RDD, который будет обработан каждым рабочим узлом.

Британский стартап помог пассажирам экономить 22% на каждом путешествии по железной дороге

2015-02-24 в 11:59, admin, рубрики: data mining, билеты, железные дороги, кое-кто читает теги, Лайфхаки для гиков, электронная коммерция

Британцы Ник Браун, Майк Ричардсон и Джордж Сиккинг создали сервис, который позволил тем, кто пользуется железными дорогами Соединённого Королевства, экономить, в среднем, 22% на каждом путешествии. По словам разработчиков, ранее занимавшихся реселлингом билетов онлайн и внимательно изучивших данные по стоимости билетов, перевозчики искусственно завышают цены на 42%. Анализ этих данных позволил им создать алгоритм, благодаря которому конечную стоимость поездки удалось значительно снизить.Читать полностью »

Необычные модели Playboy, или про обнаружение выбросов в данных c помощью Scikit-learn

2015-02-23 в 0:15, admin, рубрики: anomaly detection, data mining, machine learning, outlier detection, pandas, PCA, python, scikit-learn, unsupervised learning, Алгоритмы Мотивированный статьей пользователя BubaVV про предсказание веса модели Playboy по ее формам и росту, автор решил углубиться if you now what I mean в эту будоражащую кровь тему исследования и в тех же данных найти выбросы, то есть особо сисястые модели, выделяющиеся на фоне других своими формами, ростом или весом. А на фоне этой разминки чувства юмора заодно немного рассказать начинающим исследователям данных про обнаружение выбросов (outlier detection) и аномалий (anomaly detection) в данных с помощью реализации одноклассовой машины опорных векторов (One-class Support Vector Machine) в библиотеке Scikit-learn, написанной на языке Python.

Обзор наиболее интересных материалов по анализу данных и машинному обучению №36 (16 — 22 февраля 2015)

2015-02-22 в 13:51, admin, рубрики: big data, data mining, data science, data science digest, high scalability, machine learning, машинное обучение

Представляю вашему вниманию очередной выпуск обзора наиболее интересных материалов, посвященных теме анализа данных и машинного обучения.

Читать полностью »

[доморощенный] web honeypot своими руками

2015-02-19 в 11:34, admin, рубрики: data mining, php, информационная безопасность, обучение, Программирование, метки: php В статье Что и зачем ищут на сайтах «боты тёмной стороны силы» мы рассмотрели типичные примеры из журналов разных сайтов.

Однако, намного интереснее вариация на тему радиоигры в разведке. Что это такое и как его готовить — расскажу далее.

Читать полностью »

Введение в Apache Spark

2015-02-17 в 10:36, admin, рубрики: Apache, big data, data mining, Hadoop, python, spark, машинное обучение, разработка, метки: Big DataПривет!

В прошлый раз мы рассмотрели замечательный инструмент Vowpal Wabbit, который бывает полезен в случаях, когда приходится обучаться на выборках, не помещающихся в оперативную память. Напомним, что особенностью данного инструмента является то, что он позволяет строить в первую очередь линейные модели (которые, к слову, имеют хорошую обобщающую способность), а высокое качество алгоритмов достигается за счет отбора и генерации признаков, регуляризации и прочих дополнительных приемов. Сегодня рассмотрим инструмент, который более популярен и предназначен для обработки больших обьемов данных — Apache Spark.

Читать полностью »

Поиск похожих документов с MinHash + LHS

2015-02-16 в 9:31, admin, рубрики: big data, data mining, jaccard, lhs, minhash, Алгоритмы, похожие множества, метки: jaccard, lhs, minhash, похожие множества В этой публикации я расскажу о том, как можно находить похожие документы с помощью MinHash + Locality Sensitive Hashing. Описание LHS и Minhash в «Википедии» изобилует ужасающим количеством формул. На самом деле все довольно просто.

Читать полностью »