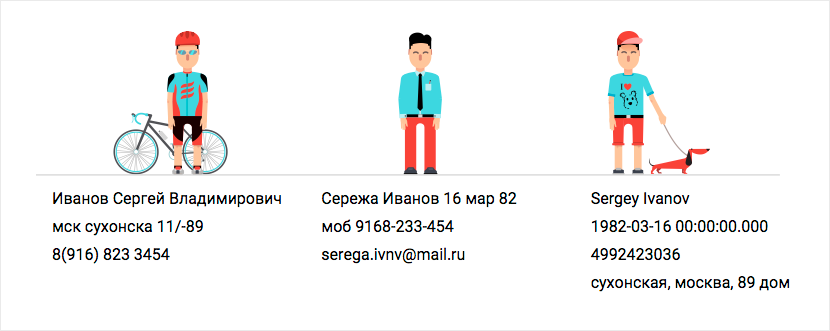

DaData.ru автоматически исправляет ошибки в адресах, ФИО и телефонах. Находит и объединяет одинаковых клиентов в базе. Помогает быстро ввести адрес и ФИО покупателя, а также и реквизиты компании на форме заказа. Есть API и javascript-виджет.

В предыдущем выпуске Дадата помогала бороться с дублями. А сейчас мы снова причинили добро:

- бесплатно находим дубликаты в файлах до 100 записей;

- снизили стоимость сервиса дедупликации до 5-10 копеек за запись;

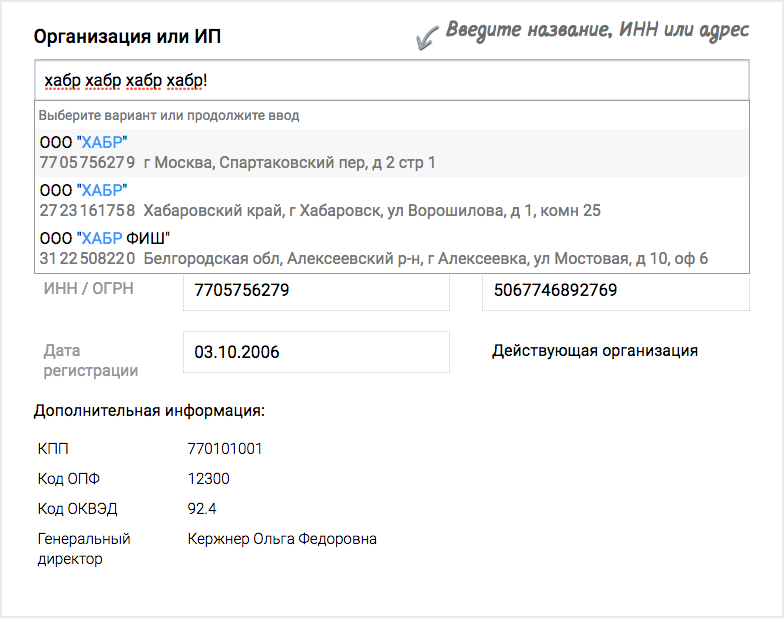

- подключили актуальные справочники налоговой службы в подсказках по компаниям.