В начале года мы рассказали о том, как подключали третью зону доступности в нашем облаке: почему вернулись к Ethernet, как развёртывали сети и собирали честный кворум для распределённых сервисов.

В начале года мы рассказали о том, как подключали третью зону доступности в нашем облаке: почему вернулись к Ethernet, как развёртывали сети и собирали честный кворум для распределённых сервисов.

Пусть надо мной посмеются сетевые инженеры в больших интеграторах, у которых есть доступ к топовому оборудованию за кучу килобаксов. Я хочу рассказать о том, как можно получить свою домашнюю сетку, которая будет быстрой, и не разориться.

— А у нас есть какой-нибудь снимок за январь, ближе к февралю?

— Сейчас посмотрим… Да, есть! Сейчас откроем.

Бывает так, что есть среднее время жизни тестовой базы, есть согласованное всеми заинтересованными время жизни снэпшотов, но какая-то из сред слишком долго «засиживается» на своём снимке, который никак не удаляется… а потом он оказывается полезен коллегам. И минус на минус даёт плюс.

Обычно для любых систем, в которых может что-то происходить, требуется формировать бэкапы. А если она ещё и развивается и дорабатывается, то где-то также разворачивать среды разработки и тестирования. Причём для бэкапов и сред тестирования, которые работают, по сути, с теми же данными, нужно немало места. А ещё эти среды надо как-то приводить к актуальному состоянию. И всё это требует аппаратных и временных ресурсов.

В нашем случае, эти потребности покрыли Oracle ZFS Storage Appliance и серверы Oracle / Sun, которые фактически слились в одну экосистему с Exadata, появившейся незадолго до них.

Читать полностью »

В этой статье мы проведем небольшой обзор наиболее популярных протоколов, которые используются для построения сетей хранения данных (SAN). Также рассмотрим перспективы развития и использования отдельных протоколов, опираясь на общедоступные роудмапы производителей.

Читать полностью »

Моделирование сложных физических процессов в наши дни рассматривается как важная технологическая возможность многими современными компаниями. Широко используемым сейчас подходом для создания вычислителей, способных рассчитывать сложные модели, является создание кластерных систем, где вычислительный узел представляет собой сервер общего назначения, подключенный к сети малой латентности и управляемый своей собственной ОС (как правило, из семейства GNU/Linux).

Введение виртуализационного слоя в системное ПО вычислительных кластеров, позволяет в течение нескольких минут создавать “виртуальный кластер”. Такие виртуальные кластера в рамках одной OpenStack инфраструктуры являются абсолютно независимыми. Пользовательские программы внутри них могут изменяться так, как нужно пользователю без каких-либо согласований с кем-либо, а логические устройства, на которых находятся пользовательские данные, недоступны другим виртуальным кластерам.

Поддержка сети малой латентности виртуализационными решениями представляет собой отдельную сложную проблему. Для прикладных программ в большинстве случаев современная виртуализация на основе KVM приводит к минимальным потерям вычислительной мощности (<1%). Однако специализированные тесты сетей малой латентности показывают накладные расходы от виртуализации не более 20% на операциях синхронизации.

Читать полностью »

Предисловие

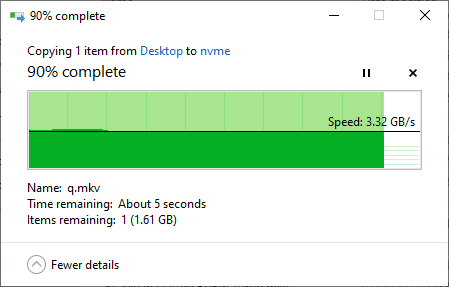

Пропускная способность внутри облака — этот пункт очень важен с технологической точки зрения. Это щепетильный момент, очень многие поставщики неохотно говорят на эту тему. Они не хотят раскрывать структуру своей сети. Но если посмотреть на суть вопроса, то от этого зависит насколько качественную услугу вы купите у провайдера. Это во многом зависит от скорости внутри облака. Как ноды соединены между собой? На каких скоростях? По каким протоколам? Сервисы многих предприятий вполне могут работать на 1 гигабите, но нужно учесть, что большинство провайдеров используют 10G, и только самые продвинутые строят свои облака на 40G или InfiniBand 56G.

Под катом пару мыслей о том, почему для нашего облака мы выбрали именно InfiniBand.

Читать полностью »

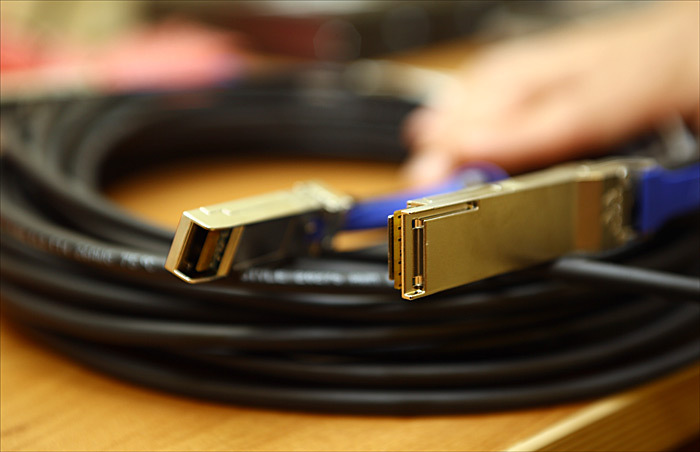

Кабель Mellanox MC2609125-005

В нашем случае Infiniband работал бы в пять раз быстрее, чем Ethernet, а стоил бы столько же. Сложность была только одна – всё это нужно было делать без прерывания облачных сервисов в ЦОДе. Ну, это примерно как пересобрать двигатель автомобиля во время движения.

В России таких проектов попросту не было. Все, кто до сих пор пытались переходить с Ethernet на Infiniband, так или иначе останавливали свою инфраструктуру на сутки-двое. У нас же в облачном «плече», которое находится в дата-центре на Волочаевской-1, около 60 крупных заказчиков (включая банки, розницу, страховые и объекты критичной инфраструктуры) на почти 500 виртуальных машинах, размещенных на примерно сотне физических серверов. Мы первые в стране получили опыт перестроения стораджевой и сетевой инфраструктуры без даунтаймов и немного гордимся этим.

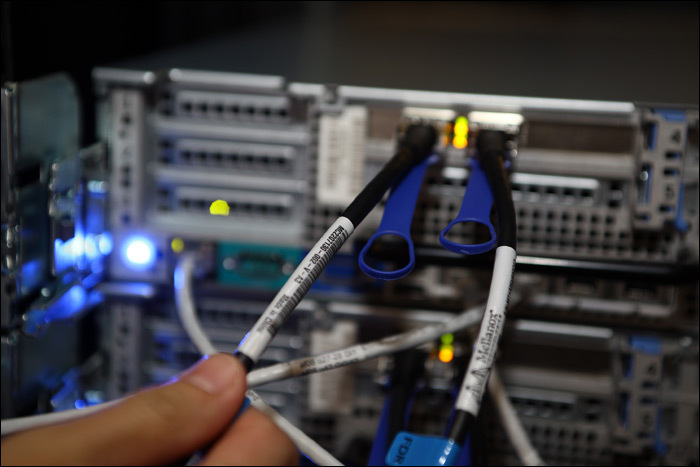

Infiniband-кабель на входе в сервер

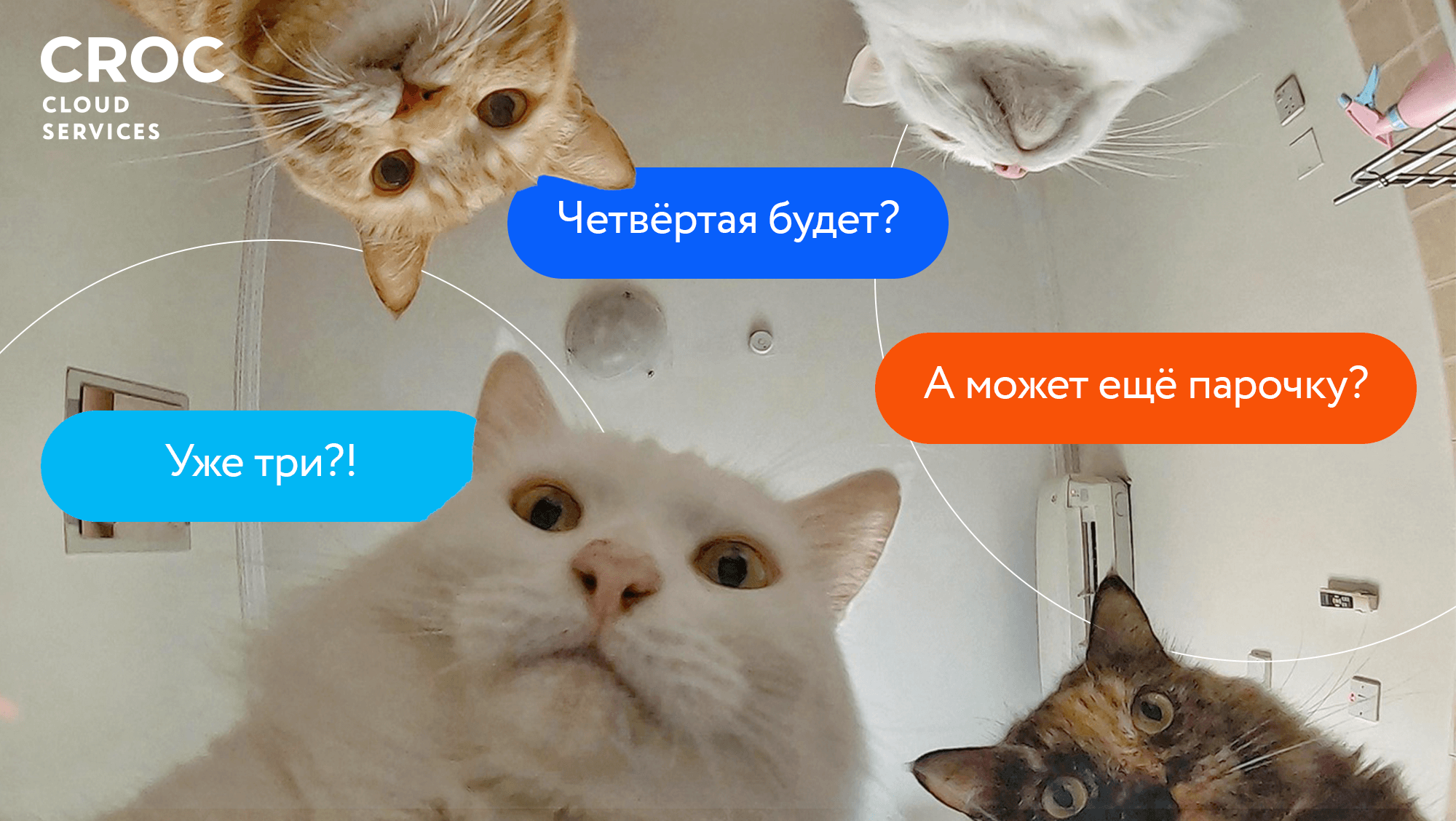

В итоге пропускная способность каналов связи между серверами «облака» выросла с 10 Гб/сек до 56 Гб/сек.Читать полностью »

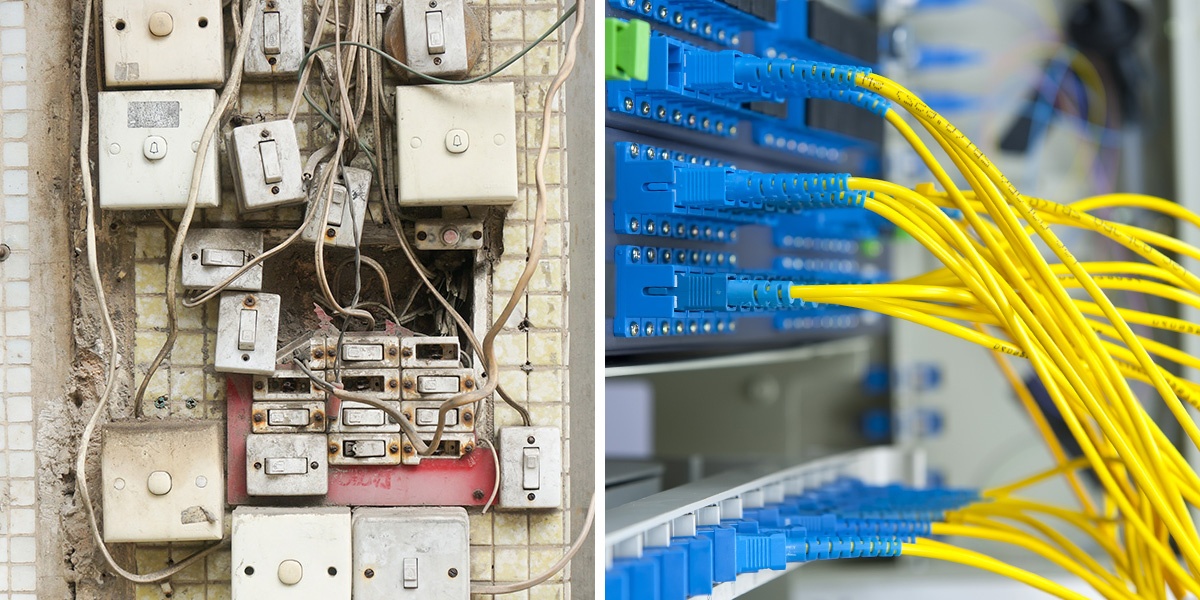

Сегодня доступно приличное количество интерфейсов, каждый из которых претендует на полезность и необходимость. Традиционный Ethernet с 1G, 10G, 40G; InfiniBand FDR 56G и QDR 40G; FibreChannel 8G, 16G, обещанный 32G.

Все обещают счастье и рассказывают про свою крайнюю необходимость и полезность в быту. Как с этим быть, что выбрать и где подводные камни?

.jpg)

InfiniBand-свитч SX6005. 12 FDR 56Gb/s портов на одном юните, коммутация 1.3Тб/с.

Многие считают, что InfiniBand — это «космос». То есть считается, что дорого и нужно только для «суперкомпьютеров» (HPC) производительностью в 1-2 Петафлопа и с гиганскими объмами обрабатываемых данных. Тем не менее, с помощью этой технологии можно организовывать не только самые скоростные межсистемные соединения в кластерах, но и радикально снижать задержки в работе критичных приложений. Конкретно – делать то, что может решаться и с помощью Ethernet, но экономичнее и быстрее. Вот пример.

У одного нашего крупного заказчика из финансовой сферы была проблема в скорости работы двух приложений. Специфика приложений заключалась в том, что необходимо было обрабатывать большое количество транзакций с минимальной задержкой. 6-7 мкс latency – это лучшие результаты, которые они достигли путем апгрейда серверов и максимальной софтверной доработкой. Дальнейшие возможные оптимизации сулили улучшения на уровне 0,3-0,5 мкс. Мы же пришли и сообщили, что сможем уменьшить задержки в два раза. Читать полностью »

Windows Azure предлагает своим клиентам облачную платформу, которая экономически эффективно и надежно удовлетворяет требованиям масштабных вычислений (Big Compute). При разработке Windows Azure были использованы инфраструктура большой мощности и масштабируемости, новые конфигурации экземпляра, а также новый HPC Pack 2012, которые позволили Windows Azure стать лучшей платформой для приложений использующих масштабные вычисления. В действительности, Windows Azure была протестирована с помощью LINPACK бенчмарка, который подтвердил мощность Windows Azure в масштабных вычислениях. Сетевая производительность очень впечатляет, и составила 151,3 ТФлопс на 8064 ядрах с 90,2 процентной эффективностью – эти результаты были отправлены в Топ-500 и исследователями был получен сертификат, подтверждающий включение в топ 500-от мощных суперкомпьютеров в мире.

В виду заинтересованности Microsoft в масштабных вычислениях, было представлено оборудование, разработанное для удовлетворения потребности клиентов в высокопроизводительных вычислениях. Были представлены две высокопроизводительные конфигурации. Читать полностью »