Всем привет! На связи Вадим Лазовский, SRE-инженер продукта Deckhouse Observability Platform от компании «Флант», и Владимир Гурьянов, solution architect. Сегодня мы поделимся кейсом, который произошёл у нас при работе с Ceph. При этом его решение может быть применимо для любого другого ПО.

Рубрика «кластер»

Как несвязанные коммиты в пакетах Linux привели к неожиданным проблемам. Практические истории из SRE-будней. Часть 7

2024-02-07 в 7:21, admin, рубрики: ceph, containerd, devops, docker, kubernetes, linux, sre, systemd, кластер, хранилище данныхКак мы сжимаем данные в больших проектах

2022-06-22 в 10:15, admin, рубрики: tarantool, tarantool cartridge, Администрирование баз данных, Блог компании VK, высокая производительность, кластер, распределенные системы, сжатие данных

Привет! Меня зовут Александр Кленов, и я работаю в Tarantool. В апреле вышел Tarantool 2.10 Enterprise Edition – обновленная версия платформы in-memory вычислений. В версии 2.10 появилось несколько новых функций, о которых уже немного рассказывали на Хабре.

Школа аналитиков данных

2022-02-26 в 12:38, admin, рубрики: big data, Data Analyst, e-commerce, sql, X5RetailGroup, Блог компании X5 Group, Большие данные, карьера, кластер, машинное обучение, обучение, ритейлX5 Tech приглашает студентов и выпускников вузов пройти бесплатное обучение по профессии Data Analyst. Уже через три месяца обучения можно будет пройти оплачиваемую стажировку в Х5 Group.

-

Начало отбора — 21 февраля.

-

Старт обучения — 29 марта.

-

Срок обучения — 8 месяцев, вторник и четверг в 19:00.

Программа обучения

Packer, Terraform и Ansible: деплой кластера Kubernetes за час

2020-03-17 в 6:52, admin, рубрики: Ansible, BM, kubeadm, kubernetes, Packer, terraform, Блог компании КРОК Облачные сервисы, виртуализация, инфраструктура, кластер, сервер, хранение данных

Привет, меня зовут Андрей Щукин, я помогаю крупным компаниям мигрировать сервисы и системы в Облако КРОК. Вместе с коллегами из компании Southbridge, которая проводит в учебном центре «Слёрм» курсы по Kubernetes, мы недавно провели вебинар для наших заказчиков.

Я решил взять материалы отличной лекции Павла Селиванова и написать пост для тех, кто ещё только начинает работать с инструментами provisioning’а облаков и не знает, с чего начать. Поэтому я расскажу про стек технологий, которые используются у нас в обучении и продакшене Облака КРОК. Поговорим о современных подходах к управлению инфраструктурой, про связку компонентов Packer, Terraform и Ansible, а также про инструмент Kubeadm, с помощью которого мы будем производить установку.

Под катом будет много текста и конфигов. Материала много, поэтому я добавил навигацию по посту. Также мы подготовили небольшой репозиторий, куда сложили всё необходимое для нашего учебного деплоя.

Не давайте имён курам

Печёные пирожки полезнее жареных

Начинаем печь. Packer

Terraform — инфраструктура как код

Запуск Terraform

Структура кластера Kubernetes

Kubeadm

Репозиторий со всеми файлами

Читать полностью »

Почему может понадобится полусинхронная репликация?

2020-03-06 в 12:37, admin, рубрики: db, highload, web-разработка, база данных, Блог компании OTUS. Онлайн-образование, высокая нагрузка, высокая производительность, высоконагруженные системы, кластер, масштабирование, Промышленное программирование, Разработка веб-сайтов, распределенные системы, репликация, репликация базы данныхВсем привет. На связи Владислав Родин. В настоящее время я преподаю на портале OTUS курсы, посвященные архитектуре ПО и архитектуре ПО, подверженного высокой нагрузке. В преддверии старта нового потока курса «Архитектор высоких нагрузок» я решил написать небольшой авторский материал, которым хочу поделиться с вами.

Введение

Из-за того, что на HDD может выполняться лишь порядка 400-700 операций в секунду (что несравнимо с типичными rps'ами, приходящимися на высоконагруженную систему), классическая дисковая база данных является узким горлышком архитектуры. Поэтому необходимо уделить отдельное внимание паттернам масштабирования данного хранилища.

На текущий момент имеются 2 паттерна масштабирования базы: репликация и шардирование. Шардирование позволяет масштабировать операцию записи, и, как следствие, снижать rps на запись, приходящийся на один сервер вашего кластера. Репликация позволяет делать тоже самое, но с операциями чтения. Именно этому паттерну и посвящена данная статья.Читать полностью »

Пирамида вместо сферы: нестандартная кластеризация атомов золота

2020-01-08 в 7:50, admin, рубрики: атомы, Блог компании ua-hosting.company, геометрия, запрещенная зона, кластер, кластеризация, молекулы, Научно-популярное, пирамида, симметрия, сфера, фигуры, физика, химия, Читальный зал

Мир, окружающий нас, является совместным результатом множества явлений и процессов из самых разных наук, выделить самую главную из которых фактически невозможно. Несмотря на некоторую степень соперничества, многие аспекты тех или иных наук обладают схожими чертами. Возьмем для примера геометрию: все, что мы видим, имеет определенную форму, из которых одной из самых распространенных в природе является окружность, круг, сфера, шар (тенденция на лицо). Стремление быть шарообразным проявляется как у планет, так и у атомных кластеров. Но в правилах всегда есть исключение. Ученые из Левенского университета (Бельгия) выяснили, что атомы золота формируют не сферические, а пирамидальные кластеры. Чем обусловлено такое необычное поведение атомов золота, какими свойствами обладают драгоценные пирамиды и как на практике можно применить это открытие? Об этом мы узнаем из доклада ученых. Поехали.Читать полностью »

Японцы из NICT представили рабочий оптоволоконный кластер с пропускной способностью в 1 Пбит-с

2019-10-31 в 9:32, admin, рубрики: miran, NICT, Блог компании Дата-центр «Миран», будущее здесь, дата-центр "Миран", кластер, оптика, оптоволокно, Сетевое оборудование, Сетевые технологии, Стандарты связи, японцы спасают интернетИсследовательская группа из японского Национального института информационных и коммуникационных технологий (NICT) разработала оптоволоконный сетевой кластер с суммарной пропускной способностью в 1 Пбит/c. Официально разработка была представлена на европейской технологической выставке ECOC 2019, которая прошла в сентябре в Дублине.

Испытательный стенд в NICT // www.nict.go.jp

Японцы показали публике сетевой кластер, в основе которого лежат 22 оптоволоконные жилы и MEMS-контроллер сигнала с системой мультиплексирования на трехжильные и семижильные подключения, которые сейчас внедряются или уже используются в магистральных сетях связи и дата-центрах.

Разработка японских инженеров доказывает, что мы способны значительно увеличить пропускную способность сетевых подключений не только через увеличение числа жил оптоволоконных кабелей, но в том числе за счет совершенствования систем коммутации и маршрутизации сигнала.

Читать полностью »

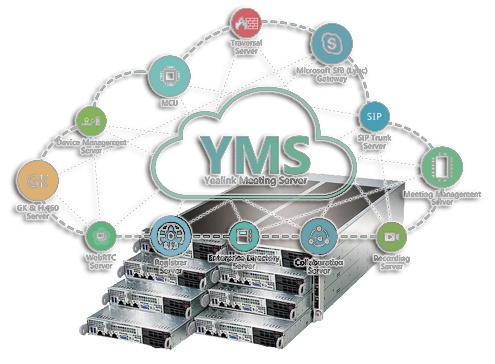

Кластер системы видеоконференцсвязи на базе Yealink Meeting Server

2019-06-19 в 9:35, admin, рубрики: cluster, h.323, IPmatika, linux, mcu, sip, skype, skype for business, stss, yealink, Yealink Meeting Server, YMS, АйПиМатика, аппаратный терминал, Блог компании STSS, вебинар, видеоконференция, видеоконференцсвязь, вкс, высокая производительность, интеграция, кластер, клиентское устройство, кодек, мероприятие, программный сервер, Работа с видео, совещание, телефония, Тестирование IT-систем Эта статья является продолжением цикла публикаций, посвященного комплексному решению ВКС Yealink Meeting Server (YMS).

Эта статья является продолжением цикла публикаций, посвященного комплексному решению ВКС Yealink Meeting Server (YMS).

В прошлой статье Yealink Meeting Server 2.0 — новые возможности видеоконференцсвязи мы описали существенный прорыв в функционале решения:

- добавился собственный сервис записи конференций, интегрированный в YMS

- появился новый тип лицензии — Broadcast, который позволяет оптимизировать стоимость асимметричных конференций

- обеспечена интеграция с решением Skype for Business и Teams

В этой статье мы рассмотрим возможность каскадирования YMS — установку и настройку системы в режиме «кластер».

Читать полностью »

96-ядерный суперкомпьютер на одноплатниках NanoPi Fire3

2018-11-11 в 15:36, admin, рубрики: diy или сделай сам, NanoPi Fire3, Raspberry Pi 3, высокая производительность, кластер, Компьютерное железо, Разработка на Raspberry PiСоздание высокопроизводительного кластера с 12 узлами NanoPi-Fire3 менее чем за £100 (£550, включая двенадцать Fire3)

Мой прошлый кластер на Raspberry Pi 3 в прошлом году немало заинтересовал публику, так что я попробовать сделать аналогичные проекты на других отличных одноплатных компьютерах, которые есть на рынке. FriendlyARM из Китая очень щедро отправила мне 12 своих последних 64-битных ARM плат NanoPi-Fire3, на каждой из которых восьмиядерный ARM A53 SoC, работающий на частоте 1,4 ГГц, с гигабитным Ethernet.

Разворачиваем Kubernetes HA-кластер на Baremethal с помощью Kubeadm и Keepalived (простое руководство)

2018-10-27 в 11:38, admin, рубрики: devops, etcd, high availability, kubernetes, multimaster, кластер, системное администрированиеЭта статья является свободной интерпретацей официального руководства Creating Highly Available Clusters with kubeadm для Stacked control plane nodes. Мне не нравятся сложный язык и примеры использованные в нем, поэтому я написал свое руководство.

Если у вас появятся какие-либо вопросы или вам будет что-то неясно, обратитесь к официальной документации или спросите Google. Все этапы описаны здесь в максимально простой и сдержанной форме.