В жизни каждого инженера‑фронтендера наступает момент, когда осознаёшь: далее не обойтись без кэширования данных из API. Всё может начаться с самых невинных вещей: сохраняем предыдущую страницу с данными, чтобы кнопка «Назад» срабатывала мгновенно; реализуем простенькую логику отмены действия или обеспечиваем слияние нескольких состояний от различных запросов к API. Но все мы знаем, чем такое кончается. Один за другим возникают запросы на новые фичи, и вскоре мы уже не покладая рук реализуем кэши данных, индексы для работы вручную, оптимистические мутации и рекурсивную инвалидацию кэша.

Рубрика «обработка данных»

Прекратите клепать базы данных

2023-12-05 в 22:07, admin, рубрики: sql, клиент, микроменеджмент, обработка данных, серверАнализ статей Хабрахабр

2021-10-09 в 15:53, admin, рубрики: Алгоритмы, визуализация, визуализация данных, обработка данных, парсинг, поиск закономерностей, Программирование, статистика, хабрахабр

Решила повторить исследование, сделанное в 2017 году и посмотреть, что изменилось за 5 лет. Ссылка на предыдущую статью Анализ статей Хабрахабр и Geektimes. Дизайн сайта изменился, поэтому делала все в jupyter python, а не wolfram mathematica. Далеко не все графики удалось воспроизвести заново. Получился анализ более чем 260000 статей.

Результаты обработки данных

Анализ хабов

Как классифицировать данные без разметки

2021-09-07 в 11:30, admin, рубрики: data engineering, data science, machine learning, python, Блог компании FunCorp, классификатор данных, классификация изображений, машинное обучение, нейросети, обработка данных, обработка изображений, сверточные нейросети

Пользователи iFunny ежедневно загружают в приложение около 100 000 единиц контента, среди которого не только мемы, но и расизм, насилие, порнография и другие недопустимые вещи.

NASA переходит в облака: MCP, DAPHNE и облачные инструменты для команды Perseverance

2021-08-02 в 15:51, admin, рубрики: астрономия, Блог компании Selectel, Научно-популярное, облака, Облачные вычисления, обработка данных, спутники

Мы уже писали о том, что NASA и другие космические агентства генерируют огромный объем информации. Данных будет еще больше после запуска в работу сети радиотелескопов и антенн Square Kilometre Array (SKA). Все эти данные нужно где-то хранить и обрабатывать.

Кроме того, NASA приходится еще иметь дело с данными со спутников, которых тоже становится все больше, как и внеземных аппаратов. Их назначение может быть самым разным — от наблюдения за Солнечной системой до изучения метеорологических условий определенного региона Земли. Объединяет их то, что они отправляют информацию на Землю, где для приема и обработки данных установлены специальные станции со специфическим и дорогим оборудованием. Недавно агентство решило сделать ход конем — начать обрабатывать и хранить все это в облаке. Подробности о проектах, которые имеют отношение к этой задаче, — под катом.

Читать полностью »

Студенты, лабы и gnuplot: обработка данных

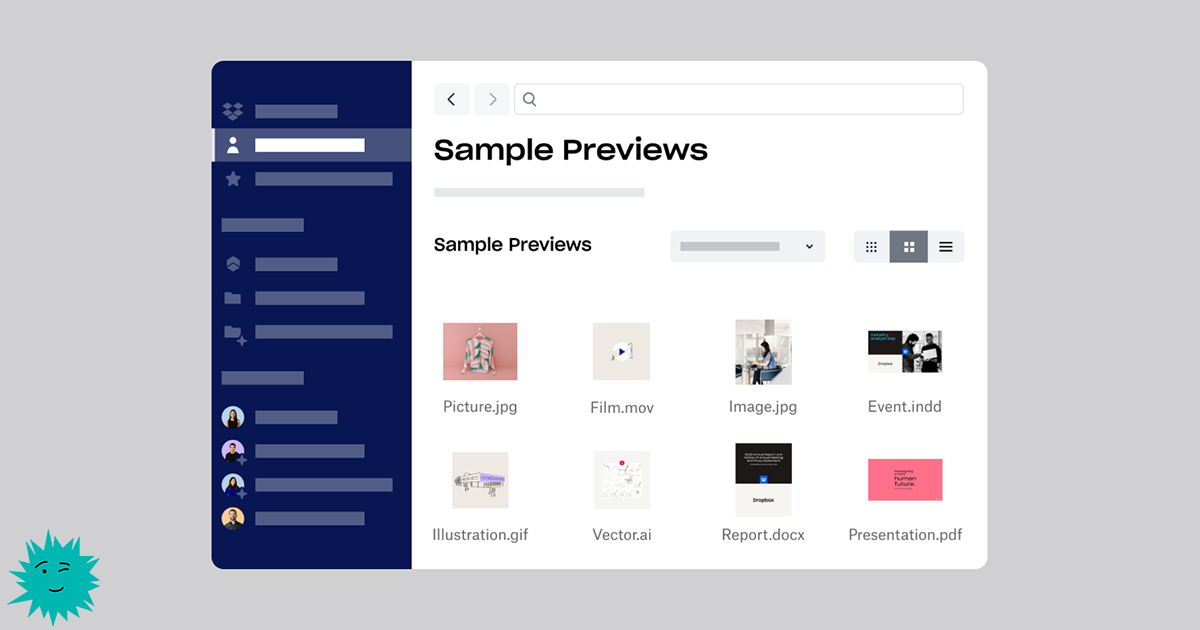

2021-03-14 в 13:59, admin, рубрики: Gnuplot, визуализация данных, лабораторные работы, математика, обработка данных, построение графиков, Софт, Учебный процесс в IT, физикаКак машинное обучение позволило Dropbox экономить ежегодно 1,7 миллиона долларов

2021-01-29 в 9:07, admin, рубрики: DropBox, Блог компании VDSina.ru, инфраструктура, искусственный интеллект, искуственный интеллект, машинное обучение, обработка данных, обработка текста, финансы в IT

Недавно благодаря предсказательной мощи машинного обучения (machine learning, ML) мы обеспечили экономию 1,7 миллионов долларов в год на инфраструктурных тратах, оптимизировав процесс генерации и кэширования превью документов Dropbox. Машинное обучение и раньше применялось в Dropbox для таких хорошо известных функций, как поиск, рекомендации файлов и папок, а также OCR при сканировании документов. Хоть и не все сферы применения ML непосредственно видны пользователю, они всё равно изнутри влияют на развитие бизнеса.

Что такое превью?

Функция Dropbox Previews позволяет пользователям просматривать файл без скачивания контента. В дополнение к превью-миниатюрам Dropbox имеет интерактивную поверхность Previews с возможностью обмена между пользователями и совместной работы, в том числе использования комментарии и тегирования других пользователей.

Читать полностью »

Какой язык выбрать для работы с данными — R или Python? Оба! Мигрируем с pandas на tidyverse и data.table и обратно

2020-03-16 в 7:56, admin, рубрики: big data, data engineering, data frame, data mining, data.table, pandas, python, R, tidyverse, агрегация данных, группировка данных, наука о данных, обработка данных, сводные таблицыПо запросу R или Python в интернете вы найдёте миллионы статей и километровых обсуждений по теме какой из них лучше, быстрее и удобнее для работы с данными. Но к сожалению особой пользы все эти статьи и споры не несут.

Цель этой статьи — сравнить основные приёмы обработки данных в наиболее популярных пакетах обоих языков. И помочь читателям максимально быстро овладеть тем, который они ещё не знают. Для тех кто пишет на Python узнать как выполнять всё то же самое в R, и соответственно наоборот.

В ходе статьи мы разберём синтаксис наиболее популярных пакетов на R. Это пакеты входящие в библиотеку tidyverse, а также пакет data.table. И сравним их синтаксис с pandas, наиболее популярным пакетом для анализа данных в Python.

Мы пошагово пройдём весь путь анализа данных от их загрузки до выполнения аналитических, оконных функций средствами Python и R.

Очистка данных, как игра «Камень, Ножницы, Бумага». Это игра с финишем или без? Часть 2. Практическая

2020-02-21 в 15:43, admin, рубрики: big data, data accuracy, data analysis, data anomaly, data cleansing, data completeness, data consistency, data engineering, data mining, data preparation, data quality, data structures, dirty data, Алгоритмы, грязные данные, обработка данных, открытые данные, очистка данныхВ части первой описывалось, что данная публикация сделана на основе датасета результатов кадастровой оценки объектов недвижимости в Ханты-Мансийском АО.

Практическая часть представлена в виде шагов. Проводилась вся очистка в Excel, так как самый распространенный инструмент и описанные операции может повторить большинство специалистов знающих Excel. И достаточно неплохо подходит для работы в «рукопашную».

Нулевым этапом поставлю работы по запуску, сохранению файла, так как он размером 100 мб, то при количестве этих операций десятки и сотни на них уходит существенное время.

Открытие, в среднем, — 30 сек.

Сохранение – 22 сек.

Первый этап начинается с определения статистических показателей датасета.

Таблица 1. Статпоказатели датасета

Читать полностью »

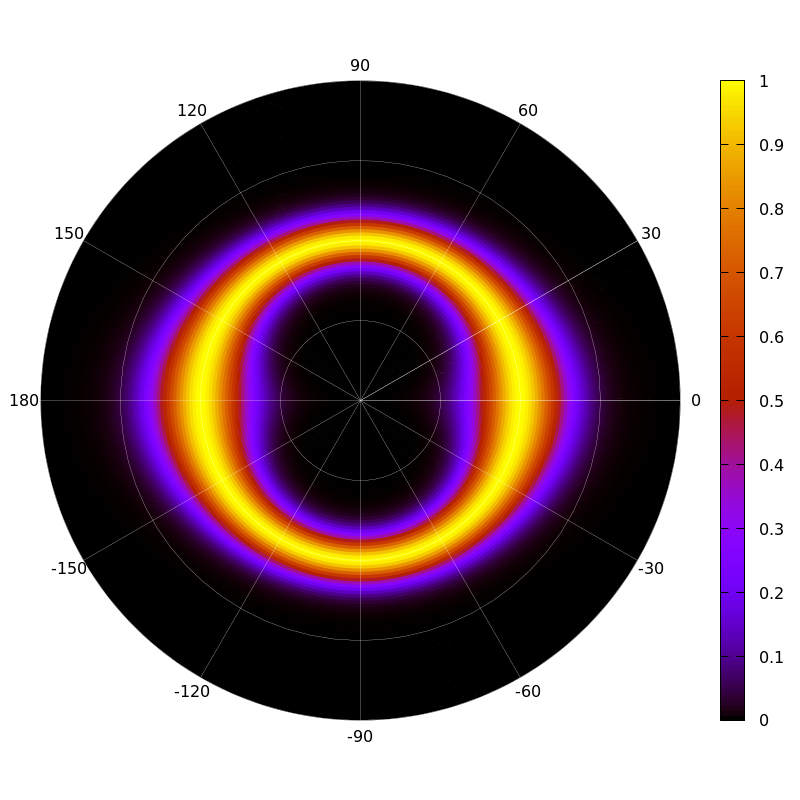

Пилотный проект по обработке высокоплотных сейсмических данных с использованием сервиса MCS

2020-01-21 в 11:58, admin, рубрики: Блог компании Mail.Ru Group, Облачные вычисления, облачные сервисы, облачный сервис, обработка данных, физика

Компания ООО НПЦ «Геостра» с помощью сервиса MCS провела камеральную обработку сейсмической информации — 40 Тб высокоплотной съёмки МОГТ-3D. О реализации, нюансах и результатах проекта будет рассказано в данной статье.

Читать полностью »