Компания Keystone NAP строит новый дата центр на месте бывшего сталелитейного завода в округе Бакс, Пенсильвания. Ввод в эксплуатацию планируется на первый квартал 2015. Сталелитейный завод был построен еще 60 лет назад и в свое время был одним из крупнейших производителей стали в США. Производство стали снизилось, но огромная энергетическая инфраструктура осталась. Вот как раз именно ее Keystone NAP планирует активно задействовать, и объединить с модульным зданием для нового ЦОД, а помогать ей в этом будет компания Schneider Electric.

Рубрика «цод» - 27

Keystone NAP превратит сталелитейный завод в ЦОД

2014-11-23 в 18:51, admin, рубрики: keystone, Schneider electric, ит-инфраструктура, хостинг, цод«ИТ-театр» из бетона и зелени

2014-11-08 в 9:00, admin, рубрики: Tier, банк, дизайн, ит-инфраструктура, финансы, хостинг, цодИспанская финансовая группа Santander – финансовый лидер в Еврозоне и третий по величине частный банк в Бразилии – открыла в Кампинасе, штат Сан-Паулу, дата центр стоимостью почти 500 млн американских долларов. ЦОД в Кампинасе занимает 800 тыс квадратных метров и служит для обработки и размещения данных корпорации. Он спроектирован таким образом, чтобы сочетать в себе высокую скорость обработки данных, высокую устойчивость системы, безопасное размещение данных, и возможность внедрения новейших технологий.

Видеонаблюдение в ЦОДах: совмещаем паранойю охраны с паранойей инженеров

2014-10-30 в 7:13, admin, рубрики: безопасность, Блог компании КРОК, видеонаблюдение, информационная безопасность, ит-инфраструктура, контроль доступа, расследование инцидентов, цод

Инженер во время штатной проверки

В розничных сетях сейчас одна из главных задач видеонаблюдения — это распознавание лиц злоумышленников из известной базы на входе.

Видеонаблюдение в ЦОДах пошло по немного другой ветви эволюции. Начнём с того, что охрана даже просто не знает, на что смотреть, и контроль, по сути, заканчивается на периметре. А случается всякое. Знаю, например, о случае нештатного запуска системы пожаротушения. Причину искали по записям — оказалось, монтажник опёрся локтем в коридоре на кнопку.

Бывают запросы на то, кто открывал стойку. В каком-нибудь ЦОДе может случиться так, что несут что-то по проходу и задевают кабель. Или вот ещё случай: инженер одной компании обслуживал верхний сервер в стойке, в процессе у него упала лестница и ударила прямо по другому серверу, в итоге — раскололся разъём.

Поэтому, конечно, видеонаблюдение в ЦОДах нужно. Расскажу, как мы это делаем для заказчиков, и как организовали в своих дата-центрах. Читать полностью »

Практика эксплуатационщика: 1000 дней без простоя ЦОДа TIER-III

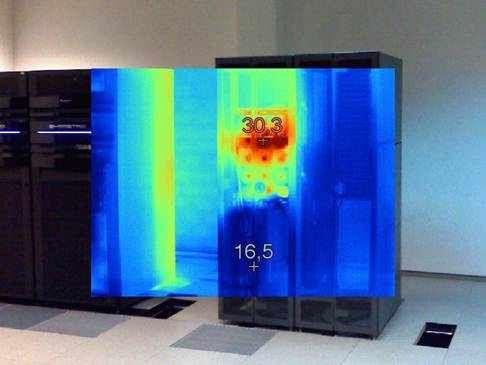

2014-10-16 в 5:49, admin, рубрики: Tier, Uptime Institute, авария, аудит, Блог компании КРОК, дата-центр, ит-инфраструктура, питание, практика, тепловизор, управление проектами, цод

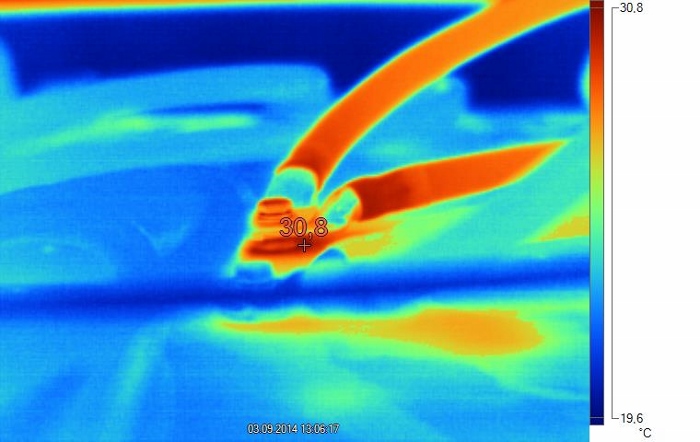

Окисление контактов перемычки аккумулятора вызвало нагрев. При наружном осмотре следов окисления не видно, поскольку оно произошло между клеммой аккумулятора и наконечником перемычки.

Пару недель назад у меня и коллег случился маленький праздник: 1000 дней непрерывной работы ЦОДа без простоя сервиса. В смысле — без влияния на оборудование заказчиков, но со штатными и не очень работами по системам.

Ниже я расскажу о том, как я и мои коллеги обслуживают ЦОД повышенной ответственности, и какие бывают подводные камни.

Читать полностью »

FAQ про охлаждение дата-центров: как сделать дёшево, сердито, надёжно и вписаться в габариты площадки

2014-10-02 в 6:18, admin, рубрики: бескомпрессорный холод, Блог компании КРОК, дата-центр, ит-инфраструктура, охлаждение, управление проектами, фрикулинг, хладоноситель, цод

— Какой обычно есть выбор для охлаждения ЦОДа?

- Фреоновое охлаждение. Проработано, просто, доступно, но главный минус — ограниченные возможности по манёвру в энергоэффективности. Также часто мешают физические ограничения по длине трассы между наружными и внутренними блоками.

- Системы с водой и гликолевыми растворами. То есть хладагентом всё ещё остаётся фреон, а вот хладоносителем уже будет другое вещество. Трасса может быть длиннее, но главное, что открывается многообразие вариантов настройки режимов работы системы.

- Системы комбинированного типа: кондиционер может быть и фреонового, и водяного охлаждения (здесь масса нюансов).

- Охлаждение воздухом с улицы — это различные варианты фрикулинга: роторные теплообменные аппараты, прямые и косвенные охладители и так далее. Общий смысл — либо прямой теплоотвод фильтрованным воздухом, либо замкнутая система, где уличный воздух охлаждает внутренний через теплообменник. Нужно смотреть на возможности площадки, так как возможны внезапные решения.

— Так давайте бахнем классические фреоновые системы, в чём проблема?

Классические фреоновые системы отлично работают в малых серверных и, не часто, средних ЦОДах. Как только машзал переваливает за 500–700 кВт, возникают проблемы с размещением наружных блоков кондиционеров. Для них банально не хватает места. Приходится искать свободные площади подальше от ЦОДов, но тут вмешивается длина трассы (её не хватает). Конечно, можно спроектировать систему на пределе возможностей, но тогда растут потери в контуре, снижается эффективность, усложняется эксплуатация. В итоге для средних и больших ЦОДов сугубо фреоновые системы зачастую невыгодны.Читать полностью »

Новая жизнь старой СХД — волшебное железо Violin для ускорения массивов

2014-09-15 в 6:22, admin, рубрики: Violin Maestro, Блог компании КРОК, кэш, нагрузка, Серверное администрирование, СХД, ускорение, хранение данных, цод, чтение

Если у вас стоят такие СХД, как EMC Clariion, VNX, VMAX, Symmetrix DMX3, DMX4, AMS 2000, HUS и другие подобные, и вам не хватает их производительности, у меня хорошая новость.

Новую быструю СХД покупать, возможно, не надо. Если вам достаточно ускорить задачи чтения, есть решение куда дешевле апгрейда массива и проще по внедрению, чем диски в Symmetix. Называется Violin Maestro.

Это аппаратный кэш на чтение, который подключается между хостом и СХД. Железка уже протестирована и уже в России. Её можно брать и ставить без какого-либо простоя и остановок. Читать полностью »

Тестирование флеш СХД. Влияние файловых систем

2014-09-02 в 12:18, admin, рубрики: flash-память, ssd, storage systems, Блог компании INLINE Technologies, высоконагруженные приложения, ит-инфраструктура, нагрузочное тестирование, Серверное администрирование, СХД, тесты, файловые системы, цодВ ходе тестирований производительности ведущих флеш-систем мы, в какой то момент, задались вопросами: Каково же влияние файловой системы на производительность реальной СХД? Насколько оно существенно и от чего зависит?

Известно, что файловая система является инфраструктурным программным слоем, реализуемым на уровне ядра ОС (kernel space) или, что реже — на пользовательском уровне (user space). Будучи промежуточным слоем между прикладным/системным ПО и дисковым пространством, файловая система должна вносить свою паразитную нагрузку, влияющую на показатели производительности системы. Следовательно, при расчетах реальной производительности СХД следует учитывать зависимость фиксируемых параметров от реализации файловой системы и ПО, использующего данную файловую систему.

Читать полностью »

Как мы построили инженерную инфраструктуру для дата-центра Физтеха

2014-08-27 в 8:22, admin, рубрики: Блог компании Softline, МФТИ, цодЗаказчиком этого проекта стал московский институт МФТИ. Выполнять для легендарного Физтеха большой и ответственный проект очень почетно, но и ответственность ложится серьезная.

Работы предстояли в дата-центре института, расположенном в Долгопрудном Московской области. Это сердце всех информационных систем МФТИ. Здесь собраны вычислительные мощности, которые используют как для научной и учебной работы (моделирование, расчеты) так для служебных целей (почта и коммуникации, бухгалтерия и т.п.)

Европейская конференция по ЦОДам, Big Data, 3D-печати, геймификации бизнеса

2014-08-25 в 8:40, admin, рубрики: ит-инфраструктура, конференция, хостинг, цодВ Хельсинки 4 сентября 2014 пройдет конференция про ЦОДы, 3D-печать, Business Gamification, Big Data и измерительные технологии. Язык конференции — английский.

Если вы как раз планируете найти клиентов или партнеров в Европе, у вас есть шенгенская виза, можете регистрироваться на сайте конференции.

Входной билет на конференцию стоит денег (от 250 EUR). Однако одни из организаторов конференции — Digitice Finland — с давних пор питают теплые чувства к Хабру. Поэтому первым семи читателям, которые пришлют мне запрос в хабрапочту, я обещаю код для бесплатной регистрации.

А надо ли вам туда? Чтобы решить, посмотрите краткую программу под катом, а подробности — на официальном сайте конференции (на англ. языке).

До встречи с теми, кто захочет поехать!

Читать полностью »

Опрос на тему: «Требования к ЦОДу облачного провайдера»

2014-08-22 в 10:50, admin, рубрики: Блог компании «Медиа Грус», ит-инфраструктура, облако, хостинг, цод

Здравствуйте, уважаемые читатели!

Рынок облачных технологий находится в постоянном развитии: каждый день появляются все более технологичные сервисы и продукты, для доступности и качественной работы которых требуются все новые и новые мощности центров обработки данных.

На нашем отраслевом профессиональном портале AllDataCenters.ru мы решили провести опрос потребителей и поставщиков облачных услуг, чтобы узнать, какие требования к дата-центрам являются ключевыми, и какие услуги наиболее востребованы.