«Энергетический предел»: Новые технологии охлаждения дата-центров

Кен Брилл (Ken Brill) из центра сертификации ЦОД Uptime Institute как-то заявил [1], что процесс увеличения тепла, выделяемого в результате установки все большего количества транзисторов на чип, достигнет предельной точки, в которой экономическая целесообразность охлаждения ЦОДа будет утеряна без внедрения новых технологий.

И индустрия постепенно движется в этом направлении, занимаясь приоритизацией показателя энергоэффективности в общем процессе обслуживания дата-центров. По этой причине классические серверные помещения с традиционными системами охлаждения становятся все более редким выбором для компаний, что объясняется экономическими соображениями: в отчете [2] IEEE от первого квартала 2016 года описано распределение энергопотребления между различными компонентами дата-центров — на долю систем охлаждения приходится 50% потребляемой энергии.

В связи с этим компании начали искать новые методы и решения охлаждения ЦОД, о которых мы хотим поговорить в этом материале.

[3]/ фото Rob Fahey [4] CC [5]

[3]/ фото Rob Fahey [4] CC [5]

В работе Марка Миллса (Mark Mills) под названием «Облака начинаются с угля» делается [6] следующий вывод: основываясь на усредненной оценке, экосистема информационно-коммуникационных технологий (ИКТ) ежегодно потребляет 1500 ТВт·ч электроэнергии, что составляет 10% от её мирового производства.

По данным [7] Intel, c 2002 года расходы на электроэнергию ежегодно возрастают примерно на 5,5%. Организации тратят около $0,50 на электроэнергию и охлаждение с каждого доллара, направленного на обслуживание аппаратной части.

Изображение: Uptime Institute [8]

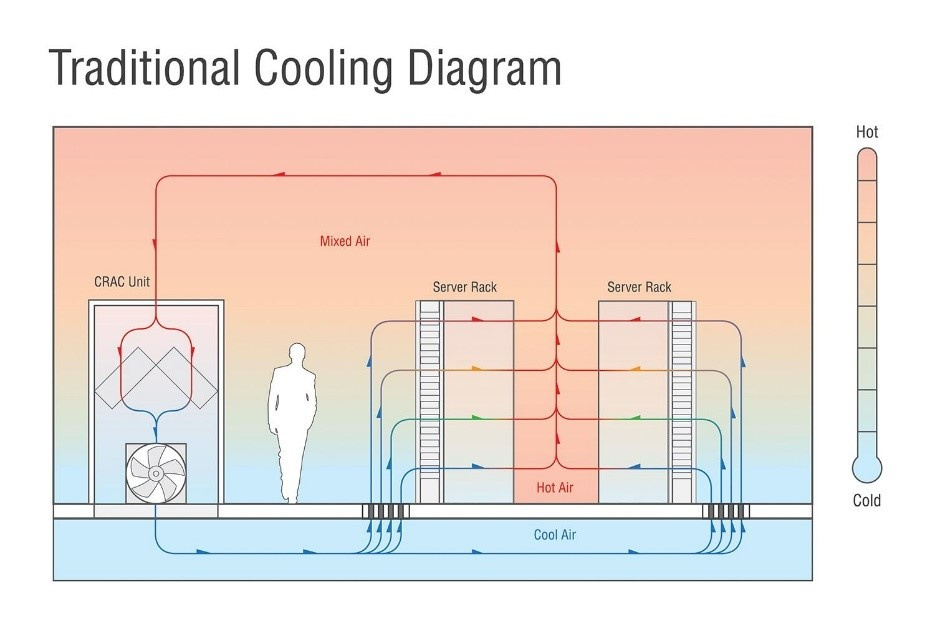

Чтобы минимизировать вероятность повышения температуры ЦОДов предприятия часто используют коридорные механизмы у стоек дата-центров с воздуховодами для горячих и холодных потоков. В этом случае применяются системы организации, управления и сдерживания воздушных потоков, которые захватывают горячий «отработанный» воздух, пропускают его через устройства кондиционирования и подают охлажденным непосредственно на воздухозаборники серверного оборудования.

Некоторые системы используют жидкости для поглощения и переноса тепла из аппаратной части. Как правило, жидкости выполняют эту функцию более эффективно, чем воздух. Распространены такие системы, как охлаждение путем контакта жидкости с радиатором и иммерсионное охлаждение (непрямое и прямое), при котором отдельные компоненты погружаются в непроводящую жидкость.

Хотя водяное охлаждение в своем традиционном виде является более экономичным методом, на сегодняшний день оно по-прежнему остается вторичным, сталкиваясь с рядом препятствий на пути к массовому внедрению. Существуют следующие замедляющие распространение факторы:

- Физические ограничения. В отличие от стоек, доступ к емкости для погружения серверов открывается только сверху, что усложняет масштабирование инфраструктуры.

- Безопасность. Любое техническое обслуживание требует контакта со специальной жидкостью.

- Стоимость развертывания системы. Проектирование нового ЦОДа на основе водяного охлаждения менее трудоемко, чем модернизация существующей инфраструктуры.

- Дефицит ресурса. На обслуживание крупного дата-центра требуется такое количество воды, что целесообразность охлаждения серверов в засушливых районах ставится под сомнение как с экономической, так и с экологической точки зрения.

Альтернативные решения для охлаждения дата-центров

Рост затрат на энергию и определенные недостатки классических методов охлаждения побудили ЦОД-индустрию обратиться к поиску инновационных решений, в том числе связанных с «естественным» охлаждением.

Миграция ЦОДов

На планете есть ряд регионов, климат которых естественным образом позволяет экономить до 100% энергии, затрачиваемой на обслуживание охлаждающих систем. Такими климатическими зонами, к примеру, являются северная часть Европы, России и несколько зон на севере США.

В подтверждение тому в 2013 году компания Facebook построила [9] свой первый дата-центр за пределами Соединенных Штатов в шведском городе Лулео со среднегодовой температурой в 1,3 °C, а компания Google вложила [10] миллиард долларов в строительство крупного ЦОДа на территории Финляндии.

Холодный климат позволяет сократить эксплуатационные расходы, из-за низких температур воздуха и воды, запускаемых в дата-центры. По словам [11] Эндрю Донохью из исследовательской компании 451 Research, естественное воздушное охлаждение позволяет строителям отказаться от механических охладителей, сократив до 40% капитальных затрат на объект.

Естественные формы охлаждения

Как логичное продолжение предыдущего решения следует рассматривать естественное охлаждение. Существует три формы его реализации: воздушное, адиабатическое и водяное.

Воздушная форма естественного охлаждения отличается от классического кондиционирования тем, что горячий воздух рядом с серверами отправляется в окружающую среду (полностью или частично), и его место занимает охлажденный воздух извне.

Еще в 2008 году в компании Intel провели [12] десятимесячный тест для оценки эффективности использования исключительно внешнего воздуха для охлаждения ЦОДа. В итоге зафиксировать увеличение частоты отказов серверов из-за колебаний температуры и влажности не удалось. Диапазон изменений температуры в машинном зале составлял 30 градусов, при этом использовался только стандартный бытовой воздушный фильтр, удаляющий лишь крупные частицы из поступающего воздуха.

В результате влажность в дата-центре колебалась от 4 до 90%, а серверы покрылись тонким слоем пыли. Несмотря на это, частота отказов в испытательной зоне составила 4,46%, что не сильно отличалось от показателя в 3,83%, достигнутого в главном дата-центре Intel за тот же период.

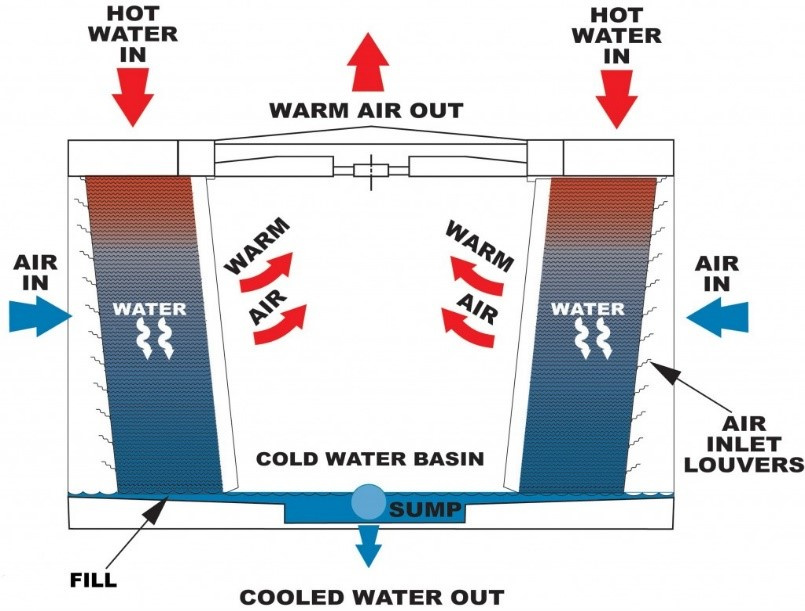

Вторая форма — это адиабатическое охлаждение, которое часто называется испарительным. Чтобы охладить дата-центр, маломощный вентилятор подает воздух на орошаемые поверхности, испаряя часть воды. Полученный воздух оказывается намного холоднее, чем пропускаемый вентилятором.

Изображение: Submer [13]

Еще одним решением [14] для адиабатического охлаждения является так называемое колесо высокой температуры. Такое колесо входит [15] в состав системы охлаждения Kyoto, используемой в Швейцарии. Гибридная установка мощностью 9 МВт использует охлажденную воду замкнутого адиабатического сухого вентилятора, соединенного с водоохлаждающим устройством с компрессорами.

Колесо представляет собой большой, медленно вращающийся алюминиевый диск, пришедший в индустрию ЦОДов из промышленного кондиционирования. Вместо того чтобы вводить внешний воздух напрямую в серверную, оно смешивает наружный воздух с вытяжным, формируя теплообмен. Колесо совершает от 3 до 10 оборотов в минуту и требует минимум энергии для поворота.

Утверждается [16], что этот тип охлаждения требует только 8–25% мощности, затрачиваемой при механическом охлаждении. Согласно независимому отчету [15], система на основе «колеса», установленная в Монтане, США, снижает стоимость затрат на охлаждение до 5 центов с каждого доллара, потраченного на энергию.

Что касается водяной формы естественного охлаждения, в реальном исполнении ее иллюстрирует принцип работы дата-центра Green Mountain, который расположен в одном из фьордов в Норвегии. Водоем обеспечивает бесперебойную подачу воды при температуре 8 °C, которая является оптимальной для систем охлаждения ЦОДов.

На более «глубокую» эксплуатацию водных ресурсов нацелен проект Microsoft Natick — реализующий идею подводного дата-центра. Предполагается [19], что на дне океана на глубине от 50 до 200 метров будут размещены капсулы, содержащие несколько тысяч серверов. Внутренняя часть блока состоит из стандартных стоек с теплообменниками, которые переносят тепло от воздуха к воде.

Затем жидкость попадает в теплообменники снаружи капсул, которые, в свою очередь, перенаправляют тепло в океан. Во время эксперимента прототип был погружен близ берегов Калифорнии на 105 дней. Температура воды колебалась в диапазоне от 14 до 18 °C. Затраты на охлаждение оказались существенно меньшими в сравнении с механическими способами охлаждения.

Похожую концепцию разрабатывает компания Google, однако ученые ИТ-гиганта предлагают размещать дата-центры на баржах. По данным [20] Nautilus Data Technologies, занимающейся разработкой похожей технологии, такой подход позволяет экономить до 30% энергии за счет естественного охлаждения.

Другим воплощением концепции эксплуатации «природных охладителей» являются подземные дата-центры, а также ЦОДы, базирующиеся в пещерах естественного происхождения. В сравнении с идеей погружения серверов под воду подземные объекты имеют преимущество с точки зрения доступа к оборудованию. В качестве примеров реализации можно привести пещеру в городе Тампере, Финляндия, которую арендует Aiber Networks.

Также стоит отметить дата-центр Iron Mountain расположенный в бывшей шахте в Пенсильвании на глубине 67 метров. Утверждается [21], что постоянная температура объекта поддерживается на уровне 11 °C естественным образом — это обеспечивает «одни из самых низких показателей энергоэффективности [по состоянию на 2014 год]».

Альтернативные системы охлаждения на основе жидкостей

Основываясь на принципе погружения в жидкость, система Iceotope от компании 2bm покрывает электронику непроводящей охлаждающей жидкостью, тепло от которой транслируется к радиатору. Вода проходит через стойку и может быть повторно использована для других целей, например в центральном отоплении. По данным [22] 2bm, эта система позволяет сэкономить до 40% от общей стоимости обслуживания ЦОДа.

В 2014 году ресурс Data Center Knowledge также представил [23] отчет об оптимизации процесса охлаждения дата-центра Агентства национальной безопасности США посредством погружения серверов в нефтяные масла. Этот подход также позволил отказаться от охлаждения с помощью вентиляторов.

Охлаждение с использованием искусственного интеллекта

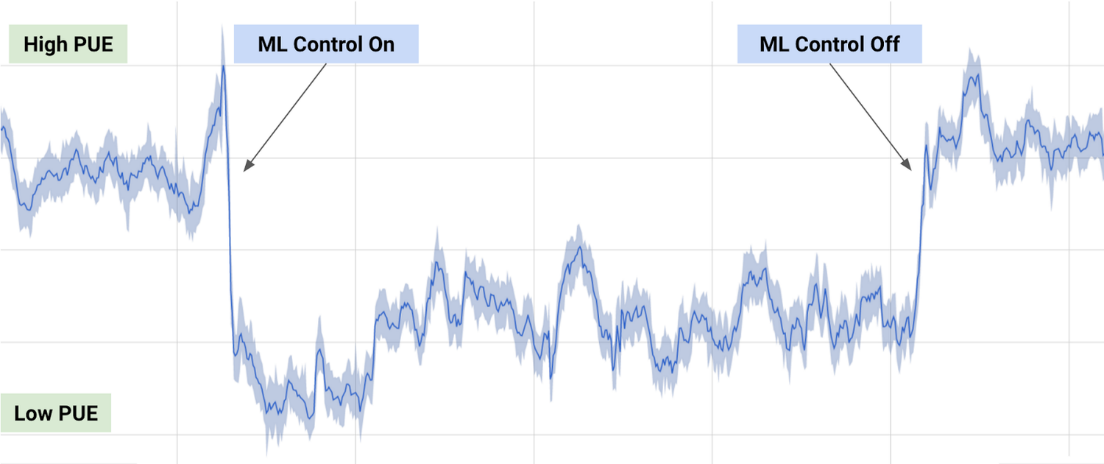

В 2014 году Google приобрели компанию DeepMind, специализирующуюся на разработке систем искусственного интеллекта. Ряд тестов ИИ корпорации был связан с оценкой энергоэффективности ее собственных дата-центров. По результатам исследования, Google удалось [24] достичь снижения энергопотребления в части охлаждения на 40%.

Для этого данные, собранные тысячами сенсоров и термодатчиков в ЦОДах, были использованы для обучения нейронных сетей. Сети научились предсказывать температуру и давление в дата-центре в ближайший час и предпринимали необходимые действия по обеспечению заданных температурных порогов. Результаты оптимизации представлены на следующем графике.

Источник: DeepMind [24]

Лазер с прямой модуляцией на кремниевой подложке

Метод находится на ранних стадиях развития и реализуется [25] в рамках проекта известного как DIMENSION. Группа ученых из Кардиффского и Шэффилдского университетов создали лазер на кремниевой подложке, способный работать 100 тыс. часов при температуре до 120 °C.

По мнению ученых, такая технология позволит объединить два направления: электронику и фотонику. Лазеры с прямой модуляцией на кремниевой подложке обеспечивают огромную скорость передачи данных в электронных системах и хотя не имеют прямого отношения к охлаждению дата-центра, способны снизить затраты на электроэнергию.

Перспективы инновационных систем охлаждения

Акцент на оптимизации энергоемких систем ЦОДов привел к возникновению различных концептов, которые могут стать реальностью в будущем. Один из таких примеров — проект 65-этажного дата-центра в Исландии, который, по словам [26] архитекторов, представляет собой «гигантскую башню данных», достигающую в высоту 50 метров и содержащую сотни тысяч серверов, обслуживаемых за счет «чистой» энергии. Учитывая близость выбранного местоположения к Северному полярному кругу, здание будет обеспечено средствами для естественного охлаждения.

Однако более перспективным направлением в развертывании инновационных систем выступает комбинация решений естественного охлаждения с повторным использованием генерируемой в результате функционирования дата-центров энергии. Так, британская телекоммуникационная компания aql в декабре прошлого года официально открыла [27] новый центр обработки данных, который направляет «отработанное» тепло в систему централизованного теплоснабжения, обслуживающего местные жилые и коммерческие здания.

Альфонсо Капоццоли (Alfonso Capozzoli) утверждает [28], что сбор и повторное использование отработанного тепла, производимого ИТ-оборудованием, является следующим шагом в стратегии энергоэффективности. Реализация соответствующих мер, кроме всего прочего, может значительно повлиять на сокращение выбросов CO2. В качестве возможных сфер использования отработанного тепла, помимо центрального отопления, также числятся абсорбционное охлаждение, цикл Ренкина [29] и опреснение воды.

Таким образом, ЦОД-индустрия в настоящее время сосредоточена на использовании естественных источников охлаждения, комбинируемых с интеллектуальными системами, оптимизирующими эффективность расходования энергии. Концепты, пребывающие сегодня на стадии прототипа, могут коренным образом изменить подход к применяемым способам охлаждения в будущем.

Автор: it_man

Источник [30]

Сайт-источник PVSM.RU: https://www.pvsm.ru

Путь до страницы источника: https://www.pvsm.ru/data-tsentry/257451

Ссылки в тексте:

[1] заявил: https://www.usenix.org/legacy/event/lisa07/tech/brill_talk.pdf

[2] отчете: http://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=7279063

[3] Image: https://habrahabr.ru/company/it-grad/blog/330338/

[4] Rob Fahey: https://www.flickr.com/photos/robfahey/338833525/

[5] CC: https://creativecommons.org/licenses/by-sa/2.0/

[6] делается: https://www.tech-pundit.com/wp-content/uploads/2013/07/Cloud_Begins_With_Coal.pdf?c761ac

[7] данным: https://people.eecs.berkeley.edu/~istoica/classes/cs294/09/CERN_Whitepaper_r04.pdf

[8] Uptime Institute: https://journal.uptimeinstitute.com/a-look-at-data-center-cooling-technologies/

[9] построила: http://bigpicture.ru/?p=404950

[10] вложила: http://www.datacenterknowledge.com/archives/2013/11/04/google-data-center-investment-in-finland-tops-1-billion-usd/

[11] словам: https://www.theregister.co.uk/2016/05/12/power_in_a_cold_climate/

[12] провели: http://www.intel.com/content/dam/doc/technology-brief/data-center-efficiency-xeon-reducing-data-center-cost-with-air-economizer-brief.pdf

[13] Submer: https://submer.com/data-center-liquid-immersion-cooling-with-adiabatic-cooling-towers/

[14] решением: http://www.datacenterknowledge.com/archives/2010/09/24/montana-deploys-kyoto-cooling-wheel/

[15] входит: http://telecombloger.ru/6793

[16] Утверждается: http://searchdatacenter.techtarget.com/tip/Free-data-center-cooling-Methods-and-challenges

[17] Image: http://iaas-blog.it-grad.ru/облачный-цод-для-iaas-провайдера-как-облако-ит-град-размещается-в-дата-центре-dataspace

[18] Image: http://iaas-blog.it-grad.ru/облачный-цод-как-проверить-надежность-дата-центра-при-выборе-iaas-провайдера

[19] Предполагается: http://spectrum.ieee.org/computing/hardware/want-an-energyefficient-data-center-build-it-underwater

[20] данным: http://www.datacenterdynamics.com/content-tracks/power-cooling/floating-data-center-is-launched/95209.fullarticle

[21] Утверждается: https://www.datacenters.com/news/infrastructure/218-new-underground-data-center-trend-takes-hold

[22] данным: http://www.datacenterdynamics.com/content-tracks/power-cooling/2bm-adopts-iceotopes-liquid-cooling-system/97867.fullarticle

[23] представил: http://www.datacenterknowledge.com/archives/2014/09/04/nsa-exploring-use-mineral-oil-cool-servers/

[24] удалось: https://deepmind.com/blog/deepmind-ai-reduces-google-data-centre-cooling-bill-40/

[25] реализуется: http://www.gazettabyte.com/home/2016/11/28/dimension-tackles-silicon-photonics-laser-shortfall.html

[26] словам: http://www.dailymail.co.uk/sciencetech/article-3558362/Forget-data-centers-future-data-SKYSCRAPERS-Radical-cylindrical-design-65-floors-servers.html

[27] открыла: http://www.datacenterdynamics.com/content-tracks/colo-cloud/new-data-center-in-leeds-will-provide-district-heat/97897.fullarticle

[28] утверждает: http://www.sciencedirect.com/science/article/pii/S1876610215028337

[29] цикл Ренкина: https://ru.wikipedia.org/wiki/Цикл_Ренкина

[30] Источник: https://habrahabr.ru/post/330338/

Нажмите здесь для печати.