Энергоэффективный ЦОД: знакомство с мировым опытом

Энергоэффективность, минимизация потенциально опасных выбросов, предотвращение вредного воздействия на окружающую среду при неизменной, а лучше повышенной мощности объекта – вот, что занимает умы управляющих ЦОД. Информационный ресурс Greentech Media еще в 2009 году отметил [1] тот факт, что потребление энергии только одним дата-центром Google можно сравнить с тем, что уходит на целый Манхэттен. Эффективная работа с таким объемом энергетических ресурсов и всевозможными ограничениями подразумевает не только регулярное обновление железа, но и перекраивание всей инфраструктуры ЦОД.

В некоторых случаях дело доходит до перехода на принципиально новые технологии и даже системное «озеленение» дата-центров. О том, как претворяют в жизнь и простые, и абсолютно фантастические идеи, поговорим в нашем материале.

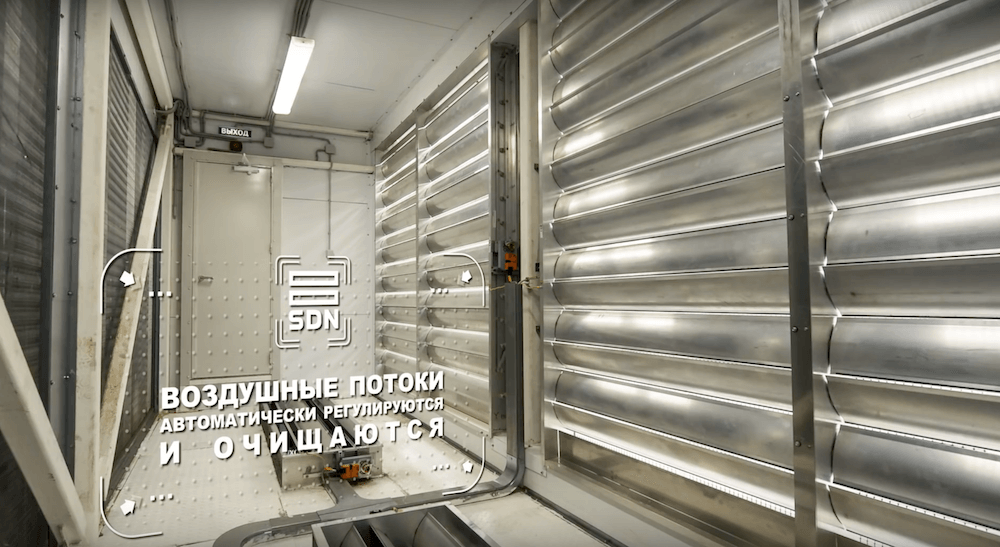

[2]/ кадр из видео о нашем дата-центре [3] SDN + (подробнее [4] об инфраструктуре 1cloud)

[2]/ кадр из видео о нашем дата-центре [3] SDN + (подробнее [4] об инфраструктуре 1cloud)

Для высокоуровневой оптимизации работы ЦОД применяют различные системы управления и мониторинга производительности (DCPM — Data Center Performance Management). Они анализирует информацию по расходу определенных ресурсов, рассчитывают базовые показатели энергоэффективности и другие метрики, по которым можно оценивать работу ЦОД.

В число универсальных входят следующие критерии, предложенные общими силами экспертного сообщества:

- коэффициент эффективности использования энергии (PUE — Power Usage Effectiveness);

- коэффициент эффективности инфраструктуры (DCiE — Data Center Infrastructure Efficiency);

- коэффициент эффективности использования воды (WUE — Water Usage Effectiveness);

- и коэффициент эффективности использования углерода (CUE — Carbon Usage Effectiveness).

Эксперты Green Grid публикуют [5] аналитику и чеклисты для усовершенствования работы дата-центров и поиска новых возможностей для их «озеленения». Многие дата-центры начали активно использовать предлагаемые методики, внедрять новые решения и улучшать собственные разработки. Значительную роль в этом процессе играет встраивание ЦОД в общую энергетическую экосистему города и использование природных особенностей региона.

/ видео о ЦОД Stack Data Network

Название одной из популярных технологий охлаждения ЦОДов — фрикулинг [6]. Оно перешло в русский язык в виде кальки от английского «free cooling». Термин интересен с точки зрения перевода — он отражает суть технологии: «естественное» или «бесплатное» охлаждение. В основе этой технологии лежит использование уличного воздуха, который пропускают, например через роторные теплообменники. Эту технологию внедряют все больше и больше компаний, а некоторые идут и дальше — продают избытки тепла.

Системы рекуперации тепла и фрикулинга позволяют крупным дата-центрам направлять избыточную тепловую энергию на поддержание оптимальной температуры в жилых помещениях. Один из примеров — инициатива [7] правительства Стокгольма. Муниципалитет совместно с проектом Stockholm Data Parks намерен создать экосистему, в рамках которой «тепло ЦОД не будет расходоваться впустую». В ходе реализации проекта планируется покрыть до 10% энергии, расходуемой на отопление города. Конечно, все это уже находит соответствующую реакцию компаний — Borderlight AB объявила [8] о запуске 5-мегаваттного ЦОДа в Стокгольме с прицелом на продажу избыточного тепла. Серверное оборудование будет поставлять GoGreenHost, дочерняя компания Borderlight, а перераспределением тепла займется Fortum Värme.

Не отстает и Яндекс, который помогает [9] отапливать финский город Мянтсяля. Представители компании говорят, что благодаря продаже тепла городу, компания экономит треть расходов на электроэнергию. Благодаря финскому климату дата-центр может работать за счет прямого фрикулинга [10]. Таким образом, компания не нуждается в сложных системах охлаждения и может позволить себе установку теплообменников в районе выброса разогретого воздуха, чтобы передать разогретую воду в городскую систему теплоснабжения. В этом регионе работает и ЦОД Google, в системе охлаждения которого задействованы ледяные воды Финского залива. Ранее, в финском городке Хамина в месте, где сейчас находится дата-центр, размещалась бумажная фабрика. Общая сумма инвестиций в проект — более 350 миллионов евро.

Климат Англии, отличающийся суровым характером, и энергия ветра также позволяют локальным ЦОД снизить затраты на охлаждение и электроэнергию. Наличие в проекте ветрогенераторов и соответствующих систем увеличивает капитальные затраты на 6-10% по сравнению с классическим объемом инвестиций для возведения дата-центра. Все это окупается всего за 4 года эксплуатации. Однако, по данным Reuters, лидирующие позиции в области ветровой энергетики занимает не Великобритания, а Дания — и этим активно пользуются лидеры рынка ИТ. Уже в этом году свой «ветряной» дата-центр там запустит Apple.

/ Фото Ian D. Keating [11] CC-BY [12]

Помимо энергии ветра компании активно используют cолнечную энергию. Например, солнечные батареи ЦОД Apple в г. Мэйден (Северная Каролина) способны генерировать более 42 млн кВт/ч электроэнергии в год. Топ-менеджмент дата-центра утверждает, что этого объема хватает для питания 60% оборудования и системы охлаждения, а оставшиеся 40% покрываются силами биотопливной станции, расположенной неподалеку от ЦОДа.

Есть и более экзотические примеры — ЦОД Verne Global в Рейкьявике, который использует BMW. Система питания этого дата-центра задействует геотермальную энергию и мощности локальной гидроэлектростанции. Эффективной работе данного ЦОД способствует и благоприятный климат региона — он в меру холодный, а перепады температур незначительны.

Единичные примеры ЦОД обладают возможностями для комбинированного использования энергии солнца, водных ресурсов и ветра. Например, Citi Data Center во Франкфурте обладает сертификатом LEED, что позволяет ему гордо носить звание самого «зеленого» ЦОД. По словам сотрудников дата-центра, работать в нем приятно, а смотреть на него — вообще одно удовольствие: один из фасадов покрыт настоящими травяными насаждениями, а территория ЦОД напоминает обыкновенный парк.

Еще один известный пример встраивания дата-центра в окружающую экосистему — проект 1&1 Internet в штате Канзас. Для питания и охлаждения компания задействует ветер, энергию солнца, водные и геотермальные ресурсы.

Даже на столь ярких примерах эволюция ЦОД не заканчивается — компании пытаются реализовать самые неординарные идеи. Например, Microsoft работает над проектом [13], который, на первый взгляд, кажется невероятным — дата-центр Natick будет расположен прямо в океане. Проект можно назвать многообещающим, но прежде чем запустить его в «промышленный» режим работы, компания будет проводить всевозможные тесты и эксперименты. Если все пройдет гладко, «облако» Microsoft станет по-настоящему подводным.

Google, в отличие от своего конкурента, предпочитает [14] наводное плавание подводному. Благодаря организации Nautilus Data Technologies, которая в ближайшем будущем запустит свой революционный дата-центр [15] на поверхности воды, концепция барж-дата-центров — уже не новость. Однако специалисты Google решили [16] пойти дальше и генерировать энергию с помощью гигантских воздушных змеев, которые в том числе будут приводить в движение всю плавучую конструкцию.

Дополнительное чтение в нашем корпоративном блоге:

И в нашем блоге на Хабре:

- Из чего складываются затраты на виртуальную и физическую инфраструктуру [19]

- «Дела осадные»: Как компании построить надежную крепость для защиты облака [20]

- Клиент у руля, или почему провайдеру следует передать штурвал [21]

Автор: 1cloud

Источник [22]

Сайт-источник PVSM.RU: https://www.pvsm.ru

Путь до страницы источника: https://www.pvsm.ru/data-tsentry/264441

Ссылки в тексте:

[1] отметил: https://www.greentechmedia.com/articles/read/a-google-data-center-running-as-much-power-as-manhattan-5951

[2] Image: https://habrahabr.ru/company/1cloud/blog/338710/

[3] видео о нашем дата-центре: https://www.youtube.com/watch?v=cufv4CrF364

[4] подробнее: https://1cloud.ru/infrastructure

[5] публикуют: https://www.thegreengrid.org/en/resources/library-and-tools

[6] фрикулинг: http://searchdatacenter.techtarget.com/podcast/Using-free-cooling-in-the-data-center

[7] инициатива: https://stockholmdataparks.com/

[8] объявила: http://www.datacenterdynamics.com/content-tracks/design-build/borderlight-set-to-build-5mw-data-center-in-stockholm-sell-waste-heat/98885.fullarticle

[9] помогает: https://yandex.ru/blog/company/kak-data-tsentr-yandeksa-gorod-obogrel

[10] прямого фрикулинга: https://habrahabr.ru/company/yandex/blog/258823/

[11] Ian D. Keating: https://www.flickr.com/photos/ian-arlett/31737305280/

[12] CC-BY: https://creativecommons.org/licenses/by/2.0/

[13] проектом: https://www.extremetech.com/extreme/222251-under-the-sea-microsoft-testing-underwater-data-centers

[14] предпочитает: https://www.youtube.com/watch?v=ZYNwIfCb440

[15] дата-центр: https://datacenterfrontier.com/nautilus-data-barges-ahead-with-floating-data-center/

[16] решили: http://telecombloger.ru/34023

[17] Технологии охлаждения дата-центров: https://1cloud.ru/blog/ohlajdenie-data-center

[18] Как создать провайдера виртуальной инфраструктуры: https://1cloud.ru/blog/how-to-create-iaas-provider

[19] Из чего складываются затраты на виртуальную и физическую инфраструктуру: https://habrahabr.ru/company/1cloud/blog/338082/

[20] «Дела осадные»: Как компании построить надежную крепость для защиты облака: https://habrahabr.ru/company/1cloud/blog/337428/

[21] Клиент у руля, или почему провайдеру следует передать штурвал: https://habrahabr.ru/company/1cloud/blog/335246/

[22] Источник: https://habrahabr.ru/post/338710/

Нажмите здесь для печати.