Опыт проектирования и строительства дата-центра в Германии часть вторая

Прошло более года с момента прошлого поста (ноябрь 2012, habrahabr.ru/post/157939/ [1]), в котором я поделился опытом строительства и проектирования дата-центра в Германии – в бывшем здании Госбанка Германии – вот снова фото здания.

На тот момент дата-центр был в стадии окончательного планирования, демонтажа, проломов и прочее – вобщем подготовки и расчистки непостредственно под строительство (или же в нашем случае перестройки).

Прошедший с того времени год был нелегким, были определеные сложности, которые выливались в задержки стройки. Сразу забегу вперед – все задержки позади, дата-центр готов и в данный момент уже проходит все тесты.

Но если по порядку, то решили проверить наших проектантов и отдали подряд на сертифицирование дата-центра ТЮФу Рейнланд. Хотя и существует классификация Tier 1-4 от американского uptime institute, которые по сути первыми ввели стандарты дата-центров, но в Европе они дата-центры практически не стандартизируются. Более того, коммерческие дата-центры – по крайней мере в Германии – практически не осуществляют сертифицирование, по большей части только корпоративные сертифицируют. Коммерческие же дата-центры сертифицируются по DIN, ISO и прочим процессам, но нет ни одного сертификата, который подтверждает редундантность сетей и оборудования. Возможно это связано с тем, что именно эти вещи требуют наибольших инвестиций…

ТЮФ Рейнланд является ведущей организацией в Германии, которая осуществляет сертификацию всех систем жизнеобесечения дата-центра в рамках так называемого сертификата «безопасный дата-центр». Требования ТЮФ немного выше, чем у uptime institute, поэтому ТЮФ категория 3, которую мы создаем, соответствует тир 3+. Кстати ТЮФ Рейнланд выложил у себя на странице полный каталог требований, его можно скачать тут:

www.tuv.com/media/germany/50_trainingandconsulting/pdf/kriterienkatalog_cat.pdf [2] (на немецком языке).

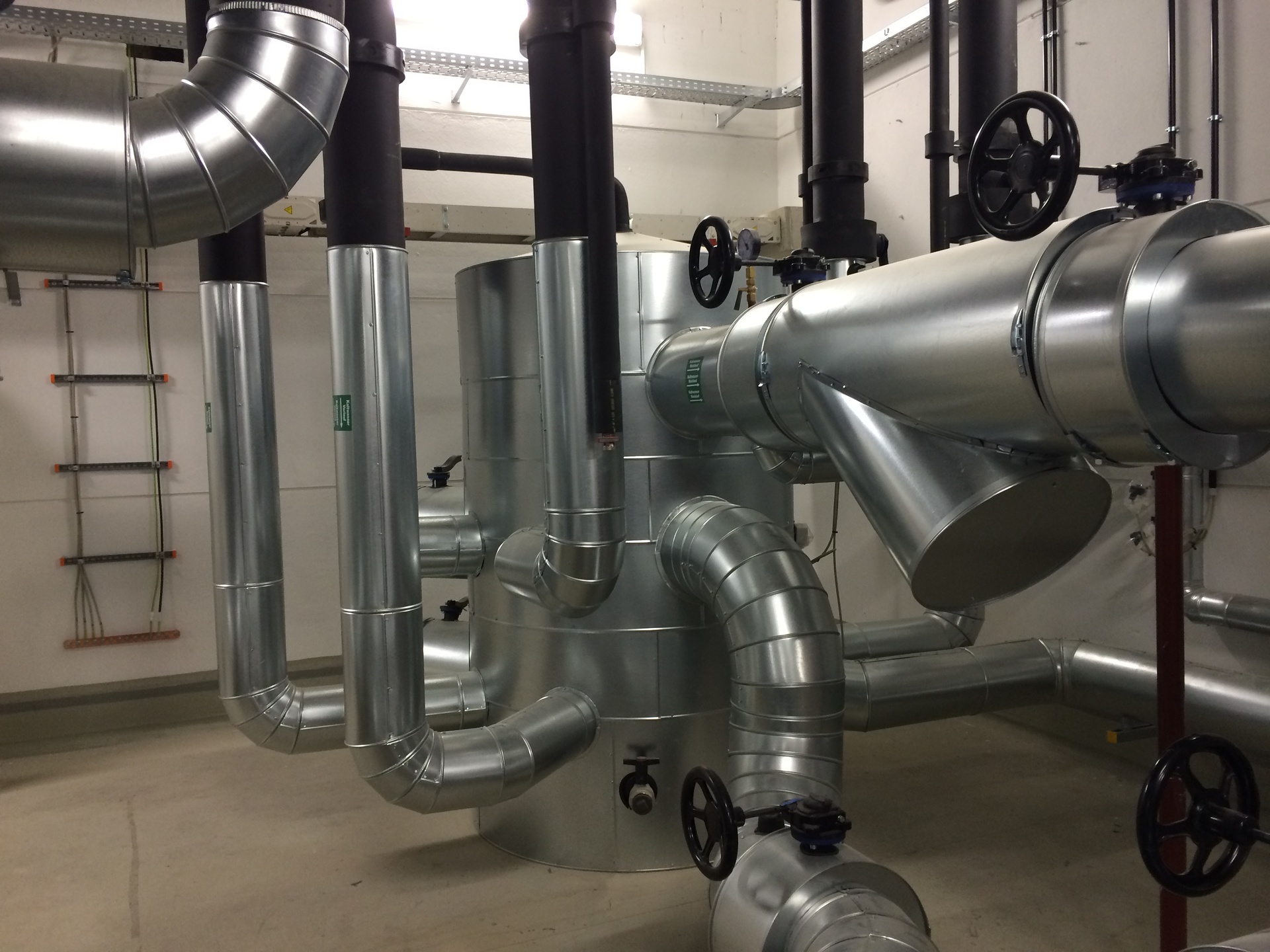

После нескольких проверок ТЮФ вынес вердикт, что нам удалось создать «топ-продукт». Например система охлаждения включает новейшую разработку австрийского производителя Zortea – прибор в форме «осьминога», в котором тепло и холод собираются и распределяются (см. тут: проспект компании на русском языке zortea.at/download/category/18-prospekte-russland.html [3]).

Прибор представляет собой резервуар-цистерну, который яляется промежуточным звеном в системе циркуляции антифриза и состоит из 3-х отделов, в которых собирается охлаждающая жидкость разных температур. Таким образом гидравлически независимый от всей системы резервуар может гибко регулировать температуру «выходящей» воды всей центральной системы охлаждения непосредственно к охладительным шкафам в серверных помещениях.

Все эти новые технологии направлены в первую очередь на снижение расхода электроэнергии, которая – как описывалось в предыдущей статье – будет закупаться на бирже. Если в момент написания прошлой статьи (ноябрь 2012) цена была на уровне 5 — 5,5 центов за кВч, то на данный момент за счет увеличения ее производства, цена снизилась до 3,8 центов за кВч. Но зато дополнительные налоги не только не снизились, но даже увеличились.

Соответственно за счет снижения расхода электроэнергии можно серьёзно оторваться от конкурентов.

Для сравнения эфективности использования энергии в дата-центре есть коэффициент PUE (Power Usage Effectiveness). Каждый дата-центр заявляет, что он у них самый низкий. Доходит до смешного, некоторые пишут, что у них PUE равен 1, а это по сути означает «вечный двигатель». Даже не изобретательностью привлекают клиентов, а фантазией. На самом же деле средний по Германии PUE равняется 2. Это означает, что на каждый кВч расхода на сервере, нужен еще 1 кВч на охлаждение сервера, освещение, системы доступа и прочие службы дата-центра для обеспечения работы сервера. В нашем дата-центре PUE будет составлять 1,5, что означает «дополнительный» расход 0,5 кВч на каждый кВч расхода на сервере. Возможно где-нибудь в Исландии, где можно использовать природную энергию, у Гугла или Амазона PUE равен 1,2. Но там другие проблемы, котоые всем и так понятны…

Кстати по поводу прослушек и прочее: В Германии с местными службами несанкционированая прослушка невозможна, и противозаконна, что регламентируется федеральным законом о защите данных (Bundesdatenschutzgesetz). Выдача данных с серверов осуществляется только по судебному решению, а не по требованию каких-либо служб или чиновников. Защита данных может гаранироваться дата-центром и в случае нарушения клиент может требовать возмещение ущерба.

Но возвращаясь к другим энергосберегающим мероприятиям в части охлаждение:

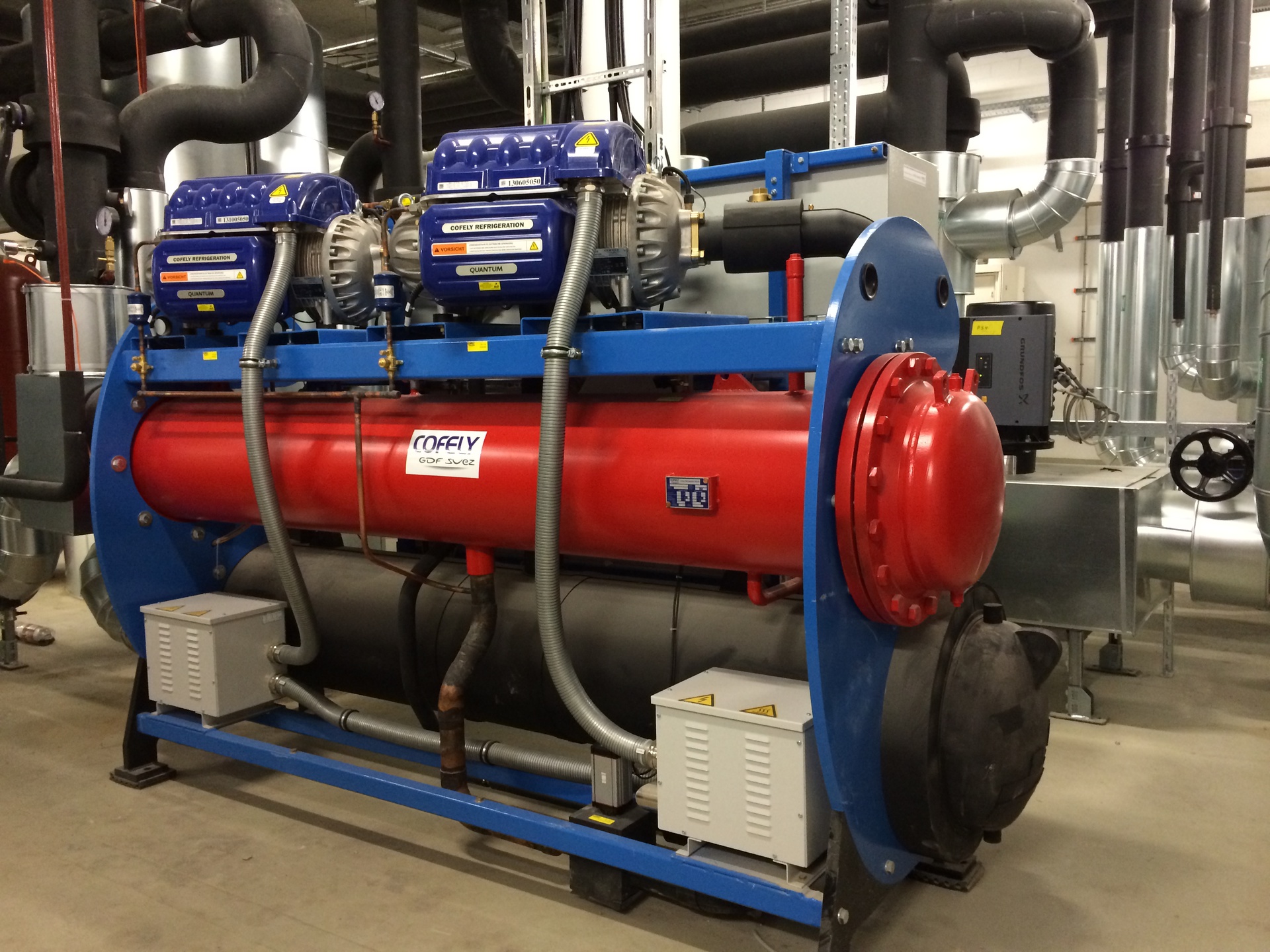

— Купили охладитель Cofely многокомпрессорный, который более дорогой, чем однокомпрессорный, но позволяет работать энергоэффективно при низкой нагрузке, неизбежной при старте дата-центра.

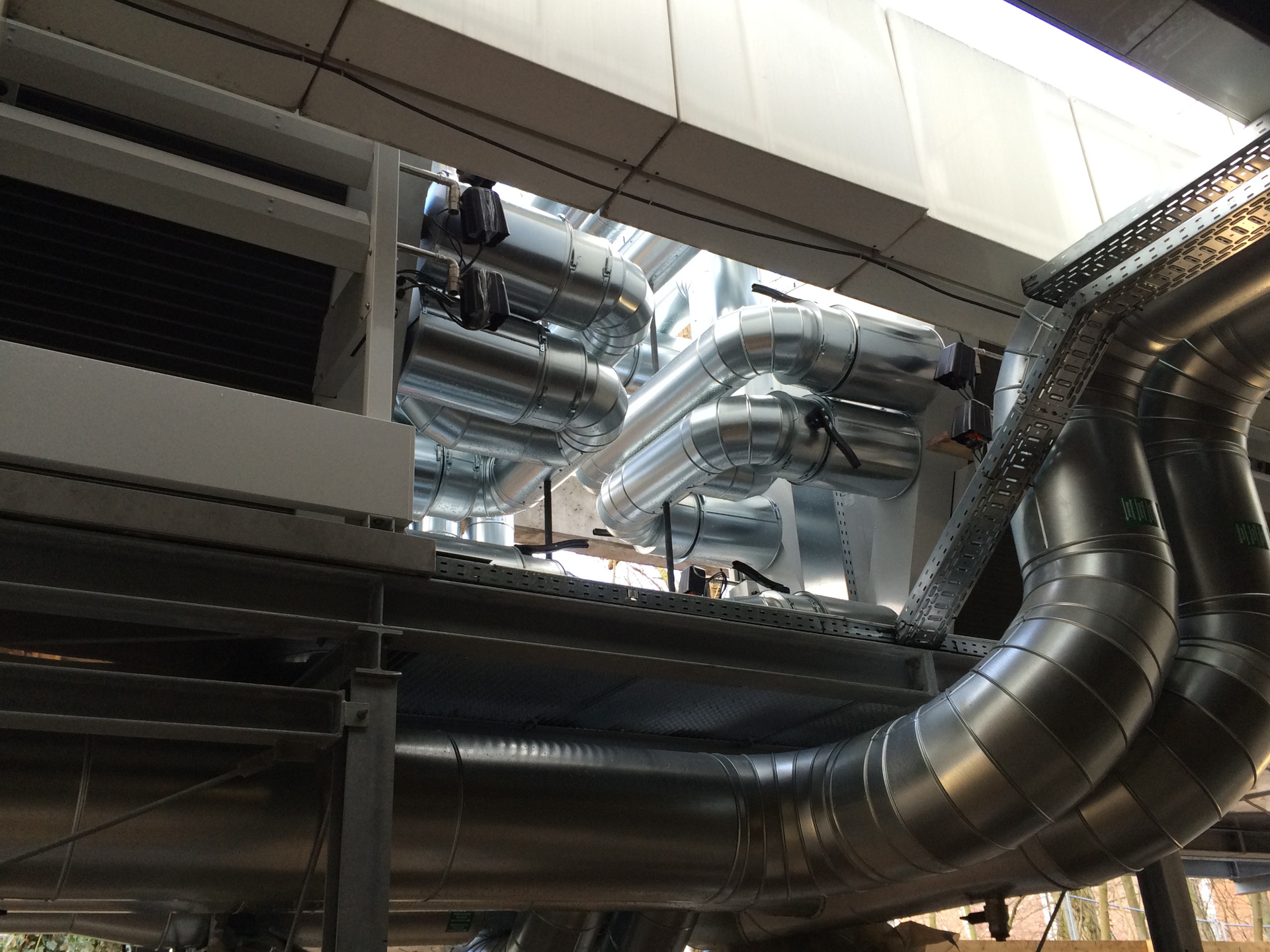

— Снаружи установили кулеры, которые позволяют охлаждать при полной нагрузке (и все по системе N+1) дата-центр при температурах от +15 С и ниже, не включая охладители. А в Дармштадте таких дней минимум половина в году.

Вот для впечатления пример системы труб от внешних кулеров внутрь здания к охладителям (под кулерами):

Кроме того запрограммированы «смешаное» охлаждение – т.е. часть засчет охладителя и часть засчет кулеров с улицы.

А вот внизу на фото дизельный генератор на 2,5 мегаватта, под ним бак на 55.000 литров дизеля (в расчете на всего 3 дизельных генератора) и потребляет он при 100% нагрузке 600 литров в час – как яхта олигарха! Запаса топлива хватает в общей сложности на 48 часов (т.к. N+1, т.е. 2 из 3 дизельных генераторов работают)

На сайте www.da-rz.de/?lang=ru [4] есть видео о здании в первоначальном виде, а также фото стройки.

Ну а вот уже один из серверных залов, в котором на данный момент ведутся окончательные работы по проводке электрошин и кабелей (под фальш-полом) и через 3 недели будут устанавливаться серверные стойки.

Вот в такой серверный зал помещается до 150 стоек, в которые можно установить до 6.000 серверов! Всего же в дата-центре 11 серверных залов (от 55 кв м до 360 кв м), которые вмещают в целом около 900 серверных стоек.

Сами стойки заказали у фирмы Schäffer по индивидуальным критериям – во-первых захотели белый цвет и нам его без доплат сделали (нестандартный цвет у любого производителя, а нам для темно-серого пола подходит классно). Во-вторых крепление разделительных боковых стенок находится внутри шкафа (т.е. снаружи невозможно открутить стенку). В-третьих ввод кабеля через крышу шкафа осуществляется через узкий шлиц, через который просунуть руку невозможно. И так далее. Т.е. учли индивидуальные пожелания клиента без доплат.

Да, и ширина стойки 700 мм, что с нашей точки зрения ни много ни мало. Достаточно удобно для инсталяций и работы внутри стойки. Если ли у кого-то опыт по инсталяции серверов в 700-мм стойке? Был бы благодарен за короткую информацию, чтобы понимать, насколько правильное решение было принято.

Сейчас нанимаем активно персонал – преимущественно на местном рынке. Часть сотрудников русскоязычная, для обслуживания клиентов из России и СНГ. В этой связи ищем сейчас в России дистрибьютора / реселлера. В этом выгодное отличие от других дата-центров в Германии, с которыми в лучшем случае можно только по телефону и на английском общаться.

Кроме того клиентам из России и СНГ будем предлагать оборудование (сервера) по низким ценам или же на базе месячных платежей, так как тут появились хорошие связи с производителями и дистрибюрами. Например в IBM можем получать скидку до 70% от официального прайс-листа.

Вобщем произошло за предыдущее время немало, скоро запуск, который постараюсь осветить в следующем посте!

Автор: Darz

Источник [5]

Сайт-источник PVSM.RU: https://www.pvsm.ru

Путь до страницы источника: https://www.pvsm.ru/germaniya/54685

Ссылки в тексте:

[1] habrahabr.ru/post/157939/: http://habrahabr.ru/post/157939/

[2] www.tuv.com/media/germany/50_trainingandconsulting/pdf/kriterienkatalog_cat.pdf: http://www.tuv.com/media/germany/50_trainingandconsulting/pdf/kriterienkatalog_cat.pdf

[3] zortea.at/download/category/18-prospekte-russland.html: http://zortea.at/download/category/18-prospekte-russland.html

[4] www.da-rz.de/?lang=ru: http://www.da-rz.de/?lang=ru

[5] Источник: http://habrahabr.ru/post/212149/

Нажмите здесь для печати.