У многих парализованных людей, не имеющих возможности говорить, сигналы того, что они хотят сказать сокрыты в их . И никто не мог расшифровать эти сигналы. Но недавно три команды исследователей достигли прогресса в переводе данных, поступающих от электродов помещенных на

Используя модели, построенные на нейронных сетях, они реконструировали слова и даже целые предложения, которые, в некоторых случаях, были вполне вразумительными для обычного слушателя-человека.

Ни одна из попыток, описанных в препринтах работ на bioRxiv, воссоздать речь из мыслей не привела к успеху. Вместо этого исследователи наблюдали за активностью различных областей

«Показать, что реконструированная речь вполне понимаема действетельно волнующе.» — говорит Стефани Мартин, нейро-инженер Женевского Университета в Швейцарии, вовлеченная в работу над этим проектом.

Люди, потерявшие возможность говорить после инсульта, либо в результате болезни, могут использовать глаза или какие-нибудь другие небольшие движения, чтобы контролировать курсор или выбирать буквы на экране (космолог Стивен Хокинг напрягал щеку, чтобы активировать переключатель, установленный на его очках). Но если интерфейс мозг-компьютер сможет воспроизводить непосредственно речь больных, то это позволит намного расширить их возможности: даст контроль над тональностью и позволит принимать участие в быстро текущих беседах.

«Мы пытаемся выработать схему… нейронов, которые активируются в различные моменты времени и сделать вывод о том как при этом звучит речь», — рассказывает Nima Mesgarani, инженер в Колумбийском университете. «Преобразование одного в другое не такое уж прямолинейное.»

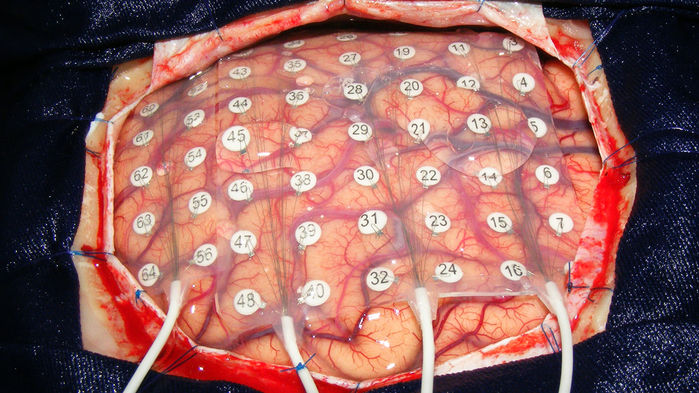

То, как эти сигналы от нейронов преобразуются в речь варьируется от человека к человеку, следовательно компьютерные модели должны тренироваться отдельно под каждого индивида. И лучше всего это получается у моделей, обучающихся на чрезвычайно точных данных, получение которых требует вскрытия черепной коробки.

Исследователи могут получить такую возможность в очень редких случая. Один из них — когда пациенту проводится удаление опухоли головного

«У нас есть максимум 20, иногда 30 минут, чтобы собрать данные», — говорит Стефани Мартин. «Мы очень, очень ограничены во времени».

Наилучших результатов достигли команды, «скармливавшие» данные, полученные от записи активности головного

Команда Nima Mesgarani опиралась на данные от пяти разных пациентов с эпилепсией. Их нейронные сети обучались на записях со слуховой коры головного

Другая команда, под руководством Tanja Schultz из Бременского университета в Германии, использовала данные полученные от 6 человек, проходящих операцию по удалению опухолей головного

Инженеры Miguel Angrick и Christian Herff, из Маастрихтского университета, натренировали нейросеть, которая сопоставила данные, считанные с помощью электродов, с полученными аудио-записями, а затем реконструировала слова и фразы для ранее не показанных модели наборов считанных данных. По этим данным модель синтезировала речь около 40% которой оказалась понятной человеку.

И, наконец, нейрохирург Edward Chang и его команда из Калифорнийского университета в Сан-Франциско реконструировала целые предложения по активности речевого центра, считанной электродами у 6 пациентов, страдающих эпилепсией, в тот момент, когда они читали вслух. Исследователи провели онлайн тест, в котором 166 человек слушали одно из предложений, сгенерированных компьютерной моделью и затем должны были выбрать среди 10 предложенных вариантов тот, который, по их мнению, был прочитан. Некоторые предложения были верно определеных более чем в 80% случаев. Но на этом исследователи не остановились и заставили модель воссоздать речь человека по данным от активности

«Это очень важный результат», — говорит Christian Herff, — «мы на один шаг ближе к протезированию речи.»

«Однако чего мы действительно ждем, так это того как эти методы покажут себя в случае, когда пациент вообще не может говорить». — Отзывается Stephanie Riès, нейробиолог из университета Сан-Диего в Калифорнии. «Сигналы

«Декодирование воображаемой речи потребует огромного скачка вперед.», — Говорит Gerwin Schalk, нейробиолог из Национального центра адаптивных нейротехнологий департамента здравоохранения штата Нью-Йорк. — «И сейчас совершенно не ясно как этого достичь».

Одним из методов, по словам Herff'а, может стать обратная связь, которую пациент будет давать компьютерной модели, которая будет воспроизводить речь в режиме реального времени по мере того, как человек будет мысленно проговаривать слова. При достаточном объеме тренировок как пациента так и ИИ,

Автор: 640509-040147