Все мы помним со школы мучительные упражнения в арифметике. На то, чтобы перемножить числа вроде 3 752 и 6 901 при помощи карандаша и бумаги, уйдёт не меньше минуты. Конечно же, сегодня, когда под рукой у нас телефоны, мы быстро можем проверить, что результат нашего упражнения должен равняться 25 892 552. Процессоры современных телефонов могут выполнять более 100 млрд таких операций в секунду. Более того, эти чипы потребляют всего несколько ватт, что делает их гораздо эффективнее наших медленных мозгов, потребляющих 20 Вт и требующих гораздо большего времени на достижение того же результата.

Все мы помним со школы мучительные упражнения в арифметике. На то, чтобы перемножить числа вроде 3 752 и 6 901 при помощи карандаша и бумаги, уйдёт не меньше минуты. Конечно же, сегодня, когда под рукой у нас телефоны, мы быстро можем проверить, что результат нашего упражнения должен равняться 25 892 552. Процессоры современных телефонов могут выполнять более 100 млрд таких операций в секунду. Более того, эти чипы потребляют всего несколько ватт, что делает их гораздо эффективнее наших медленных мозгов, потребляющих 20 Вт и требующих гораздо большего времени на достижение того же результата.

Конечно же, эволюционировал не для того, чтобы заниматься арифметикой. Поэтому у него это получается плохо. Но он прекрасно справляется с обработкой постоянного потока информации, идущего от нашего окружения. И он реагирует на неё – иногда быстрее, чем мы можем это осознать. И неважно, сколько энергии будет потреблять обычный компьютер – он с трудом будет справляться с тем, что легко даётся

Если бы могли создать машины, вычислительные способности и энергетическая эффективность которых были бы сравнимы с

Но не рано ли ставить себе такие смелые цели? Не слишком ограничено ли наше понимание

Ключевая особенность обычных компьютеров – физическое разделение памяти, хранящей данные и инструкции, и логики, обрабатывающей эту информацию. В

Говоря об исключительных возможностях человеческого

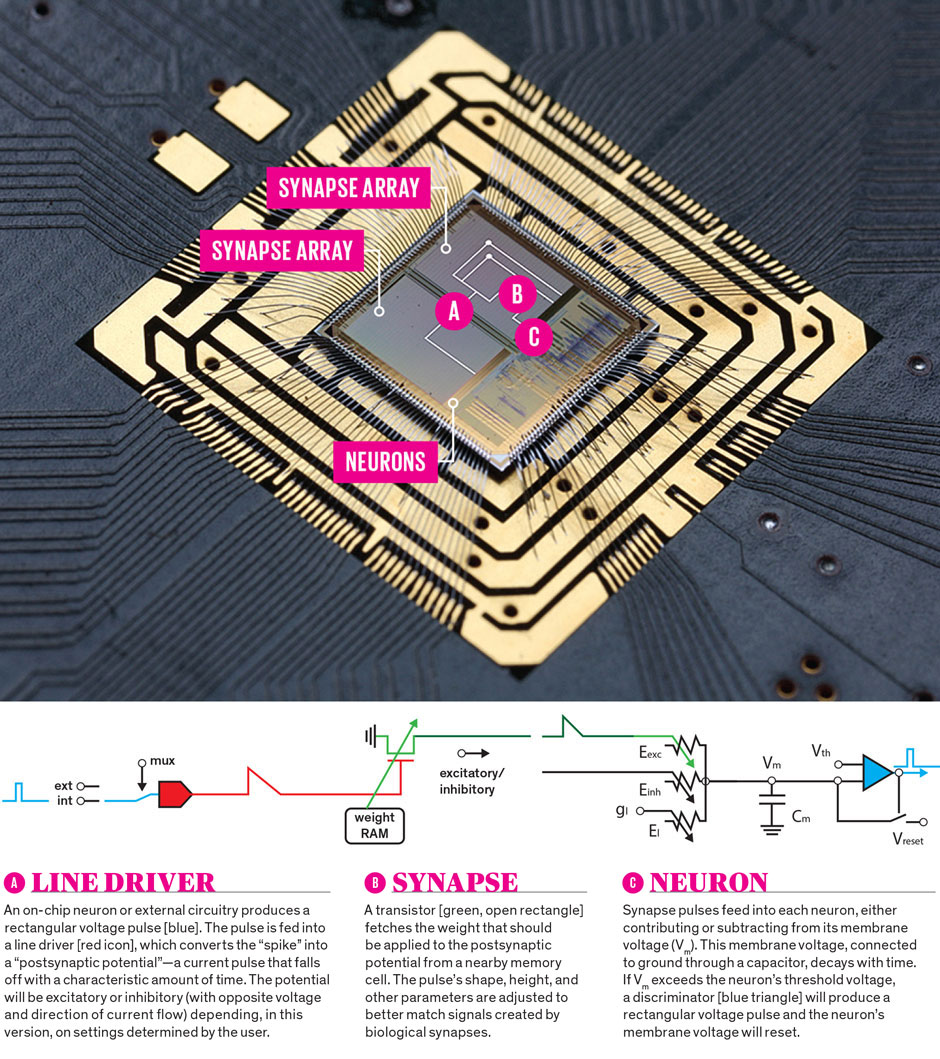

Как у всех клеток человеческого тела, у нейрона существует электрический потенциал порядка 70 мВ между внешней поверхностью и внутренностями. Это мембранное напряжение изменяется, когда нейрон получает сигнал от других связанных с ним нейронов. Если мембранное напряжение поднимается до критической величины, он формирует импульс, или скачок напряжения, длящийся несколько миллисекунд, величиной порядка 40 мВ. Этот импульс распространяется по аксону нейрона, пока не доходит до синапса – сложной биохимической структуры, соединяющей аксон одного нейрона с дендритом другого. Если импульс удовлетворяет определённым ограничениям, синапс преобразует его в другой импульс, идущий вниз по ветвящимся дендритам нейрона, получающего сигнал, и меняет его мембранное напряжение в положительную или отрицательную сторону.

Связность – критическая особенность

Современные компьютеры общего назначения цифровые, а не аналоговые;

Ещё одно ключевое отличие

У идеи использования

В 1957 году Фрэнк Розенблатт предложил другой вариант порогового нейрона, перцептрон. Сеть из взаимосвязанных узлов (искусственных нейронов) составляется слоями. Видимые слои на поверхности сети взаимодействуют с внешним миром в качестве входов и выходов, а скрытые слои, находящиеся внутри, выполняют все вычисления.

Розенблатт также предложил использовать основную особенность

Нам известно, что впечатляющих вычислительных результатов можно добиться и без попыток создать биологический реализм. Исследователи глубинного обучения продвинулись очень далеко в деле использования компьютеров для анализа крупных объёмов данных и выделения определённых признаков из сложных изображений. Хотя созданные ими нейросети обладают большим количеством входов и скрытых слоёв, чем когда бы то ни было, они всё-таки основаны на крайне простых моделях нейронов. Их широкие возможности отражают не биологический реализм, а масштаб содержащихся в них сетей и мощность используемых для их тренировки компьютеров. Но сетям с глубинным обучением всё ещё очень далеко до вычислительных скоростей, энергетической эффективности и возможностей обучения биологического

Огромный разрыв между

Почему же они такие медленные? Симуляция

Эти симуляции могут стать инструментом познания

Нейроны в кремнии.

Копирование работы

Идея о создании компьютеров при помощи транзисторов, работающих как нейроны, появилась в 1980-х у профессора Карвера Мида из Калтеха. Одним из ключевых аргументов Мида в пользу «нейроморфных» компьютеров было то, что полупроводниковые устройства могут, работая в определённом режиме, следовать тем же физическим законам, что и нейроны, и что аналоговое поведение можно использовать для расчётов с большой энергоэффективностью.

Группа Мида также изобрела платформу для нейрокоммуникаций, в которой всплески кодируются только их адресами в сети и временем возникновения. Эта работа стала новаторской, поскольку она первой сделала время необходимой особенностью искусственных нейросетей. Время – ключевой фактор для

Несколько активных сегодня исследовательских групп, например, группа Джиакомо Индивери из Швейцарской высшей технической школы и Квабены Боахен из Стэнфорда, пошли по стопам Мида и успешно внедрили элементы биологических корковых сетей. Фокус в том, чтобы работать с транзисторами при помощи тока низкого напряжения, не достигающего их порогового значения, создавая аналоговые схемы, копирующие поведение нервной системы, и при этом потребляющие немного энергии.

Дальнейшие исследования в этом направлении могут найти применение в таких системах, как интерфейс мозг-компьютер. Но между этими системами и реальным размером сети, связности и способностью к обучению животного

Так что в районе 2005 году три группы исследователей независимо начали разрабатывать нейроморфные системы, существенно отличающиеся от изначального подхода Мида. Они хотели создать крупномасштабные системы с миллионами нейронов.

Ближе всех к обычным компьютерам стоит проект SpiNNaker, руководимый Стивом Фёрбером из Манчестерского университета. Эта группа разработала собственный цифровой чип, состоящий из 18 процессоров ARM, работающих на 200 МГц – примерно одна десятая часть скорости современных CPU. Хотя ядра ARM пришли из мира классических компьютеров, они симулируют всплески, отправляемые через особые маршрутизаторы, разработанные так, чтобы передавать информацию асинхронно – прямо как

Чип TrueNorth, разработанный Дармендра Мода и его коллегами из Исследовательской лаборатории IBM в Альмадене, отказывается от использования микропроцессоров как вычислительных единиц, и представляет собой на самом деле нейроморфную систему, в которой переплелись вычисления и память. TrueNorth всё равно остаётся цифровой системой, но основана она на специально разработанных нейроконтурах, реализующих определённую модель нейрона. В чипе содержится 5,4 млрд транзисторов, он построен по 28-нм технологии Samsung КМОП (комплементарная структура металл-оксид-полупроводник). Транзисторы эмулируют 1 млн нейроконтуров и 256 млн простых (однобитных) синапсов на одном чипе.

Я бы сказал, что следующий проект, BrainScaleS, отошёл довольно далеко от обычных компьютеров и приблизился к биологическому

Система может воспроизводить девять различных режимов срабатывания биологических нейронов, и разработана в тесном сотрудничестве с нейробиологами. В отличие от аналогового подхода Мида, BrainScaleS работает в ускоренном режиме, его эмуляция в 10 000 раз быстрее реального времени. Это особенно удобно для изучения процесса обучения и развития.

Обучение, скорее всего, станет критическим компонентом нейроморфных систем. Сейчас чипы, сделанные по образу

Во втором поколении нашей системы BrainScaleS мы реализовали возможность обучения, создав на чипе «обработчики гибкости». Они используются для изменения широкого спектра параметров нейронов и синапсов. Эта возможность позволяет нам точно подстраивать параметры для компенсации различий в размере и электрических свойствах при переходе от одного устройства к другому – примерно как сам

Три описанных мной крупномасштабных системы дополняют друг друга. SpiNNaker можно гибко настраивать и использовать для проверки разных нейромоделей, у TrueNorth высока плотность интеграции, BrainScaleS разработана для постоянного обучения и развития. Поиски правильного способа оценки эффективности таких систем пока продолжаются. Но и ранние результаты многообещающие. Группа TrueNorth от IBM недавно подсчитала, что синаптическая передача в их системе отнимает 26 пДж. И хотя это в 1000 раз больше энергии, требующейся в биологической системе, зато это почти в 100 000 раз меньше энергии, уходящей на передачу в симуляции на компьютерах общего назначения.

Мы всё ещё находимся на ранней стадии понимания того, что могут делать такие системы и как их применять к решению реальных задач. Одновременно мы должны найти способы комбинировать множество нейроморфных чипов в крупные сети с улучшенными возможностями к обучению, при этом понижая энергопотребление. Одна из проблем – связность:

Ещё одним подспорьем могут стать устройства, не основанные на КМОП – мемристоры или PCRAM (память с изменением фазового состояния). Сегодня веса, определяющие реакцию искусственных синапсов на входящие сигналы, хранятся в обычной цифровой памяти, отнимающей большую часть кремниевых ресурсов, необходимых для построения сети. Но другие виды памяти могут помочь нам уменьшить размеры этих ячеек с микрометровых до нанометровых. И основной трудностью современных систем будет поддержка различий между разными устройствами. Для этого смогут помочь принципы калибровки, разработанные в BrainScaleS.

Мы только начали свой путь по дороге к практичным и полезным нейроморфным системам. Но усилия стоят того. В случае успеха мы не только создадим мощные вычислительные системы; мы даже можем получить новую информацию о работе нашего собственного

Автор: SLY_G