NVMe over Fabric, Fibre Channel и другие

Про грядущую смерть Fibre Channel говорят разве что чуть меньше, чем про смерть ленточных накопителей. Еще когда скорость была ограничена 4 Гбит, уже тогда на смену FC прочили новомодный iSCSI (пусть вменяемый бюджет только на 1 Гбит вариант, но 10 где-то уже совсем рядом). Время шло, а 10Гбит ethernet оставался слишком дорогим удовольствием и к тому же не мог обеспечить низкую латентность. ISCSI в качестве протокола общения серверов с дисковыми системами хоть и получил значительное распространение, но полностью вытеснить FC так и не смог.

Про грядущую смерть Fibre Channel говорят разве что чуть меньше, чем про смерть ленточных накопителей. Еще когда скорость была ограничена 4 Гбит, уже тогда на смену FC прочили новомодный iSCSI (пусть вменяемый бюджет только на 1 Гбит вариант, но 10 где-то уже совсем рядом). Время шло, а 10Гбит ethernet оставался слишком дорогим удовольствием и к тому же не мог обеспечить низкую латентность. ISCSI в качестве протокола общения серверов с дисковыми системами хоть и получил значительное распространение, но полностью вытеснить FC так и не смог.

Прошедшие годы показали, что инфраструктура Fibre Channel продолжает активно развиваться, скорость интерфейсов растет и говорить о грядущей кончине явно преждевременно. А еще весной этого (2016) года был анонсирован стандарт Gen 6, удвоивший максимальную скорость с 16GFC до 32GFC. Помимо традиционного увеличения производительности, технология получила и ряд других новшеств.

Стандарт позволяет объединить 4 линии FC в один канал 128GFC для соединения коммутаторов друг с другом через высокоскоростной ISL линк. Коррекция ошибок (Forward Error Correction, FEC) уже была доступна в продуктах FC пятого поколения в виде опции, но в Gen 6 ее поддержка стала обязательной. На столь высоких скоростях не только вероятность возникновения ошибок возрастает (BER для Gen 6 составляет 10-6), но и еще больше возрастает влияние ошибок на производительность из-за необходимости перепосылки кадров. FEC позволяет принимающей стороне исправлять ошибки без необходимости делать повторные запросы на перепосылку кадра. Как следствие, мы получаем более «ровную» скорость передачи данных. Не обошли вниманием и энергоэффективность — для снижения энергопотребления медные порты могут полностью отключаться, а оптические снижать мощность до 60%.

По-прежнему, сильной стороной технологии FC является низкая латентность (которая стала еще на 70% ниже в сравнении с широко используемым сейчас 8 Гбит стандартом). Именно сочетание низкой латентности и высокой производительности делает 32GFC подходящим решением для подключения All-Flash массивов. На горизонте уже все отчетливее видим NVMe системы, предъявляющие высочайшие требования к инфраструктуре сети хранения и 32GFC имеет все шансы завоевать достойное место.

Чипы FC Gen 6, адаптеры и коммутатор Brocade G620 были объявлены весной вместе с самим стандартом, а не так давно были анонсированы и новые директоры (шассийные коммутаторы) семейства Brocade X6 Director. В максимальной конфигурации (8 слотов) он поддерживает до 384 портов 32GFC + 32 порта 128GFC с суммарной пропускной способностью 16Тбит. В зависимости от шасси можно установить 8 или 4 линейные карты FC32-48 (48 портов 32GFC), либо мультипротокольные карты SX6 (16 портов 32GFC, 16 портов 1/10GbE и два порта 40GbE). Лезвия SX6 позволяют использовать IP-сети для соединения коммутаторов. К сожалению, не обошлось без апгрейда шасси и старый-добрый DCX-8510 нельзя проапгрейдить до 32GFC, зато для линейки X6 заявлена поддержка карт Gen 7 стандарта.

Значительное внимание уделено не только аппаратным возможностям, но и системе управления. Brocade Fabric Vision с технологией IO Insight позволяет осуществлять проактивный мониторинг за всем каналом ввода-вывода, в том числе и не только до физических серверов, но и от отдельных виртуальных машин до конкретных LUN на СХД. В условиях, когда на одной системе хранения консолидируется множество различных приложений, анализ производительности всего комплекса довольно сложен и сбор метрик на уровне коммутатора может существенно упростить поиск проблемы. Настраиваемые алерты помогают быстрее реагировать на потенциальные проблемы и не допускать деградации производительности ключевых приложений.

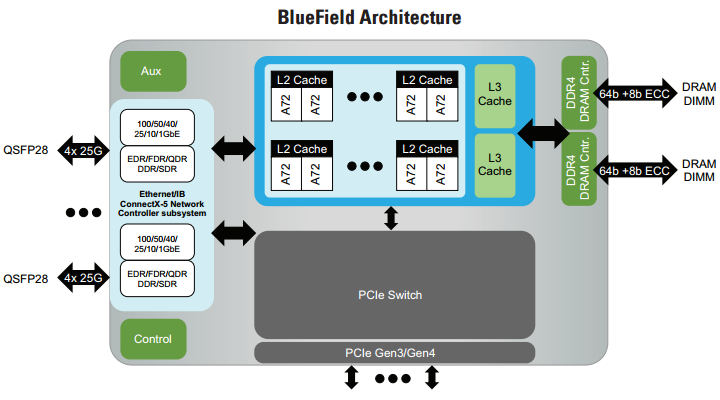

Но конечно не единым Fibre Channel живем и Mellanox объявил о готовящемся выходе семейства чипов BlueField. Это системы на кристалле (SoC) с поддержкой NVMe over Fabric и интегрированным контроллером ConnecX-5. Чип поддерживает Infiniband вплоть до скоростей EDR (100Gb/s), а также 10/25/40/50/100Gb Ethernet. BlueField нацелен на применение как в NVMe AllFlash массивах, так и в серверах для подключения NVMe over Fabric. Ожидается, что использование подобных специализированных устройств даст возможность увеличить эффективность серверов, что очень важно для HPC. Использование в качестве сетевого контроллера для NVMe СХД избавляет от PCI express коммутаторов и мощных процессоров. Кто-то может сказать, что такие специализированные устройства идут вразрез с идеологией software defined storage и использования commodity hardware. Я же считаю, что коль скоро мы получаем возможность снизить цену решения и оптимизировать производительность, это и есть правильный подход. Первые поставки BlueField обещаны уже в начале 2017.

В ближайшей перспективе количество NVMe систем хранения будет неуклонно возрастать. Подключение серверов через PCI-express коммутатор хотя и обеспечивает максимальную скорость, но имеет целый ряд недостатков, поэтому очень кстати подоспела опубликованная версия 1.0 стандарта «NVM Express over Fabrics”. В качестве транспорта может использоваться FC или RDMA фабрика, последняя в свою очередь может быть физически реализована на базе Infiniband, iWARP или RoCE.

RDMA транспорт через Infiniband будет превалировать скорее в HPC системах, а также там, где есть возможность приложить руки “самоделкиным”. В этой фразе нет никакого негатива — Fibre Channel уже много лет является признанным корпоративным стандартом и вероятность нарваться на проблемы гораздо ниже, чем при использовании RDMA. Это касается как вопросов совместимости с широким кругом прикладного ПО, так и простоте управления. Все это имеет цену, за которой корпоративный рынок внимательно следит.

В свое время некоторые производители прочили большой успех технологии FCoE, как позволяющей унифицировать сеть хранения с обычной сетью передачи данных, но по факту добиться значимых успехов по завоеванию рынка так и не удалось. Сейчас довольно активно развивается тема NVMe СХД с подключением к сети Ethernet и передаче данных NVMe over Fabric через RoCE (RDMA over Converged Ethernet). Есть вероятность, что здесь успех будет более значимым, чем с внедрением FCoE в массы, но уверен, что мы увидим еще не одно поколение Fibre Channel устройств. И сейчас очень рано говорить о том, что “наконец-то можно обойтись только ethernet” — да, часто можно, но далеко не факт, что это будет дешевле.

Сегодня, если FC сеть уже развернута, то очень редко есть смысл внедрять альтернативные решения — лучше провести модернизацию оборудования до Gen 6 или Gen 5 стандартов — эффект будет даже при частичном апгрейде. Несмотря на то, что имеющаяся СХД не поддерживает максимальную скорость, обновление сети хранения часто позволяет снизить латентность и увеличить интегральную производительность всего комплекса.

Инженеры Тринити будут рады проконсультировать вас по вопросам виртуализации серверов, систем хранения данных, рабочих мест, приложений, сетей.

Посетите популярный технический форум Тринити [1] или закажите консультацию [2].

Другие статьи Тринити можно найти в блоге [3] и хабе Тринити. [4] Подписывайтесь!

Автор: Тринити

Источник [5]

Сайт-источник PVSM.RU: https://www.pvsm.ru

Путь до страницы источника: https://www.pvsm.ru/it-infrastruktura/184507

Ссылки в тексте:

[1] технический форум Тринити: http://3nity.ru/

[2] закажите консультацию: http://www.trinitygroup.ru/about/kons/

[3] в блоге: http://blog.trinitygroup.ru/

[4] хабе Тринити.: https://habrahabr.ru/company/trinity/

[5] Источник: https://habrahabr.ru/post/309086/?utm_source=habrahabr&utm_medium=rss&utm_campaign=best

Нажмите здесь для печати.