Всем привет! Настало время пополнить наш с вами алгоритмический арсенал.

Сегодня мы основательно разберем один из наиболее популярных и применяемых на практике алгоритмов машинного обучения — градиентный бустинг. Наша задача — основательно разобраться в бустинге, поэтому статья разбита на 2 части: сегодня мы разберем основную теорию алгоритма, а через 2 недели — практику.

О том, откуда у бустинга растут корни и что на самом деле творится под капотом алгоритма — в нашем красочном путешествии в мир бустинга под катом. Рванули!

- Первичный анализ данных с Pandas

- Визуальный анализ данных c Python

- Классификация, деревья решений и метод ближайших соседей

- Линейные модели классификации и регрессии

- Композиции: бэггинг, случайный лес. Кривые валидации и обучения

- Построение и отбор признаков

- Обучение без учителя: PCA, кластеризация

- Обучаемся на гигабайтах c Vowpal Wabbit

- Анализ временных рядов с помощью Python

- Градиентный бустинг, часть 1

- Градиентный бустинг, часть 2

План этой статьи:

- Введение и история бустинга

- GBM алгоритм

- Функции потерь

- Итог про теорию GBM

- Домашнее задание №10

- Полезные ссылки

1. Введение и история появления бустинга

Большинство людей, причастных к анализу данных, хоть раз слышали про бустинг. Этот алгоритм входит в повседневный "джентльменский набор" моделей, которые стоит попробовать в очередной задаче. Xgboost и вовсе часто ассоциируется со стандартным рецептом для победы в ML соревнованиях, породив мем про "стакать xgboost-ы". А еще бустинг является важной частью большинства поисковых систем, иногда выступая еще и их визитной карточкой. Давайте для общего развития посмотрим, как бустинг появился и развивался.

История появления бустинга

Все началось с вопроса о том, можно ли из большого количества относительно слабых и простых моделей получить одну сильную. Под слабыми моделями мы подразумеваем не просто небольшие и простые модели вроде деревьев решений в противовес более "сильным" моделям, например, нейросетям. В нашем случае слабые модели — это произвольные алгоритмы машинного обучения, точность которых может быть лишь немногим выше случайного угадывания.

Утвердительный математический ответ на этот вопрос нашелся довольно быстро, что само по себе было важным теоретическим результатом (редкость в ML). Однако, потребовалось несколько лет до появления работоспособных алгоритмов и Adaboost. Их общий подход заключался в жадном построении линейной комбинации простых моделей (базовых алгоритмов) путем перевзвешивания входных данных. Каждая последующая модель (как правило, дерево решений) строилась таким образом, чтобы придавать больший вес и предпочтение ранее некорректно предсказанным наблюдениям.

По-хорошему, нам следовало бы последовать примеру большинства остальных курсов по машинному обучению, и перед градиентным бустингом тщательно разобрать его предтечу — Adaboost. Однако, мы решили сразу перейти к самому интересному, так как Adaboost все равно в итоге слился с GBM, когда стало понятно, что это просто его частная вариация.

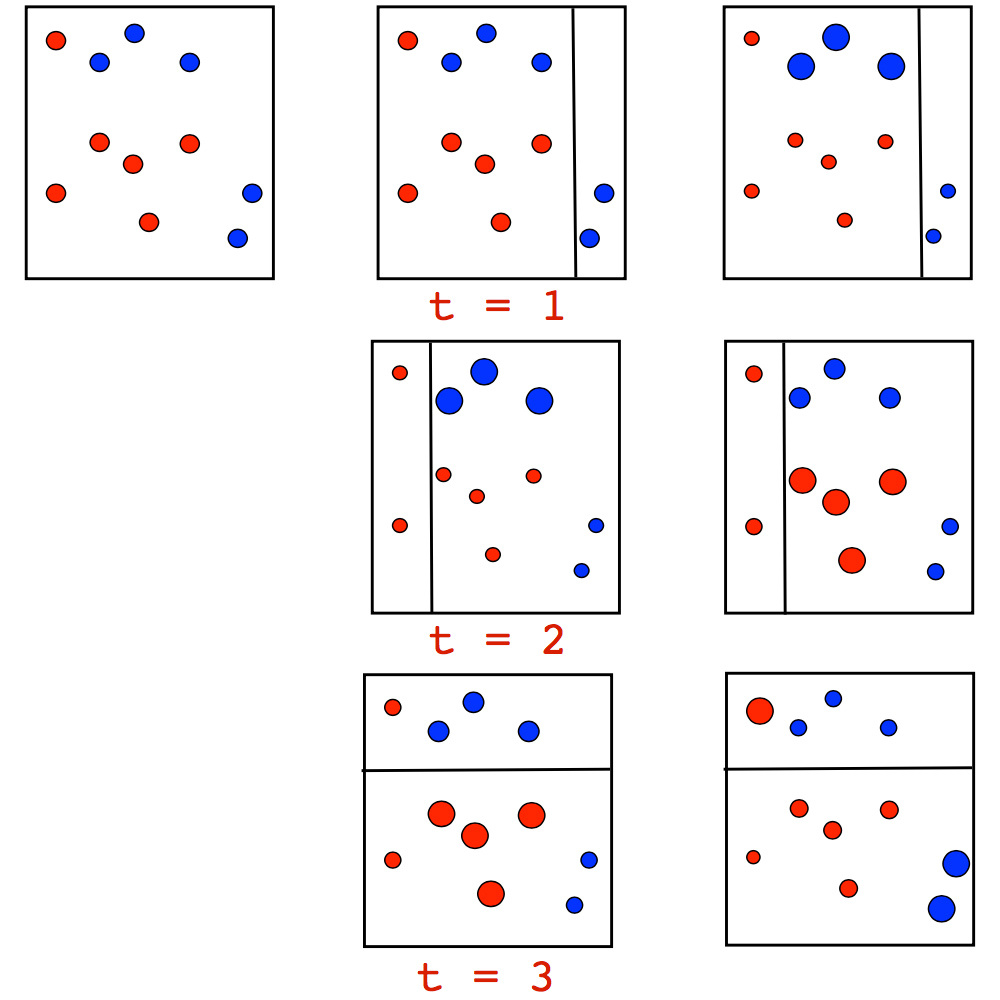

Сам алгоритм имеет очень наглядную визуальную интерпретацию стоящей за ним интуиции взвешивания наблюдений. Рассмотрим игрушечный пример задачи классификации, в которой мы будем пробовать на каждой итерации Adaboost разделить данные деревом глубины 1 (так называемым "пнем"). На первых двух итерациях мы увидим следующую картинку:

Размер точки соответствует полученному ей весу за ошибочное предсказание. И мы видим, как на каждой итерации эти веса растут — пни не могут в одиночку справиться с такой задачей. Однако, когда мы произведем взвешенное голосование ранее построенных пней, мы получим искомое нами разделение:

Более подробный пример работы Adaboost, на котором в течение серии итераций видно последовательное увеличение точек, особенно на границе между классами:

Adaboost работал хорошо, но из-за того, что обоснований работы алгоритма с его надстройками было мало, вокруг них возник полный спектр спекуляций: кто-то считал его сверх-алгоритмом и волшебной пулей, кто-то был скептичен и разделял мнение, что это малоприменимый подход с жесткой переподгонкой (overfitting). Особенно сильно это касалось применимости на данных с мощными выбросами, к которым Adaboost оказался неустойчив. К счастью, когда за дело взялась профессура Стэнфордской кафедры статистики, уже принесшая миру Lasso, Elastic Net и Random Forest, в 1999 году от Jerome Friedman появилось обобщение наработок алгоритмов бустинга — градиентный бустинг, он же Gradient Boosting (Machine), он же GBM. Этой работой Friedman сразу задал статистическую базу для создания многих алгоритмов, предоставив общий подход бустинга как оптимизации в функциональном пространстве.

Вообще, команда Стэнфордской кафедры статистики причастна и к CART, и к bootstrap, и еще ко многим вещам, заранее внеся свои имена в будущие учебники статистики. По большому счету значительная часть нашего повседневного инструментария появилась именно там, и кто знает, что еще появится. Или уже появилось, но еще не нашло достаточного распространения (как, например, glinternet).

С самим Friedman-ом не так много видеозаписей. Однако, с ним есть очень интересное интервью про создание CART, и вообще про то, как решали статистические задачки (которые мы бы отнесли к анализу данных и data science) 40+ лет назад:

Из серии познавательной истории анализа данных, есть также лекция от Hastie с ретроспективой анализа данных от одного из участников создания наших с вами ежедневно используемых методов:

По сути, произошел переход от инженерно-алгоритмических изысканий в построении алгоритмов (так свойственных в ML) к полноценной методологии, как такие алгоритмы строить и изучать. С точки зрения математической начинки, на первый взгляд изменилось не так много: мы всё также добавляем (бустим) слабые алгоритмы, наращивая наш ансамбль постепенными улучшениями тех участков данных, где предыдущие модели "не доработали". Но при построении следующей простой модели, она строится не просто на перевзвешенных наблюдениях, а так, чтобы лучшим образом приближать общий градиент целевой функции. На концептуальном уровне это дало большой простор для фантазии и расширений.

По сути, произошел переход от инженерно-алгоритмических изысканий в построении алгоритмов (так свойственных в ML) к полноценной методологии, как такие алгоритмы строить и изучать. С точки зрения математической начинки, на первый взгляд изменилось не так много: мы всё также добавляем (бустим) слабые алгоритмы, наращивая наш ансамбль постепенными улучшениями тех участков данных, где предыдущие модели "не доработали". Но при построении следующей простой модели, она строится не просто на перевзвешенных наблюдениях, а так, чтобы лучшим образом приближать общий градиент целевой функции. На концептуальном уровне это дало большой простор для фантазии и расширений.

История становления GBM

Свое место в "джентльменском наборе" градиентный бустинг занял не сразу — на это потребовалось больше 10 лет с момента появления. Во-первых, у базового GBM появилось много расширений под разные статистические задачи: GLMboost и GAMboost как усиление уже имеющихся GAM моделей, CoxBoost для кривых дожития, RankBoost и LambdaMART для ранжирования. Во-вторых, появилось много реализаций того же GBM под разными названиями и разных платформах: Stochastic GBM, GBDT (Gradient Boosted Decision Trees), GBRT (Gradient Boosted Regression Trees), MART (Multiple Additive Regression Trees), GBM как Generalised Boosting Machines и прочие. К тому же, сообщества machine learner-ов были достаточно разобщены и занимались всем подряд, из-за этого отследить успехи бустинга достаточно сложно.

В то же время бустинг начали активно применять в задачах ранжирования выдачи поисковых систем. Эту задачу выписали с точки зрения функции потерь, которая штрафует за ошибки в порядке выдачи, так что стало удобно просто вставить ее в GBM. Одними из первых внедрили бустинг в ранжирование AltaVista, а вскоре за ними последовали Yahoo, Yandex, Bing и другие. Причем, говоря о внедрении, речь шла о том, что бустинг на годы вперед становился основным алгоритмом внутри работающих движков, а не еще одной взаимо-заменяемой исследовательской поделкой, живущей в рамках пары научных статей.

Главную роль в популяризации бустинга сыграли ML соревнования, в особенности kaggle. Исследователям давно не хватало общей платформы, где было бы достаточно участников и задач, чтобы в открытой борьбе за state of the art соревновались люди с их алгоритмами и подходами. Сумрачным немецким гениям, вырастившим у себя в гараже очередной чудо-алгоритм стало нельзя все списывать на закрытые данные, а реальные прорывные библиотеки наоборот получали отличную площадку для развития. Именно это и произошло с бустингом, который прижился на kaggle почти сразу (стоит искать GBM в интервью победителей с 2011 года), а xgboost как библиотека быстро завоевал популярность вскоре после своего появления. При этом xgboost — это не какой-то новый уникальный алгоритм, а просто крайне эффективная реализация классического GBM с некоторыми дополнительными эвристиками.

Главную роль в популяризации бустинга сыграли ML соревнования, в особенности kaggle. Исследователям давно не хватало общей платформы, где было бы достаточно участников и задач, чтобы в открытой борьбе за state of the art соревновались люди с их алгоритмами и подходами. Сумрачным немецким гениям, вырастившим у себя в гараже очередной чудо-алгоритм стало нельзя все списывать на закрытые данные, а реальные прорывные библиотеки наоборот получали отличную площадку для развития. Именно это и произошло с бустингом, который прижился на kaggle почти сразу (стоит искать GBM в интервью победителей с 2011 года), а xgboost как библиотека быстро завоевал популярность вскоре после своего появления. При этом xgboost — это не какой-то новый уникальный алгоритм, а просто крайне эффективная реализация классического GBM с некоторыми дополнительными эвристиками.

И вот мы здесь, в 2017 году, пользуемся алгоритмом, который прошел очень типичный для ML путь от математической задачи и алгоритмических поделок через появление нормальных алгоритмов и нормальной методологии к успешным практическим приложениям и массовому использованию через годы после своего появления.

2. GBM алгоритм

Постановка ML задачи

Мы будем решать задачу восстановления функции в общем контексте обучения с учителем. У нас будет набор пар признаков

Пока что мы не делаем каких-либо предположений ни о типе зависимости

К сожалению, функций

Аналитические решения для получения оптимальных параметров

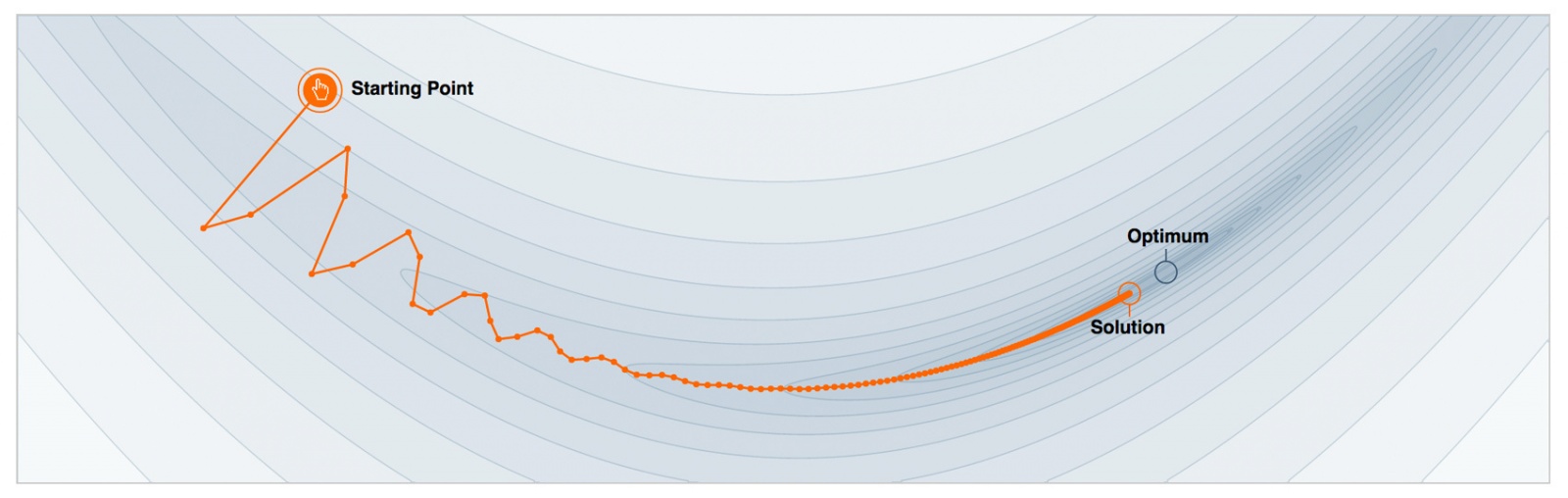

Дело за малым — осталось только взять подходящий итеративный алгоритм, которым мы будем минимизировать

- Инициализировать начальное приближение параметров

- Для каждой итерации

повторять:

- Посчитать градиент функции потерь

при текущем приближении

- Задать текущее итеративное приближение

на основе посчитанного градиента

- Обновить приближение параметров

:

- Посчитать градиент функции потерь

- Сохранить итоговое приближение

- Пользоваться найденной функцией

по назначению

Функциональный градиентный спуск

Расширим сознание: представим на секунду, что мы можем проводить оптимизацию в функциональном пространстве и итеративно искать приближения

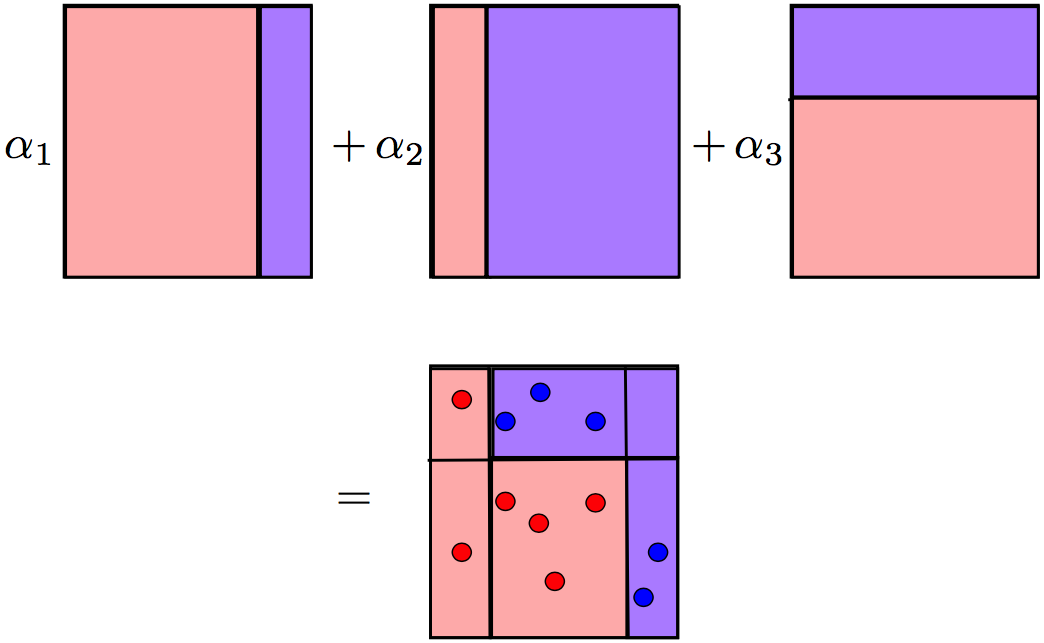

Магии пока не случилось, мы просто решили, что будем искать наше приближение

Чтобы решить задачу, нам все равно придется ограничить свой поиск каким-то семейством функций

А вот теперь время магии. Мы выписывали все наши задачи в общем виде, словно мы можем просто так брать и обучать какие угодно модели

Зная выражение градиента функции потерь, мы можем посчитать его значения на наших данных. Так давайте обучать модели так, чтобы наши предсказания были наиболее скоррелированными с этим градиентом (со знаком минус). То есть будем решать задачу МНК-регрессии, пытаясь выправлять предсказания по этим остаткам. И для классификации, и для регрессии, и для ранжирования под капотом мы все время будем минимизировать квадрат разности между псевдо-остатками

Классический GBM алгоритм Friedman-а

Теперь у нас есть все необходимое, чтобы наконец выписать GBM алгоритм, предложенный Jerome Friedman в 1999 году. Мы все так же решаем общую задачу обучения с учителем. На вход алгоритма нужно собрать несколько составляющих:

- набор данных

;

- число итераций

;

- выбор функции потерь

с выписанным градиентом;

- выбор семейства функций базовых алгоритмов

, с процедурой их обучения;

- дополнительные гиперпараметры

, например, глубина дерева у деревьев решений;

Единственный момент, который остался без внимания — начальное приближение

- Инициализировать GBM константным значением

- Для каждой итерации

повторять:

- Посчитать псевдо-остатки

- Построить новый базовый алгоритм

как регрессию на псевдо-остатках

- Найти оптимальный коэффициент

при

относительно исходной функции потерь

- Сохранить

- Обновить текущее приближение

- Посчитать псевдо-остатки

- Скомпоновать итоговую GBM модель

- Покорять kaggle и мир обученной моделью (предсказания там делать, сами разберетесь)

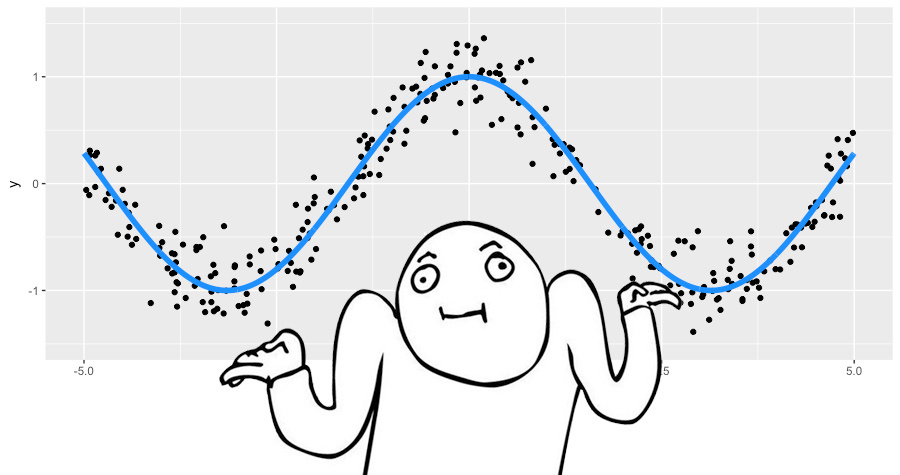

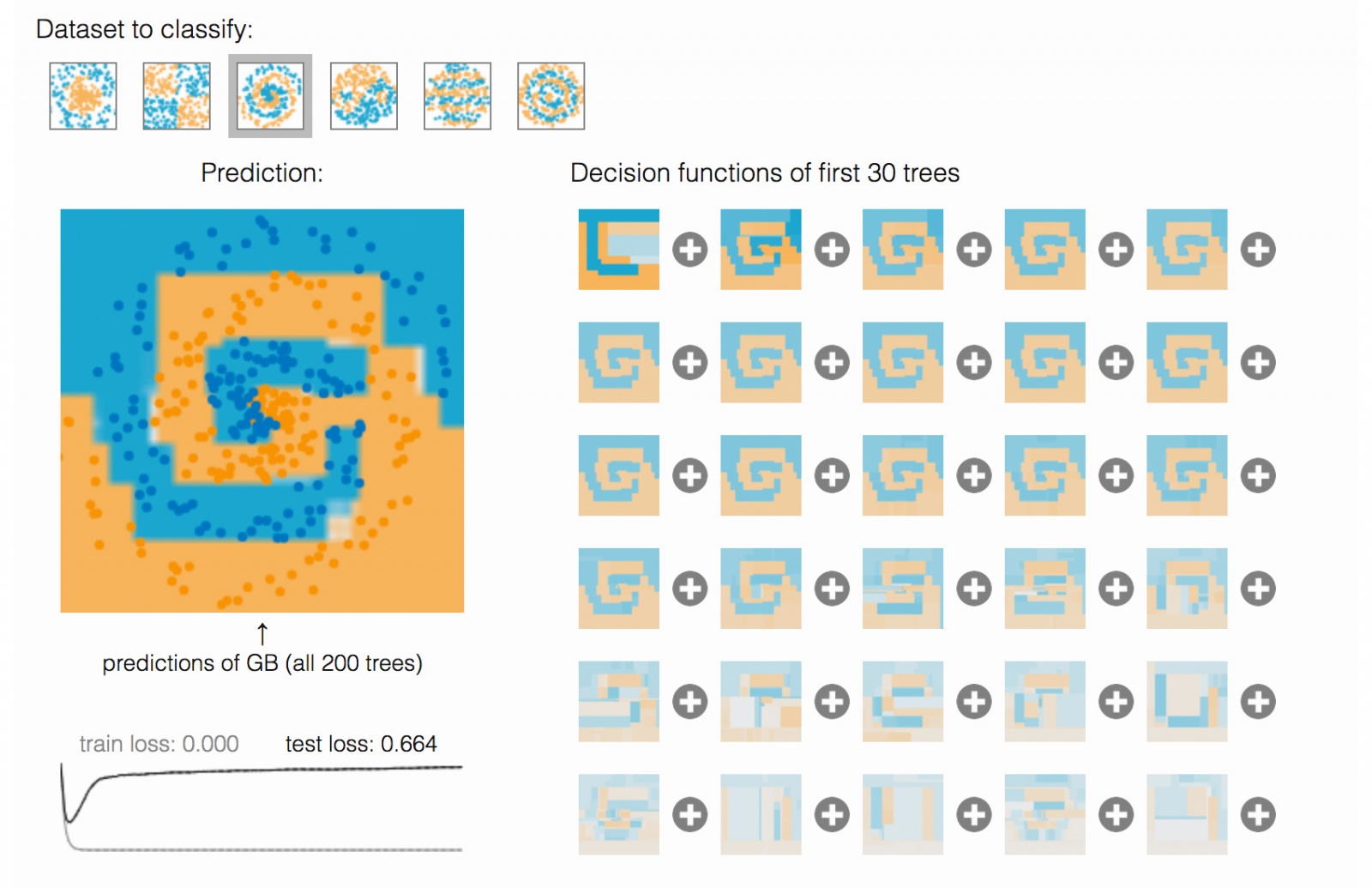

Пошаговый пример работы GBM

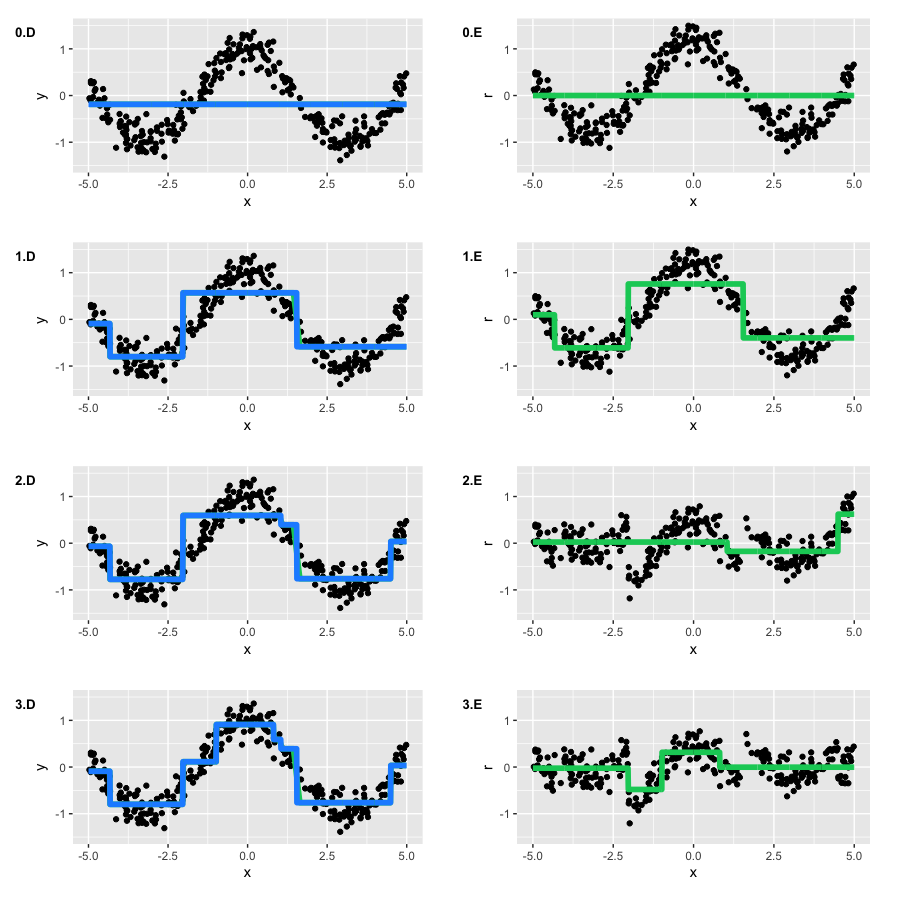

Попробуем на игрушечном примере разобраться, как работает GBM. Будем с его помощью восстанавливать зашумленную функцию ![Открытый курс машинного обучения. Тема 10. Градиентный бустинг. Часть 1 - 84 $large y=cos(x) + epsilon, epsilon sim mathcal{N}(0, frac{1}{5}), x in [-5,5]$](https://www.pvsm.ru/images/2017/05/18/otkrytyi-kurs-mashinnogo-obucheniya-tema-10-gradientnyi-busting-chast-1-84.svg)

Это задача регрессии на вещественную целевую переменную, поэтому воспользуемся средне-квадратичной функцией потерь. Самих пар наблюдений мы сгенерируем 300 штук, а приближать будем деревьями решений глубины 2. Соберем вместе все, что нам нужно для применения GBM:

- Игрушечные данные

✓

- Число итераций

✓;

- Среднеквадратичная функция потерь

✓

Градиентloss это просто остатки

✓;

- Деревья решений в качестве базовых алгоритмов

✓;

- Гиперпараметры деревьев решений: глубина деревьев равна 2 ✓;

У среднеквадратичной ошибки все просто и с инициализацией

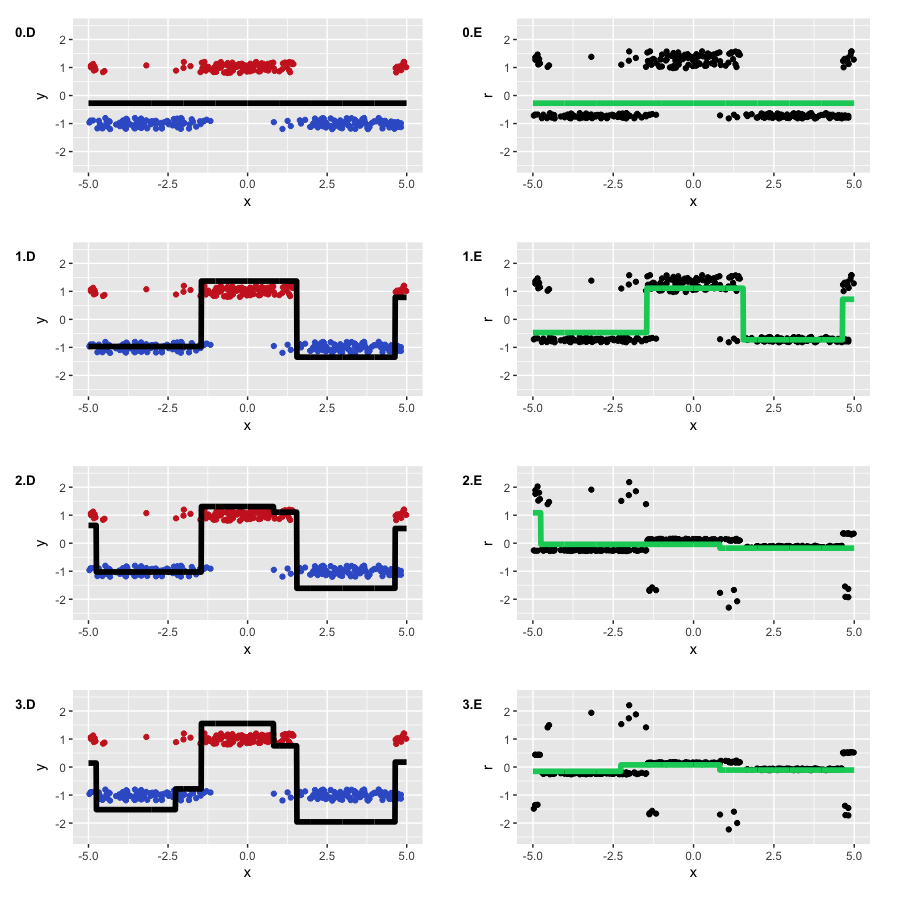

Запустим GBM и будем рисовать два типа графиков: актуальное приближение

Заметим, что ко второй итерации наши деревья повторили основную форму функции. Однако, на первой итерации мы видим, что алгоритм построил только "левую ветвь" функции (![Открытый курс машинного обучения. Тема 10. Градиентный бустинг. Часть 1 - 99 $large x in [-5, -4]$](https://www.pvsm.ru/images/2017/05/18/otkrytyi-kurs-mashinnogo-obucheniya-tema-10-gradientnyi-busting-chast-1-99.svg)

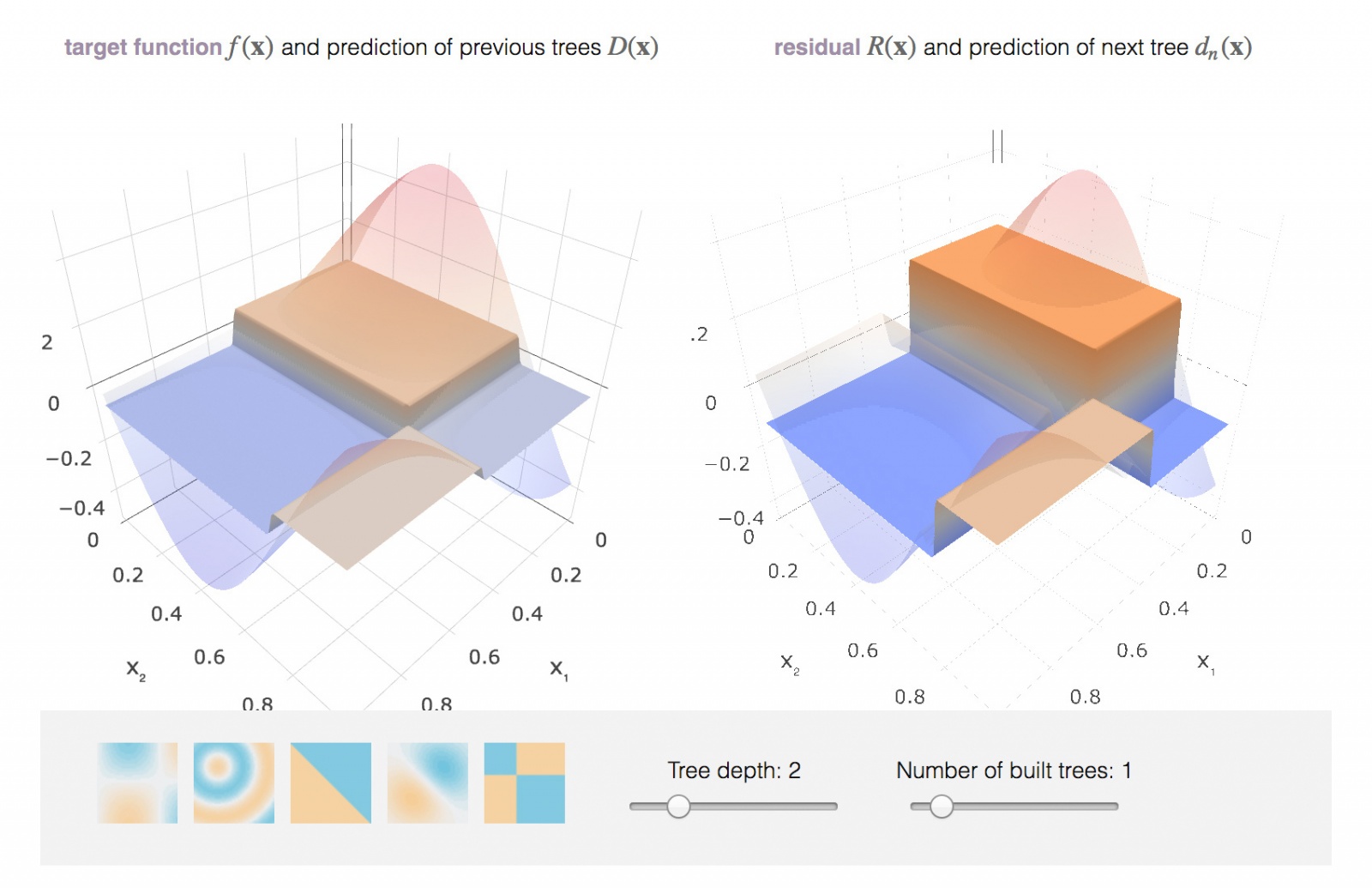

В остальном процесс прошел так как мы и ожидали: на каждом шаге наши псевдо-остатки уменьшались, а GBM все ближе приближал исходный косинус. Однако, деревья по построению не могут приблизить непрерывную функцию, поэтому на этом примере GBM полезен, но не идеален. Чтобы самим поиграться с тем, как GBM приближает функции, в блоге Brilliantly wrong есть офигенная интерактивная демка:

http://arogozhnikov.github.io/2016/06/24/gradient_boosting_explained.html

3. Функции потерь

Что делать, если мы хотим решать не обычную среднеквадратичную регрессию, а, скажем, задачу бинарной классификации? Нет проблем, надо только выбрать соответствующую задаче и целевой переменной

Как правило, самим нам ничего придумывать и выписывать не надо — исследователи уже все сделали за нас. Сегодня мы разберем функции потерь двух самых часто встречающихся задач: регрессии

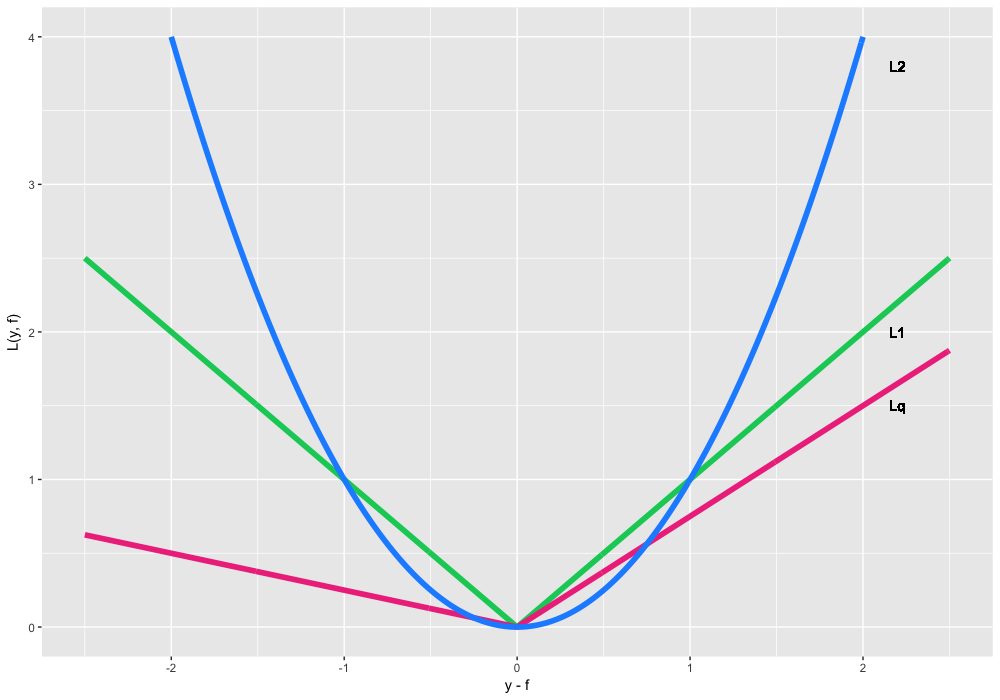

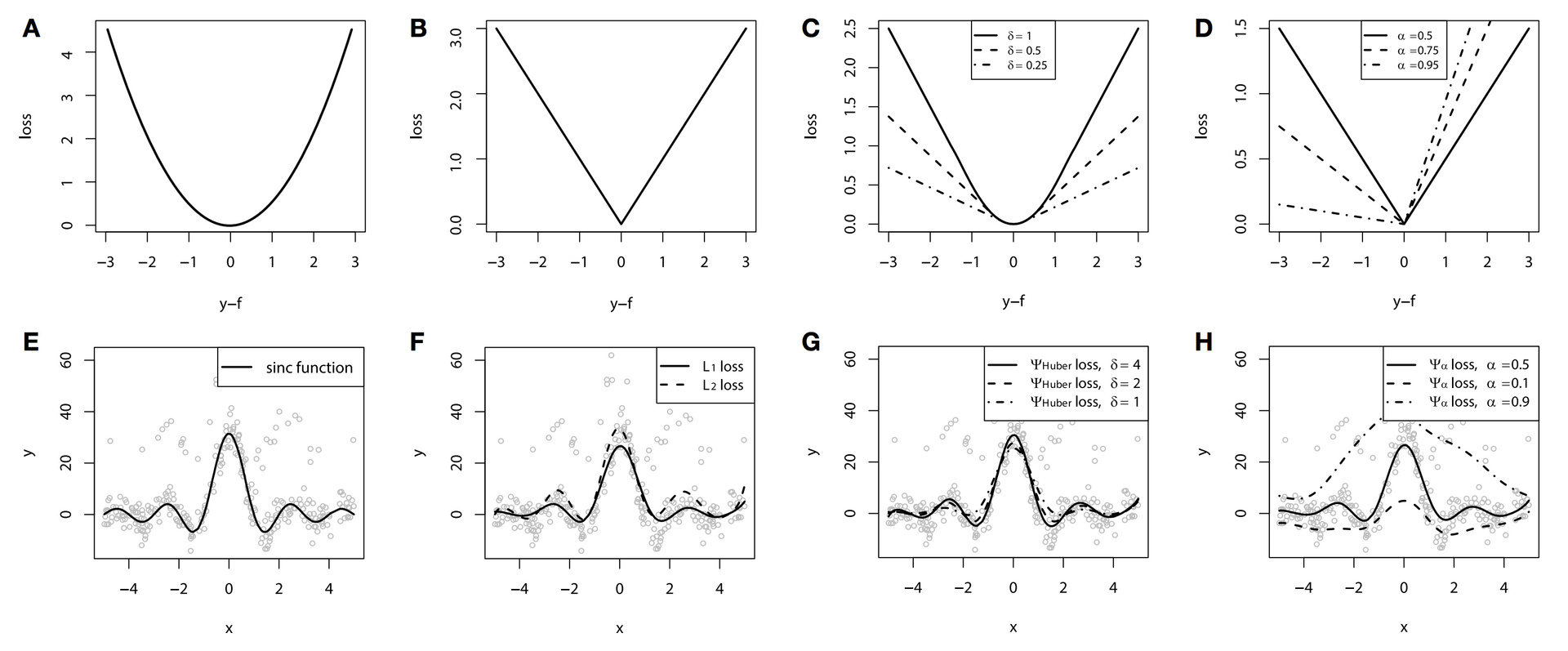

Функции потерь регрессии

Сначала разберемся с регрессией

, оно же

loss, оно же Gaussian loss. Это классическое условное среднее, самый частый и простой вариант. Если нет никакой дополнительной информации или требований к устойчивости (робастности) модели — используйте его.

, оно же

loss, оно же Laplacian loss. Эта, на первый взгляд, не очень дифференцируемая вещь, на самом деле определяет условную медиану. Медиана, как мы знаем, более устойчива к выбросам, поэтому в некоторых задачах эта функция потерь предпочтительнее, так как она не так сильно штрафует большие отклонения, нежели квадратичная функция.

- $inline$ large begin{equation} L(y, f) =left{ begin{array}{@{}ll@{}} (1 - alpha) cdot |y - f|, & text{if} |y-f| leq 0 \ alpha cdot |y - f|, & text{if} |y-f| >0 end{array}right. end{equation}, alpha in (0,1) $inline$, оно же

loss, оно же Quantile loss. Если бы мы, допустим, захотели не условную медиану с

, а условную 75%-квантиль, мы бы воспользовались этим вариантом с

. Можно видеть, что эта функция ассиметрична и больше штрафует наблюдения, оказывающиеся по нужную нам сторону квантили.

Давайте попробуем воспользоваться

- Игрушечные данные

✓

- Число итераций

✓;

- Квантильная функция потерь $inline$ large begin{equation} L_{0.75}(y, f) =left{ begin{array}{@{}ll@{}} 0.25 cdot |y - f|, & text{if} |y-f| leq 0 \ 0.75 cdot |y - f|, & text{if} |y-f| >0 end{array}right. end{equation} $inline$ ✓;

- Градиент

— индикаторная функция, взвешенная нашим

. Мы будем обучать деревья чему-то, очень похожему на классификатор:

✓;

- Деревья решений в качестве базовых алгоритмов

✓;

- Гиперпараметры деревьев решений: глубина деревьев равна 2 ✓;

У нас есть очевидное начальное приближение — просто взять нужную нам квантиль

Непривычно видеть, что по факту мы обучаем что-то очень непохожее на обычные остатки — на каждой итерации

Если оставить алгоритм обучаться на этом игрушечном примере, мы получим почти такой же результат, что и с квадратичной функцией потерь, смещенный на

Для задачи регрессии разработано достаточно много функций потерь, в том числе с дополнительными свойствами робастности. Один такой пример — функция потерь Губера, она же Huber loss. Суть функции в том, что на небольших отклонениях она работает как

Можно посмотреть, как работает эта функция потерь на следующем игрушечном примере. За основу возьмем игрушечные данные функции

И в крупном разрешении.

В этом примере в качестве базовых алгоритмов для визуальной наглядности были использованы сплайны. Мы ведь уже говорили, что бустить можно не только деревья? О том, какие базовые алгоритмы чаще используются в бустинге и какие у них свойства, мы расскажем в следующей статье про GBM (часть 2). Мы все равно находимся в бонусной секции курса, куда заглянут только самые стойкие, так что легкие спойлеры позволительны.

По результатам примера, из-за искусственно созданной проблемы с шумом разница между

К сожалению, функция Huber loss реализована не во всех современных библиотеках (в h2o реализована, в xgboost еще нет). Это же касается и других интересных функций потерь, включая и условные квантили, и такие экзотические вещи как условные экспектили. Но в целом, достаточно полезно знать о том, что такие варианты существуют и ими можно пользоваться.

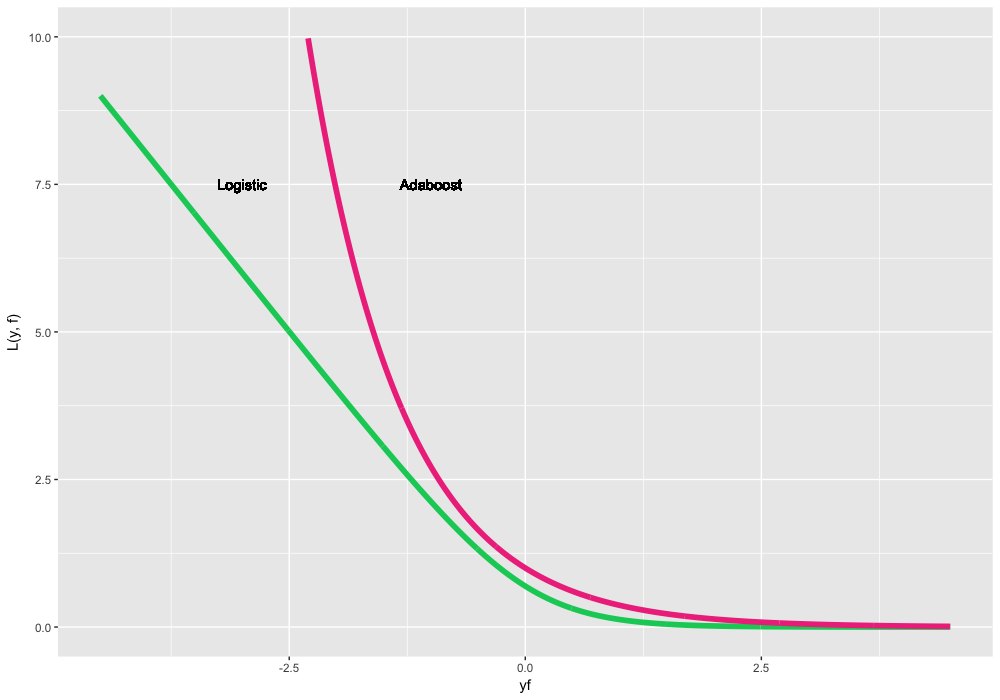

Функции потерь классификации

Теперь разберем бинарную классификацию, когда

Из-за принципиально другой природы распределения целевой переменной, будем предсказывать и оптимизировать не сами метки классов, а их log-правдоподобие. Для этого переформулируем функции потерь над перемноженными предсказаниями и истинными метками

, она же Logistic loss, она же Bernoulli loss. Интересное свойство заключается в том, что мы штрафуем даже корректно предсказанные метки классов. Нет, это не баг. Наоборот, оптимизируя эту функцию потерь, мы можем продолжать "раздвигать" классы и улучшать классификатор даже если все наблюдения предсказаны верно. Это самая стандартная и часто используемая функция потерь в бинарной классификации.

, оно же Adaboost loss. Так получилось, что классический Adaboost алгоритм эквивалентен GBM с этой функцией потерь. Концептуально эта функция потерь очень похожа на Logistic loss, но имеет более жесткий экспоненциальный штраф на ошибки классификации и используется реже.

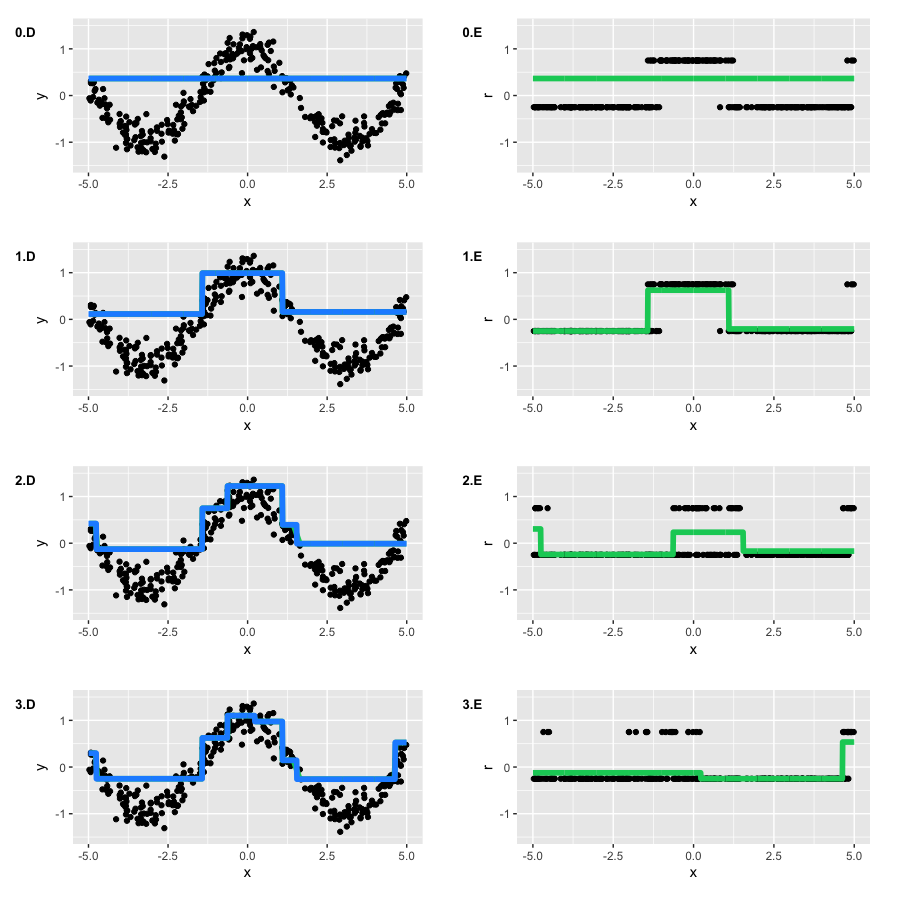

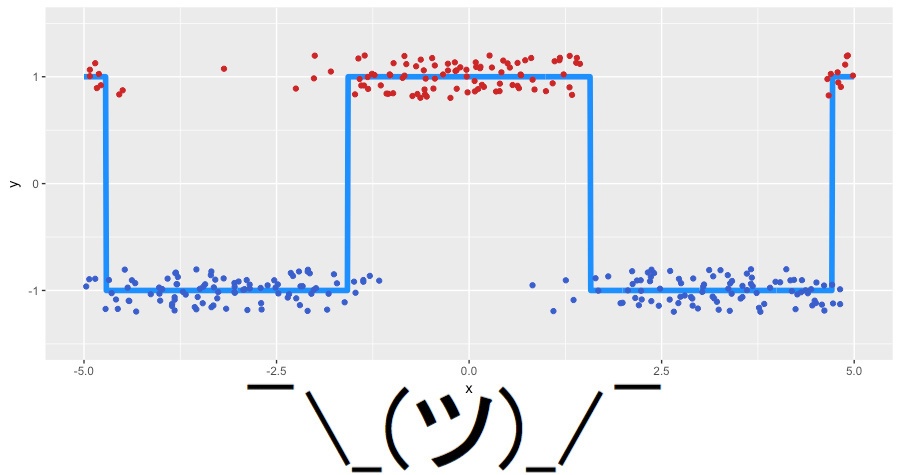

Сгенерируем новые игрушечные данные для задачи классификации. За основу возьмем наш зашумленный косинус, а в качестве классов целевой переменной будем использовать функцию sign. Новые данные выглядят следующим образом (jitter-шум добавлен для наглядности):

Воспользуемся Logistic loss, чтобы посмотреть, что же мы на самом деле бустим. Как и прежде, соберем воедино то, что будем решать:

- Игрушечные данные

✓

- Число итераций

✓;

- В качестве функции потерь — Logistic loss, ее градиент считается так:

✓;

- Деревья решений в качестве базовых алгоритмов

✓;

- Гиперпараметры деревьев решений: глубина деревьев равна 2 ✓;

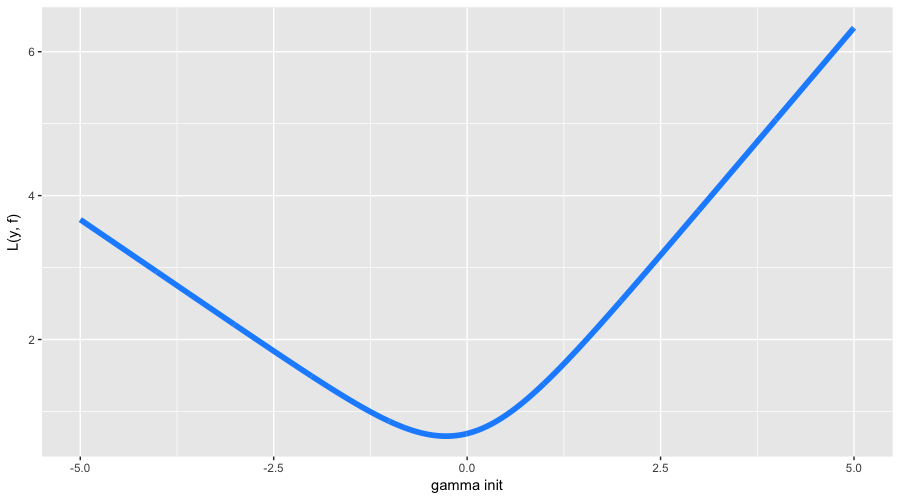

В этот раз с инициализацией алгоритма все немного сложнее. Во-первых, наши классы несбалансированы и разделены в пропорции примерно 63% на 37%. Во-вторых, аналитической формулы для инициализации для нашей функции потерь неизвестно. Так что будем искать

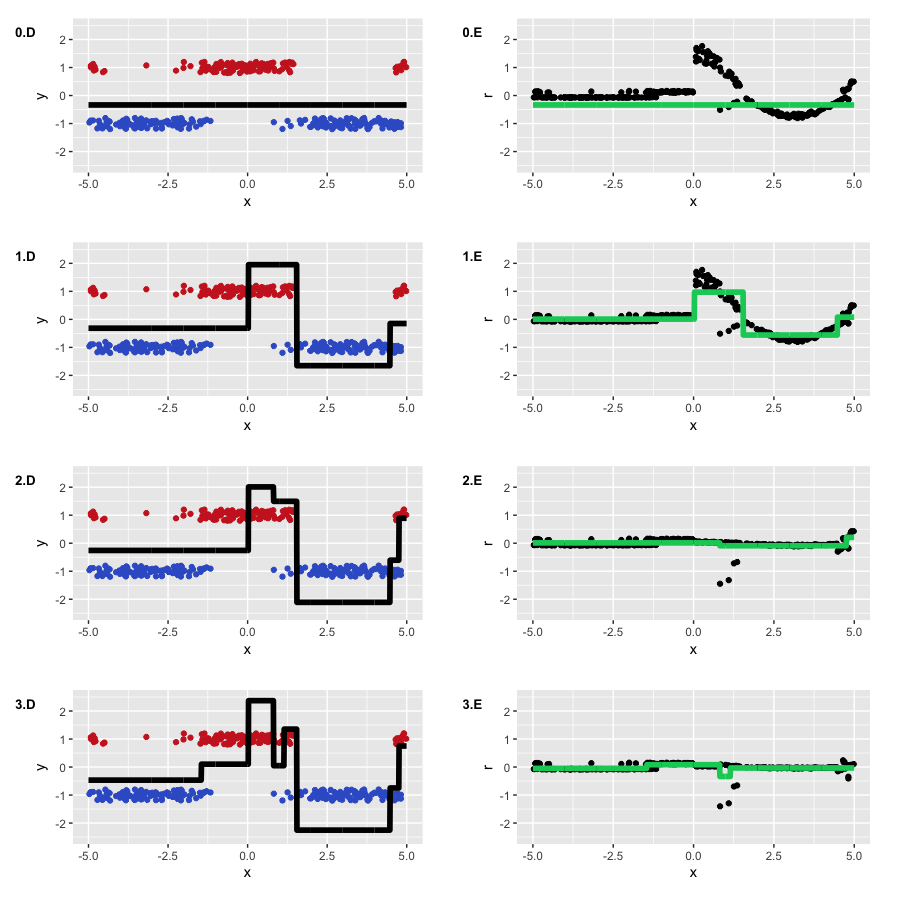

Оптимальное начальное приближение нашлось в районе -0.273. Можно было догадаться, что оно будет отрицательным (нам выгоднее предсказывать всех наиболее популярным классом), но формулы точного значения, как мы уже сказали, нет. А теперь давайте наконец уже запустим GBM и посмотрим, что же на самом деле происходит под его капотом:

Алгоритм отработал успешно, восстановив разделение наших классов. Можно видеть, как отделяются "нижние" области, в которых деревья больше уверены в корректном предсказании отрицательного класса, и как формируются две ступеньки, где классы были перемешаны. На псевдо-остатках видно, что у нас есть достаточно много корректно классифицированных наблюдений, и какое-то количество наблюдений с большими ошибками, которые появились из-за шума в данных. Как-то выглядит то, что на самом деле предсказывает GBM в задаче классификации (регрессия на псевдо-остатках логистической функции потерь).

Веса

Иногда возникает ситуация, когда для задачи хочется придумать более специфичную функцию потерь. Например, в предсказании финансовых рядов мы можем захотеть придавать больший вес крупным движениям временного ряда, а в задаче предсказания клиентского оттока — лучше предсказывать отток у клиентов с высоким LTV (lifetime value, сколько денег клиент нам принесет в будущем).

Истинный путь статистического воина — придумать свою функцию потерь, выписать для нее производную (а для более эффективного обучения, еще и Гессиан), и тщательно проверить, удовлетворяет ли эта функция требуемым свойствам. Однако, высока вероятность где-то ошибиться, столкнуться с вычислительными трудностями, да и в целом потратить непозволительно много времени на исследования.

Вместо этого был придуман очень простой инструмент, о котором редко вспоминают на практике — взвешивание наблюдений и задание весовых функций. Простейший пример такого взвешивания — задание весов для балансировки классов. В общем случае, если мы знаем, что какое-то подмножество данных, как во входных переменных

Веса позволяют существенно сократить время на подстройку самой функции потерь под решаемую задачу, а также поощряют эксперименты с целевыми свойствами моделей. Как именно задавать эти веса — исключительно наша творческая задача. С точки зрения GBM алгоритма и оптимизации, мы просто добавляем скалярные веса, закрывая глаза на их природу:

Понятно, что для произвольных весов мы не знаем никаких красивых статистических свойств нашей модели. В общем случае, привязывая веса к значениям

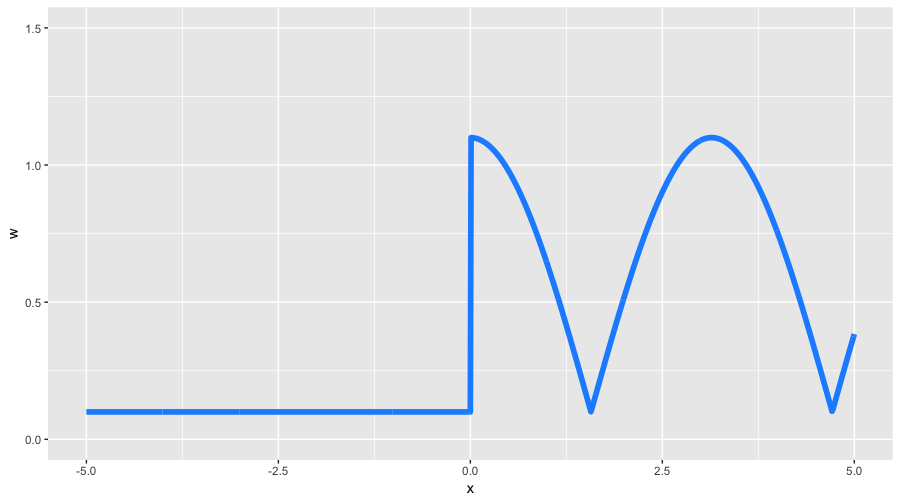

Мы обсуждаем все это, чтобы лучше понимать наши возможности. Давайте придумаем какой-нибудь очень экзотический пример весов на наших игрушечных данных. Зададим сильно асимметричную весовую функцию следующим образом:

$$display$$ large begin{equation} w(x) =left{ begin{array}{@{}ll@{}} 0.1, & text{if} x leq 0 \ 0.1 + |cos(x)|, & text{if} x >0 end{array}right. end{equation} $$display$$

С помощью таких весов мы ожидаем увидеть два свойства: меньшую детализацию на отрицательных значениях

Результат получился, какой мы и ожидали. Во-первых, видно, насколько сильно у нас стали отличаться псевдо-остатки, на начальной итерации во многом повторяя наш исходный косинус. Во-вторых, левая часть графика функции была во многом проигнорирована в пользу правой, имевшей большие веса. В-третьих, полученная нами функция на третьей итерации получила достаточно много деталей, став больше похожей на исходный косинус (а также, начав легкую переподгонку).

Веса — это мощный инструмент, который, на наш страх и риск, позволяет существенно управлять свойствами нашей модели. Если вы хотите оптимизировать свою функцию потерь, стоит сначала попробовать решить более простую задачу, но добавив в нее веса наблюдений по своему усмотрению.

4. Итог про теорию GBM

Сегодня мы разобрали основную теорию про градиентный бустинг. GBM — это не просто какой-то конкретный алгоритм, а общая методология, как строить ансамбли моделей. Причем методология достаточно гибкая и расширяемая: можно обучать большое количество моделей с учетом различных функций потерь и при этом еще и навешивать на них разного рода весовые функции.

Как показывает и практика, и опыт соревнований по машинному обучению, в стандартных задачах (все кроме картинок и аудио, а также сильно разреженных данных), GBM очень часто является самым эффективным алгоритмом (не считая stacking-а и верхнеуровневых ансамблей, где GBM почти всегда является неотъемлемой их частью). При этом существуют адаптации GBM под Reinforcement Learning (Minecraft, ICML 2016), а алгоритм Виола-Джонса, до сих пор используемый в компьютерном зрении, основан на Adaboost.

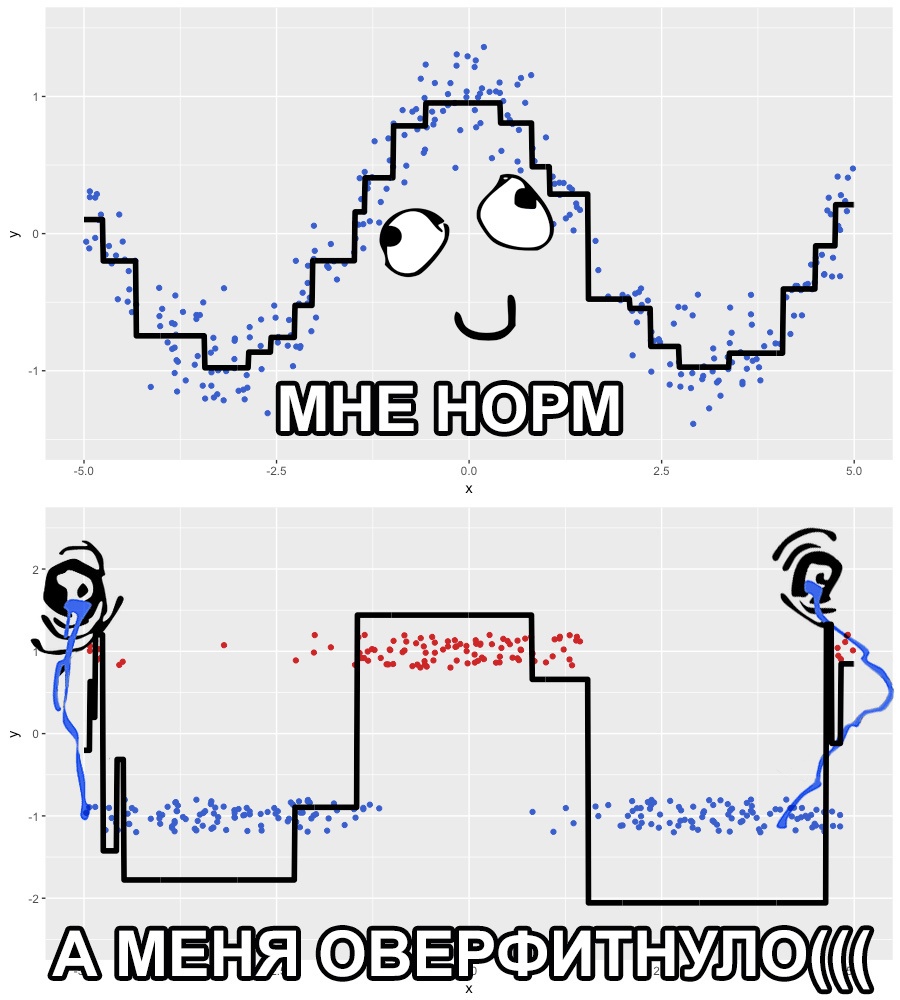

В этой статье мы специально опустили вопросы, связанные с регуляризацией GBM, стохастичностью, а также связанными с ними гиперпараметрами алгоритма. Неспроста мы везде выбирали маленькое число итераций алгоритма,

О том, что делать в подобных ситуациях, и как взаимосвязаны друг с другом параметры регуляризации GBM, а также гиперпараметры базовых алгоритмов, мы расскажем в следующей статье. В ней же мы разберем современные пакеты — xgboost, lightgbm и h2o, а также попрактикуемся в их правильной настройке. А пока мы предлагаем вам поиграться с настройками GBM в еще одной очень крутой интерактивной демке Brliiantly wrong:

http://arogozhnikov.github.io/2016/07/05/gradient_boosting_playground.html

5. Домашнее задание №10

Сегодня мы разбирались с теорией GBM и функциями потерь. Так как мы еще не рассказали про GBM на практике и реальных задачах, задание будет привязано только к пройденной теории.

Вам необходимо самостоятельно реализовать GBM алгоритм, пользуясь готовыми функциями для построения деревьев. Также необходимо реализовать обучение GBM для RMSLE и RMSPE метрик, самостоятельно выписав соответствующие им функции потерь (и их градиенты).

Ссылки на домашнее задание будут выданы комментарием к этой статье в течение суток с момента публикации.

6. Полезные ссылки

- Оригинальная статья про GBM от Jerome Friedman

- Глава в Elements of Statistical Learning от Hastie, Tibshirani, Friedman (стр. 337)

- Wiki статья про Gradient Boosting

- Frontiers tutorial статья про GBM (лайтовый самопиар)

- Видео-лекция Hastie про GBM на h2o.ai конференции

- Видео-лекция Владимира Гулина про композиции алгоритмов от Техносферы

- Видео-лекции Константина Воронцова (часть 1, часть 2) про композиции алгоритмов от Школы Анализа Данных

Особая благодарность yorko (Юрию Кашницкому) за ценные комментарии, а также bauchgefuehl (Анастасии Манохиной) за помощь с редактированием.

Автор: Open Data Science

![Открытый курс машинного обучения. Тема 10. Градиентный бустинг. Часть 1 - 19 $large hat{f}(x)=underset{f(x)}{argmin} mathbb {E} _{x,y}[L(y,f(x))]$](https://www.pvsm.ru/images/2017/05/18/otkrytyi-kurs-mashinnogo-obucheniya-tema-10-gradientnyi-busting-chast-1-19.svg)

![Открытый курс машинного обучения. Тема 10. Градиентный бустинг. Часть 1 - 22 $large hat{f}(x)=f(x, hat{theta}), \ large hat{theta}=underset{theta}{argmin} mathbb {E} _{x,y}[L(y,f(x,theta))]$](https://www.pvsm.ru/images/2017/05/18/otkrytyi-kurs-mashinnogo-obucheniya-tema-10-gradientnyi-busting-chast-1-22.svg)

![Открытый курс машинного обучения. Тема 10. Градиентный бустинг. Часть 1 - 38 $large L_{theta}(hat{theta})=left[frac{partial L(y, f(x, theta))}{partial theta}right]_{theta=hat{theta}}$](https://www.pvsm.ru/images/2017/05/18/otkrytyi-kurs-mashinnogo-obucheniya-tema-10-gradientnyi-busting-chast-1-38.svg)

![Открытый курс машинного обучения. Тема 10. Градиентный бустинг. Часть 1 - 54 $large hat{f}(x)=sum_{i=0}^{t-1} hat{f_i}(x), \ large (rho_t,theta_t)=underset{rho,theta}{argmin} mathbb {E} _{x,y}[L(y,hat{f}(x) + rho cdot h(x, theta))], \ large hat{f_t}(x)=rho_t cdot h(x, theta_t)$](https://www.pvsm.ru/images/2017/05/18/otkrytyi-kurs-mashinnogo-obucheniya-tema-10-gradientnyi-busting-chast-1-54.svg)

![Открытый курс машинного обучения. Тема 10. Градиентный бустинг. Часть 1 - 59 $ large hat{f}(x)=sum_{i=0}^{t-1} hat{f_i}(x), \ large r_{it}=-left[frac{partial L(y_i, f(x_i))}{partial f(x_i)}right]_{f(x)=hat{f}(x)}, quad mbox{for } i=1,ldots,n ,\ large theta_t=underset{theta}{argmin} sum_{i=1}^{n} (r_{it} - h(x_i, theta))^2, \ large rho_t=underset{rho}{argmin} sum_{i=1}^{n} L(y_i, hat{f}(x_i) + rho cdot h(x_i, theta_t))$](https://www.pvsm.ru/images/2017/05/18/otkrytyi-kurs-mashinnogo-obucheniya-tema-10-gradientnyi-busting-chast-1-59.svg)

![Открытый курс машинного обучения. Тема 10. Градиентный бустинг. Часть 1 - 73 $large r_{it}=-left[frac{partial L(y_i, f(x_i))}{partial f(x_i)}right]_{f(x)=hat{f}(x)}, quad mbox{for } i=1,ldots,n$](https://www.pvsm.ru/images/2017/05/18/otkrytyi-kurs-mashinnogo-obucheniya-tema-10-gradientnyi-busting-chast-1-73.svg)

![Открытый курс машинного обучения. Тема 10. Градиентный бустинг. Часть 1 - 120 $large r_{i}=-left[frac{partial L(y_i, f(x_i))}{partial f(x_i)}right]_{f(x)=hat{f}(x)}=$](https://www.pvsm.ru/images/2017/05/18/otkrytyi-kurs-mashinnogo-obucheniya-tema-10-gradientnyi-busting-chast-1-120.svg)

![Открытый курс машинного обучения. Тема 10. Градиентный бустинг. Часть 1 - 153 $ large L_{w}(y,f)=w cdot L(y,f), \ large r_{it}=- w_i cdot left[frac{partial L(y_i, f(x_i))}{partial f(x_i)}right]_{f(x)=hat{f}(x)}, quad mbox{for } i=1,ldots,n$](https://www.pvsm.ru/images/2017/05/18/otkrytyi-kurs-mashinnogo-obucheniya-tema-10-gradientnyi-busting-chast-1-153.svg)