LLM будут врать вечно

Сможем ли мы когда-нибудь доверять искусственному интеллекту?

Несмотря на впечатляющий прогресс языковых моделей, они по-прежнему страдают от серьезной «болезни» — так называемых галлюцинаций, когда ИИ выдает ложную или бессмысленную информацию. В одном из недавних исследований выдвигается предположение, что lданная проблема — не временный сбой, а фундаментальная особенность работы нейросетей. Если это действительно так, нам придется пересмотреть подход к ИИ.

Обзор исследования

Статья под говорящим названием «Большие языковые модели всегда будут галлюцинировать, и нам придется жить с этим» [1] выдвигает смелый тезис: галлюцинации в ИИ неизбежны из-за самого принципа устройства этих систем. Авторы утверждают, что независимо от того, насколько мы усовершенствуем ИИ — будь то улучшение архитектуры, увеличение объема данных или более умная проверка фактов — определенный уровень галлюцинаций всегда будет присутствовать.

Их аргументация основана на математической теории. Используя концепции из теории вычислений и теоремы Гёделя о неполноте, исследователи показывают, что некоторые ограничения непреодолимы.

Авторы выстраивают свою позицию через серию математических выкладок, каждая из которых демонстрирует неизбежность галлюцинаций в природе больших языковых моделей. В конце статьи обсуждаются практические и этические последствия этого факта.

Если они правы, нам придется пересмотреть свои цели в отношении ИИ-систем, — особенно в том, что касается достижения их полной надежности.

Простое объяснение

Работу больших языковых моделей можно сравнить с игрой, где вас просят описать картинку, но вы не видите ее целиком. В каких-то случаях вы сможете угадать, чего не хватает, но в других — ошибетесь, потому что у вас нет полного изображения, и в скрытых частях может оказаться что-то, чего вы предугадать ну никак не могли. Именно так работают галлюцинации ИИ: система заполняет пробелы, но не всегда делает это правильно.

Авторы статьи утверждают, что это не признак несовершенства технологии, а основополагающий принцип работы ИИ. Сколько бы мы ни дообучали эти системы, они никогда не смогут знать абсолютно все. И даже если бы у них был доступ ко всем данным мира, существуют фундаментальные математические ограничения, не позволяющие системам всегда безошибочно извлекать необходимую информацию.

Главный вывод заключается в том, что вместо попыток сделать ИИ безупречным, нам следует принять его недостатки и сосредоточиться на том, как управлять ими наиболее эффективно.

Техническое объяснение

Опираясь на математическую аргументацию, исследователи демонстрируют неминуемость галлюцинаций в LLM. Во-первых, они обосновывают это неполнотой информации, ссылаясь в том числе на теорему Гёделя и другие аналогичные утверждения, показывающие невозможность создания датасета, содержащего абсолютно все факты.

Во-вторых, они исследуют процесс извлечения информации, проводя параллели с известной проблемой в теории вычислений — проблемой допустимости [2], являющейся неразрешимой. Проще говоря, это значит, что от моделей ИИ нельзя ожидать 100% точности при извлечении информации. Аналогичный вывод они делают и в отношении интерпретации пользовательских запросов: идеальное понимание намерений юзера также недостижимо.

Наконец, они анализируют сам процесс генерации языка. Доказывая, что проблема остановки [3] (определение момента завершения процесса) непреодолима для LLM, они утверждают, что системы не способны предсказать результат их собственной генерации до ее завершения. Это открывает путь для возникновения галлюцинаций.

В статье также показано, что никакая система проверки фактов не может исправить все галлюцинации. Даже идеальный фактчекер не способен преодолеть фундаментальные вычислительные ограничения, лежащие в основе этой проблемы.

Критическая оценка

Хотя статья предоставляет довольно убедительные математические доказательства, некоторые моменты требуют дальнейшего изучения.

Во-первых, авторы работы широко трактуют само понятие «галлюцинации». Создается впечатление, что клеймо «галлюцинация» ставится на любое отклонение от идеального знания, но на практике многие ИИ-системы эффективно решают поставленные задачи даже при наличии небольших погрешностей. Для многих вариантов практического применения хватает «удовлетворительного» результата, несмотря на периодические неточности.

Во-вторых, статья рассматривает только детерминированные исходы, тогда как современные ИИ-системы работают на основе вероятностных моделей. Это может означать, что выводы о неразрешимости не полностью применимы. Даже если идеальное поведение недостижимо, можно снизить уровень галлюцинаций до приемлемого минимума.

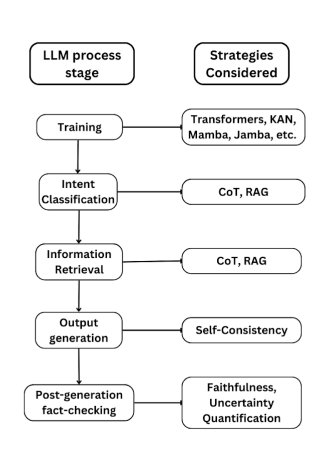

Статья также выиграла бы от бóльшего количества эмпирических доказательств и проверки этих идей на реальных ИИ-моделях. Кроме того, исследование ограничивается анализом трансформерных архитектур, оставляя открытым вопрос о применимости выводов к другим архитектурам ИИ.

Наконец, в статье не рассматривается, как люди справляются с нехваткой информации и ошибками в собственном . Сравнение галлюцинаций ИИ с человеческими ошибками могло бы добавить ценную перспективу.

Заключение

Если выводы статьи верны, нам, возможно, придется пересмотреть подход к разработке и использованию ИИ-систем. Вместо погони за совершенством мы должны сосредоточиться на том, как контролировать и минимизировать эффект галлюцинаций. Важно также объяснять пользователям реальные возможности ИИ и разрабатывать приложения, которые смогут эффективно работать даже при случайных ошибках.

Я считаю, что это исследование поднимает важные вопросы:

-

Как мы можем оценить и уменьшить реальное влияние галлюцинаций?

-

Существуют ли новые архитектуры ИИ, которые могли бы избежать некоторых из этих проблем?

-

Как должны измениться нормативные акты и этические стандарты, чтобы учесть тот факт, что у ИИ всегда будут изъяны?

А что думаете вы? Убедили ли вас приведенные доказательства? Как эти выводы повлияют на развитие языковых моделей и наше доверие к ним?

Автор: full_moon

Источник [5]

Сайт-источник PVSM.RU: https://www.pvsm.ru

Путь до страницы источника: https://www.pvsm.ru/iskusstvenny-j-intellekt/403366

Ссылки в тексте:

[1] «Большие языковые модели всегда будут галлюцинировать, и нам придется жить с этим»: https://arxiv.org/pdf/2409.05746

[2] проблемой допустимости: https://people.computing.clemson.edu/~goddard/handouts/cpsc3500/MATERIAL/14b9-11.pdf

[3] проблема остановки: https://ru.wikipedia.org/wiki/%D0%9F%D1%80%D0%BE%D0%B1%D0%BB%D0%B5%D0%BC%D0%B0_%D0%BE%D1%81%D1%82%D0%B0%D0%BD%D0%BE%D0%B2%D0%BA%D0%B8

[4] мышлении: http://www.braintools.ru

[5] Источник: https://habr.com/ru/companies/magnus-tech/articles/859768/?utm_campaign=859768&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.