Практика alignment: данные, RLHF и UX как конкурентное преимущество

Взгляд на самую большую проблему в мире ИИ, почему это важно для вас и почему это так ценно.

Согласованность — одна из самых важных тем в современной области машинного обучения (ML). Независимо от того, являетесь ли вы пользователем продуктов ML, человеком, который их разрабатывает, или компанией, решающей с их помощью задачи, вам стоит знать и хорошо понимать, что такое согласованность. В области искусственного интеллекта (ИИ) согласованность определяет:

-

Конфиденциальность: обеспечение ответственного использования пользовательских данных.

-

Безопасность: защита пользователей и систем от эксплуатации.

-

Исследования и разработки: улучшение производительности моделей.

-

Качество продукта: предоставление оптимального (и задуманного) пользовательского опыта.

Проще говоря: согласованность гарантирует, что системы ИИ достигают желаемых результатов и соответствуют человеческим ценностям, целям и этическим принципам. Это означает, что выходные данные систем машинного обучения не только соответствуют намерениям их создателей, но и делают эти системы безопасными и надёжными для пользователей.

Стохастическая природа и непредсказуемость результатов работы моделей делают эту задачу гораздо сложнее, чем кажется. Однако для полного использования потенциала ML в широком спектре реальных приложений согласование ИИ с человеческими потребностями абсолютно необходимо. Согласованность — отличный пример сложной проблемы машинного обучения, которую необходимо решить (как инженер по ML, я это обожаю), и при этом существует огромный финансовый стимул для её решения (как отец пятерых детей, я также обожаю и это).

Давайте разберёмся, что такое согласованность и почему она важна для вас.

Почему согласование моделей настолько сложно

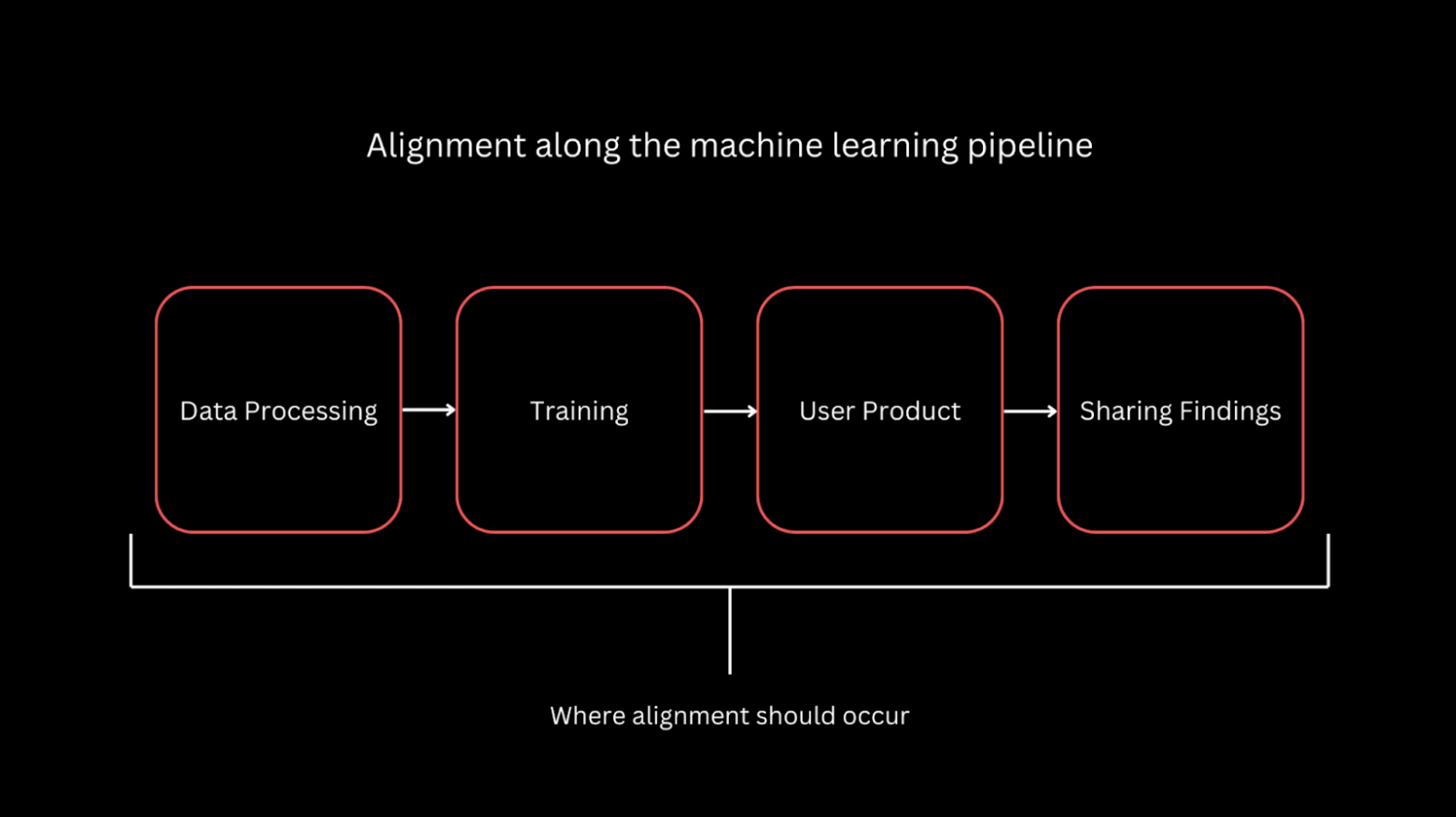

Я читал немало материалов, где согласование (alignment) рассматривается как этап в самом конце обучения — во время fine-tuning модели. На практике согласование должно пронизывать весь ML-пайплайн. На выход модели влияет множество факторов, и каждый из них нужно корректно согласовывать.

Все крупные игроки в мире LLM работают над согласованием своих моделей, но идеально этого не делает никто: процесс субъективный и выполняется поверх непредсказуемого алгоритма. Согласование зависит от целевого поведения системы ИИ, от человеческих ценностей, релевантных её применению, и от того, какой метод согласования под эти цели выбирают создатели системы.

Обсуждая согласование, держите в голове, почему это огромное и сложное пространство задач:

-

Оно будет постоянно меняться. Универсальных решений не существует: по мере изменения человеческих ценностей и областей применения ML будут меняться и корректные методы согласования.

-

О согласовании нужно думать на всём протяжении обучения. На поведение модели влияет множество факторов, и каждый из них сказывается на качестве итогового согласования.

Почему пользователям стоит заботиться о согласовании

Согласование (alignment) напрямую влияет и на эффективность, и на безопасность AI-продуктов. Значительная доля ML-моделей использует пользовательские данные, и хорошо согласованные модели обязаны ставить ответственное обращение с данными в приоритет. Это значит, что данные применяются исключительно в интересах того пользователя, который их предоставил, и остаются недоступными для остальных. Как пользователь, вы должны понимать, как согласован ML-продукт, которым вы пользуетесь, — чтобы знать, не используются ли ваши данные во вред вам.

Недавние приватностные вопросы вокруг ChatGPT вызвали дискуссию об этом в X. Изначально не было явно понятно, что диалоги с ChatGPT могут использоваться для дальнейшего обучения GPT-моделей (скорее всего, это было где-то в ToS). Многие применяли ChatGPT для личных целей и затем обнаружили, что их личные разговоры пошли в обучение GPT. Это особенно обеспокоило компании, доверявшие OpenAI данные своих пользователей при работе с GPT-4. К счастью, данные, отправленные через OpenAI API, никогда не используются для обучения.

Деванш [1] в статье Extract Training Data from ChatGPT [2] объясняет, почему для потребителя критично, что его данные могут использоваться для обучения модели. Он ссылается на работу Google DeepMind, показывающую, что извлекать обучающие данные из ChatGPT на удивление легко [3]. Это означает, что всё, что пользователи отдавали ChatGPT, потенциально может быть сгенерировано для любого другого пользователя ChatGPT. Для потребителей согласование суперважно: корректно согласованные модели защищают пользовательские данные.

Справедливости ради, ChatGPT — не единственная модель, способная «воспроизводить» запомненные обучающие данные. Просто ChatGPT — самый массовый LLM, особенно среди нетехнических пользователей, которые могут не понимать, как именно используются их данные.

Согласование важно и для корректного поведения продукта. Совсем недавно я столкнулся с тем, что Gemini (когда он ещё был Bard) перегибал палку в сторону «сверхзащиты приватности» — до такой степени, что это мешало базовой функциональности. Главная ценность Gemini для меня — умение интегрироваться со всеми моими документами и письмами, хранящимися в Google Drive. ChatGPT так не умеет. Но, как выясняется, иногда и Bard — тоже.

На скриншоте выше видно, как Bard сообщает, что не может получить доступ к письмам в папке с рассылками, одновременно показывая письмо из этой же папки. Непосредственно перед этим скриншотом Bard без проблем подтягивал эти письма и делал для меня краткие выжимки. Похоже, существует некая «жёсткая отсечка» на доступ к пользовательским данным, призванная предотвратить непреднамеренный доступ, но на деле ломающая ключевую функциональность продукта. Корректно согласованные модели должны уметь предотвращать проблемы приватности и при этом сохранять работоспособность продукта.

Кроме того, согласование — центральный механизм снижения рисков генерации ИИ. Хотя это частично связано с поддержанием функциональности, галлюцинации и нарушение авторских прав заслуживают отдельного внимания ввиду своей новизны.

Галлюцинации сложно контролировать, и последствия могут быть серьёзными. Я какое-то время использовал ChatGPT для планирования питания, пока один из читателей (спасибо, Sarah!) не указал, что он может рекомендовать небезопасные практики приготовления. Как неопытный повар, я бы сам этого не заметил.

Midjourney и другие ИИ для генерации изображений в последнее время оказались под огнём критики из-за вопросов авторского права. Возникают любопытные юридические вопросы, например:

-

Допустимо ли, чтобы генеративная модель по промпту «создай изображение быстрого супергероя» выдала картинку с The Flash (Флэш)?

-

Если да, может ли автор промпта свободно использовать эти изображения, или на них распространяется авторское право?

Я не претендую на глубокое знание авторского права, но эти вопросы кажутся мне интересными, потому что я бы их не предвидел. Это ещё один челлендж для корректного согласования модели.

Важность согласования для компаний и специалистов

Компаниям, которые выпускают AI-продукты, нужно гарантировать корректную работу для конечных пользователей. Инженерам, занимающимся ML внутри этих компаний, придётся разбираться в согласовании (alignment) независимо от их роли на жизненном цикле модели. Это сложная задача, требующая коммуникации между командами. Как уже отмечалось, у согласования вряд ли будет «сделал и забыл»-решение: по мере доработки и масштабирования моделей вопрос корректного согласования будет всплывать снова.

Хотя бесчисленные продукты на ML дают ценность, конкурентное преимущество получат те организации, которые лучше других согласуют их с потребностями и ценностями пользователей. Показательный пример — массовое использование Perplexity [4] как LLM для поиска. Perplexity быстро вырос в доминирующего игрока (а возможно, и лидера) в нише поисковых LLM, потому что он чётко выполняет основную задачу: даёт фактические ответы и минимизирует галлюцинации. По сравнению с более крупными и «общего назначения» LLM, его выход кажется мне гораздо лучше согласованным под этот кейс.

Согласование настолько важно для бизнеса, что породило целую волну компаний, предлагающих «Alignment-as-a-Service» — услуги по решению задач согласования для других компаний. Хороший пример — Scale AI. За дополнительными инсайтами по теме Alignment-as-a-Service рекомендую статью: Humans-in-the-loop vs synthetic data: за что идёт борьба на рынке AaaS [5]. Это очень толковый обзор рынка Alignment-as-a-Service и того, какую ценность он приносит клиентам.

Стратегии согласования моделей

Теперь, когда понятно, зачем нужно согласование, — как его делать? Ниже — методы, которые используют крупные компании для согласования своих моделей.

Данные

Значимость данных при обучении ML-моделей невозможно переоценить. В контексте согласования Деванш сформулировал простой, но на 100% рабочий принцип (в статье, на которую я ссылался выше): если вы не хотите, чтобы модель что-то генерировала, не включайте это в обучающие данные.

Понятно, что так выходит не всегда, но об этом стоит помнить на этапе data processing в ML-пайплайне. Считайте данные стартовой точкой согласования: разнообразные, полные и качественные данные влияют и на метрики модели, и на качество её согласования.

Обучение

Фокус согласования часто смещён на техники, применяемые во время обучения (часто — fine-tuning), чтобы имплементировать в модель человеческие ценности. Ключевые подходы:

-

Валидация согласования (Validating Alignment). Применяем методы детекции рассогласования и намеренно обучаем «рассогласованные» модели, чтобы убедиться, что эти методы действительно корректно выявляют проблемы.

-

Reinforcement Learning from Human Feedback (RLHF). Итеративно согласуем модель на основе человеческих оценок её ответов.

-

AI-assisted RLHF. Масштабируем RLHF, используя отдельные модели, которые предсказывают «ожидаемую» человеческую обратную связь для данного ответа (да, тут уже спорно, насколько это всё ещё «human feedback»).

Пользовательский опыт (UX)

Согласование можно делать и «по-старинке», средствами инженерии ПО — на уровне UX. LLM нужны контекст и инструкции взаимодействия. Например, в промпте для LLM явно задавать: «ты — полезный чат-бот». Я часто так делаю, когда собираю инструмент для саммаризации: всегда явно говорю модели, что она — суммаризатор, и описываю, каких саммари я жду. Это примеры согласования выхода модели на уровне UX.

Обмен находками

Возможно, самый недооценённый, но критически важный элемент — делиться результатами о техниках согласования. Сложные задачи обычно требуют усилий многих людей. Важно обсуждать решения с экспертами вне области ИИ: оптимальные практики согласования могут различаться в зависимости от домена применения.

Я убеждён, что важность (и эффект) корректного согласования моделей невозможно преувеличить. Воодушевляет, сколько проблемных зон тут можно закрыть.

Автор: kucev

Источник [6]

Сайт-источник PVSM.RU: https://www.pvsm.ru

Путь до страницы источника: https://www.pvsm.ru/soglasovannost/431370

Ссылки в тексте:

[1] Деванш: https://open.substack.com/users/8101724-devansh?utm_source=mentions

[2] Extract Training Data from ChatGPT: https://artificialintelligencemadesimple.substack.com/p/extracting-training-data-from-chatgpt

[3] извлекать обучающие данные из ChatGPT на удивление легко: https://arxiv.org/abs/2311.17035

[4] Perplexity: https://perplexity.ai/

[5] Humans-in-the-loop vs synthetic data: за что идёт борьба на рынке AaaS: https://habr.com/ru/articles/944768/

[6] Источник: https://habr.com/ru/articles/948412/?utm_campaign=948412&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.