О том, что за BigData помноженной на искусственный интеллект стоит невероятное будущее написано уже чуть ли не больше, чем собрание сочинений братьев Стругацких и Жуля Верна вместе взятых. Все они, и не совсем без основательно, утверждают, что собранные огромные массивы данных, обработанные с помощью, например, Deep Learning смогут уже сегодня выявить всех мошенников, предотвратить сомнительные сделки и предсказать самые высокодоходные рынки. Сама же по себе финансовая отрасль станет полностью автоматизированной под управлением мудрого искусственного интеллекта.

Наверное, так и будет до некоторой степени. Уже сегодня степень автоматизации достигла такого уровня, который еще 10 лет назад казался фантастикой. Все так… Но, как известно, «мелочи» могут привнести множество сюрпризов. Одной из таких мелочей является тот факт, что львиная доля всех данных, которые можно и нужно было бы использовать в задачах борьбы с мошенничеством, прогнозированием рынков представляют собой текстовые данные. Количество ежедневно порождаемых письменных, видео и других данных составляет миллиарды строк, анализ которых с помощью операторов практически бесполезен. Кто-то может, поспорить, что все не так и большинство данных представляют собой обычные таблицы, которые хорошо обрабатываются статистическими методами. И, казалось бы, он будет прав. Банки из TOP-30 рапортуют о широком использовании BigData. Но если присмотреться повнимательнее, то по утверждению того же Альфа-банка речь идет преимущественно о структурированных транзакционных данных.

Но даже в анализе структурированных данных мы увидим, что все эти горы цифр упираются в отдельные колонки, которые несут дополнительный смысл. В них лежат названия товаров, наименования организаций без указания каких-либо ИНН, фамилии и другие скажем так «неструктурированные данные».

Другим огромным пластом являются массивы данных с прайс-листами, объявлений о продаже квартир, автомобилей многого другого. И тут опять кто-то скажет: «но ведь практически везде есть товарные каталоги, есть ТН ВЭД, ОКВЭД-2 и многое другое». И вот в этом замечании уже кроется ответ на многие вопросы. Все эти справочники отраслевые, неполные, нет полных описаний и правил отнесения, да и фантазия человеческая границ порой не имеет. Что касается других областей, таких как массивы договоров, объявлений о найме на работу и постов в интернете, то справочников нет никаких вовсе.

Объединяющим все эти проблемы является признание того факта, что никакими статистическими методами, будь то даже нейронные сети, решить эту задачу без поисково-аналитических систем семантического и семиотического анализа попросту невозможно. В качестве простого примера можно привести задачу борьбы с мошенничеством в сфере ипотечного кредитования или выдачу автокредита на покупку подержанного авто. Набор данных которые хотелось бы получить, думаю, понятен каждому: Есть ли квартира или авто, под которые требуется выдать кредит в списках на продажу? А какова стоимость квадратного метра в этом же или соседнем доме, или цена аналогичного авто? А какова стоимость в пределах населенного пункта, а в пределах агломерации и т.д.?

Скачать данные с сайтов «как есть» на сегодняшний день не представляет собой технически сложной задачи. Получив такую базу имеем миллионы записей с неструктурированной информаций и базу категории BigData во всей своей полноте. Анализ же баз предложений на работу, дабы удостоверится в адекватности указанной в справке заработной платы или анализ надежности молодого поколения без анализа социальных сетей вообще представляет собой невыполнимую задачу.

В последнее время все больше разного рода государственных органов стали интересоваться темой семантического анализа данных. В качестве примера можно привести размещенный в мае 2017 года на сайте госзакупок электронный аукцион на разработку «аналитической подсистемы АИС ФНС», в составе которой есть подсистема семантического анализа текстов.

К сожалению, за победными реляциями почему-то скрывается полный пул проблем и упущенных возможностей с этим связанных. Попробуем разобраться хотя бы в некоторых из них.

Во-первых, это наличие объема данных сам по себе. Объем и скорость поступающих данных на сегодняшний день исключает возможность их обработки операторами. Следствием является острая необходимость в наличии на рынке продуктов, обеспечивающих решение задач Data Quality и Data Mining в автоматическом режиме с уровнем извлечения не ниже 80-90 процентов при весьма высокой скорости обработки. И что не маловажно, количество ошибок должно быть не более 1-1,5 процента. Внимательный читатель, может сказать, что есть различные распределенные решения способные решить вопросы низкой производительности, такие как Hadoop и так далее. Все верно, но многие забывают, что такого рода процессы носят циклический характер. И, то что было только что извлечено, должно быть добавлено в справочники, поисковые индексы и т.д. Данные непересекающиеся в рамках одного потока, могут пересекаться с данными из другого потока. Следовательно, количество параллельных веток должно быть сведено к максимальному минимуму, а производительность в рамках одного потока должна быть максимальна.

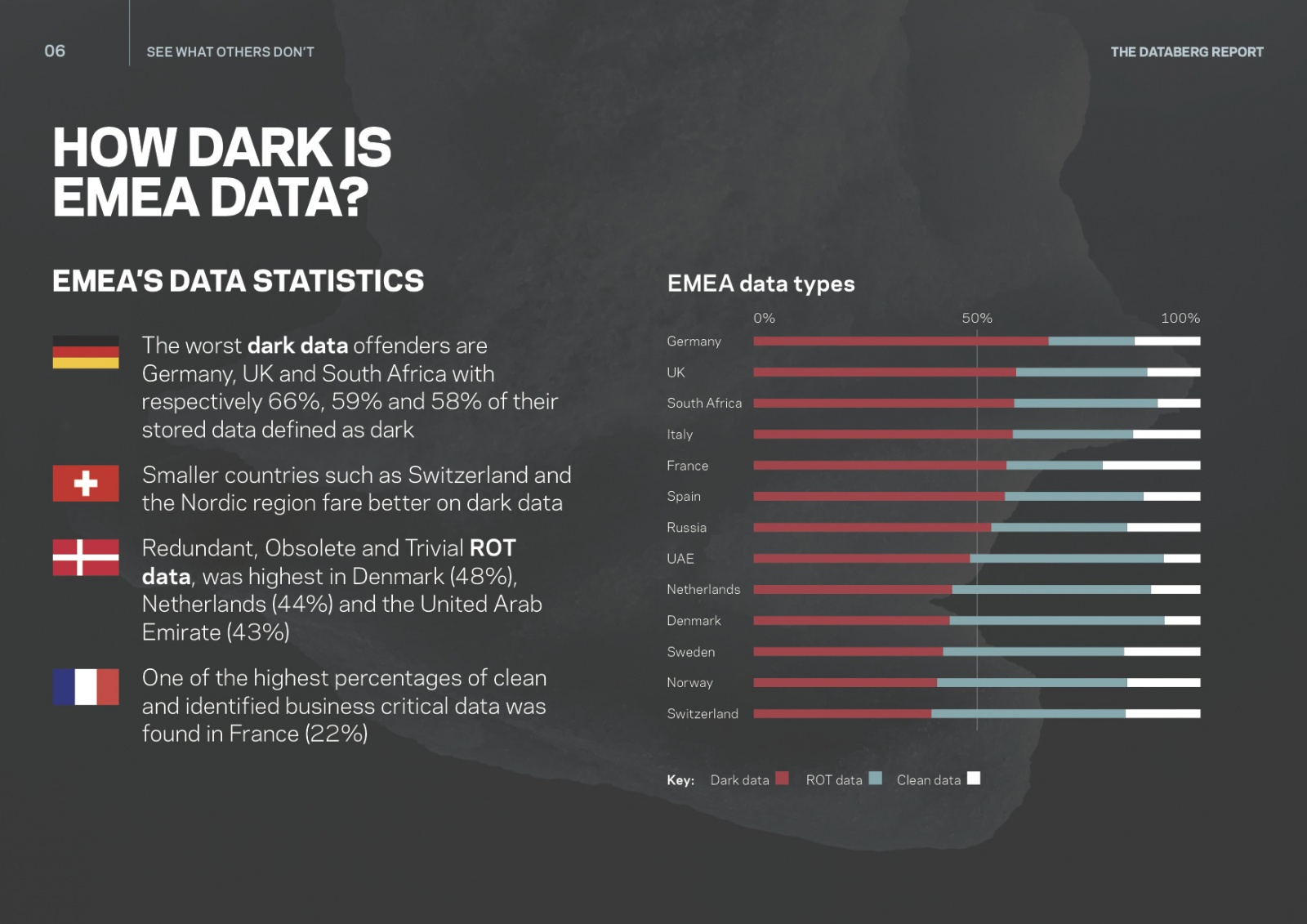

Во-вторых, это реальный процент, который используется. По оценкам ряда западных источников доля «темных» или скрытых данных в разных странах достигает половины и более. Основными причинами невозможности их использования являются их слабая структурированность на фоне низкого качества. Здесь сразу хочется пояснить, что проблема структурированности и низкого качества – это две совершенно разные проблемы. Неструктурированные данные трудно разложить на составляющие и построить какие-либо зависимости, сложно сравнивать, но при этом они могут быть абсолютно достоверными и валидными по своей сути. Невалидные, или данные с низким качеством, могут быть прекрасно структурированы, но не соответствовать объектам «реального» мира. Например, почтовый адрес, может быть замечательно разложен по полям, но не существовать в природе.

В-третьих, это отсутствие у западных систем компетенции в области семантики русского языка. Данная проблема зачастую упускается сами аналитиками при выборе систем для работы с данными. Поставщики решений и системные интеграторы радушно обещают, что это вопрос, легко решаемый ведь «наше решение уже присутствует во многих странах». Но как правило умалчивается тот факт, что это или международные организации, работающие на английском языке или это язык той же романской группы, или внедрение не полностью локализовано. По нашему опыту все известные на российском рынке попытки локализации задач семантического поиска не увенчались успехом, достигая уровня качества не выше 60-70 процентов от возможного.

В-четвертых, различные участники процесса могут иметь различные представления о правилах классификации каких-либо сущностей. В данном случае речь не идет о том, что в рамках информационного ландшафта существует несколько систем. Зачастую в рамках одной и той же системы одни и те же по своей сути объекты по-разному описаны и классифицированы. И причина не в невнимательности или нерадивости каких-то сотрудников. Основная причина в контексте или условиях, в которых производилось действие. Национальных традициях, различном культурном коде. Произвести однозначную регламентацию правил в этих условиях попросту невозможно.

Таким образом, задача использования больших данных, искусственного интеллекта и т.д. на самом деле требует более широко взгляда, объединенного скорее термином Data Science. А в процессе проектирования решений в области BigData следует уделять отдельное и не менее важное значение вопросам очистки и извлечения данных. Иначе, следуя известной поговорке, автоматизированный бардак – все равно бардак.

Автор: MaximKovalev