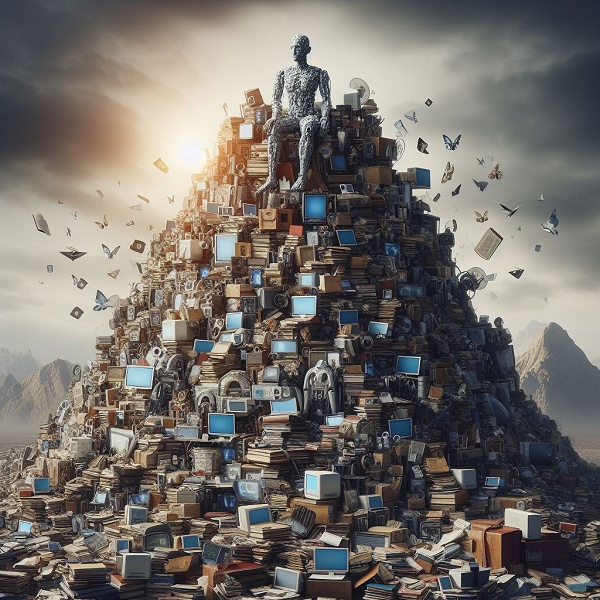

Похоже, процесс создания всё более масштабных и сложных языковых моделей на основе ИИ уже упёрся в одну весьма серьёзную преграду. Для таких моделей весь интернет фактически слишком мал.

Для обучения больших языковых моделей нужно очень и очень много данных. GPT-4, согласно данным аналитика Epoch Research, обучали на 12 трлн токенов, а GPT-5, вероятно, понадобится 60-100 трлн! Конечно, во всём интернете наберётся гораздо больше, однако языковые модели учат на специально созданных базах данных, так как нельзя «скармливать» ИИ всё подряд — это слишком некачественная основа. И аналитики посчитали, что для обучения GPT-5 уже сейчас не хватает 10-20 трлн токенов. То есть примерно столько же или даже больше, чем требовала вся GPT-4.

Некоторые компании уже ищут альтернативные источники обучения данным, предлагая в качестве вариантов такие вещи, как общедоступные стенограммы видео и даже «синтетические данные», генерируемые ИИ, но последний вариант, видимо, не подойдёт.

OpenAI, к примеру, обсуждала обучение GPT-5 на основе транскрипции из общедоступных видеороликов YouTube. Аналитики пока не спешат бить тревогу, так как всё же есть варианты, как нарастить количество подходящих для обучения ИИ данных. Однако, учитывая темпы развития ИИ, если столь серьёзная загвоздка есть уже сейчас, неясно, смогут ли IT-гиганты в обозримом будущем выйти на совершенно новый уровень ИИ и создать условный GPT-6.