Привет!

Сегодня Amazon Web Services выпустили новый сервис, который работает с другими сервисами, а именно может помочь в переносе данных между:

- S3

- MySQL RDS/Внешние MySQL серверы

- DynamoDB

AWS Data Pipeline позволяет копировать, переносить данные из таблиц SQL и DynamoDB в S3 и наоборот.

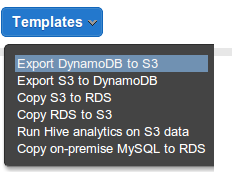

По умолчанию Data Pipeline предоставляет несколько шаблонов:

- Экспорт из DynamoDB в S3

- Экспорт из S3 в DynamoDB

- Копирование из S3 в RDS

- Копирование из RDS в S3

- Анализ файлов в S3

- Миграция из не RDS MySQL в S3

Так же можно придумать много всяких других методов использования Data Pipeline.

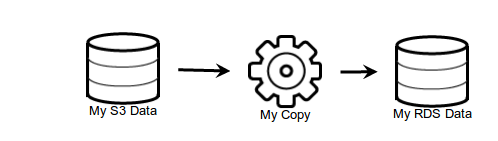

Процесс легко настраивается с помощью графического интерфейса. Вы перетягиваете элементы, задаёте параметры и так далее.

В официальном блоге AWS появилась статья-пример настройки Data Pipeline.

Что приходит в голову при вопросе «Зачем?». С помощью Data Pipeline можно легко настроить бекапы. Причём даже бекапы с внешних серверов БД на S3, например.

Давайте поделимся идеями, как мы можем использовать эти механизмы. Может у вас есть вопросы о возможностях? Давайте искать ответы вместе!

Автор: korjik

![Запуск I2S Трансивера на Artery [часть 2] (DMA, FSM, PipeLine) Запуск I2S Трансивера на Artery [часть 2] (DMA, FSM, PipeLine)](https://www.pvsm.ru/wp-content/plugins/contextual-related-posts/timthumb/timthumb.php?src=http%3A%2F%2Fwww.pvsm.ru%2Fimages%2F2024%2F08%2F17%2Fzapusk-I2S-transivera-na-Artery-chast-2-DMA-FSM-PipeLine-21.png&w=100&h=100&zc=1&q=75)