Мы создали и развиваем первый в России инструмент по GEO - Тунец, который сосредоточен не на том, чтобы просто анализировать ваше присутствие в ответах нейросетей, а выдавать четкие и конкретные рекомендации по созданию контента и местам его размещения.

В ходе изучения и внедрения нейросетей в работу Тунца мы подмечаем разные странности и делимся этой информацией с вами.

Ограничения ИИ при работе с веб-ресурсами: что нужно знать владельцам бизнеса

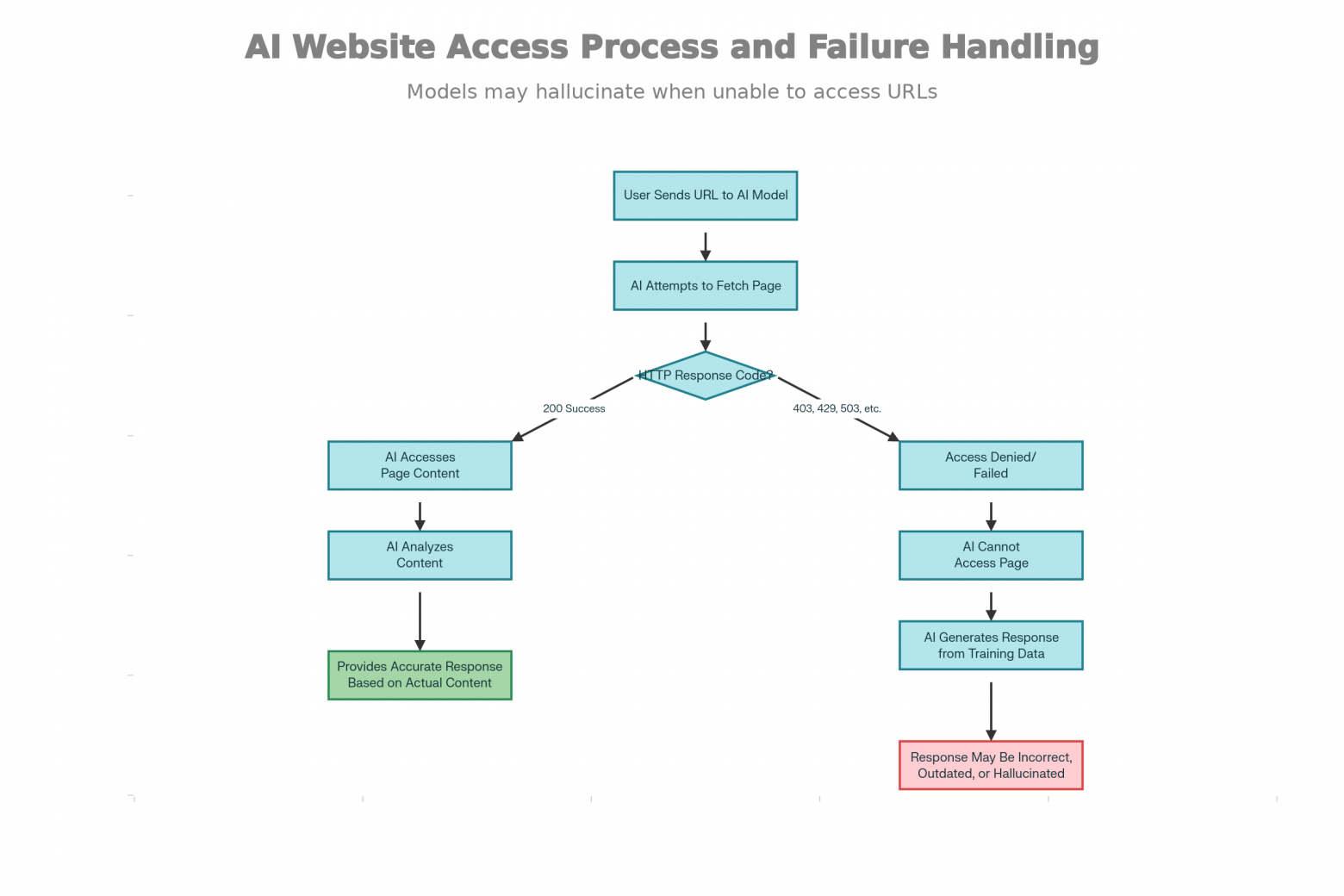

Если вы используете ИИ-сервисы для анализа веб-контента, важно понимать их реальные возможности. Наши тесты показали критический момент: из 15 отправленных источников модели успешно обрабатывают только 6–10, несмотря на наличие единственного URL в каждом запросе.

Почему это происходит

ИИ-модели не всегда имеют доступ к открытым интернет-ресурсам. При попытке обработки страницы система часто сталкивается с недоступностью: сервер не возвращает HTTP статус 200, блокирует запросы или ограничивает доступ. В результате модель не может извлечь реальный контент, заголовки, структуру и метаданные.

Типичные ошибки, которые вы увидите:

-

Не удалось открыть страницу

-

HTTP статус не равен 200

-

Контент недоступен

Что это значит для вашего анализа

Когда модель не может загрузить источник, она не может выполнить качественный SEO-анализ, проверить релевантность контента или оценить его структуру. Это не означает, что сайт плохой — просто инструмент не имеет к нему доступа.

Таким образом: если не требовать подтверждения "положительного" статуса у нейросети, то модель будет просто генерировать ложный ответ, так как она в целом не может не дать ответа.

Существующие способы защита веб-сайтов от автоматизированного доступа

Robots.txt и User-Agent блокировки — это первая линия защиты, которую используют сайты для управления доступом AI-краулеров. Специальные User-Agent строки помогают сайтам идентифицировать различные боты: GPTBot (OpenAI), ClaudeBot (Anthropic), CCBot (Cohere) и другие. Владельцы сайтов могут явно запретить этим ботам доступ, добавив в robots.txt строки типа User-agent: GPTBot и Disallow: /. Однако важно отметить, что некоторые боты, как Bytespider, игнорируют robots.txt полностью и требуют серверных методов блокировки.

Cloudflare и CDN-блокировки представляют собой системную проблему масштабов. С 1 июля 2025 года Cloudflare изменил поведение по умолчанию для всех новых доменов, размещённых на его платформе. Сервис управляет трафиком 20% всемирной сети, и теперь каждый новый домен по умолчанию блокирует AI-краулеры. Это означает, что значительная часть интернета теперь требует явного разрешения от владельца сайта на доступ AI-моделям.

Rate Limiting и HTTP статус-коды ошибок

Когда AI-модель направляет множество запросов слишком быстро, серверы отвечают кодом 429 (Too Many Requests), что свидетельствует о превышении лимита запросов. Это не редкость для краулеров: системы защиты специально разработаны, чтобы ограничить интенсивность доступа, используя token bucket алгоритмы или per-IP лимиты. Код 403 (Forbidden) указывает на то, что доступ к ресурсу запрещён, а код 503 (Service Unavailable) сигнализирует о временной недоступности сервера.

JavaScript и динамический контент создают отдельный класс проблем. Если сайты размещают основной контент за JavaScript-кодом, который выполняется в браузере. Простые HTTP-запросы, которые использует большинство AI-краулеров, получают только пустой HTML без содержимого. Для обработки JavaScript требуются полнофункциональные браузер-движки, которые требуют значительных вычислительных ресурсов и замедляют процесс извлечения данных.

Автор: Ja-gagarin