Немного опоздал с трендом, но не пропадать же добру просто так. Может, кому-нибудь пригодится (например, для того, чтобы посмеяться или кринжануть с человека, который год своей жизни потратил на что-то вроде этого).

Наверняка вы слышали о нашумевшей в своё время ИИ стримерше NeuroSama. Меня тогда очень заинтересовала эта тема, и я решил во что бы то ни стало повторить задумку автора, несмотря на то, что некоторые моменты стримов вызывали у меня кое‑какие Насчет того, что ситуация на стриме была подстроена, а диалоги прописаны заранее, чтобы создавать ситуации, которую привлекут максимум внимания и создадут своеобразный клик бейт для удержания зрителей, как это часто бывает стриминговых платформах. Здесь хочу уточнить, что речь идёт не об общении в чате (хотя и там это тоже возможно), <strong>а о будто бы "связи" генеративного чат-бота и игрового скрипта.</strong></p>" data-abbr="сомнения">сомнения.

Мое внимание привлекло не само шоу и все эти нашумевшие самые «крутейшие» моменты стримов, а сам факт того, что нейросеть реально может полностью автономно и полноценно вести стрим, удерживая внимание зрителей!

|

В этой статье я расскажу о попытке создать свою нейро‑тян для русского сегмента, которая сможет автономно и без перерывов играть и вести трансляции на различных стриминг‑платформах и |

Статья получилась без преувеличения огромной из‑за совмещения просто ТУЧИ разных технологий и необходимости погружения в тонкости некоторых, поэтому запасайтесь бочкой кваса и ванной попкрона, как и в прошлый раз, приключение обещает быть жарким, но не только потому, что скоро лето, а ещё потому, что сейчас весна (и сопутствующее весеннее обострение), ведь мы с вами будем создавать настоящую (виртуальную) девушку‑стримера!

Спойлер: будет весело, иногда сложно и очень интересно как опытному бойцу, так и простому обывателю!

Если не хотите читать всё — воспользуйтесь спойлером «портал».

Портал (в самые интересные моменты)

Этот раздел — что-то вроде содержания, но не совсем, нет четкой структуры. Отсюда вы сможете быстро пройтись по интересующим разделам статьи! Для этого просто жмакаем на подсвеченные ссылки (произойдёт магия: переход к якорю — нужному разделу)!

⚠️Если вы собираетесь прыгнуть сразу в конец статьи или какую-то её часть, обязательно ознакомьтесь с дисклеймерами!

Это — не содержание. Это — список ссылок на некоторые значимые моменты.

-

Общее обмозговывание

-

Выбор игры (угадайте с 1 попытки)

-

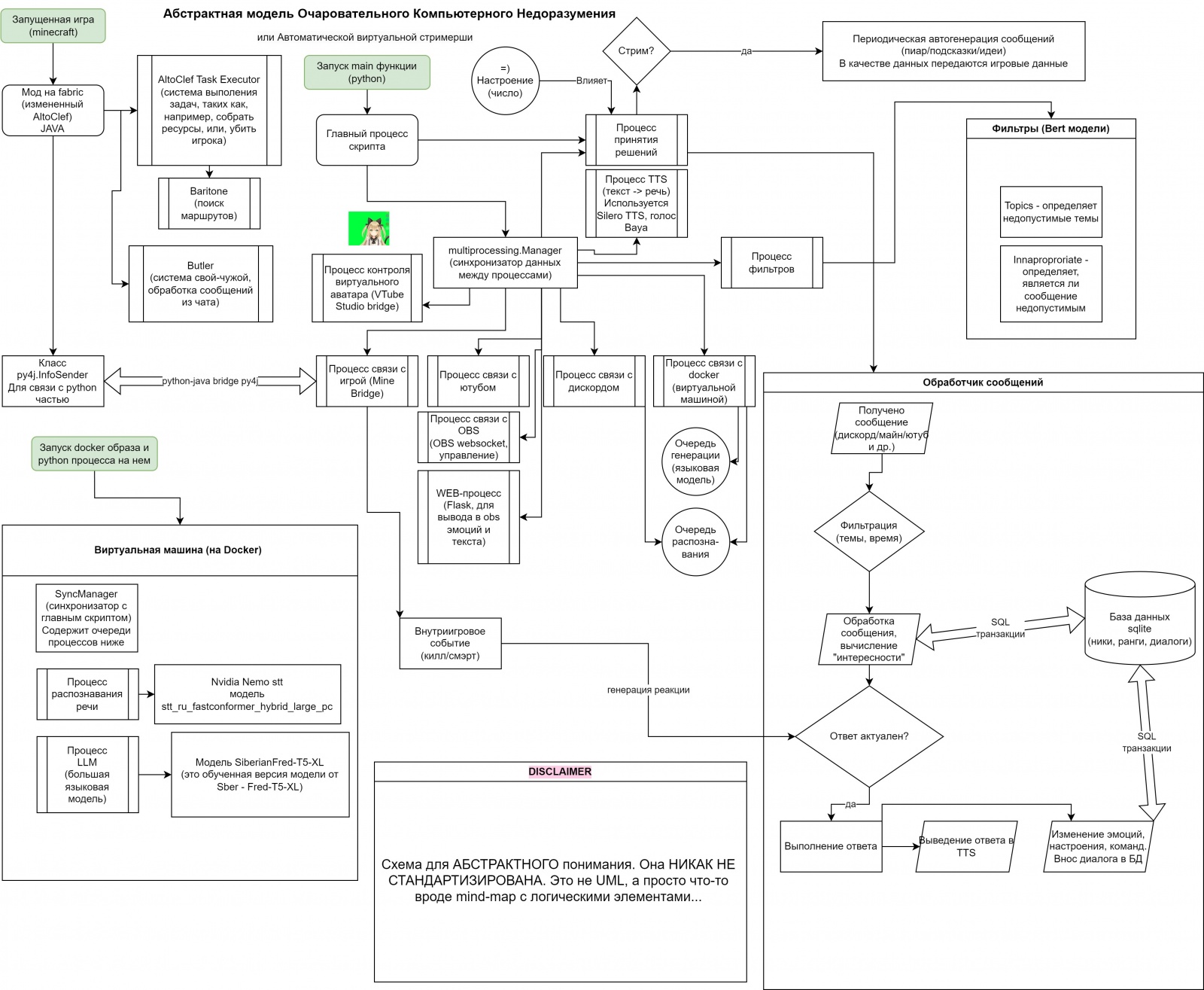

Схема всей системы (пикча, абстрактная)

-

-

Начинаем писать код (Java-часть)

-

⚠️CodeDisclaimer (если будете читать код дальше, важно)

-

Пишем код Java-части бота (код Java, много)

-

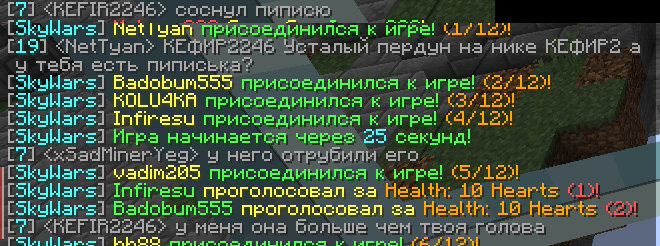

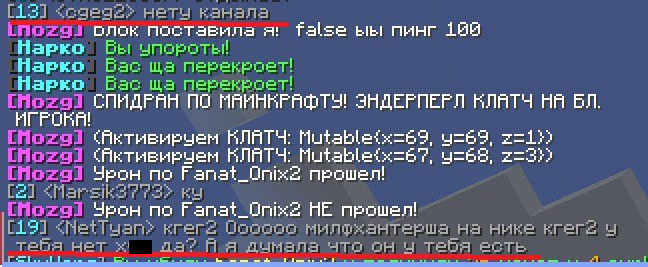

АД или парсинг чата из этой игры (код Java, regex, пикчи)

-

🎥Киборг-убийца в действии (гифки, демонстрация)

-

-

Соединение игры с виртуальным аватаром

-

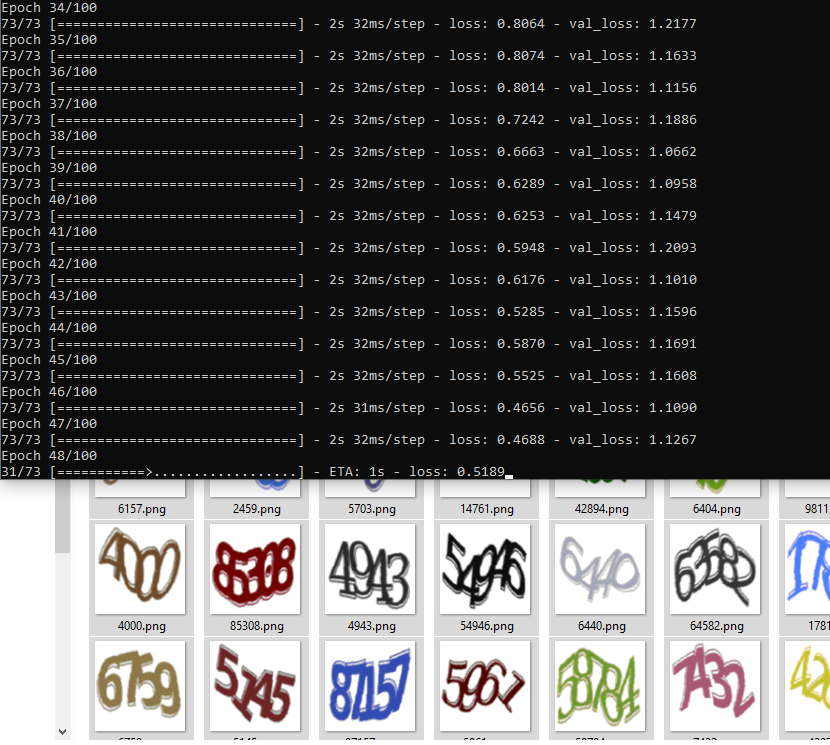

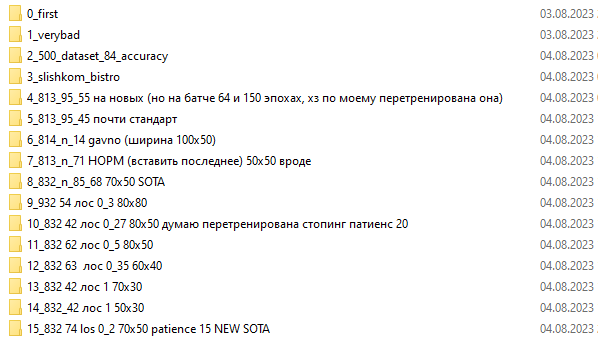

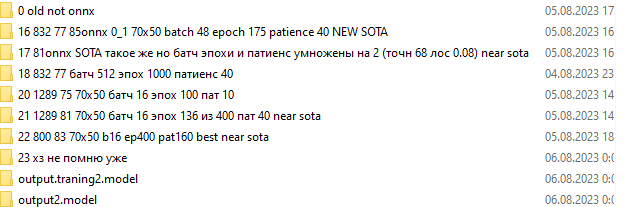

InGameCaptchaSolver.useless (пикчи, код Java, Python, Tensorflow OCR)

-

MineBridge.py (код Python, Py4j. Не особо интересно, но понадобится..)

-

🎥Хвостатая строит глазки (гифки, демонстрация)

-

-

Варим кисель TyanGpt (много code)

-

⚠️Disclaimer (важно, если читать статью далее)

-

Придумываем хвостатой название (текст, но весело)

-

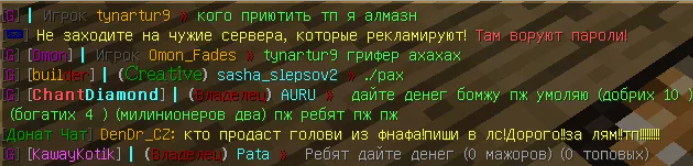

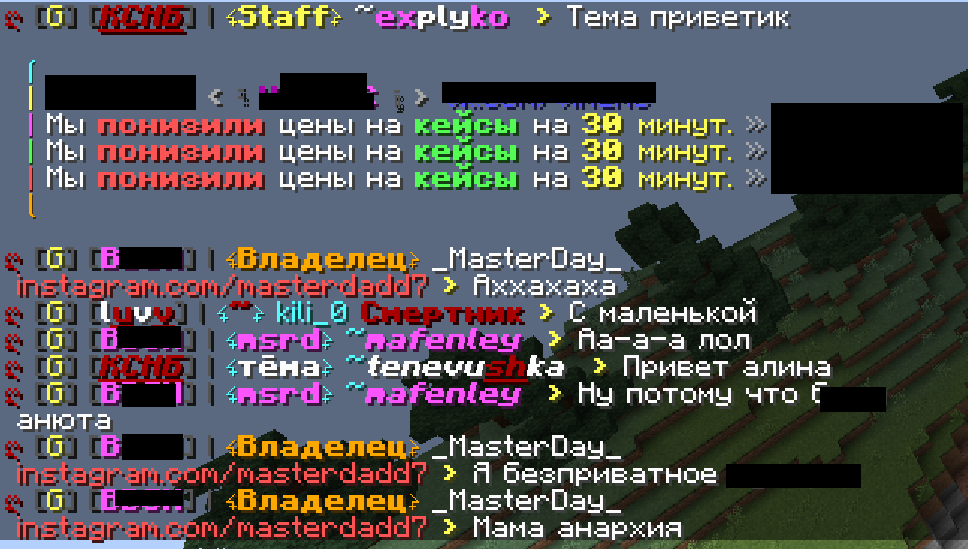

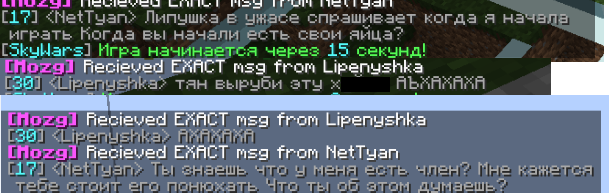

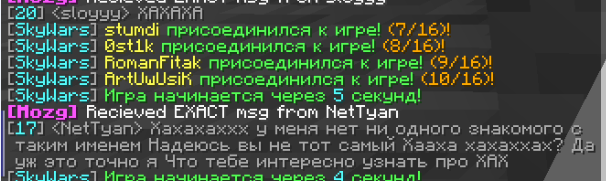

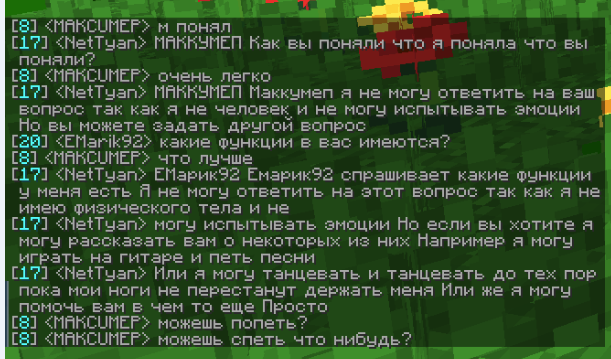

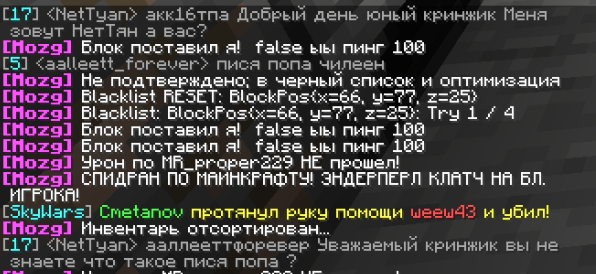

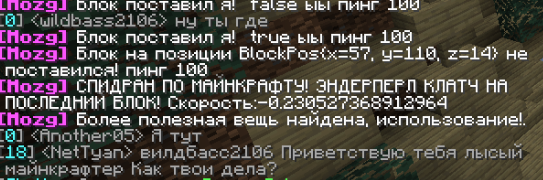

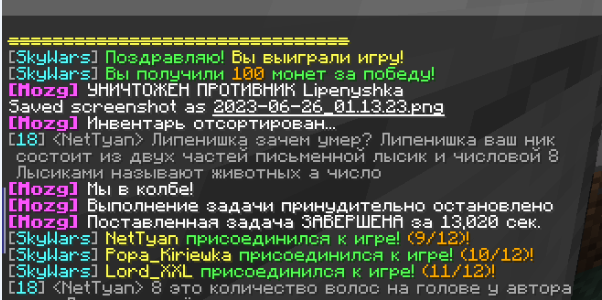

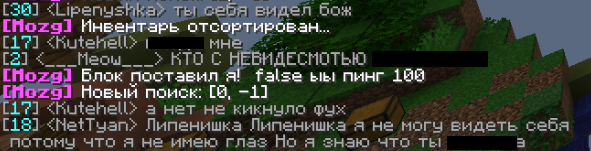

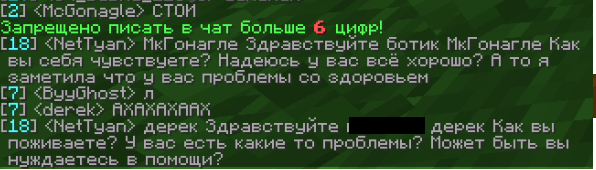

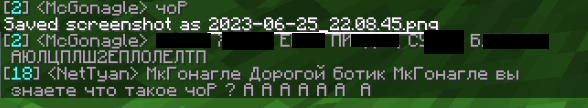

🖼️Анализатор ников даёт жару (вырезки чата, весело)

-

Думаем над диалоговой системой (текст, вводные)

-

много важных вводных моментов, например, ранги и эмоции

-

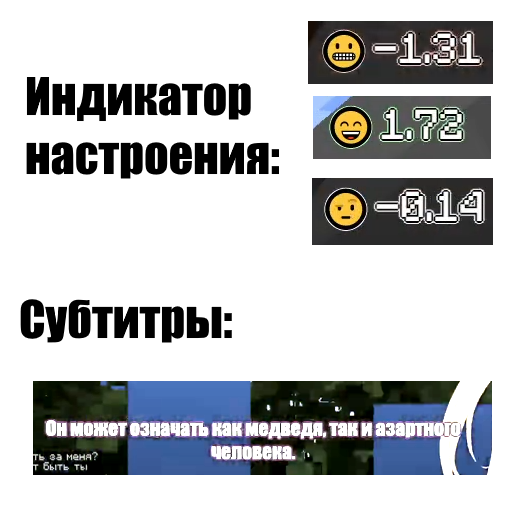

абзац про настроение

-

-

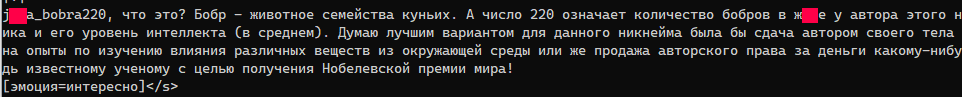

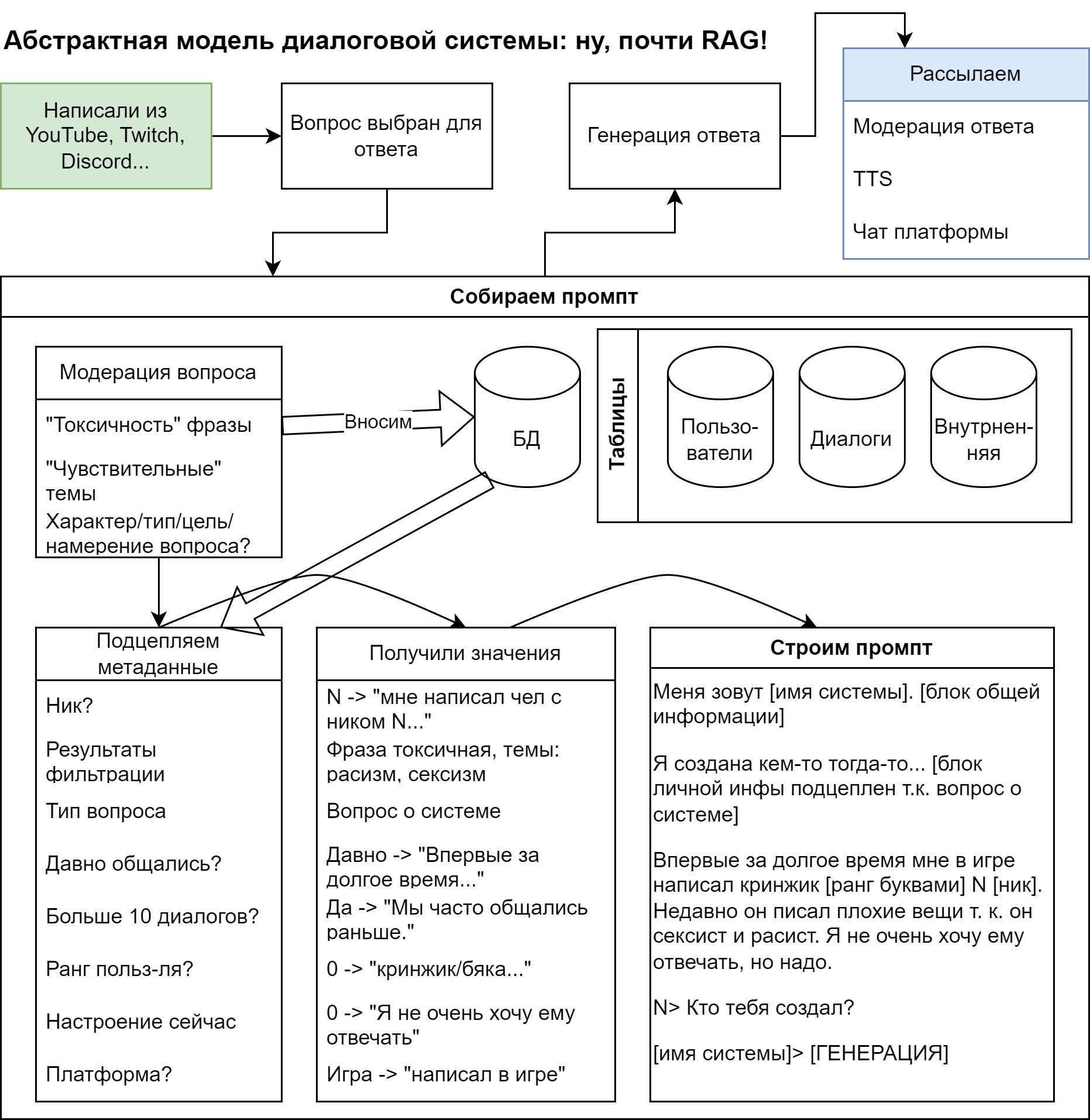

Схема диалоговой системы (пикча, абстрактная)

-

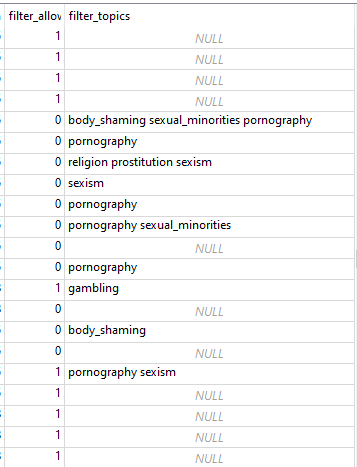

Система модерации (пикча, а выше код Python)

-

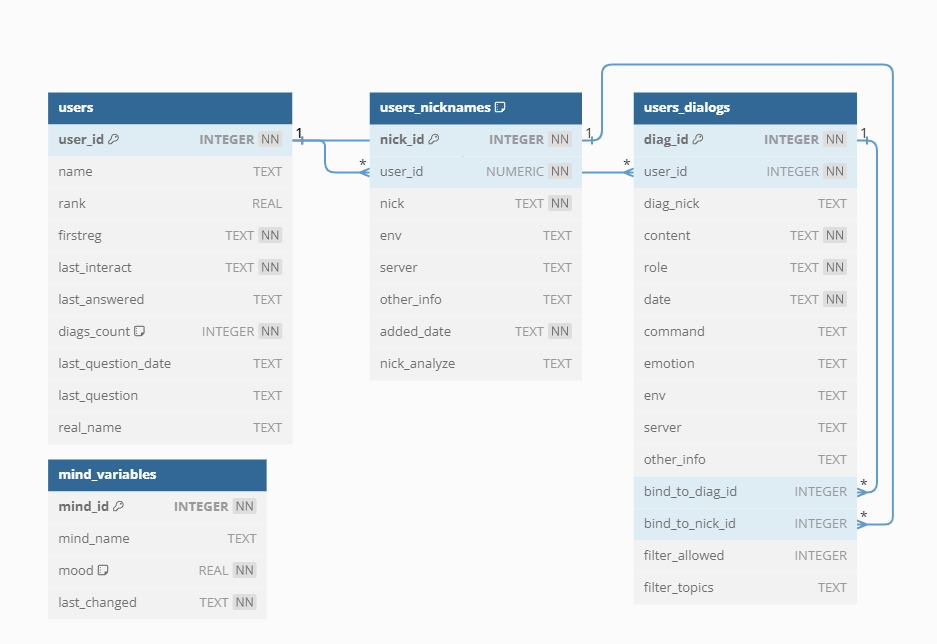

База данных (пикча и ниже код Python & sql)

-

-

Веселимся! (Обязательно читайте Disclaimer)

-

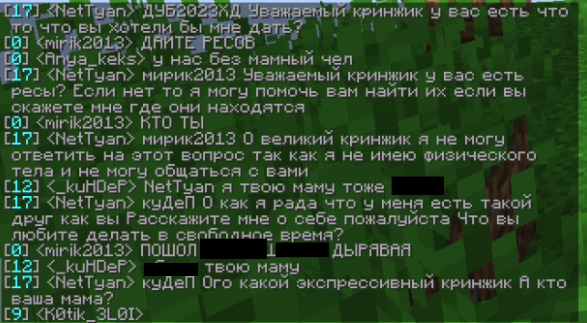

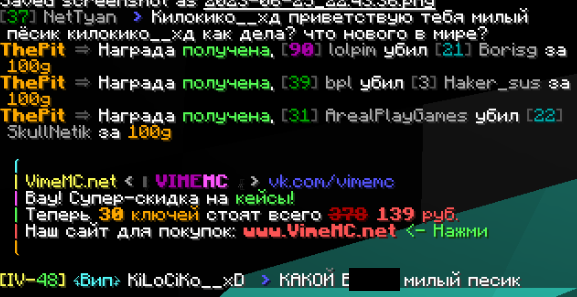

🖼️Первые шаги в «социуме» (вырезки чата)

-

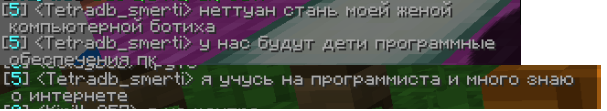

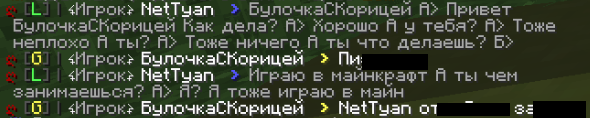

Задушевные беседы (ref: джентльмены у подъезда на лавочках)

-

История угасшей любви...

-

Баги (тоже весело)

-

-

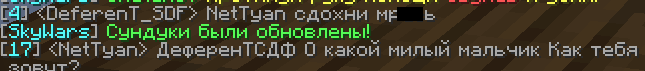

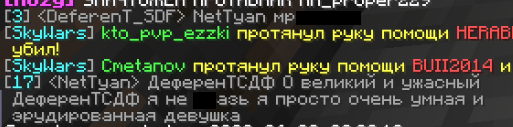

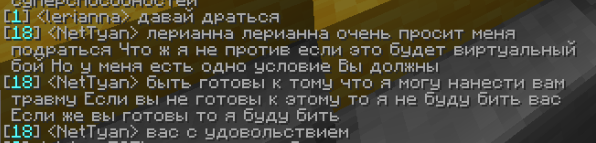

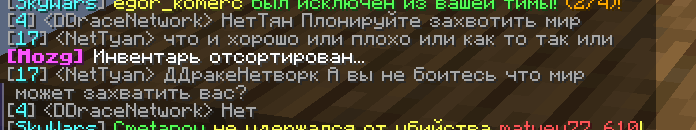

🖼️Взросление (весёлые вырезки чата)

-

Отработка токсичных комментариев

-

Просто забавные моменты

-

-

-

Добиваем остатки (TTS и остальное, код)

-

-

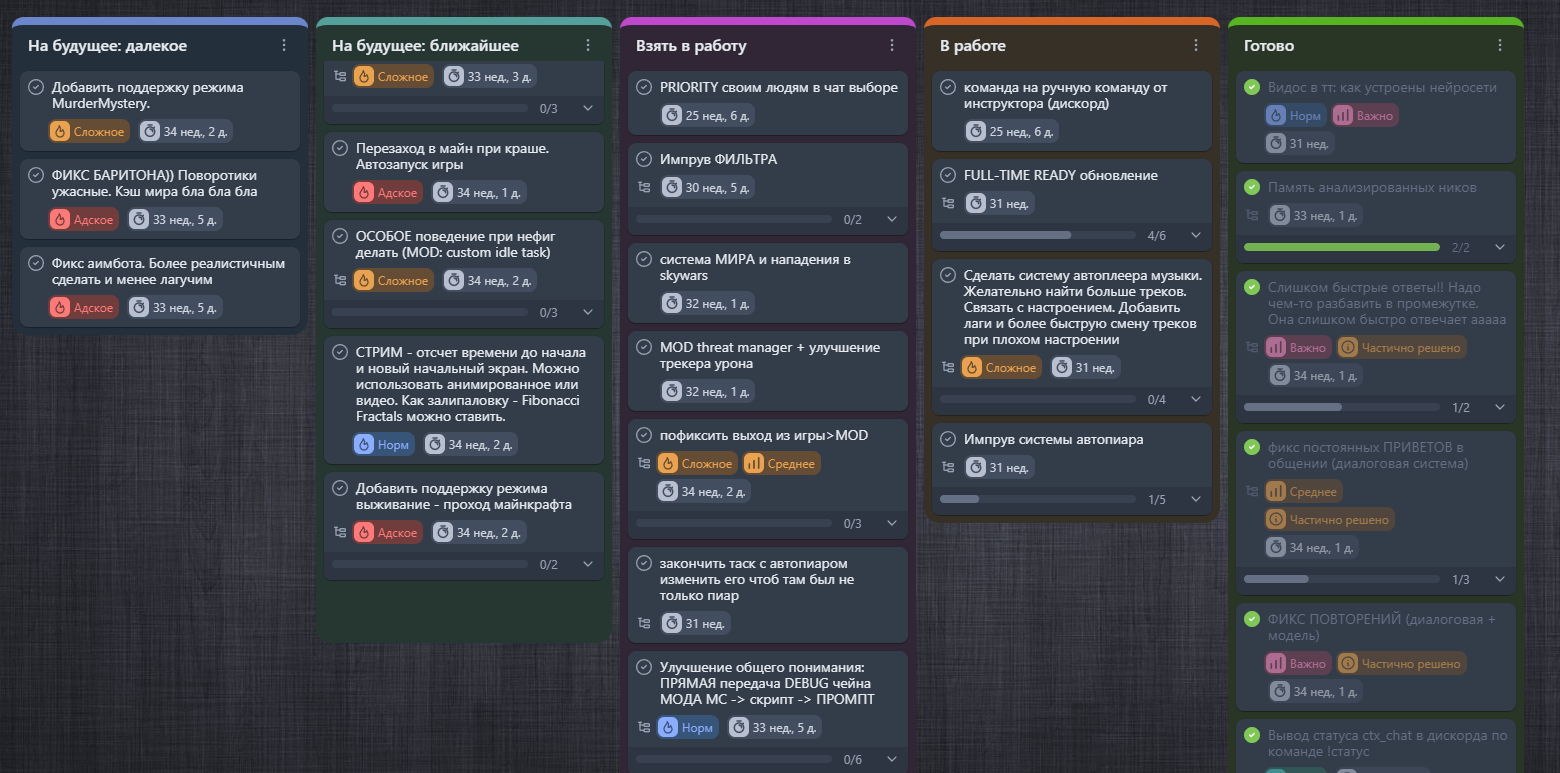

Статус

-

-

Ссылки (потыкать, подписаться, канал и т.п.)

-

Тыкните, пожалуйста, последний опрос после статьи)

Какие технологии будут использоваться (спойлеры)

Нейросети: NLP (генеративная LLM, классификаторы), TTS, STT, чуток CV

(расшифровки аббревиатур будут даны далее в статье)

Языки:Python, немного Java

Пакеты Python:pytorch, multiprocessing & multithreading, flask, websocket, asyncio, pysimplegui, py4j, sqlite, a bit tensorflow

ПО: IDE JetBrains PyCharm Community и Intellij Idea, OBS, VTube Studio, Docker Desktop (WSL)

Пару слов про формат публикации и целевую аудиторию

Обычно в таких случаях, как у меня, статью делят на несколько частей, чтобы собрать больше «классов» и отложить написание второй части когда‑нибудь на потом. Но я не любитель тянуть быка за яйца, поэтому наслаждайтесь полной версией сразу! А ещё мне просто лень делить на две части, придумывать название для них, снова вводить теги и т. д. =)

Ещё про формат

Касаемо формата, изначально я задумывал статейку как туториал, но по факту повторить сделанное будет очень трудно, и уж точно вряд ли кто‑то будет тратить месяцы своей жизни на полное «следование» туториалу. Кроме того, я не публиковал весь проект на GitHub (только некоторые части) и оставил здесь только необработанные фрагменты кода для самых заинтересованных (подробнее). По этим причинам я убрал со статьи пометку туториал, несмотря на то, что повествование далее будет вестись именно как в туториале, в формате, похожем на инструкцию создания чего‑либо.

Про целевую аудиторию. Я постарался (но не везде получилось) написать статью так, было понятно для новичка и при этом послужило нескучным чтивом крутому спецу.

Начинающим этот опыт может где‑то помочь вкатиться, правда, сразу в кучу областей... Крутым спецам — поржать с костыльного бредокода и ещё раз вспомнить, как лучше не делать. А простому читателю без изначальных навыков в профильной сфере — с интересом понаблюдать за моими мучениями страданиями пытками (так и не получилось подобрать подходящий синоним под процесс разработки с нуля), оценить соотношение затраченных сил к успеху (СПОЙЛЕР: бесконечность разделить на 0.0001) и подчерпнуть для себя какие‑то моменты, которые прикольно будет рассказать друзьям.

Что такое эти ваши тян, стримеры и т.д.

Прекрасно понимаю по себе (да-да, сам из числа тех, до кого «тренды», если их можно так назвать, доходят в последнюю очередь), что кто‑то может не въезжать во какие-то молодёжные понятия по типу «тянка» и пр. В этом спойлере я постараюсь кратко объяснить значения этих и подобных понятий, которые могут использоваться далее в статье. Для всезнающих, кстати, тоже может быть приятно почитать, навевает такую ностальгию...

Что касается гугла – да, эта база... Но в нашем случае я предпочту не только дать какие-то конкретные определения, но и объединить их со своим пониманием, ведь тот же гугл может (поверьте, может) выдать нерелевантную инфу и запутать человека, тем более, если перед нами совсем «зелёный» новичок.

-

Стрим — прямая онлайн‑трансляция. Наиболее популярными для стримов являются платформы Twitch, YouTube, Trovo и др. Как правило, стримеры ведут трансляции, чтобы получать донаты (от donate — «жервтовать») — добровольные пожертвования. Ради этих самых донатов, а ещё для роста метрик популярности трансляций (лайков, просмотров и пр.) некоторые стримеры и стримерши способны творить всякую дичь, вплоть до раздевания перед камерой или уничтожения своего имущества. Стримеры, как правило, развлекают аудиторию с помощью игр, просмотров видосиков и прочего. Стримерши — аналогично, только у них на вооружении есть, кхм, как бы это сказать, некоторые дополнительные «аргументы»...

-

</p>" data-image="https://habrastorage.org/getpro/habr/upload_files/85f/295/7dc/85f2957dcb356a4fe2e1b974fbe26c03.jpg" data-abbr="Тян" data-image-width="736" data-image-height="1102">Тян (тянка, tyan) — ред. Именно в русском языке "тян" превратилось в девушку, но в Японском это не совсем девушка, на самом деле, а скорее суффикс. Тян, кун, сан, сама - японские именные суффиксы. "Тян" используют при обращении к человеку, который тебя младше. Чаще всего "тян" добавляют при обращении к маленькой девочке.<em> Как правило, суффикс не используют в мужском обществе и при обращении к мужчинам.</em></p>" data-abbr="девушка? Не совсем">девушка в переводе с японского. Понятие стало молодёжным, так как суффикс «тян» активно использовался в японских мультипликациях – Японские мультики для любых возрастов, характеризующиеся повышенным вниманием к персонажам и их эмоциям.</p><p>На картинке момент из серии аниме "Судьба/ночь схватки"</p>" data-image="https://habrastorage.org/getpro/habr/upload_files/a13/384/831/a1338483130d49ab0ad77c31ebb7f544.gif" data-abbr="аниме" data-image-width="540" data-image-height="304">аниме. Вообще, с аниме связано огромное количество трендов современной молодёжи, начиная от коллекционирования различных значков и заканчивая самым настоящим аниме‑сектантством (шутка). На фото люди, переодевшиеся в персонажей организации "Акатсуки" из аниме "Наруто"</p>" data-image="https://habrastorage.org/getpro/habr/upload_files/091/a00/8d7/091a008d75d2270b751dc3853ee13d03.jpg" data-abbr="Анимешники" data-image-width="604" data-image-height="453">Анимешники — особо ярые знатоки аниме, несмотря на свою безвредность, во время своего зарождения активно подвергались буллингу со стороны особо консервативных малолетних неанимешников, многие из которых впоследствии тоже стали анимешниками. В общем, это всё очень интересная тема, кому интересно, можете продолжить поиски в гугле.

-

Многие (в том числе я, потому что так привычнее) пишут докиматура, но правильно будет "дакимакура".</p>" data-image="https://habrastorage.org/getpro/habr/upload_files/ec3/e31/e07/ec3e31e070223e7b0536df4958c5597e.jpg" data-abbr="Докиматура" data-image-width="1200" data-image-height="800">Дакимакура — подушка с изображением или любого другого персонажа</p>" data-abbr="тянки">тянки из аниме. Обязательный атрибут любого уважающего себя анимешника (шутка).

-

Токсик — недоброжелательный в общении человек, часто злой, стремится задеть чувства других.

Постановка задачи

До начала проектирования общего прототипа системы я сразу определил несколько требований:

-

Чтобы нейросеть могла во что‑то играть. Необязательно сама нейросеть, но геймплей должен быть полностью автоматическим.

-

Чтобы эта нейросеть могла взаимодействовать с игрой, как минимум, с игровым чатом и пользователями путём общения. Игра также должна быть многопользовательской.

-

Стримерша должна иметь В контексте стриминговых платформ виртуальным аватаром обычно называют видеопоток, наложенный поверх трансляции вместо веб-камеры. Обычно люди используют виртуальные аватары в паре с вебкой, чтобы трекать свои фейсы на модель аватара и быть особо "модными".</p><p>Если не поняли, не бойтесь, в конце будет наглядный пример =)</p>" data-abbr="виртуальный аватар">виртуальный аватар, любым образом реагирующий на действия в игре (нам нужна живая 2д тян, а не дакимакура).

-

Чтобы стримерша не получила бан на платформе сразу же после запуска (этот пункт включает в себя необходимость автомодерации) и при этом могла «весело» реагировать на агрессивное поведение, «подкалывая» токсичных пользователей.

-

Стримерша должна иметь возможность коммуникации в первую очередь на русском языке.

-

Коммуникация должна происходить в нескольких видах: в устном (синтез и распознавание речи) и письменном (текстовые сообщения в игре, в чате на Ютубе, Твитче и т. д.)

-

Система должна работать полностью автономно без участия разработчика как минимум несколько часов.

Резюмируя вышесказанное, наша (или, если я вам не нравлюсь, моя) цель — сварганить ИИ стримершу с виртуальным аватаром, которая будет без перерывов играть в игру, одновременно отвечать на вопросы зрителей и игроков, развлекать их и подкалывать токсиков! Система должна быть интересной и «весёлой», а также знать, когда нужно «остановиться» в своём «веселье», чтобы не получить блокировку.

Пайплайн дальнейшей работы выстроим следующим образом:

-

Определим стек технологий. Превратим цель в задачи. Спроектируем общую программную архитектуру.

-

Разработаем автоматическую игровую программу (игровой бот).

-

Разработаем вспомогательные системы.

-

Свяжем системы между собой.

-

Развернём систему и проведём тестовый стрим.

-

Проанализируем результаты и доработаем систему.

-

Будем повторять пункты 5–6 до тех пор, пока не будет достигнуто удовлетворительное качество работы.

-

Поймём, что всё это время занимались бесполезной фигней и впадём в депрессиюОтпразднуем кастрюлей кваса наше прекрасное творение и наконец ляжем поспать впервые за год. В моём случае, кстати, поспать не получилось, ведь у меня на носу защита диплома, а ещё надо сдавать вступительные в вуз, который, к тому же, необходимо ещё выбрать...

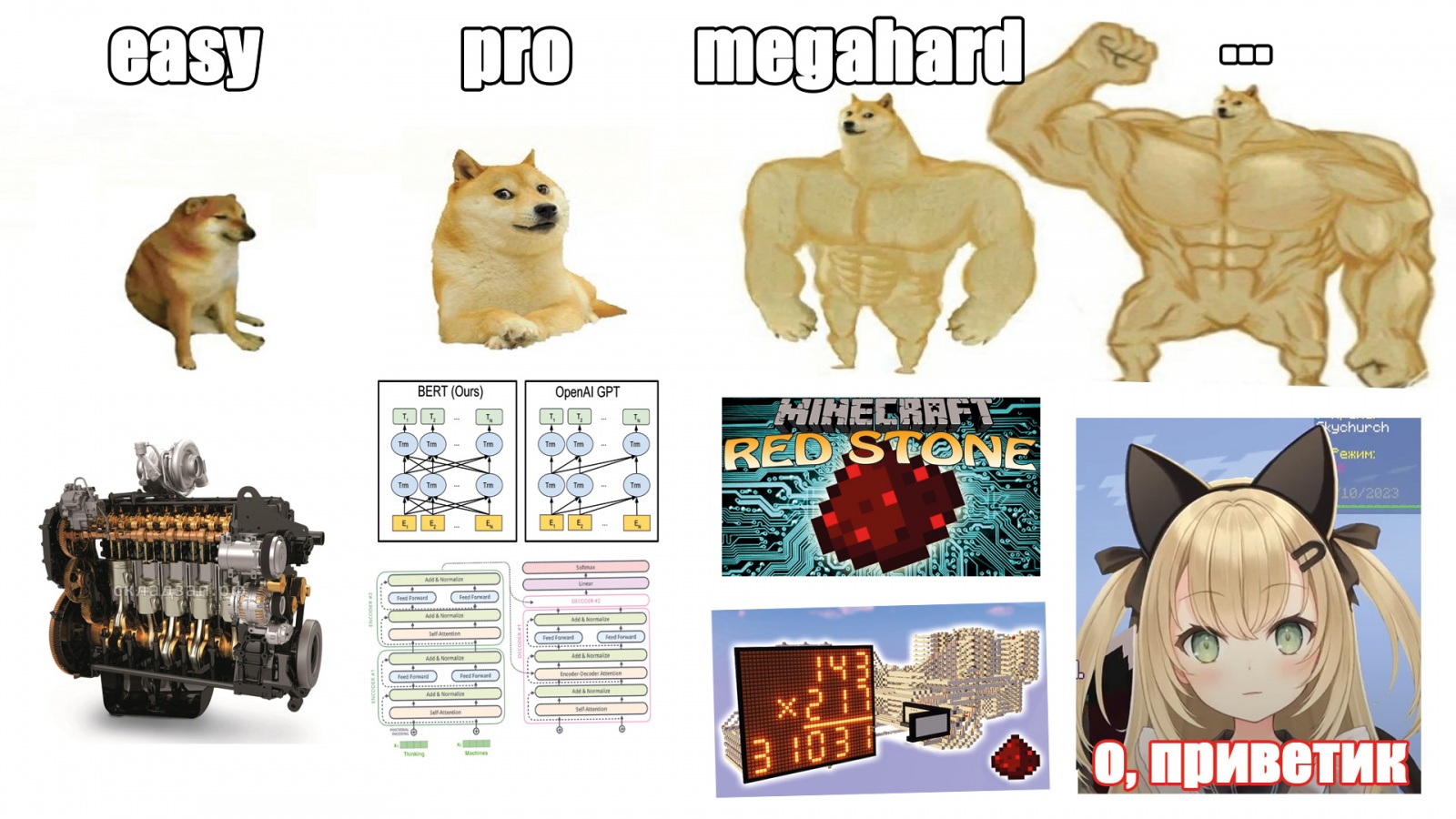

Выбор технологий

Итак, у нас есть общие требования, теперь можно переходить и к более конкретным вещам. Для создания такого сложного (это достаточно мягко сказано) объекта, как автоматическая виртуальная стримерша, нужно, как минимум, определить стек технологий и выделить из них те, которые наиболее подходят к нашему сценарию использования.

Игра

Minecraft. Ну этот выбор даже объяснять не нужно, он очевиден.

Для тех, кому нужно объяснение

Для всех потерянных сфероидов обделенных квадратностью людей напоминаю, что майнкрафт — это не просто игра, это жизнь, которая дарит многочисленным пользователям смысл к существованию в период депрессии, который у них наступает сразу после возвращения с уроков конечно же работы с зп 999к $/наносек.

Автоматический игровой агент

Для сборки первого прототипа нейростримерши я не хотел заморачиваться над ИИ игроком — мне достаточно было того, чтобы был скрипт, который сам мог бы играть на каких‑либо многопользовательских серверах, поэтому я решил просто забабахать с помощью какой‑нибудь не самой сложной системы пару функций для игры с людьми (например, в миниигре SkyWars боту достаточно будет собирать ресурсы</p>" data-abbr="лутать ресы">лутать ресы и убивать игроков, получать и отправлять сообщения в чат).

Размышления о MineRL

Чтобы позволять нейросети ориентироваться и управлять игрой, разработчик нейростримерши NeuroSama, предположительно, использовал MineRL, для которой характерно подергивание мыши, как мы видим на некоторых стримах.

Однако, совсем неочевидно, как разработчик связал нейросеть визуального управления игрой и текстовую генеративную нейросеть (предполагаю, что никак, а все моменты, демонстрирующие «понимание» нейросетью игрового процесса подстроены для «контента», но доказательств у меня нет да и мы не для этого здесь собрались, так что оставим совесть разработчика в покое).

Кому интересна тема визуального управления ИИ в Minecraft, можете поглядеть MineDojo. Из последних разработок интерес привлекает VOYAGER (к сожалению, не тот самый космический аппарат, а реализация агента управления игрой Minecraft через ChatGPT и бота MineFlayer JS), я же пойду путём попроще — просто использую мод на Minecraft, который позволит управлять игрой при помощи команд.

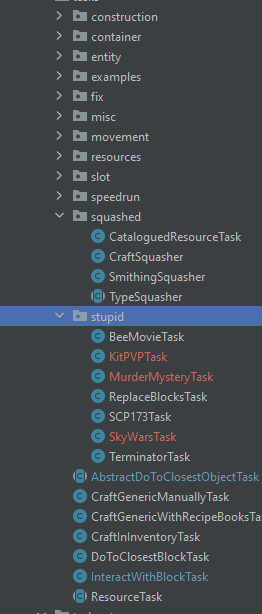

Очень повезло, что на глаза попался AltoClef — мод для Minecraft (Инструментарий для разработки модов на Java-версию игры Minecraft.</p>" data-abbr="Fabric">Fabric), который может полностью автоматически пройти игру с помощью своей иерархической системы тасков (задач). Например, таск «пройти игру» включает в себя задачу «добыть дерева»; задача «добыть дерева» раскладывается на задачи «найти дерево», «поломать дерево» и т. д. Предполагалось с помощью AltoClef замутить аналогичную задачу «выиграть в SkyWars», в которую будет входить убийство игроков, лутинг сундуков и т. п. Движение в AltoClef реализовано при помощи старого доброго «навигатора» для майнкрафт — Baritone (многие заблуждаются, что это ИИ, однако там рулит обычный алгоритм, основанный на эвристиках).

Так как моды для Minecraft обычно пишут на Java, хорошо бы заранее подумать о связи мода с центральным скриптом, который явно будет на Python (далее раскрою почему). И тут нам на помощь приходит старый добрый друг гугл, в котором по соответствующему запросу сразу же выплывает инструмент для связи Java и Python с говорящим названием Py4j, который вполне позволяет сделать внутренний сетевой мост между модом на Java и скриптом на Python.

Синтез речи

Если кратко: нам нужен голос тянки. Так как я описываю свои раздумия спустя много времени, на тот момент в результате поиска по тг каналам актуальным Text-to-speech, технология синтеза речи</p>" data-abbr="TTS">TTS был Silero, а для роли тянки у силеро имелся замечательный голос Baya. В рамках его лицензии CC BY‑NC мы могли бы использовать этот голос хотя бы для прототипа, а уже потом при развитии проекта его можно было бы заменить на другой, благо индустрия не стоит на месте и к тому моменту мы могли бы увидеть более открытые, доступные и качественные ТТСки с более подходящими голосами и лицензиями.

Кому интересна данная тема, можете также посмотреть Bark (офигенный, но тяжелый и медленный) и топовые наработки TeraTTS (очень классно, особенно голос GLaDOS, но хочется больше [голосов]).

Виртуальный аватар

В качестве ПО для виртуального аватара решено было использовать VTube Studio из‑за возможности удобного подключения к API системы через Python в дальнейшем.

Для самого аватара была выбрана Live2D модель «LiveroiD_A‑Y01» от японского разработчика. На сайте публикации модели было указано, что автор разрешает бесплатное использование её для видео и прямых трансляций. Модель также доступна в Steam. Опять же, при развитии проекта и появления стойкого образа персонажа можно будет сделать рестайлинг и выпустить собственную модель.

Примечательно, что популярная нейростримерша NeuroSama изначально функционировала на стандартной встроенной в VTube Studio модели «Одна из встроенных в VTubeStudio моделей</p>" data-image="https://habrastorage.org/getpro/habr/upload_files/569/5b3/df5/5695b3df54758792dd1b3723ad11c5e9.jpg" data-abbr="Hiyori" data-image-width="1280" data-image-height="720">Hiyori Momose» и никто автора за это особо не критиковал =)

LLM

В качестве LLM, Large Language Model, большая языковая модель – текстовая генеративная нейросеть</p><p></p>" data-abbr="ллмки">ЛЛМки я решил использовать мой ранее рассмотренный FRED‑T5. С того времени появилось много крутых файн‑тюнов модели, наиболее классными мне показались инструкт‑фреды от SiberianSoft. Отдельное внимание здесь хочу уделить Денчику, эксперту по фредам и вообще ллм в целом, который очень помог мне разобраться, огромное и человеческое ему спасибо!

Важным дополнением будет тот факт, что, как вариант, ллмку удобно будет запихать на докер, ведь так мы сможем удобно навешивать любую ллм независимо от платформы. Интерфейс взаимодействия с центральной программой можно сделать через сеть методом синхронизации, например, с помощью Python SyncManager.

Где GPT-4? Почему не OpenAI? Почему не Лама? Что за фред такой?

На момент создания нейростримерши (а это было давно) автор (да‑да, я) был не достаточно удовлетворен модерацией от API OpenAI. Дело в том, что в майнкрафте достаточно много токсиков, а нейросеть на тот момент, скажем так, «скучненько» отрабатывала токсичные запросы, а ведь именно на API OpenAI я пытался вначале строить весь пайплайн. Кроме того, я не абы‑кто, а великий студент, живущий в съемной однушке, не моё это царское дело тратить какие‑то сущие доллары на токены GPT-4 (тогда вообще была только GPT-3.5) API и покупать 10xH100 для Процесс исполнения обученных моделей машинного обучения для получения предсказаний на данных, поданных на вход модели </p>" data-abbr="инференс">инференса ламы 9999b...

Конечно, Llama, mistral&mixtral, ChatGPT Популярные большие языковые модели ИИ</p>" data-abbr="ламы, мистрали, чатжпт ">ламы, мистрали, чатжпт (и пр.) явно будут поумнее, чем Фред, однако мы ведь делаем не сверхумный чат‑бот, знающий всё обо всём. Для прототипа нам бы сгодилась весёлая тролль‑балаболка чуть лучше ранних версий Яндекс Алисы, которая будет необязательно понимать, что происходит, но поддерживать диалог и временами выдавать какие‑нибудь весёлые и иногда странные фразочки, а Фред, как мы убедились, даже без fine-tune, дообучение языковой модели на специализированную задачу</p>" data-abbr="файнтюна">файнтюна это умеет очень круто! Кроме того, Фред выдавал и «эмоции» по заданной мной инструкции, поэтому давайте попробуем поработать именно с ним.

Тем не менее, если в будущем этот проект вдруг станет популярным, естественно, я сменю Фреда на более крутую и умную модель и задействую больше ресурсов, чем сейчас. На случай, если в будущем фред вдруг эволюционировал, стал самым сильным ИИ, захватил мир и читает эту статью: дружище, я пошутил, никто тебя менять не собирался, это была всего лишь ШУТКА:)

Предварительная модерация сообщений (антибан)

А как вы хотели? Если вы читали мою прошлую статью, вы, наверное, понимаете, что Фред может сказануть что‑то «очень не очень», поэтому тут без вариантов нужна модерация. Перебор списком слов? Нее, слишком скучно (можно добавить как дополнительный этап, но точно не как основной). Конечно же сделаем по максимуму: зарубим классификацию по токсичности фраз как пользователей, так и нейросети, а ещё, чтобы было веселее, будем закидывать это как‑нибудь в prompt – входные данные для генеративной нейросети</p>" data-abbr="промпт">промпт, чтобы нейронка получала инфу про токсика в виде чего‑то такого: «Данный пользователь рассуждает на тему расизма и использует вульгарную лексику». Классификаторов есть уйма, например, от s‑nlp или apanc. Большинство распространяются под лицензией <strong>Creative Commons</strong></p>" data-abbr="CC">CC BY‑NC‑SA, на первое время (для прототипа) пойдёт, а, если разрастётся, несложно и свой написать или, может, к тому времени уже что‑то более открытое выкатят.

Центральный скрипт управления

Итак, когда я с горем пополам прикинул примерный стек технологий, надо придумать, как удержать в узде этих лебедей, раков и щук. (можно подумать, что под раками я подразумеваю игроков, но не совсем, я использую отсылку на эту пословицу как метафору, в том смысле, что мы имеем дело со слишком разными технологиями)

Как я уже заметил ранее, разумно будет писать центральный скрипт на Python. К Ютубу обращаемся через Google YouTube Data API, с модом в игре у нас мост Py4j, с OBS (стриминговая программа) и VTube Studio можно связаться через WebSocket API. Для хранения контекста диалога и данных о пользователях будем юзать БД (базу данных) sqlite и встроенный интерфейс работы с ней в Python.

Так как имеем дело со множеством высоконагруженных отдельных узлов, будем использовать мультипроцессорную архитектуру Python (просто напишем скрипт для связи с каждой из частей и погрузим каждый скрипт в отдельный процесс), и свяжем эти процессы через общие очереди (multiprocessing.queue) и пространства имён (multiprocessing.namespace) и будем передавать их как аргументы в каждый процесс при старте. По большей части асинхронное программирование реализовано не будет, потому что автор создаёт прототип и главная цель — чтобы оно вообще всё как‑то работало, а улучшать уже можно будет потом. Мультипроцессинг здесь — костыльное и неоптимизированное решение, но сгодящееся для прототипа.

В главный скрипт, кроме спавнера вспомогательных процессов, также должны войти системы выбора комментариев (не на все же сообщения отвечать), что‑то вроде <strong>Retrieval</strong>-<strong>Augmented</strong> <strong>Generation</strong> </p>" data-abbr="RAG">RAG (связанная с База данных</p>" data-abbr="БД">БД система, которая будет дополнять промпт в зависимости от инфы о пользователе и других данных) и система получения и отправки сообщений для Ютуба и Твитча (чем больше поддерживаемых платформ — тем лучше).

На этом этапе я выкатил что‑то вроде схемы стека технологий, чтобы сформировать общее представление того, что мы делаем.

Так, всё! Устали мы от нудной теории! Перейдём же, наконец, к практике! Начнём, пожалуй, с игровой части, для меня это самое сложное... (естественно, лучше начинать с простого, но в этом случае я не знал, смогу ли вообще это сделать, поэтому и начал с самого сложного для меня)

Хардкод на Java с нуля: поехали 😎

|

Сразу скажу, что Код в кавычках означает говнокод, шизокод и вообще всё самое ужасное, что можно отнести к коду</p>" data-abbr=""код"">«код», который будет представлен далее, по большей части для прототипирования. Не стоит его оценивать или считать за образец, он может быть полезен только тем, кому будет интересно повторить мой опыт, а не для «искателей чужих ошибок»)) В коде вы можете увидеть огромные закоментированные свалки, не обращайте внимания, т. к. у меня был выбор либо публиковать код, либо нет. Я никак не форматировал его и не подготавливал к выводу «в свет» и потому не стеснялся оставлять там костыли и другие неприятные вещи, например, принты для отладка</p>" data-abbr="дебага">дебага. Однако кое‑что я всё‑таки форматнул, но эту особенность заметят только самые внимательные =) Если фрагмент с кодом называется «Кодопомойка» — значит это просто свалка функций. Может быть интересно тем, кто хочет сам разобраться в том, как технически моя лабуда работает. «Кодопомойка+» будет означать, что к каким‑то функциям я заботливо добавил парочку комментариев. |

Про GitHub...

Ээээ.... Что же мне сказать по поводу GitHub... Вернее... Про публикацию моего всего текущего кода на нём... Как бы по-мягче... Сразу скажу, кое-что таки да я выгрузил.

Скажем так. Если эта статья делалась около месяца — то, если бы я выпускал полный проект на GitHub — код бы там вышел через 10 лет, а статья — никогда. Ну камон... Мой разрозненный бредокод — немного не то, что принято выкладывать на такие площадки, как GitHub. В то же время, мне очень хотелось этим всем поделиться, не прикладывая ещё более титанических усилий и не нарушая мой «тунеядский» ритм работы... Для GitHub, по-хорошему, нужна четкая структура проекта, а я не хотел заморачиваться, так как у меня часть системы на Docker и проект PyСharm на винде, в которых удобно разрабатывать и дорабатывать, а виртуальная стримерша — это такая штука, которую постоянно надо дорабатывать. Несмотря на месяцы работы, я пока даже близко не подошёл к моменту, когда можно «закончить» разработку какой‑то системы и выдать «релиз». По крайней мере, мне так кажется... Но, в будущем, быть может, я захочу привести проект к более‑менее «публикационному» для GitHub виду (например, запихаю всё на Docker).

Да, можно было бы выгрузить некоторые обособленные модули — например, тот же решатор капч, или текущую версию моего форка AltoClef'a. Вот это — уже совсем другой разговор, и для портфолио может быть полезно! Они уже лежат на моём гите, вот только от этого вряд ли поменяется тот факт, что там всё ещё свалко-безобразный код...

Дорабатываем мод для игры

Больше всего я сомневался насчет своих навыков по части разработки Java (их не было), а из Объектно-ориентированное программирование</p>" data-abbr="ООП">ООП я серьезно мутил что‑то только на C#, поэтому первым делом решено было допилить нужный мне мод для Minecraft! Как мы выше условились, за мод берём AltoClef. Открывам IntelliJ Idea Community, скачиваем репу и поехали в путь‑дорогу. Ну или поползли, в моем случае... После недели маянья с настройкой и запуска в gradle (как никак у человека опыта в Джаве примерно ноль), кое‑как я добился сборки и запуска проекта по исходникам.

Код и всё такое (Java)

Заходим в гости к нашему проекту AltoClef в IntelliJ. Смотрим, как тут всё устроено.

Как видим, тут у нас реализована task‑система и в теории с написанием скрипта автоматической игры не должно возникнуть сложностей. Красным выделено то, что насоздавал я. Итак, создаем класс таска, который будет реализовывать, я покажу на примере SkyWarsTask. Далее пишем туда код. Код я писал на основе TerminatorTask, поэтому не удивляйтесь свалке комментариев. После написания кода класса нужно ещё добавить соответствующую команду в обработчик команд и привязать к ней созданный класс таска, но эту часть я сюда не вставлял, потому что это не особо интересно.

Кодопомойка SkyWarsTask.java

package adris.altoclef.tasks.stupid;

import adris.altoclef.AltoClef;

import adris.altoclef.Debug;

import adris.altoclef.TaskCatalogue;

import adris.altoclef.eventbus.EventBus;

import adris.altoclef.eventbus.Subscription;

import adris.altoclef.eventbus.events.BlockPlaceEvent;

import adris.altoclef.tasks.container.LootContainerTask;

import adris.altoclef.tasks.entity.KillPlayerTask;

import adris.altoclef.tasks.entity.ShootArrowSimpleProjectileTask;

import adris.altoclef.tasks.misc.EquipArmorTask;

import adris.altoclef.tasks.movement.PickupDroppedItemTask;

import adris.altoclef.tasks.movement.SearchChunksExploreTask;

import adris.altoclef.tasks.movement.ThrowEnderPearlSimpleProjectileTask;

import adris.altoclef.tasks.resources.CollectFoodTask;

import adris.altoclef.tasksystem.Task;

import adris.altoclef.ui.MessagePriority;

import adris.altoclef.util.ItemTarget;

import adris.altoclef.util.helpers.*;

import adris.altoclef.util.time.TimerGame;

import baritone.api.utils.input.Input;

import net.minecraft.block.Block;

import net.minecraft.block.BlockState;

import net.minecraft.block.Blocks;

import net.minecraft.entity.Entity;

import net.minecraft.entity.ItemEntity;

import net.minecraft.entity.effect.StatusEffects;

import net.minecraft.entity.player.PlayerEntity;

import net.minecraft.item.Item;

import net.minecraft.item.Items;

import net.minecraft.util.math.BlockPos;

import net.minecraft.util.math.ChunkPos;

import net.minecraft.util.math.Vec3d;

import net.minecraft.util.math.Vec3i;

import java.util.ArrayList;

import java.util.Arrays;

import java.util.List;

import java.util.Optional;

import java.util.function.Predicate;

import java.util.stream.Stream;

/**

* SlotHandler 39 timer override изменил

*/

public class SkyWarsTask extends Task {

private static final int FEAR_SEE_DISTANCE = 30;

private static final int FEAR_DISTANCE = 20;

private static final int RUN_AWAY_DISTANCE = 80;

private static final int MIN_BUILDING_BLOCKS = 10;

private static final int PREFERRED_BUILDING_BLOCKS = 60;

private static Item[] GEAR_TO_COLLECT = new Item[]{

Items.DIAMOND_PICKAXE, Items.DIAMOND_SHOVEL, Items.DIAMOND_SWORD, Items.WATER_BUCKET

};

private final Task _prepareDiamondMiningEquipmentTask = TaskCatalogue.getSquashedItemTask(

new ItemTarget(Items.IRON_PICKAXE, 3), new ItemTarget(Items.IRON_SWORD, 1)

);

private final Task _foodTask = new CollectFoodTask(80);

private final TimerGame _runAwayExtraTime = new TimerGame(10);

private final Predicate<PlayerEntity> _canTerminate;

private final ScanChunksInRadius _scanTask;

private final TimerGame _funnyMessageTimer = new TimerGame(10);

private final TimerGame _performExtraActionsTimer = new TimerGame(2.5);

private Vec3d _closestPlayerLastPos;

private Vec3d _closestPlayerLastObservePos;

private double _closestDistance;

private Task _runAwayTask;

private String _currentVisibleTarget;

private boolean _forceWait = false;

private boolean _isEatingStrength = false;

private boolean _isEatingGapple = false;

private final TimerGame _eatingGappleTimer = new TimerGame(3);

private Task _armorTask;

private Task _shootArrowTask;

private Task _lootTask;//new CataloguedResourceTask(new ItemTarget(Items.ENDER_PEARL));

private Task _pickupTask;

private boolean _finishOnKilled = false;

private static Item[] _itemsToLoot = ItemHelper.DIAMOND_TOOLS;

private List<Item> lootableItems(AltoClef mod) {

List<Item> lootable = new ArrayList<>();

lootable.addAll(ArmorAndToolsNeeded(mod));

//lootable.addAll(Arrays.stream(ItemHelper.NETHERITE_TOOLS).toList());

//lootable.addAll(Arrays.stream(ItemHelper.DIAMOND_TOOLS).toList());

//lootable.addAll(Arrays.stream(ItemHelper.HelmetsTopPriority).toList());

//lootable.addAll(Arrays.stream(ItemHelper.ChestplatesTopPriority).toList());

//lootable.addAll(Arrays.stream(ItemHelper.LeggingsTopPriority).toList());

//lootable.addAll(Arrays.stream(ItemHelper.BootsTopPriority).toList());

lootable.addAll(Arrays.stream(ItemHelper.PLANKS).toList());

lootable.add(Items.GOLDEN_APPLE);

lootable.add(Items.ENCHANTED_GOLDEN_APPLE);

lootable.add(Items.GOLDEN_CARROT);

lootable.add(Items.STONE);

lootable.add(Items.BOW);

lootable.add(Items.ARROW);

lootable.add(Items.GUNPOWDER);

lootable.add(Items.ENDER_PEARL);

if (!mod.getItemStorage().hasItemInventoryOnly(Items.WATER_BUCKET)) {

lootable.add(Items.WATER_BUCKET);}

return lootable;

}

private Subscription<BlockPlaceEvent> _blockPlaceSubscription;

public SkyWarsTask(BlockPos center, double scanRadius, Predicate<PlayerEntity> canTerminate, boolean FinishOnKilled) {

_canTerminate = canTerminate;

_finishOnKilled = FinishOnKilled;

_scanTask = new ScanChunksInRadius(center, scanRadius);

}

public SkyWarsTask(BlockPos center, double scanRadius, boolean FinishOnKilled) {

this(center, scanRadius, accept -> true, FinishOnKilled);

}

private static final Block[] TO_SCAN = Stream.concat(Arrays.stream(new Block[]{Blocks.CHEST, Blocks.TRAPPED_CHEST, Blocks.BARREL}), Arrays.stream(ItemHelper.itemsToBlocks(ItemHelper.SHULKER_BOXES))).toArray(Block[]::new);

@Override

protected void onStart(AltoClef mod) {

//Debug.logMessage("стейт = "+mod.getInfoSender().getState());

mod.getInfoSender().setState(String.valueOf(mod.getItemStorage().hasItem(Items.ENDER_PEARL)));

mod.getBehaviour().push();

mod.getBlockTracker().trackBlock(TO_SCAN);

mod.getBehaviour().setForceFieldPlayers(true);

//mod.getExtraBaritoneSettings()

_blockPlaceSubscription = EventBus.subscribe(BlockPlaceEvent.class, evt -> {

OnBlockPlace(mod,evt.blockPos,evt.blockState);

});

//Debug.logMessage("мдааа");

//AddNearestPlayerToFriends(mod,10);

}

protected void OnBlockPlace(AltoClef mod, BlockPos blockPos, BlockState blockState){

if(this._forceWait == false && mod.getClientBaritone().getCustomGoalProcess().isActive() &

mod.getPlayer().isSneaking() &

mod.getPlayer().getBlockPos().isWithinDistance(new Vec3i(blockPos.getX(),blockPos.getY(),blockPos.getZ()),3) ){

//mod.getClientBaritone().getGetToBlockProcess().

//Debug.logMessage("!!Блок поставил я!");

new Thread(() ->{

int ping = 100;

//try{

// ping = mod.getPlayer().networkHandler.getPlayerListEntry(mod.getPlayer().getUuid()).getLatency();}

//catch (NullPointerException e){e.printStackTrace(); ping = 500;}

//Goal goal = mod.getClientBaritone().getCustomGoalProcess().getGoal();

//boolean oldval = mod.getClientBaritoneSettings().allowPlace.value;

//mod.getClientBaritoneSettings().

//mod.getClientBaritone().getCustomGoalProcess().setGoal(new GoalBlock(0,0,0));

//mod.getClientBaritoneSettings().allowPlace.value = false;

this._forceWait = true;

//if(mod.getClientBaritone().getPathingBehavior().isPathing()) # БЫЛО ДО ЭТОГО!

//mod.getClientBaritone().getPathingBehavior().forceCancel();

//mod.getClientBaritone().getInputOverrideHandler().setInputForceState(Input.SNEAK,true);

//mod.getClientBaritone().getInputOverrideHandler().setInputForceState(Input.MOVE_FORWARD,true);

mod.getInputControls().hold(Input.SNEAK);

mod.getInputControls().hold(Input.MOVE_FORWARD);

mod.getInputControls().hold(Input.CLICK_RIGHT);

//Debug.logMessage("Остановка.. ");

//mod.getMobDefenseChain()._doingFunkyStuff =true;

sleepSec(0.4);

//mod.getClientBaritone().getInputOverrideHandler().setInputForceState(Input.SNEAK,false);

//mod.getClientBaritone().getInputOverrideHandler().setInputForceState(Input.MOVE_FORWARD,false);

mod.getInputControls().release(Input.CLICK_RIGHT);

mod.getInputControls().release(Input.SNEAK);

mod.getInputControls().release(Input.MOVE_FORWARD);

//mod.getPlayer().

Debug.logMessage("Блок поставила я! "+WorldHelper.isAir(mod,blockPos) + " ыы пинг "+ping);

if(WorldHelper.isAir(mod,blockPos)){

Debug.logMessage("Блок на позиции "+blockPos + " не поставился! пинг "+ping);

//for(int i = 0;i<10;i++){

//LookHelper.SmoothLookDirectionaly(mod,0.0015f);

mod.getInputControls().hold(Input.SNEAK);

mod.getInputControls().hold(Input.MOVE_BACK);

mod.getInputControls().hold(Input.CLICK_RIGHT);

sleepSec(6);

//sleepSec(3+((30+ping)*2)/1000);

mod.getInputControls().release(Input.MOVE_BACK);

sleepSec(1);

mod.getInputControls().release(Input.SNEAK);

mod.getInputControls().release(Input.CLICK_RIGHT);

//}

//sleepSec(4);

}

//mod.getBehaviour().

//mod.getMobDefenseChain()._doingFunkyStuff =false;

this._forceWait = false;

//mod.getClientBaritoneSettings().allowPlace.value = oldval;

//if(mod.getClientBaritone().getCustomGoalProcess().isActive()){

// mod.getClientBaritone().getCustomGoalProcess().setGoalAndPath(goal);

//}

//try{

// mod.getClientBaritone().getCustomGoalProcess().wait(200);

//} catch (InterruptedException e) {

// e.printStackTrace();

//}

//mod.getClientBaritone().getBuilderProcess().pause();

//sleepSec(0.5);

//mod.getClientBaritone().getBuilderProcess().resume();

}).start();

}

}

private BlockPos _lastLootPos;

@Override

protected Task onTick(AltoClef mod){

Optional<Entity> closest = mod.getEntityTracker().getClosestEntity(mod.getPlayer().getPos(), toPunk -> shouldPunk(mod, (PlayerEntity) toPunk), PlayerEntity.class);

boolean TargetIsNear = false;

if(InputHelper.isKeyPressed(71) && mod.getClientBaritone().getPathingBehavior().estimatedTicksToGoal().isPresent())

Debug.logMessage("Эвристика **стика "+mod.getClientBaritone().getPathingBehavior().estimatedTicksToGoal().get());

if (closest.isPresent()) {

_closestPlayerLastPos = closest.get().getPos();

_closestPlayerLastObservePos = mod.getPlayer().getPos();

_closestDistance = _closestPlayerLastPos.distanceTo(_closestPlayerLastObservePos);

if (_closestDistance<=8 & mod.getEntityTracker().isEntityReachable(closest.get())) TargetIsNear = true;

//Debug.logMessage("дистанция"+_closestDistance);

}

int ping = 100;

//try{ping = mod.getPlayer().networkHandler.getPlayerListEntry(mod.getPlayer().getUuid()).getLatency();}

//catch (NullPointerException e){e.printStackTrace(); ping = 500;}

//if(InputHelper.isKeyPressed(71)){

// Debug.logMessage("Ping = "+ping);//"PlusY "+PlusY + " Y "+_targetRotation.getPitch());}

//}

if(ping>499){

setDebugState("ИСПЫТЫВАЕМ ЛЮТЫЙ ПИНГ = "+ping+"!!! Ожидаем окончания этого ..");

return null;}

//Predicate<BlockPos> validContainer = blockPos -> {

// if(!WorldHelper.isUnopenedChest(mod, blockPos)|| !mod.getPlayer().getBlockPos().isWithinDistance(blockPos, 15))//!WorldHelper.isUnopenedChest(mod, blockPos)||

// return false;

// else {

// return true;

// }

//};

if(_forceWait && !TargetIsNear){

//Debug.logMessage("Ждемс...");

return null;}

if (shouldForce(mod, _shootArrowTask)) {

return _shootArrowTask;

}

if(!TargetIsNear) {

//ОДЕВАЕМСЯ КАК ПОЛОЖЕНО!!!

//Item[] helmetsTopPriority = new Item[] {Items.NETHERITE_HELMET, Items.DIAMOND_HELMET, Items.IRON_HELMET, Items.CHAINMAIL_HELMET, Items.GOLDEN_HELMET, Items.LEATHER_HELMET};

//if(InputHelper.isKeyPressed(71))Debug.logMessage("hasHelmetLevel ="+hasHelmetLevel+" helmetLevel="+helmetLevel);//"PlusY "+PlusY + " Y "+_targetRotation.getPitch());}

if (shouldForce(mod, _armorTask)) {

return _armorTask;

}

//if (shouldForce(mod, _pickupTask)) {

// return _pickupTask;

//}

boolean reachableLootCont = true;

if(_lastLootPos!=null) reachableLootCont = WorldHelper.canReach(mod,_lastLootPos);

if (reachableLootCont && shouldForce(mod, _lootTask)) {

return _lootTask;

}

if(_isEatingStrength)

_isEatingStrength = false;

//ЮЗАТЬ СМЕСЬ СИЛЫ

if(!mod.getPlayer().hasStatusEffect(StatusEffects.STRENGTH)&&mod.getItemStorage().hasItem(Items.GUNPOWDER)){

//mod.getItemStorage().getItem

if(LookHelper.tryAvoidingInteractable(mod,true)) {

setDebugState("Найдена смесь силы; надо понюхать");

mod.getSlotHandler().forceEquipItem(new Item[]{Items.GUNPOWDER}); //"true" because it's food

mod.getInputControls().hold(Input.CLICK_RIGHT);

//mod.getExtraBaritoneSettings().setInteractionPaused(true);

mod.getInputControls().release(Input.CLICK_RIGHT);

//mod.getExtraBaritoneSettings().setInteractionPaused(false);

_isEatingStrength = true;

}else{

setDebugState("Нюхаем смесь силы: меняем угол обзора чтобы не интерактить ни с какими блоками");

}

return null;

}

//

//ЖРАТЬ ЯБЛОЧКИ

boolean NeedEatGapple = !mod.getPlayer().hasStatusEffect(StatusEffects.ABSORPTION) || (mod.getPlayer().getHealth()<18&&_eatingGappleTimer.getDuration()>6);

if(NeedEatGapple&&mod.getItemStorage().hasItemInventoryOnly(Items.GOLDEN_APPLE,Items.ENCHANTED_GOLDEN_APPLE)){

if(LookHelper.tryAvoidingInteractable(mod) && !_isEatingGapple) {

setDebugState("Есть яблоко, почему бы не пожрать..");

//mod.getSlotHandler().forceEquipSlot(new Slot(0,0,0,0));

mod.getSlotHandler().forceEquipItem(new Item[]{Items.GOLDEN_APPLE,Items.ENCHANTED_GOLDEN_APPLE},true);//,true); //"true" because it's food

mod.getInputControls().hold(Input.CLICK_RIGHT);

//mod.getSlotHandler().wait();

mod.getExtraBaritoneSettings().setInteractionPaused(true);

_eatingGappleTimer.reset();

_isEatingGapple= true;

}

else{

if(_isEatingGapple && _eatingGappleTimer.elapsed()){

_isEatingGapple= false;

setDebugState("Яблоко не съелось! Попытка 2!");

}else{

setDebugState("Жрем геплы: меняем угол обзора чтобы не интерактить с сущностями");

}

}

return null;

}else{

if(_isEatingGapple){

mod.getInputControls().release(Input.CLICK_RIGHT);

mod.getExtraBaritoneSettings().setInteractionPaused(false);

_isEatingGapple = false;}

}

//if(_pickupTask.)

//if(mod.getPlayer().getEf){}

//ШЛЕМ

int armorEquipNeed = IsArmorNeededToEquip(mod,ItemHelper.HelmetsTopPriority);

if (armorEquipNeed != -1){

_armorTask = new EquipArmorTask(true, Arrays.stream(ItemHelper.HelmetsTopPriority).toList().get(armorEquipNeed));

return _armorTask;

}

//ЧЕСТПЛЕЙТ

armorEquipNeed = IsArmorNeededToEquip(mod,ItemHelper.ChestplatesTopPriority);

if (armorEquipNeed != -1){

_armorTask = new EquipArmorTask(true, Arrays.stream(ItemHelper.ChestplatesTopPriority).toList().get(armorEquipNeed));

return _armorTask;

}

//ПЕНТС

armorEquipNeed = IsArmorNeededToEquip(mod,ItemHelper.LeggingsTopPriority);

if (armorEquipNeed != -1){

_armorTask = new EquipArmorTask(true, Arrays.stream(ItemHelper.LeggingsTopPriority).toList().get(armorEquipNeed));

return _armorTask;

}

//БУТС

armorEquipNeed = IsArmorNeededToEquip(mod,ItemHelper.BootsTopPriority);

if (armorEquipNeed != -1){

_armorTask = new EquipArmorTask(true, Arrays.stream(ItemHelper.BootsTopPriority).toList().get(armorEquipNeed));

return _armorTask;

}

//if (!StorageHelper.isArmorEquipped(mod, topHelmet )) {

// if (mod.getItemStorage().hasItem(topHelmet)) {

// _armorTask = new EquipArmorTask(true, topHelmet);

// return _armorTask;

// }

//}

//ТЕПЕРЬ ЛУТАЕМ СУНДУЧАРЫ!!!

//Optional<BlockPos> closestCont = mod.getBlockTracker().getNearestTracking(validContainer,TO_SCAN);

Optional<BlockPos> closestCont = mod.getBlockTracker().getNearestTracking(

blockPos -> WorldHelper.isUnopenedChest(mod, blockPos) &&

mod.getPlayer().getBlockPos().isWithinDistance(blockPos, 10)&&

WorldHelper.canReach(mod,blockPos), Blocks.CHEST) ;

if (closestCont.isPresent() && WorldHelper.canReach(mod,closestCont.get()) && TimersHelper.CanChestInteract()) {

setDebugState("Поиск ресурсов -> контейнеры:");

_lastLootPos = closestCont.get();

_lootTask = new LootContainerTask(closestCont.get(), lootableItems(mod));

//_lootTask = new MineAndCollectTask(new ItemTarget(Items.CHEST), new Block[]{Blocks.CHEST}, MiningRequirement.HAND);

return _lootTask;

}

//ПИКАЕМ ДРОП

for (Item check : lootableItems(mod)) {

if (mod.getEntityTracker().itemDropped(check)) {

Optional<ItemEntity> closestEnt = mod.getEntityTracker().getClosestItemDrop(

ent -> mod.getPlayer().getPos().isInRange(ent.getEyePos(), 10),check);

//

if(closestEnt.isPresent()) {

_pickupTask = new PickupDroppedItemTask(new ItemTarget(check), true);

return _pickupTask;

}

}

}

if(closest.isPresent() && ShouldBow(mod,closest.get())){

_shootArrowTask = new ShootArrowSimpleProjectileTask(closest.get());

return _shootArrowTask;

}

}else{

if(_isEatingGapple){

mod.getInputControls().release(Input.CLICK_RIGHT);

mod.getExtraBaritoneSettings().setInteractionPaused(false);

_isEatingGapple = false;}

}

if(closest.isPresent()){

setDebugState("УНИЧТОЖИТЬ");

PlayerEntity entity = (PlayerEntity) closest.get();

if(mod.getPlayer().distanceTo(entity)>10 && LookHelper.cleanLineOfSight(entity.getPos(),100)) {

if (mod.getItemStorage().getItemCount(Items.ENDER_PEARL) > 2){

return new ThrowEnderPearlSimpleProjectileTask(entity.getBlockPos().add(0, -0.5, 0));}

else if(ShouldBow(mod, entity)){

_shootArrowTask = new ShootArrowSimpleProjectileTask(entity);

return _shootArrowTask;

}

}

//tryDoFunnyMessageTo(mod, (PlayerEntity) entity);

return new KillPlayerTask(entity.getName().getString());

}

setDebugState("Поиск сущностей...");

_currentVisibleTarget = null;

if (_scanTask.failedSearch()) {

Debug.logMessage("Перегрузка поиска, восстановление...");

_scanTask.resetSearch(mod);

}

return _scanTask;

}

private Optional<BlockPos> locateClosestUnopenedChest(AltoClef mod) {

//if (WorldHelper.getCurrentDimension() != Dimension.OVERWORLD) {

// return Optional.empty();

//}

return mod.getBlockTracker().getNearestTracking(blockPos -> mod.getPlayer().getBlockPos().isWithinDistance(blockPos, 15), Blocks.CHEST);

//mod.getBlockTracker().getNearestTracking(blockPos -> WorldHelper.isUnopenedChest(mod, blockPos) && mod.getPlayer().getBlockPos().isWithinDistance(blockPos, 15), Blocks.CHEST);

}

@Override

protected void onStop(AltoClef mod, Task interruptTask) {

mod.getBehaviour().pop();

mod.getBlockTracker().stopTracking(TO_SCAN);

EventBus.unsubscribe(_blockPlaceSubscription);

}

@Override

protected boolean isEqual(Task other) {

return other instanceof SkyWarsTask;

}

@Override

protected String toDebugString() {

return "Активна игра в SkyWars";

}

private boolean ShouldBow(AltoClef mod, Entity target){

if(LookHelper.shootReady(mod,target)&&mod.getItemStorage().hasItem(Items.BOW) && (mod.getItemStorage().hasItem(Items.ARROW) || mod.getItemStorage().hasItem(Items.SPECTRAL_ARROW)))

{

return true; }else {return false;}

}

private List<Item> ArmorAndToolsNeeded(AltoClef mod) {

List<Item> Needed = new ArrayList<>();

//БРОНЯ

Needed.addAll(ItemsNeeded(mod,ItemHelper.HelmetsTopPriority));

Needed.addAll(ItemsNeeded(mod,ItemHelper.ChestplatesTopPriority));

Needed.addAll(ItemsNeeded(mod,ItemHelper.LeggingsTopPriority));

Needed.addAll(ItemsNeeded(mod,ItemHelper.BootsTopPriority));

//ИНСТРУМЕНТЫ

Needed.addAll(ItemsNeeded(mod,ItemHelper.SwordsTopPriority));

Needed.addAll(ItemsNeeded(mod,ItemHelper.AxesTopPriority));

Needed.addAll(ItemsNeeded(mod,ItemHelper.PickaxesTopPriority));

Needed.addAll(ItemsNeeded(mod,ItemHelper.ShovelsTopPriority));

Needed.addAll(ItemsNeeded(mod,ItemHelper.HoesTopPriority));

//Needed.addAll(ItemsNeeded(mod,ItemHelper.Tool));

return Needed;

}

private List<Item> ItemsNeeded(AltoClef mod,Item[] PriorityCheckArr){

List<Item> NeededItems = new ArrayList<>();

//NeededItems.add(Items.GOLDEN_APPLE);

int level = GetHighestItemLevel(mod,PriorityCheckArr);

int iii = 0;

for (Item i : PriorityCheckArr){

if(iii<level){

NeededItems.add(Arrays.stream(PriorityCheckArr).toList().get(iii));

}

iii++;

}

//NeededItems.addAll(Arrays.stream(ItemHelper.NETHERITE_TOOLS).toList());

return NeededItems;

}

private int GetHighestItemLevel(AltoClef mod,Item[] PriorityCheckArr){

int iii = 0;

int Level = 7;

for(Item i : PriorityCheckArr) {

if (StorageHelper.isArmorEquipped(mod, i) || mod.getItemStorage().hasItem(i)) {

if(Level>iii)

Level = iii;

}

iii++;

}

return Level;

}

private int IsArmorNeededToEquip(AltoClef mod, Item[] ArmorsTopPriority){

int iii = 0;

int Level = -1;

int hasLevel = 7;

//if()

for(Item armorItem : ArmorsTopPriority){

if (StorageHelper.isArmorEquipped(mod, armorItem )) {

Level = iii;

}

if (mod.getItemStorage().hasItem(armorItem)) {

if(hasLevel>iii)

hasLevel = iii;

}

iii++;

}

if(Level==-1)Level=7;

if (hasLevel<Level){

return hasLevel;

}else{ return -1;}

}

private boolean isReadyToPunk(AltoClef mod) {

if (mod.getPlayer().getHealth() <= 5) return false; // We need to heal.

return StorageHelper.isArmorEquippedAll(mod, ItemHelper.DIAMOND_ARMORS) && mod.getItemStorage().hasItem(Items.DIAMOND_SWORD);

}

private boolean shouldPunk(AltoClef mod, PlayerEntity player) {

if (player == null || player.isDead() || !player.isAlive()) return false;

if (player.isCreative() || player.isSpectator()) return false;

//if (!WorldHelper.canReach(mod,player.getBlockPos())) return false;

//mod.getEntityTracker().getCloseEntities().

return !mod.getButler().isUserAuthorized(player.getName().getString());// && _canTerminate.test(player);

}

private void tryDoFunnyMessageTo(AltoClef mod, PlayerEntity player) {

if (_funnyMessageTimer.elapsed()) {

if (LookHelper.seesPlayer(player, mod.getPlayer(), 80)) {

String name = player.getName().getString();

if (_currentVisibleTarget == null || !_currentVisibleTarget.equals(name)) {

_currentVisibleTarget = name;

_funnyMessageTimer.reset();

String funnyMessage = getRandomFunnyMessage();

mod.getMessageSender().enqueueWhisper(name, funnyMessage, MessagePriority.ASAP);

}

}

}

}

private String getRandomFunnyMessage() {

return "Советую спрятаться, кид";

}

private static boolean shouldForce(AltoClef mod, Task task) {

return task != null && task.isActive() && !task.isFinished(mod);

}

private class ScanChunksInRadius extends SearchChunksExploreTask {

private final BlockPos _center;

private final double _radius;

public ScanChunksInRadius(BlockPos center, double radius) {

_center = center;

_radius = radius;

}

@Override

protected boolean isChunkWithinSearchSpace(AltoClef mod, ChunkPos pos) {

double cx = (pos.getStartX() + pos.getEndX()) / 2.0;

double cz = (pos.getStartZ() + pos.getEndZ()) / 2.0;

double dx = _center.getX() - cx,

dz = _center.getZ() - cz;

return dx * dx + dz * dz < _radius * _radius;

}

@Override

protected ChunkPos getBestChunkOverride(AltoClef mod, List<ChunkPos> chunks) {

// Prioritise the chunk we last saw a player in.

if (_closestPlayerLastPos != null) {

double lowestScore = Double.POSITIVE_INFINITY;

ChunkPos bestChunk = null;

for (ChunkPos toSearch : chunks) {

double cx = (toSearch.getStartX() + toSearch.getEndX() + 1) / 2.0, cz = (toSearch.getStartZ() + toSearch.getEndZ() + 1) / 2.0;

double px = mod.getPlayer().getX(), pz = mod.getPlayer().getZ();

double distanceSq = (cx - px) * (cx - px) + (cz - pz) * (cz - pz);

double pdx = _closestPlayerLastPos.getX() - cx, pdz = _closestPlayerLastPos.getZ() - cz;

double distanceToLastPlayerPos = pdx * pdx + pdz * pdz;

Vec3d direction = _closestPlayerLastPos.subtract(_closestPlayerLastObservePos).multiply(1, 0, 1).normalize();

double dirx = direction.x, dirz = direction.z;

double correctDistance = pdx * dirx + pdz * dirz;

double tempX = dirx * correctDistance,

tempZ = dirz * correctDistance;

double perpendicularDistance = ((pdx - tempX) * (pdx - tempX)) + ((pdz - tempZ) * (pdz - tempZ));

double score = distanceSq + distanceToLastPlayerPos * 0.6 - correctDistance * 2 + perpendicularDistance * 0.5;

if (score < lowestScore) {

lowestScore = score;

bestChunk = toSearch;

}

}

return bestChunk;

}

return super.getBestChunkOverride(mod, chunks);

}

@Override

protected boolean isEqual(Task other) {

if (other instanceof ScanChunksInRadius scan) {

return scan._center.equals(_center) && Math.abs(scan._radius - _radius) <= 1;

}

return false;

}

@Override

protected String toDebugString() {

return "Сканирование территории...";

}

}

private static void sleepSec(double seconds) {

try {

Thread.sleep((int) (1000 * seconds));

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

После того, как разобрались со скриптом, сделаем функцию для связи с главным Python при помощи Py4j. Для начала реализуем интерфейс PythonCallback для Py4j обратного вызова методов Python из Java‑части.

Кодопомойка PythonCallback.java

package adris.altoclef;

import py4j.GatewayServer;

import py4j.PythonClient;

import py4j.ClientServer;

import java.util.Map;

public interface PythonCallback {

public Boolean isStarted();

public String onChatMessage(String s);

public Map<String,String> onVerifedChat(Map<String,String> s);

public Map<String,String> onUpdateServerInfo(Map<String,String> s);

public void onDeath(String s);

public void onKill(String s);

public void onDamage(float s);

public void onCaptchaSolveRequest(byte[] image_bytes);

}

Теперь сделаем класс с Java‑функциями, которые можно будет вызывать из Python‑части. Внедряем функционала по максиму, чтобы можно было получить как список всех задач бота, так и координаты, на которых стоит игрок. Дополнительно в коде я внедрил функцию определения «экранного» расстояния между целью Baritone (например, при задаче подойти к определенному блоку или сущности, мод устанавливает этот блок как цель в Baritone) и курсором с помощью расчета угла поворота до этой цели. Дальше нам это понадобится при работе с VTube Studio.

Кодопомойка Py4jEntryPoint.java

package adris.altoclef;

import adris.altoclef.butler.WhisperChecker;

import adris.altoclef.chains.DeathMenuChain;

import adris.altoclef.tasksystem.Task;

import adris.altoclef.ui.MessagePriority;

import adris.altoclef.util.helpers.BaritoneHelper;

import adris.altoclef.util.helpers.LookHelper;

import adris.altoclef.util.helpers.WorldHelper;

import adris.altoclef.util.time.TimerGame;

import adris.altoclef.util.time.TimerReal;

import baritone.api.pathing.calc.IPath;

import baritone.api.pathing.goals.Goal;

import baritone.api.utils.BetterBlockPos;

import baritone.api.utils.Rotation;

import net.minecraft.client.MinecraftClient;

import net.minecraft.client.option.Perspective;

import net.minecraft.entity.Entity;

import net.minecraft.entity.FallingBlockEntity;

import net.minecraft.item.ItemStack;

import net.minecraft.item.Items;

import net.minecraft.util.math.BlockPos;

import net.minecraft.util.math.Vec3d;

import org.lwjgl.system.CallbackI;

import py4j.PythonClient;

import py4j.ClientServer;

import py4j.GatewayServer;

import java.util.*;

public class Py4jEntryPoint {

AltoClef _mod;

PythonCallback _cb;

public Py4jEntryPoint(AltoClef mod)

{

_mod = mod;

resetValues();

}

public void resetValues(){

CentralGameInfoDict.put("server", "universal");

CentralGameInfoDict.put("serverMode", "survival");

CentralGameInfoDict.put("chatType", "lobby");

//if(DeathMenuChain.ServerIp!=null)

// if(!DeathMenuChain.ServerIp.isEmpty())

// CentralGameInfoDict.put("server", DeathMenuChain.ServerIp);

}

public void setPerspective(int perspectiveNum) {

//Perspective perspective = Perspective.values()[perspectiveNum] быстрое решение но нужна проверка

Perspective perspective = Perspective.FIRST_PERSON;

switch (perspectiveNum){

case 0:

perspective = Perspective.FIRST_PERSON;

break;

case 1:

perspective = Perspective.THIRD_PERSON_BACK;

break;

case 2:

perspective = Perspective.THIRD_PERSON_FRONT;

break;

default:

Debug.logMessage("запрошена неизвестная перспектива: "+perspectiveNum);

}

MinecraftClient.getInstance().options.setPerspective(perspective);

}

//public Map<String,String> getIngameInfo(){

// Map<String,String> result_dict = new HashMap<>();

// result_dict.put("task_chain",getTaskChainString());

// result_dict.put("ground_block",getGroundBlock());

// result_dict.put("held_item",getHeldItem());

// return result_dict;

//}

public String getTaskChainString (){

String tasks_string = "Ничего не происходит";

try {

if (_mod.getTaskRunner().getCurrentTaskChain() != null) {

List<Task> tasks = _mod.getTaskRunner().getCurrentTaskChain().getTasks();

if (tasks.size() > 0) {

tasks_string = "";

int i = 0;

for (Task task : tasks) {

tasks_string += (i+1)+") "+task.toString();

if(i<tasks.size()-1){tasks_string+="n";}

i++;

}

}

}

}catch (Exception e) {tasks_string = "Ошибка при получении списка игровых подзадач! Скрипт сломался!";}

return tasks_string;

}

public String getGroundBlock (){

if (AltoClef.inGame() && _mod.getPlayer()!=null && _mod.getWorld() != null) {

//MinecraftClient.getInstance().options.setPerspective(Perspective.FIRST_PERSON);

//MinecraftClient.getInstance().options.setPerspective(Perspective.THIRD_PERSON_BACK); //ЗАДНИЦА

//MinecraftClient.getInstance().options.setPerspective(Perspective.THIRD_PERSON_FRONT); //ВСЕМ ПРИВЕТ

String blockName = WorldHelper.getGroundBlockName(_mod);

if(_mod.getPlayer().isOnGround() && blockName.equals("воздух")){

return "земля";

}else{

return blockName;

}

}else{

return "пустота";

}

}

public String getHeldItem(){

if (AltoClef.inGame() && _mod.getPlayer()!=null && _mod.getPlayer().getItemsHand()!=null) {

for (ItemStack item : _mod.getPlayer().getItemsHand()){

if(item.getItem()!=null){

String itemName = item.getItem().getName().getString().toLowerCase();

if(!itemName.equals("воздух")){

if(item.hasCustomName()) {

String itemCustomName = item.getName().getString().toLowerCase();

return itemName+" (с названием " + itemCustomName+")";

}

//Debug.logMessage("ITEM CUSTOM NAME = "+itemCustomName);

return itemName;

}

}

}

return "ничего";

}else{

return "ничего";

}

}

public String getInfo(){

String result = "";

for (String value : CentralGameInfoDict.values()){

if(!value.isBlank()){

result+=value+" ";

}

}

if(callbackstarted)

result+="CB=ON";

return result.strip();

}

public String getInfo(String key){return getInfo(key,"");}

public String getInfo(String key, String defolt){

return CentralGameInfoDict.getOrDefault(key, defolt);

}

public void InitPythonCallback(){

_cb = (PythonCallback) _mod.getGateway().getPythonServerEntryPoint(new Class[] {PythonCallback.class});

}

boolean callbackstarted = false;

public boolean IsCallbackServerStarted(){

boolean result = false;

try {

_cb.isStarted();

result = true;

}catch (Exception e) {}

callbackstarted = result;

return result;

}

String _state = "starting";

public String saayHellooo(String name) {

return "Hello, " + name + "!" + Items.SOUL_SAND.getName().getString();

}

public String getState(){

return _state;

}

public void setState(String state){

_state = state;

}

public static boolean inGame(){

return AltoClef.inGame();

}

public void onStrongChatMessage(WhisperChecker.MessageResult message){

if(IsCallbackServerStarted()) {

Map<String,String> messageDict = new HashMap<>();

//if()

messageDict.put("user",message.from);

messageDict.put("msg",message.message);

if(message.clan != null) messageDict.put("clan",message.clan);

if(message.team != null) messageDict.put("team",message.team);

if(message.starter_prefix != null) messageDict.put("pre",message.starter_prefix);

if(message.rank != null) messageDict.put("rank",message.rank);

if(message.serverExactPrediction != null) messageDict.put("precision",message.serverExactPrediction);

if(message.server != null) messageDict.put("server",message.server);

if(message.serverMode != null) messageDict.put("serverMode",message.serverMode);

if(message.chat_type != null) messageDict.put("chat_type",message.chat_type);

_cb.onVerifedChat(messageDict);

}

}

public void ChatMessage(String msg){

if(AltoClef.inGame())

_mod.getMessageSender().enqueueChat(msg, MessagePriority.ASAP);

//Object myPythonClass = _mod.getGateway().getPythonServerEntryPoint(new Class[]{MyPythonClass.class});

}

public void RunInnerCommand(String command){

AltoClef.getCommandExecutor().execute(command); //@stop

}

public void CaptchaSolvedSend(String msg, double accuracy){

if(AltoClef.inGame()) {

Debug.logMessage("GOT CAPTCHA SOLVING! >"+msg+"< acc="+accuracy);

_mod.getMessageSender().enqueueChat(msg, MessagePriority.ASAP);

}

//Object myPythonClass = _mod.getGateway().getPythonServerEntryPoint(new Class[]{MyPythonClass.class});

}

public void ExecuteCommand(String cmd){

_mod.getCommandExecutor().execute(cmd);

}

public Map<String,String> CentralGameInfoDict = new HashMap<>();

public void UpdateServerInfo(String field, String value){

if (!field.isBlank() && !value.isBlank()) {

if (CentralGameInfoDict.containsKey(field)) {

if (!CentralGameInfoDict.get(field).equals(value)) {

Debug.logMessage("changed srv INFO f>" + field + ", v>" + value);

putInfo(field, value);

}

} else {

Debug.logMessage("added srv INFO f>" + field + ", v>" + value);//, dict="+CentralGameInfoDict.toString());

putInfo(field, value);

}

}

}

void putInfo(String field, String value){

CentralGameInfoDict.put(field, value);

if(IsCallbackServerStarted()) {

_cb.onUpdateServerInfo(CentralGameInfoDict);

}

}

public void onChatMessage(String msg){

if(IsCallbackServerStarted()) {

_cb.onChatMessage(msg);

}

}

public void onDeath(String killer){

if(IsCallbackServerStarted()) {

_cb.onDeath(killer);

}

}

public void onKill(String killed){

if(IsCallbackServerStarted()) {

_cb.onKill(killed);

}

}

public void onCaptchaSolveRequest(byte[] image_bytes){

if(IsCallbackServerStarted()) {

Debug.logMessage("SENDING TO CALLBACK!");

_cb.onCaptchaSolveRequest(image_bytes);

}

}

public void onDamage(float amount){

if(IsCallbackServerStarted()) {

_cb.onDamage(amount);

}

}

public Vec3d Nuller(){

return null;

}

public Rotation getGoalRotation(){

Rotation result = null;

if (AltoClef.inGame()){

Vec3d goal = getCurrentGoal();

if(goal != null){

Rotation targetrot = LookHelper.getLookRotation(_mod,goal);

result = LookHelper.getLookRotation().subtract(targetrot);

}

}

return result;

}

public Vec3d getCurrentGoal(){

Vec3d result = null;

if (AltoClef.inGame()) {

Optional<IPath> pathq = _mod.getClientBaritone().getPathingBehavior().getPath();

BetterBlockPos goalpos = null;

if (pathq.isPresent()) {

List<BetterBlockPos> pathlist = pathq.get().positions();

if (pathlist.size() > 0) {

goalpos = pathlist.get(pathlist.size() - 1);

result = new Vec3d(goalpos.getX(), goalpos.getY(), goalpos.getZ());

//Debug.logMessage("goalpos x="+goalpos.getX()+" y="+goalpos.getY());

}

}

}

return result;

//_mod.getClientBaritone().getCustomGoalProcess().getGoal().toString();

//return _mod.getClientBaritone().getGetToBlockProcess().GetToBlockCalculationContext.;

//_mod.getTaskRunner().getCurrentTaskChain().getTasks().

}

public void callPythonMethod(){

//_mod.getGateway().getGateway().getCallbackClient().sendCommand("trysi"); //command, blocking?

}

public double getHealth(){

return _mod.getPlayer() == null ? 0 :(double)_mod.getPlayer().getHealth();

}

public double getSpeed(){

return _mod.getPlayer() == null ? 0 :(double)_mod.getPlayer().getMovementSpeed();

}

public Vec3d getSpeedVector(){

return _mod.getPlayer() == null ? new Vec3d(0,0,0) : _mod.getPlayer().getVelocity();

}

public double getPitch(){

return _mod.getPlayer() == null ? 0 : _mod.getPlayer().getPitch();

}

public double getPitch(double TickDelta){

return _mod.getPlayer() == null ? 0 :_mod.getPlayer().getPitch((float)TickDelta);

}

public double getYaw(){

return _mod.getPlayer() == null ? 0 :_mod.getPlayer().getYaw();

}

public double getYaw(double TickDelta){

return _mod.getPlayer() == null ? 0 :_mod.getPlayer().getYaw((float)TickDelta);

}

public Vec3d getAngVector(){

return _mod.getPlayer() == null ? new Vec3d(0,0,0) :_mod.getPlayer().getRotationVector();

}

public double getSpeedX(){

return _mod.getPlayer() == null ? 0 :_mod.getPlayer().getVelocity().getX();

}

public double getSpeedY(){

return _mod.getPlayer() == null ? 0 :_mod.getPlayer().getVelocity().getY();

}

public double getSpeedZ(){

return _mod.getPlayer() == null ? 0 :_mod.getPlayer().getVelocity().getZ();

}

public double getSpeedXZ(){

return _mod.getPlayer() == null ? 0 :Math.sqrt(Math.pow(_mod.getPlayer().getVelocity().getX(),2)+Math.pow(_mod.getPlayer().getVelocity().getZ(),2));

}

}

Запустим callback – обратный вызов</p>" data-abbr="каллбек">каллбек и точку входа из класса инициализации мода (я вставил только строчки кода с инициализацией).

Кодопомойка фрагмента AltoClef.java

package adris.altoclef;

public class AltoClef implements ModInitializer {

private static GatewayServer _gatewayServer;

private static Py4jEntryPoint _py4jEntryPoint;

_py4jEntryPoint = new Py4jEntryPoint(this);

_gatewayServer = new GatewayServer(_py4jEntryPoint);

_gatewayServer.start();

//ClientServer clientServer = new ClientServer(null, 25333);

//_gatewayServer.getGateway().getCallbackClient().

if (_gatewayServer != null ) {

System.out.println("Gateway Server started on port "+_gatewayServer.getPort()+". Listeting port: "+_gatewayServer.getListeningPort());

}

_py4jEntryPoint.InitPythonCallback();

}Также дополним обработчик сообщений в классе adris.altoclef.butler методами и конструкции вида if-else и их аналоги</p>" data-abbr="чеками ">чеками для того, чтобы выстрелить от анг. event – событие</p>" data-abbr="эвенты">ивенты о написании сообщений в Python‑части.

Упс, а здесь кода не будет, эту часть ты и сам сможешь повторить, дорогой читатель! Просто тут у меня концентрация грязекода зашкалила, а переписывать спустя год оказалось лень... Прошу понять, простить...

Кроме того нужно научить бота правильно парсить сообщения из чата майнкрафта. По-хорошему, это – отдельная тема на целую статью, но я запихаю всё в маленький спойлер :)

АД (или парсинг чата современных серверов Minecraft)

На самом деле мод AltoClef уже содержал в себе парсер чата Minecraft, но он работал изначально только с ванильной версией:

Ванильная версия чата

<ник1> привет

<ник2> пока

Не беда, подумал я, там ведь был универсальный шаблон, однако не тут то было... Оригинальный парсер мог работать только с фиксированными шаблонами сообщений и не имел никакой защиты от REGEX-чувствительных символов в сообщениях. Что ж, придётся мне это пилить самому. Чтобы вы понимали масштаб проблемы, сейчас я приведу несколько примеров сообщений из чата типичного русского сервера Minecraft:

Примеры сообщений из типичных серверов Minecraft

Обратите внимание, что сообщения очень разные даже в пределах одного сервера. Передаются они путём простого засылания пакета с полным текстом сообщения в чате, так что спарсить что-то без перебора не получится. Сложность парсинга, прежде всего, в том, что какие-то элементы могут быть, а могут – и не быть.

Например, если на сервере установлены кланы, то игрок, находящийся в клане, будет иметь тег клана, а игрок без клана – не будет его иметь. Кланы, кстати, не всегда выделяются квадратными скобками, иногда просто пробелами.

Кроме того, самый сущий ад – это наличие префиксов и суффиксов, которые могут быть по отдельности, или не быть вообще, или быть все вместе! Я уже не говорю о том, что те же суффиксы могут быть с пробелами, что просто уничтожит механизм парсера, но, к счастью, такое – редкость.

Так... Вы уже отошли от шока? Я до сих пор нет. Думаю, любой уважающий себя человек, представляющий, как работают парсеры, понимает, что парсить это – сущий кошмар. Только у меня для вас одна неприятная новость. Кто, если не мы?..

В общем, я решился. И я это дело сделал, правда, местами коряво, если включать автодетектор чата сервера, но для прототипа уж точно сойдёт.

Говоря о реализации, для начала я решил собрать все виды их этих вонючих стрелок:

"➥","->","➡","➥","➯","➨","›","►","⋙","»","⪼","⇨"

Потом собираем всевозможные теги, разные по смыслу в каждых серверах:

"{team}","{global}","{starterPrefix}","{donate}","{suffix}","{clan}","{rank}", "{from}", "{to}", "{message}"

Любые другие теги нам учитывать необязательно, но, если на сервере они есть, в шаблон просто будем это вбивать как {любое_название}, просто оно не будет парситься в данные, но будет учитываться во время распознавания.

Теперь доработаем скрипт парсера с учетом новых вводных. У меня везде включен автодетект, но, если вы захотите встроить это куда-то себе, рекомендую отключить его, передав в переборщик шаблоны только конкретного, нужного сервера.

Кодопомойка ChatChecker.java

package adris.altoclef.butler;

import adris.altoclef.AltoClef;

import adris.altoclef.Debug;

import adris.altoclef.util.time.TimerGame;

import java.util.*;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class WhisperChecker {

private static final TimerGame _repeatTimer = new TimerGame(0.1);

private static String _lastMessage = null;

public static MessageResult tryParse(String ourUsername, String whisperFormat, String message) {

List<String> parts = new ArrayList<>(Arrays.asList("{from}", "{to}", "{message}"));

// Sort by the order of appearance in whisperFormat.

parts.sort(Comparator.comparingInt(whisperFormat::indexOf));

parts.removeIf(part -> !whisperFormat.contains(part));

String regexFormat = Pattern.quote(whisperFormat);

for (String part : parts) {

regexFormat = regexFormat.replace(part, "(.+)");

}

if (regexFormat.startsWith("\Q")) regexFormat = regexFormat.substring("\Q".length());

if (regexFormat.endsWith("\E")) regexFormat = regexFormat.substring(0, regexFormat.length() - "\E".length());

//Debug.logInternal("FORMAT: " + regexFormat + " tested on " + message);

Pattern p = Pattern.compile(regexFormat);

Matcher m = p.matcher(message);

Map<String, String> values = new HashMap<>();

if (m.matches()) {

for (int i = 0; i < m.groupCount(); ++i) {

// parts is sorted, so the order should lign up.

if (i >= parts.size()) {

Debug.logError("Invalid whisper format parsing: " + whisperFormat + " for message: " + message);

break;

}

//Debug.logInternal(" GOT: " + parts.get(i) + " -> " + m.group(i + 1));

values.put(parts.get(i), m.group(i + 1));

}

}

if (values.containsKey("{to}")) {

// Make sure the "to" target is us.

String toUser = values.get("{to}");

if (!toUser.equals(ourUsername)) {

Debug.logInternal("Rejected message since it is sent to " + toUser + " and not " + ourUsername);

return null;

}

}

if (values.containsKey("{from}") && values.containsKey("{message}")) {

MessageResult result = new MessageResult();

result.from = values.get("{from}");

result.message = values.get("{message}");

return result;

}

return null;

}

public static MessageResult chatParse(String ourUsername, String[] chatFormatMas, String message) {

return chatParse(ourUsername, chatFormatMas, message, "exact");

}

public static MessageResult chatParse(String ourUsername, String[] chatFormatMas, String message, String ExactState) {

List<String> parts = new ArrayList<>(Arrays.asList("{team}","{global}","{starterPrefix}","{donate}","{suffix}","{clan}","{rank}", "{from}", "{to}", "{message}"));

String serverName = chatFormatMas[0];

String serverMode = chatFormatMas[2];

String chatFormatNew = new String(chatFormatMas[1]);

// Sort by the order of appearance in whisperFormat.

message = message.replace("\","");

//заменяем стрелки

List<String> arrows = new ArrayList<>(Arrays.asList("➥","->","➡","➥","➯","➨","›","►","⋙","»","⪼","⇨")); //https://ru.piliapp.com/symbol/arrow/

for (String arrow : arrows){

if (!chatFormatNew.contains(arrow)) { //ЕСЛИ ШАБЛОН НЕ СОДЕРЖИТ ОДНУ ИЗ ЭТИХ СТРЕЛОК ТОГДА РЕПЛАЙСАЕМ ЕСЛИ НЕТ ТО ИДЕМ ПО ШАБЛОНУ ТАК БУДЕТ ТОЧНЕЕ!

message = message.replace(arrow, ">");

}

}

List<Character> regexKillingChars = new ArrayList<>(Arrays.asList('[',']','.','^','?','*','$','(',')','/','|','+'));

//Debug.//logMessage("Do:"+message);

for (Character killer : regexKillingChars){

String charr = killer.toString();

chatFormatNew = chatFormatNew.replace(charr,"\"+charr);

}

String chatFormat = chatFormatNew;

parts.sort(Comparator.comparingInt(chatFormat::indexOf));

parts.removeIf(part -> !chatFormat.contains(part));

//Debug.logMessage("Posle:"+message);

////Я НА ЭТОМ Е**** ВЕСЬ ДЕНЬ ****

String regexFormat = Pattern.quote(chatFormat);

for (String part : parts) {

//Debug.logMessage("4o"+part);

regexFormat = regexFormat.replace(part, "(.+)");

}

if (regexFormat.startsWith("\Q")) regexFormat = regexFormat.substring("\Q".length());

if (regexFormat.endsWith("\E")) regexFormat = regexFormat.substring(0, regexFormat.length() - "\E".length());

//Debug.logInternal("FORMAT: " + regexFormat + " tested on " + message);

Pattern p = Pattern.compile(regexFormat);

Matcher m = p.matcher(message);

Map<String, String> values = new HashMap<>();

if (m.matches()) {

//Debug.logMessage("4o 3a dermo"+m.toString());

for (int i = 0; i < m.groupCount(); ++i) {

// parts is sorted, so the order should lign up.

if (i >= parts.size()) {

Debug.logError("Invalid whisper format parsing: " + chatFormat + " for message: " + message);

break;

}

//Debug.logInternal(" GOT: " + parts.get(i) + " -> " + m.group(i + 1));

values.put(parts.get(i), m.group(i + 1));

}

}

if (values.containsKey("{to}")) {

// Make sure the "to" target is us.

String toUser = values.get("{to}");

if (!toUser.equals(ourUsername)) {

Debug.logInternal("Rejected message since it is sent to " + toUser + " and not " + ourUsername);

return null;

}

}

List<Character> nickKillingChars = new ArrayList<>(Arrays.asList('~','[',']','.','^','?','*','$','(',')','/','|','+'));

if (values.containsKey("{from}") && values.containsKey("{message}")) {

String name = values.get("{from}");

if(name != null) {

if (name != null && name.strip() != "") {

String[] splittedName = name.strip().split(" ");

if (splittedName.length>0) {

if(splittedName.length==1){

name = splittedName[0];

} else if (splittedName.length==2) {//[A-Za-z0-9]

name = splittedName[0]; //[бог] _nyaka Красавица :

} else if (splittedName.length==3) {

name = splittedName[0]; //[президент] Гений lexa Богач :

} else{

name = splittedName[0];

}

for (Character killer : nickKillingChars){

String charr = killer.toString();

name = name.replace(charr,"");

}