C появлением LLM, инструменты для автоматизации бизнес-процессов получили мощный импульс развития, так как стало возможным решать такие задачи, которые раньше было невозможно или сложно реализовать известными методами.

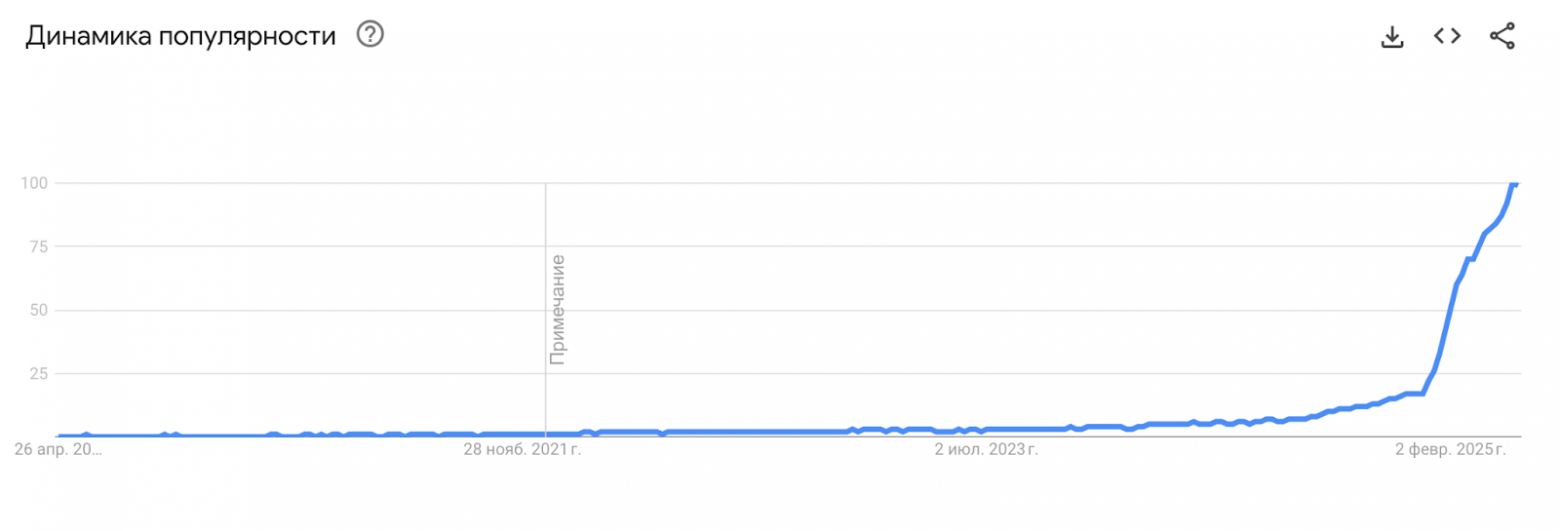

Так, инструмент n8n, который увидел свет в 2019 году, стал стремительно расти в последние месяцы, именно благодаря добавлению интеграций с LLM.

В этой статье я сравню несколько популярных решений для автоматизации бизнес-процессов в связке с LLM:

n8n — автоматизация и интеграция API.

- Open-source инструмент для построения автоматизаций.

- Поддержка API, Webhooks, JavaScript-блоков.

- Более 350 интеграций.

- Расширяемость: можно писать свои узлы.

Flowise — визуальный интерфейс для LangChain.

- Визуальный конструктор LLM-агентов.

- Поддержка OpenAI, Cohere, HuggingFace и локальных моделей.

- Построен на LangChain.

- Возможность деплоя через Docker или облако.

Open WebUI (LangChain) — кастомные интерфейсы и пайплайны для LLM.

- Интерфейс для визуальной отладки цепочек LangChain.

- Много кастомизации, но требует технических знаний.

Flowise и n8n мы уже реализовали как преднастроенные сервисы в нашем облаке для простого деплоя – Amvera Cloud. Open WebUI будет реализован в ближайшее время. Надеюсь, это сравнение поможет вам понять, какой инструмент лучше подходит для решения ваших задач.

А чтобы сравнение было наиболее наглядным, я рассмотрю пару задач для автоматизации, и как они будут решаться данными сервисами.

Сценарий 1 - Анализ отзывов о компании и отправка отчёта

Для многих видов бизнеса полезно мониторить отзывы или новости о себе, чтобы вовремя на них реагировать. Рассмотрим сценарий, где необходимо по заданной теме найти, используя API отзывы/новости, обработать текст и в зависимости от результата, направить ответственному специалисту результат на почту или телеграм.

|

Этап |

n8n |

Flowise |

Open WebUI |

|

1. Ввод темы пользователем |

Через Webhook, FormTrigger или UI |

Можно через встроенный ChatUI или API endpoint |

Через чат-интерфейс |

|

2. Получение отзывов через API |

Легко настраивается с HTTP-запросом |

Нет встроенного шага для внешних API, нужен кастомный node или API gateway |

Требует внешнего скрипта |

|

3. Обработка текстов в LLM (summarization) |

Можно через встроенные LLM плагины (OpenAI, Hugging Face) |

Есть LangChain-поддержка LLM, цепочки |

Очень удобно — прямо в чате |

|

4. Формирование отчёта (текст + формат) |

JavaScript-блок позволяет гибкую логику |

Требует дополнительной цепочки |

Вручную, мало форматирования |

|

5. Отправка отчёта пользователю (email / Telegram / чат) |

Много интеграций: Telegram, Email, Slack |

Нужно вручную настроить вызов API |

Требуется внешний обработчик |

|

6. UI / UX для конечного пользователя |

Есть rudimentary UI (Webhook+Forms) |

Chat-интерфейс встроен |

Чат удобный и готовый |

|

7. Повторяемость / планировщик |

Есть cron, таймеры и триггеры |

Нет, нужно вызывать вручную или внешне |

Только ручной запуск |

|

8. Масштабируемость |

Docker, self-hosted, кластеризация |

Docker есть, но нагрузка — проблема |

Пока нестабильна под нагрузкой |

Из таблицы видно, что n8n отлично подходит для API-интеграций, логики, и отправки уведомлений по Webhook. При этом требуется составление базовых скриптов и нет интерфейса чата.

Для работы с LLM хорошо подойдет Flowise, но сложные автоматизации, с использованием API будет реализовать тяжело.

Open WebUI же пригоден как AI-чат с кастомизацией. Но для сложных интеграций с API решение не подойдет.

Сценарий 2: «AI-консультант по подбору продукта»

Описание:

Пользователь отвечает на серию вопросов (бюджет, цели, размер экрана и т.д.). Система анализирует ответы, подбирает варианты из базы (или API), запрашивает LLM, чтобы оформить объяснение выбора, и возвращает ответ в понятной форме.

Сравнение реализации сценария

|

Этап |

n8n |

Flowise |

Open WebUI |

|

1. Диалог с пользователем (опрос) |

Можно имитировать через Forms/Webhook с пошаговой логикой |

Нет встроенного диалога, только один input |

Прямой диалог с LLM |

|

2. Хранение/обработка состояния (вопросы, ответы) |

Через переменные, функции, хранение в JSON |

Частично возможно через цепочки и memory |

LLM-хорошо справляется, но сложно сохранять контекст между сессиями |

|

3. Подборка по базе/каталогу (например, API магазинов) |

Простая интеграция с API (Amazon, DNS, JSON-файл) |

Нужно писать кастомный вызов |

Требует внешнюю интеграцию |

|

4. Использование LLM для объяснения подбора |

Можно вставить ответы из базы и отправить в LLM |

Отлично реализуется через LangChain tools |

Отлично – можно сразу написать prompt и отправить |

|

5. Форматирование/вывод результатов |

Через Markdown или шаблоны письма/сообщений |

Через prompt или chain |

Ограничено HTML-рендерингом |

|

6. Повторное взаимодействие (новый запрос, изменить параметр) |

Нужно проектировать самостоятельно |

Требует rebuild цепочки |

Встроено — можно вести беседу |

|

7. Отправка результатов в мессенджер / email |

Email, Telegram, Discord и др. |

Нужен отдельный endpoint |

Только чат в браузере |

Если важна логика и интеграции с API, разумно выбрать n8n. Если необходимо преобразовать логику в цепочки с AI-пояснениями, полезно будет выбрать Flowise. А Open WebUI хорошо подходит для разговорного опыта и гибких запросов.

У каждого из инструментов есть сильные и слабые стороны, и иногда их полезно использовать в связке друг с другом.

Связки

-

n8n как оркестратор + Flowise как “AI-мозг”

В данном сценарии n8n обрабатывает триггер (например, сообщение в Telegram или форма) и делает запрос к Flowise endpoint с текстом запроса. После чего получает ответ и отправляет его обратно пользователю.

-

Open WebUI как интерфейс + n8n/Flowise вместо бэкенда

Пользователь взаимодействует с Open WebUI (человеческий интерфейс), но его запросы перенаправляется на n8n, который вызывает Flowise, делает API-запросы, форматирует результат, возвращает ответ в Open WebUI.

Пример сценария "в связке"

Сценарий: Пользователь пишет в WebUI: "Подбери ноутбук для дизайна до 100 000 руб"

-

Open WebUI получает фразу, отправляет в n8n Webhook.

-

n8n:

-

Парсит запрос (может вызывать GPT-3 для структурирования),

-

Делает запрос к каталогу вашего интернет-магазина,

-

Формирует список моделей,

-

Отправляет их в Flowise endpoint, где цепочка LLM формулирует текст рекомендации.

-

-

Ответ возвращается в Open WebUI.

Надеюсь, данное сравнение поможет лучше подобрать инструмент под вашу задачу.

Разместить же данные решения можно в облаке Amvera Cloud, где они предоставляются как преднастроенные сервисы с бесплатными доменами и встроенным проксированием до ведущих LLM.

Автор: NikitinIlya