Одной из самых обсуждаемых тем сегодня является появление искусственного интеллекта (ИИ), сравнимого с человеческим или даже еще более продвинутого. Момент, когда это должно произойти, носит название технологической сингулярности.

В этой статье мы будем сравнивать методы глубинного обучения с принципами работы нашего , выясним (на основе этого источника), насколько далеки наши алгоритмы от совершенного ИИ, и попытаемся понять, когда же может наступить эта технологическая сингулярность.

По мнению известного американского футуролога Рэя Курцвейла, технологическая сингулярность должна наступить в 2030 году. Его подсчеты основаны на двух оценках – сложности структуры человеческого

За последние два года ученые доказали, что «производительность» нашего

Математические модели, построенные в соответствии с принципами работы головного

Получается, что, с одной стороны, новые технологии позволяют нам проверять обобщенные гипотезы, связанные с обработкой информации. С другой – данные, которые мы получаем в ходе таких исследований, не несут в себе особого смысла.

Одной из самых точных моделей, описывающих поведение нейронов в человеческом

Несмотря на то, что мы знаем, в каком направлении нам нужно двигаться и какие модели нам нужно разрабатывать в будущем, существует еще масса ограничений, которые, по прогнозам ученых, оттягивают технологическую сингулярность еще на несколько десятков лет.

Работа алгоритмов глубинного обучения, в отличие от других технологий, сильно зависит от скорости подключения к Интернету. Известно, что развитие сетевых технологий идет гораздо более медленными темпами по сравнению с развитием комплектующих для компьютера: по статистике скорость интернет-соединения удваивается каждые три года. В прошлом году компания Mellanox разработала коммутаторы, позволяющие передавать данные со скоростью 100 Гбит/с. Технологические решения Mellanox пока нельзя применить ни на одном суперкомпьютере, но когда это случится, следующего прорыва в сфере сетевых технологий нам ждать еще не скоро.

Похожая ситуация складывается и с развитием оперативной памяти. Такие решения, как 3D-память, по-прежнему дают возможность увеличить скорость работы ОЗУ. Однако повысить производительность традиционными методами мы уже просто не способны.

Не менее серьезная проблема касается потребления электроэнергии и ее стоимости. Суперкомпьютер Тяньхэ-2, который, согласно рейтингу TOP500, считается самым мощным компьютером в мире, в день потребляет по 24 МВатт энергии, на что уходит от 65 до 100 долларов. Этой энергии хватило бы на то, чтобы обеспечить электричеством 6 000 домов в Германии.

Более того, существует масса физических ограничений. К примеру, не так давно был разработан транзистор размером в несколько атомов. По оценкам экспертов, в ближайшие два года мы достигнем физических пределов в производстве компьютерной техники. Более того, на таком микроуровне начинают проявляются такие квантовые эффекты, как, например, квантовое туннелирование.

Легче представить это явление, если бы оно происходило на макроуровне. Допустим, вам нужно зарядить телефон, и вы подключаете его к розетке, расположенной недалеко от телевизора. Эффект туннелирования предполагает, что электроны в этом случае решали бы сами, к какому устройству им следует направиться. Так или иначе, чтобы избежать этого явления и начать новую волну технического прогресса, нам нужны новые материалы, новые технологии и новые идеи.

Что общего между глубинным обучением и мыслительными процессами

Современные алгоритмы глубинного обучения далеки от систем ИИ, которые можно увидеть в голливудских блокбастерах. Чтобы это доказать, мы сравним сверточные сети, которые используются в глубинном обучении, с процессами обработки информации, происходящими в нашем

Если вы знакомы с основами нейробиологии, то, наверняка, знаете, что нейроны передают электрические сигналы по трубчатым структурам, которые называются аксонами. Когда нейрон возбуждается, он передает электрический сигнал – называемый потенциалом действия – по аксону, который, в свою очередь, разветвляется на несколько участков. Эти участки называются терминалями. На конце каждой из терминалей находятся определенные белки. Они сменяют электрический сигнал химической реакцией, которая заставляет нейромедиаторы – вещества, передающие важную для нас информацию – перескакивать с одного нейрона на другой. Совокупность терминалей аксона и других рецепторов можно представить в виде входного слоя сверточной сети.

Нейроны могут иметь от пяти до нескольких сотен ветвящихся отростков, называемых дендритами. Лишь в 2013 году было доказано, что так называемые дендритные спайки – потенциалы действия, возникающие в дендритах – играют большую роль в обработке информации.

Дендритные спайки возникают в ситуации, когда деполяризация дендрита достигает достаточно высокого значения.

В этом случае электрический сигнал, поступающий в тело нейрона, может резко увеличиться за счет потенциал-зависимых каналов, генерирующих дополнительный электрический потенциал. Этот процесс напоминает реализацию метода максимального элемента (max-pooling) в глубинном обучении. Более того, дендритные спайки играют одну и ту же функцию как в человеческом

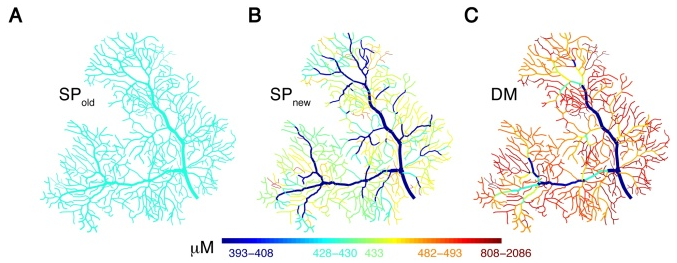

A – модель нейрона, не учитывающая дендритные спайки; B – моделирование обычной динамики дендритных спайков; C – моделирование более сложной динамики дендритных спайков с учетом одномерной диффузии частиц, которая напоминает операцию свертки. Изображение © было опубликовано в статье Анвара, Роома, Неделеску, Чена, Куна и Де Шуттера в журнале Frontiers in Cellular Neuroscience

Если уровень деполяризации достаточно высок, это еще не значит, что нейрон будет возбужден. Сразу после возбуждения нейрон имеет слишком высокий положительный потенциал. В связи с этим может произойти его задержка, пока потенциал не примет нужное значение.

В модели LNP эта задержка представлена в виде неоднородного пуассоновского процесса с распределением Пуассона. Это означает, что вероятность возбуждения нейрона с перового или второго раза достаточно высока, в то время как вероятность более позднего возбуждения уменьшается в геометрической прогрессии.

Это лишь некоторые из примеров того, как методы глубинного обучения воспроизводят процессы происходящие в нашем

Чего не хватает глубинному обучению

Главным недостатком существующих моделей является то, что они не учитывают множества деталей. Современные модели не используют знания о биологических процессах обработки информации, включая изменения, происходящие в белках и генах – они слишком сложны для понимания.

Глубинное обучение не учитывает, к примеру, аксон-аксонные соединения, так как в них информация обрабатывается по особым алгоритмам, отличным от упомянутых выше. Кроме того, в некоторых случаях у нас просто недостаточно достоверный сведений для того, чтобы создать математическую модель. Например, мы не знаем, как именно обучается наш

Но так ли нам нужны эти детали? Для сравнения традиционная физическая модель используется физиками и инженерами по всему миру. Благодаря этой модели им удается разрабатывать высокотехнологичные решения, которые мы можем использовать в повседневной жизни. В то же время физическая теория неполна. Более того, ее пришлось слегка изменить после того, как полгода назад физики обнаружили новую частицу на Большом адронном коллайдере.

Еще один аргумент приводит известный французский ученый Ян Лекун. Он утверждает, что наши летательные аппараты способны перемещаться по воздуху ничуть не хуже птиц. Но описать движение птицы чрезвычайно сложно, так как оно требует учета даже мельчайших деталей. Движение самолета, в свою очередь, описывается всего лишь законами аэродинамики. Почему же тогда глубинное обучение не может иметь более простую структуру по сравнению с человеческим

Очевидно, что нам не нужно в точности воспроизводить все мыслительные процессы в своих алгоритмах для того, чтобы создать ИИ, сравнимый с человеческим. Вопрос лишь в том, каких знаний нам будет для этого достаточно.

Итак, мы сравнили механизмы глубинного обучения с процессами, происходящими в головном

Исходя из текущих темпов технического прогресса, некоторые ученые делают вывод о том, что искусственный разум будет создан в ближайшие 20 лет. Однако, вероятнее всего, это случиться уже после 2080 года.

Мы не сможем добиться успехов в разработке ИИ, если нам не удастся преодолеть ряд ограничений. Нам нужно эффективнее использовать энергию и организовать более эффективный процесс производства техники и комплектующих. Разработка и внедрение инноваций, позволяющих значительно увеличить скорость ОЗУ и интернет-соединения, становятся ключевыми факторами технологического развития. Так что ожидать появления продвинутых систем ИИ в ближайшее время нам не стоит.

P.S. Если возвращаться к реалиям дня сегодняшнего, на этой неделе мы посмотрели на основные тренды в сфере IaaS.

Стоит отметить, что в прошлом и в начале этого года мы задали хороший темп в работе по расширению облачного пространства компании. Мы давно не знакомили вас с оборудованием, поступающим на наши облачные площадки, и решили исправить эту ситуацию с помощью нового материала по unboxing'у серверов Cisco UCS M4308.

Автор: ИТ-ГРАД