Первый дата-центр (ЦОД) Microsoft был построен в 1989 году. Это был ЦОД первого поколения, сейчас это уже ЦОДы четвертого поколения. Microsoft самостоятельно осуществляет проектирование, строительство и управлением ЦОДам. Для этих зада у нас даже есть специальное подразделение — Global Foundation Services (GFS).

Для каких задач Microsoft используется ЦОДы?

Во-первых, для обеспечения работоспособности сервисов, которые используют миллионы пользователей по всему миру (XBOX Live, Hotmail, MSN, Zune, SkyDrive и т.п.). Сейчас это можно назвать всем хорошо знакомым термином SaaS (Software as Service). Во-вторых, для предоставления глобальной масштабируемой платформы, на основе которой разработчики могут создавать собственные SaaS. Эта платформа Windows Azure, которая реализует модель PaaS (Platform as Service). В цифрах и фактах это выглядит примерно следующим образом:

Базовая архитектура дата-центров

Давайте начнем с базовой архитектуры ЦОДа, это поможет понять различия между ЦОДа первого и четвертого поколения. Традиционную инфраструктура ЦОДа можно представить следующим образом (источник The Green Grid):

Система энергоснабжения. Система энергоснабжения отвечает за питания ЦОДа энергий, обычно это десятки мегаватт (МВт). Обычно (на всякий случай) для ЦОДов используется две подстанции, которые поставляют электроэнергию. От подстанции (Substation)на вход ЦОДа поступает электричество с вольтажом большим, чем сервера (IT Load) готовы принять на вход. Поэтому необходимы трансформаторы (Transformer), которые понижают вольтаж.

На случай выхода из строя основной системы энергообеспечения должны быть предусмотрены резервные генераторы (Generators). Помимо этого требуются промышленные источники бесперебойного питания (UPS). Обратите внимание, что к UPS на рисунке идут «черные линии» (электричество от электростанции) и «коричневые линии» (электроэнергия от генераторов), а выходят «зеленые» (уже прошедшие через фильтр UPS). Именно «зеленые линии» идут к оборудованию ЦОДа. Самый просто тип UPS – это UPS, основанные на батареях (backup battery UPS), но для ЦОДов обычно это не очень подходит, т.к. обеспечивает достаточно небольшой резерв и длительность работы. У нас в ЦОДах используются дизельные генераторы, мощностью 2 – 2.5 МВт. Например, такой генератор может обслуживать поселок из 250 домов.

Система охлаждения. Система охлаждение отвечает за охлаждение оборудования. Принцип ее работы достаточно прост:

- На вход поступает вода («синие линии»), которая охлаждается с помощью градирен или охладительных башен (Cooling Towers). Обычно градирни применяются в теплом климате. Для холодного климата сейчас пытаются использовать просто наружный холодный воздух (такие системы значительно дешевле, чем охладительные башни), но для этого на улице должна быть низкая влажность и температура воздуха не выше 23 градусов. Такие системы называются адиабатическими системами охлаждения (Adiabatic System), именно они используются в ЦОДах четвертого поколения.

- Следующим шагом большие ходильные установки или чиллеры (Chiller) охлаждают воду.

- Далее вода поступает в специальные кондиционеры — CRAC (computer room air conditioning unit), которые уже находятся в помещении дата-центра (Zone 1).

- Нагретая от воздуха вода («красные линии») снова проходит весь цикл охлаждения.

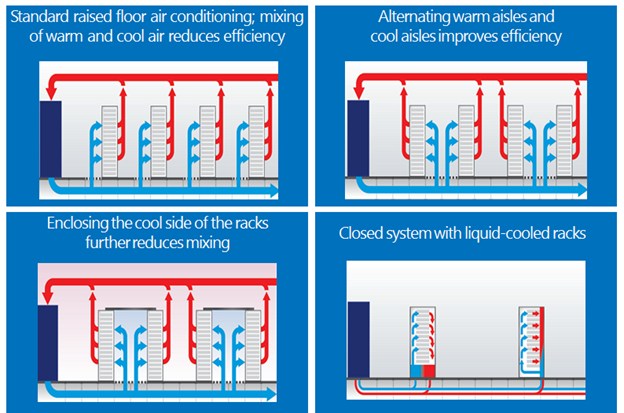

Когда помещение охлаждается очень важно сделать так, чтобы горячий и холодный воздух не перемащивались. Например, сравните четыре вариации системы:

Последний четвертый вариант применяется не очень часто и для стоек с высокой плотностью размещения серверов.

Итого, получает, что при построении ЦОДов необходимо решить следующие задачи:

- Отдавать максимум поступающей энергии непосредственно серверам, а не другим установка (охладительным, кондиционным и т.п.).

- Максимально эффективно охлаждать ЦОДы (чем меньше установок, а следовательно, электроэнергии для этого используется, тем лучше).

- Максимально эффективно использовать площадь ЦОДа (при эффективном охлаждении плотность серверов можно существенно увеличить, а значит сократить площадь и ЦОДа и стоимость участка под него).

Технические подробности, например, функционирования системы охлаждения и генераторов, можно найти в хабростатьях (из блока Билайна):

- ЦОД в Ярославле: воплощение мечты последних пяти лет;

- ЦОД в Ярославле: инженерные решения для бесперебойной работы;

- Строим дата-цетр, часть 3: подавать охлаждённым.

Эффективность энергопотребления ЦОДа (Power Usage Effectiveness, PUE)

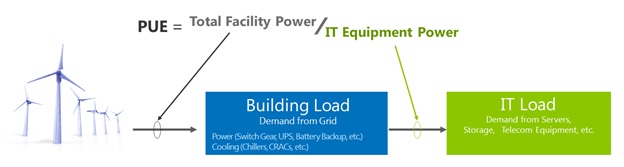

Для определения эффективности ЦОДов существует специальный показатель (аналог КПД) — Power Usage Effectiveness (PUE).

Традиционно величина PUE определяется как отношение общего энергопотребления ЦОДа к энергопотреблении только размещенного в нем полезного (сервера, хранилища и т.п.) IT-оборудования.

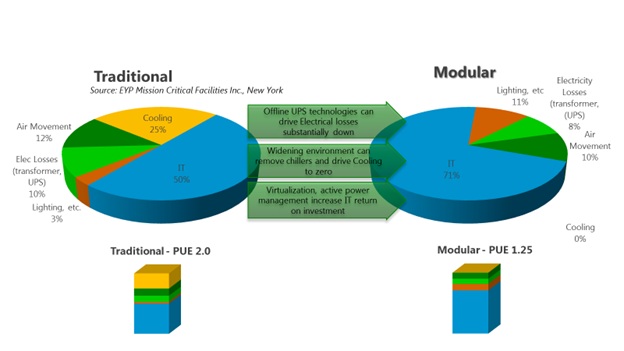

Допустим, что 15 MW требуется для функционирования ЦОДа (сервера, освещение и т.п.), а серверами потребляется только 10 MW, поэтому PUE = 1.5. Получается, что чем ниже PUE, тем лучше. Сейчас для ЦОДоа стандартным считается 1.3-1.5 PUE. У ЦОДов четвертого поколения показатель PUE значительно меньше, чем у ЦОДов первого поколения.

Поколения ЦОДов и ITPAC (IT Preassembled Components)

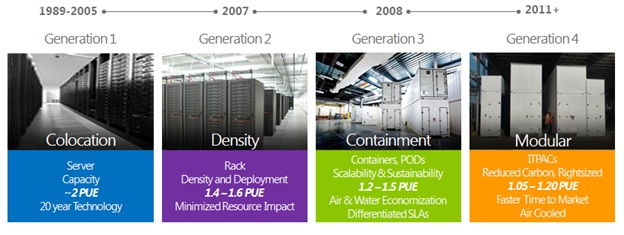

Первое поколение – это сервера, второе поколение – стойки серверов, треть поколение – контейнеры, а четвертое поколение – специальные модули (IT Preassembled Components, ITPAC).

В обычных контейнерных используется внешнее водяное охлаждение, для чего необходимо подключить линии с холодной водой; кроме того, эффективность использования электропитания у них несколько меньше. Для новейших модульных ЦОДОВ на базе ITPAC используется воздушно-водяная система (распыление капель воды внутри модуля, что повышает скорость охлаждения через испарение), а показатель эффективности энергопотребления (PUE) составляет 1,05, то есть на каждый ватт, направляемый на питание серверов, всего 0,05 ватта тратится на нужды охлаждающей инфраструктуры.

Фактически, ITPAC — это некоторый стандарт на завершенный модуль для построения дата-центра. Он содержит спецификации на контейнер и его составные части: на стойку, систему вентиляции и другое оборудование, а также на подводимые коммуникации, включая воду, электроэнергию и сеть передачи данных. Важной особенностью является возможность использования без предварительного охлаждения внешнего воздуха, температура которого может варьироваться в достаточно широком интервале. Функционирование внутренней системы кондиционирования регулируется в зависимости от температуры забираемого воздуха. Так, в случае существенного ее повышения включается водяное охлаждение внутри контейнера ITPAC, при снижении до определенного порога нагреваемый серверами воздух используется для поддержания комфортной среды внутри модуля. При нормальной температуре потока забираемого воздуха оказывается достаточно для охлаждения серверов. ITPAC может содержать более 2000 серверов.

Строительство дата-центра с использованием ITPAC во много раз быстрее и эффективнее: эклномичная система охлаждение, ITPAC контейнеры могут изготовляться удаленно и доставлять уже в собранном виде на площадку под ЦОД.

Где располагаются ЦОДы?

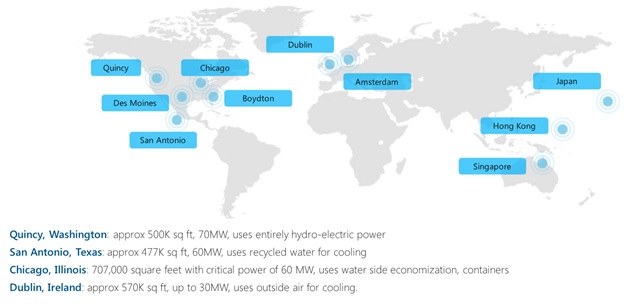

Ниже представлено географическое присутствие ЦОДов. Если говорить о Windows Azure, то сейчас это 8 ЦОДов (4 в Северной Америка, 2 в Европе и 2 в Азии). Кстати, два из них стали поддерживать Windows Azure не так давно.

Для Windows Azure здесь стоит отметить, что для ЦОДы в соседних регионах автоматически и бесплатно делают копии данных файлового хранилища, т.е. это автоматическая репликация. В итоге, мы получаем 6 копий наших данных (по 3 реплики на каждый ЦОД). Все эти меры (репликация, отдельное энергоснабжение и т.п.) направлены на повышение отказоустойчивости конечного разработанного приложения или сервиса, который предоставляем мы или который был разработан на нашей PaaS платформе. Кстати, еще интересный момент: как мы говорили ранее, для серверов и стоек нужны либо UPS, либо генераторы. Генераторы потребляют значительно больше энергии ЦОДа, поэтому использование UPS является более «экономичным», но как мы помним, его резерва может быть не достаточно – тогда сервер выйдет из строя или потеряются данные (а это не есть хорошо). Так вот, именно подход к репликации и геораспределенность позволяют не потерять данные и перенести заботу об SLA с уровня инфраструктуры ЦОДа на уровень приложения и обслуживания, а это позволяет понизить коэффициент PUE и повысить эффективность.

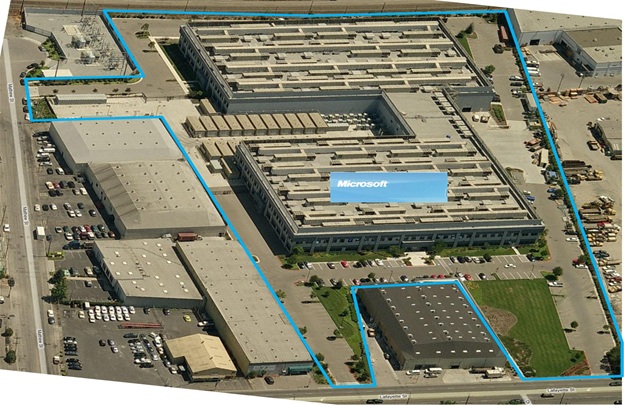

ЦОД в Калифорнии выглядит так как на рисунке ниже:

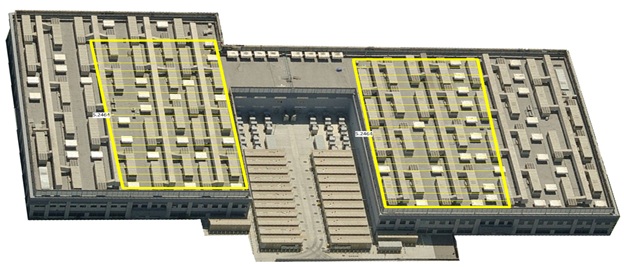

Чтобы почувствовать масштаб, давайте сравним с футбольным полем (желтые прямоугольники, площадь каждого из которых 2464 м2):

Что дальше? ЦОД пятого поколения?

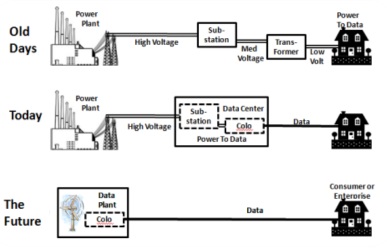

Каким будет пятое поколение ЦОДов? Давайте посмотрим на данные как на новую форму энергии:

Old day: эра до дата-центров и SaaS, дома или предприятия получали электричество напрямую и использовали его по своему усмотрению (для своих серверных и т.п.). В чем здесь недостаток? Большая «трата» энергии «по пути».

Today: с появление дата-центров в них стала производится большая часть работы и вычисления, а на выходе мы получаем данные (SaaS). Можно увидеть, что «трата» энергии уже значительно меньше.

The Future: объединить дата-центр и источник энергии (подстанцию). И это новый путь, т.к. на распространение электричества на 1 милю затрачивается примерно $ 2 млн. Оптический канал (а не вышки) значительно дешевле. И мы уже начинаем следовать этой концепции, например, новый строящийся ЦОД в Ирландии. Основной отличительной чертой этого ЦОДа будет являться наличие собственной инфраструктуры по управлению энергоснабжением. Полагаю, что об этом задумались уже многие облачные провайдеры.

Что будет дальше – покажет будущее, но уже сейчас достигнуты новые уровни энергоэффектсвности за счет применения передовых технологий и PaaS архитектуры.

Если кого-то заинтересовала инфраструктура ЦОДов Microsoft, то заходите на сайт Global Foundation Center (GFS) – нам есть что рассказать, т.к. Microsoft это не только софтверная компания, но так же имеет большой опыт как в разработке модулей ЦОД, так и ЦОД архитектур в целом. На странице с видео можно пройти виртуальный тур по ЦОДу, начиная с момента его строительства (это даже интереснее, чем готовый дата центр).

PS. Хочу поблагодарить Константина Кичинского и Анждея Аршавского за помощь при подготовке статьи.

Автор: inatale