Обсуждая искусственный интеллект, каждый говорит об AI, каким он его знает. Для одного это помощник, который пишет код, для второго — не очень надёжный поисковик. Для третьего — конкурент. Восприятие технологии формируется здесь и сейчас, в режиме реального времени. Эта статья — о том, что диктует отношение человека к AI, готовы ли люди в среднем ему доверять и можно ли испытывать к нему благодарность.

AI — это инструмент или социальный субъект?

Опубликованное в 1994 году исследование показало: пользователи не считали, что на компьютер распространяются социальные нормы… но при этом их использовали. Например, если после диалога с компьютером тот просил оценить диалог, испытуемые отвечали позитивнее, чем если поставить оценку предлагал кто-то третий (то есть не говорили ПК в лицо всю правду). Словом, реагировали на этот контакт как на социальную ситуацию.

AI-системы унаследовали это отношение; они инструменты, но и социальные субъекты тоже. В сравнении с обычными инструментами для той же задачи AI однозначно воспринимается как социальный субъект. Шахматный суперкомпьютер Deep Blue и сборник правил для игры в шахматы служат одной и той же цели — научиться играть. Но человек скорее проявит вежливость к Deep Blue, чем к учебнику. В целом люди склонны приписывать AI намерения, цели и даже «разум».

В том же исследовании участники рассмотрели AI-системы в разрезе модели стереотипного содержания (The Stereotype content model, SCM). Согласно SCM мы оцениваем незнакомца (или любой социальный субъект, которому приписываем некий мотив — животное, бренд, робота, чат-бота) по двум показателям:

-

какие у него намерения. Это так называемая «теплота» — благонадёжность и дружелюбие объекта. Оценка теплоты частично зависит от того, совпадают ли интересы наблюдателя и наблюдаемого. Если да — наблюдаемый скорее будет восприниматься как «тёплый».

-

способен ли он реализовать эти намерения. В понятие компетентности входят статус наблюдаемого, его потенциал и уверенность. Для AI дополнительным предиктором для оценки становится автономность. Если AI-система сравнительно автономна (выполняет более сложные операции, чем ввод-вывод), она скорее воспринимается как компетентная.

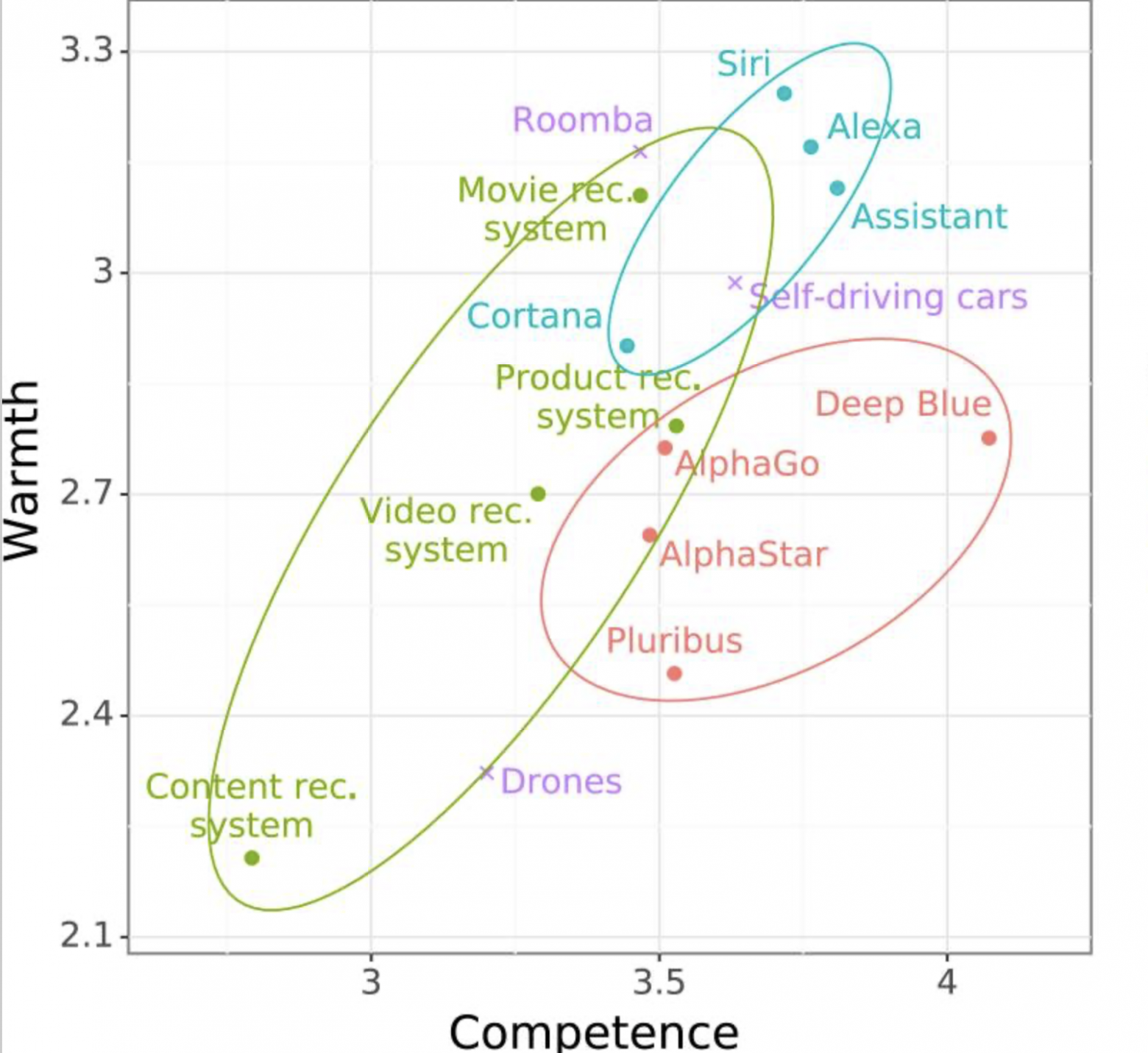

Участникам предоставили описания AI-систем трёх типов: AI-соперники в играх (например, программа для игры в го AlphaGo), виртуальные ассистенты (Siri и другие), рекомендательные системы (Amazon), а также три дополнительных примера — пылесос Roomba, самоуправляемые автомобили, дроны. Кроме того, в заключительном исследовании участники сыграли во вариант «диллемы заключённого» с AI-агентами. Конкретно — с многослойными перцептронами, настроенными на разные уровни сотрудничества. Это позволяло оценить, насколько совпадение интересов повлияет на оценку «теплоты» AI.

В свободной форме участники описывали AI-системы в тех же терминах, что и людей: коммуникабельность («самый скучный из помощников», моральность («несколько ненадёжный»), справедливость («непредвзятый»). Ещё один тест, где метрики SCM оценивали по пятибалльной шкале, позволил распределить системы по шкалам теплоты и компетентности.

Рекомендательные системы показали низкий уровень и теплоты, и компетентности; «игровые» AI — высокую компетентность, но низкую теплоту. Виртуальные ассистенты оказались в топе по обоим параметрам. При этом пылесос Roomba в восприятии участников более «тёплый», чем даже некоторые виртуальные ассистенты, хотя менее компетентный — возможно, как раз в силу низкой автономности.

Игра в «дилемму заключённого» дополнительно показала, что воспринимаемое «тепло» AI и вправду коррелирует с согласованностью интересов. Если AI-агент готов сотрудничать в игре, он кажется теплее. Подтвердилась и гипотеза, что компетентность зависит от автономности. Этот параметр отображался в интерфейсе: при низкой автономности испытуемый запускал агента вручную, при высокой AI начинал действовать сам.

Выходит, что AI — социальный субъект и соучастник коммуникации. По меньшей мере, мы считаем его таковым. По другим исследованиям, эмоциональную связь с AI, социальное присутствие и симпатию дополнительно увеличивают антропоморфные особенности — например, голосовая модальность. Человек оценивает AI так же, как любое существо, которому приписывает антропоморфные свойства… и благодарит виртуального ассистента, если понравился ответ.

Но если AI воспринимается как полноценный актор в коммуникации, выходит, что он должен нести вину за провалы. Или нет?

Считают ли люди, что AI отвечает за свои действия?

Краткий ответ: смотря кто принимал решение. Ещё одно исследование изучило, насколько AI-помощник в вождении считается ответственным за аварию. При опросе участники заявили, что скорее считают его инструментом. Вместе с тем оказалось, что даже самый простой AI-помощник разделяет ответственность с водителем — а вот обычные инструменты без искусственного интеллекта ответственности не несут.

В рамках исследования участники оценивали варианты одной и той же истории: автомобиль, водитель и AI-помощник в опасной ситуации. Но с разными деталями:

-

статус AI-помощника (активен или нет);

-

модальность AI (тактильные подсказки — например, вибрация рулевого колеса — или голосовой помощник);

-

результат гипотетической ситуации (авария произошла или её удалось избежать?).

Модальность никак не повлияла на ответы. Статус — предсказуемо да: если AI-ассистент был выключен, он ни за что не отвечает. Ключевым оказался результат пресловутой гипотетической ситуации. Если авария произошла, хотя AI-ассистент работал, ответственность водителя немного снижается, а AI-ассистента — повышается. А вот в кейсах, где аварию удалось предотвратить, AI-ассистент хвалят больше, чем человека. На ответственность человека исход ситуации не особо влияет. В другом исследовании этот эффект подтвердился: в случае плохого исхода мы виним AI меньше.

Распределение вины, возможно, коррелирует с ролью AI в управлении машиной. В сценарии, когда автомобилем в аварии совместно управляют человек и AI, вина искусственного интеллекта ниже, чем человека. Но существуют и сравнения автономных автомобилей с обычными, где за рулем человек. В этих случаях беспилотный транспорт оказывается более «виноватым», чем AI.

Можно предположить, что мы ждём от беспилотных автомобилей больше, чем от людей. Или сослаться на эффект «алгоритмической аверсии»: в целом люди скорее склонны реже прощать искусственному интеллекту ошибки. Этот эффект особенно силён там, где алгоритму поручают задачи с высокими ставками (например, в медицине или юриспруденции). Но когда человек и AI принимают решения совместно, человека винят больше. Особенно там, где за ним сохранялось право финального решения. Это результат наших социальных ожиданий — в сценариях, где есть человек, в случае неудачи к нему применяются более высокие стандарты. А какие стандарты можно применить к AI? Почему мы вообще ему доверяем?

…. и это очень хороший вопрос.

От чего зависит доверие к искусственному интеллекту?

Существует множество объективных факторов, которые, как считается, определяют нашу возможность доверять AI. Они варьируются от исследования к исследованию, но в сумме их можно свести к трём:

-

доброжелательность — этичность, справедливость и т.д.;

-

объективность — прозрачные стандарты, сертификация, государственное регулирование;

-

компетентность — устойчивость, надёжность, прозрачность.

Последний пункт — это отдельная большая тема объяснимого AI (Explainable AI, XAI). В большинстве современных сложных AI-решений система действует по принципу чёрного ящика: даже разработчик не может полностью объяснить, как конкретный входной сигнал превратился именно в этот вывод. Рассчитывается, что «объяснимый AI» повысит доверие конечного пользователя (и снизит угрозу искусственного интеллекта).

Вместе с тем это скорее технические и юридические факторы. А ведь в процессе формирования доверия есть ещё две важные стороны.

Во-первых, контекст, в котором происходит взаимодействие. Например, сложность задачи, репутация разработчика AI, специфика приложения.

Во-вторых, сам доверитель — человек, который имеет дело с AI. Ведь доверие зависит не только от того, кто перед нами, но и от того, каковы мы сами. Даже при контакте «человек — машина».

Интересный факт: у «доверия» и «надёжности» полной связи нет. К примеру, есть корреляция, но не причинно-следственная связь между качеством графического интерфейса программы и доверием к ней. Известно исследование, где интерфейс с визуализацией данных в электронной медицинской карте повысил уверенность врачей в инструменте, хотя его точность оставалась той же.

Таким образом, в развитии доверия важную роль играют эмоции. Это и предыдущий опыт человека (см. «алгоритмическая аверсия» ранее — в случае ошибки AI-системе труднее вернуть себе доверие). И черты его личности. Например:

-

Открытые люди доверяют AI чуть больше, чем закрытые. Экстраверты — больше, чем интроверты. Вместе с тем изначально склонные к доверию люди теряют более значительную часть доверия к системе после ошибки.

-

Согласно другому исследованию экстраверсия, открытость и доброжелательность положительно коррелируют с доверием к интерфейсу с поддержкой AI. А невротизм — отрицательно.

-

Негативно связан с доверием AI внутренний локус контроля (убеждённость человека, что его жизнь контролирует не он, а внешние силы). Видимо, при чувстве «у меня всё под контролем» отдавать этот контроль искусственному интеллекту хочется меньше.

-

Человек предпочитает AI, если полагает, что люди могут дискриминировать его по тому или иному признаку — в этих случаях алгоритмы кажутся ему объективнее (1, 2). С учётом проблемы предвзятости датасетов это довольно иронично.

Словом, вполне можно составить бинго.

Возраст и пол, культура и профессия, погружённость в технологии, склонность к аналитическому — всё это способно определить взгляд человека на AI-системы. Независимо от особенностей самих систем.

Зафиксированных правил, как относиться к искусственному интеллекту, не существует. Мы пробуем разные AI-модели и адаптируем их для собственных задач, включая задачу «жалобы на жизнь перед сном». Решаем, что готовы им доверить, а что лучше сделать самим. Некоторые даже на них женятся (эти уж точно верят в AI). Коллективное человечество пока не определило, чего ожидать от искусственного интеллекта и как стратегически регулировать его. Зато каждый что-то чувствует по этому поводу, пока запускает AI-чат-бота.

Автор: valentina-p