— Спейдвил, ты человек или больше, чем человек? — спросил Маскалл.

— Тот, кто не больше, чем человек — ничто.

— Откуда ты?

— Из размышлений, Маскалл. Никакая иная мать не может родить истину. Я размышлял и отвергал, и размышлял снова.Д. Линдсей, «Путешествие к Арктуру»

Каков основной вопрос современного SEO? «Как вывести сайт в ТОП по определенным запросам»? Ничего подобного. На самом деле самое важное — стоимость целевого посетителя, а вопрос звучит так: «Как привлечь максимальный целевой трафик за минимально возможные деньги?» И хотя доля контента в расходах на поисковое продвижение постоянно растет, основной статьей бюджета остаются ссылки. Купить их в нужных объемах можно только на биржах. Но когда дело доходит до конкретных действий, можно и нужно впасть в ступор. Сколько брать ссылок с тИЦ 10, 20, 500 и т.д. для продвижения определенного запроса — например, «литиевые батарейки» — в определенном промежутке времени? А ведь у ссылок и страниц-доноров куча важных характеристик, далеко не только один лишь тИЦ (например, описанная ниже система работает с 184 критериями). И по каждому нужно как-то получить оптимальное распределение и, в конечном итоге, создать соответствующую ссылочную массу согласно ему из слабодифференцированной кучи доноров, предлагающейся на биржах.

Закупка ссылок на глазок должна остаться в давно минувшем первом десятилетии XXI века. Да, набирая ссылки на приличных донорах можно вывести заранее оптимизированный сайт в ТОП, это не бог весть какая проблема. Однако потратить при таком подходе можно чуть ли не в 5 раз больше денег по сравнению с достижимым минимумом, а при достаточно высокой конкуренции это автоматически выбивает вас из битвы за первую десятку выдачи, если не из бизнеса в целом. К счастью, природа не терпит пустоты — если среди легионов легендарных школьников-сеошников есть ниша для научного подхода и математики, она будет заполнена.

Читать дальше

Новый подход к эмпиризму в SEO

Около двух лет назад мы решили разработать методику, выводящую экспериментальный подход к эффективности продвижения на новый уровень. Если базовые алгоритмы SeoPult работают на основе каскадов фильтров, подстраиваемых вручную нашими аналитиками согласно усредненным результатам опытов над большой, но все же ограниченной выборкой комплексов «акцептор-доноры», то новую систему было решено сделать: a) автоматической и основанной на сборе и обработке данных в реальном времени; b) работающей с конкретными запросами, а не с их группами; с) анализирующей намного больше факторов, чем это доступно живому специалисту; d) способной выделять факторы успеха текущих лидеров выдачи; e) способной применять эти факторы для закупки ссылочной массы, максимально приближенной по паттернам этих факторов к ссылочным массам лидеров-конкурентов по конкретным поисковым запросам.

Для разработки математических принципов технологии SeoPult Max были привлечены специалисты AlterTrader Research (основана в 2004 году как научно-исследовательская лаборатория, приоритетным направлением деятельности которой являлась разработка научных методов анализа финансовых рынков и технологий системного трейдинга. В настоящее время в компании три отдела: трейдинга, финансовой математики и поисковых исследований). Результатом стали две статьи и методика, к которым мы отсылаем любителей математики: «Алгоритм отбора максимально эффективного множества доноров для продвижения сайта в поисковых системах» и «Реализация и анализ эффективности метода построения оптимального множества доноров для продвижения сайта в поисковых системах». Ниже же мы представляем адаптированную для «Хабрахабра» версию популярной статьи Ильи Зябрева, Олега Пожаркова и Ирины Пожарковой.

Кстати, алгоритм является весьма требовательным — как к входящим данным, получаемым разнообразным и довольно-таки нетривиальным парсингом, так и к обработке. Даже для первичного запуска потребовался мини-кластер серверов, а сейчас, в связи с высокой востребованностью SeoPult Max и громадными объемами вычислений, приставка «мини» уже вряд ли уместна.

Частотные распределения

Рассмотрим пример — акцептор, на который проставлено 100 ссылок со страниц-доноров. Пусть тИЦ доноров — от 0 до 950. Разобьем отрезок 0...1000 на 10 равных частей (0-90, 100-190 и т.д.) и посчитаем, сколько значений тИЦ доноров попало в каждую из них.

| тИЦ | Частота |

|---|---|

| 0-90 | 50 |

| 100-190 | 28 |

| 200-290 | 7 |

| 300-390 | 4 |

| 400-490 | 3 |

| 500-590 | 2 |

| 600-690 | 2 |

| 700-790 | 2 |

| 800-890 | 1 |

| 900-990 | 1 |

| Итого | 100 |

У акцептора из примера 50 доноров, у которых тИЦ попадает в интервал от 0 до 90, 28 — с тИЦ попадает от 100 до 190 и т.д. Частоты показаны абсолютные, но зачастую удобнее использовать относительные частоты, которые в данном случае показывают долю доноров, тИЦ которых попадает в соответствующий интервал. Для перехода к относительным частотам необходимо разделить абсолютные частоты на общее количество доноров, т.е. в данном случае на 100.

| тИЦ | Относительная частота |

|---|---|

| 0-90 | 0,50 |

| 100-190 | 0,28 |

| 200-290 | 0,07 |

| 300-390 | 0,04 |

| 400-490 | 0,03 |

| 500-590 | 0,02 |

| 600-690 | 0,02 |

| 700-790 | 0,02 |

| 800-890 | 0,01 |

| 900-990 | 0,01 |

| Итого | 1 |

По каждому фактору (мы используем 184 фактора, которые выделили на основании проведенных ранее экспериментов, выявляющих влияние качеств доноров на изменение позиций тестовых акцепторов) можно построить распределение. Для построения одного распределения требуется выделить фактор, взять один акцептор и все его доноры. Мы получим 184 распределения для анализируемого акцептора, которые образуют частотный паттерн, очень конкретную и четкую характеристику ссылочной массы (то есть совокупности доноров).

Алгоритм, реализованный в SeoPult Max, строит частотные паттерны для ТОП-50 выдачи «Яндекса» по заданному запросу. При этом составляется 50 х 184 = 9200 распределений факторов для получения 50 частотных паттернов. На основе этих распределений строится «идеальный» частотный паттерн лидера выдачи по определенному поисковому запросу, который также состоит из 184 распределений. По каждому из факторов, «идеальный» частотный паттерн обладает свойствами, явно выраженными в ТОП-10 (с усилением к ТОП-3) и, как правило, слабее выраженными вне топа.

Пример работы с отдельными факторами

Для примера покажем принцип расчета по трем факторам:

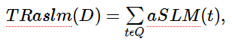

TRaslm — релевантность донора заданному поисковому запросу. На странице донора в анкоре ссылки на акцептор могут быть слова нашего запроса. Также такие слова могут быть и в тексте страницы-донора, или же на ней стоят аналогичные ссылки на другие сайты. С точки зрения поисковой системы релевантность донора запросу будет явно больше нуля. Фактор TRaslm считается на основе формулы релевантности aSLM:

"

"

где t — леммы слов донора D,

Q — множество лемм слов запроса,

aSLM — аппроксимированная спектральная языковая модель.

Другими словами TRaslm — это сумма значений aSLM лемм донора, которые встречаются в запросе. Лемма в данном случае — каноническая форма слова.

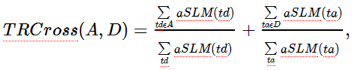

TRCross — индекс взаимной релевантности донора и акцептора, который можно еще назвать «псевдотематичностью». Считается для связки донор-акцептор. Тексты донора и акцептора могут пересекаться по какому-то набору слов. Для каждого слова из текста вычисляется значение релевантности документа запросу «слово». Сумма таких релевантностей по пересечению слов в текстах донора и акцептора, деленная на сумму всех релевантностей слов из текстов, и даст значение TRCross. Формула для фактора выглядит так:

где td — леммы слов донора D,

ta — леммы слов акцептора A.

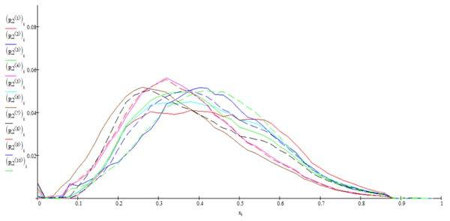

HostDist — «расстояние» между хостами. Считается для связки донор-акцептор на основании их IP-адресов. Данное расстояние используется «Яндексом» для вычисления фактора HostRank. Формула фактора:

где n — целое число от 0 до 31, номер старшего бита, на котором различаются IP-адреса хостов донора D и акцептора A. Если IP-адреса совпадают, то HostDist(A,D)=0.

Посчитаем эти факторы для конкретного запроса «продвижение сайтов». На момент написания этой статьи коллективом AlterTrader Research ТОП-10 выдачи «Яндекса» выглядел следующим образом (мы взяли 10 первых сайтов по запросу, без учета «спектральной» примеси).

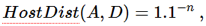

Распределения рассматриваемых акцепторов-лидеров по каждому из факторов можно свести в один график.

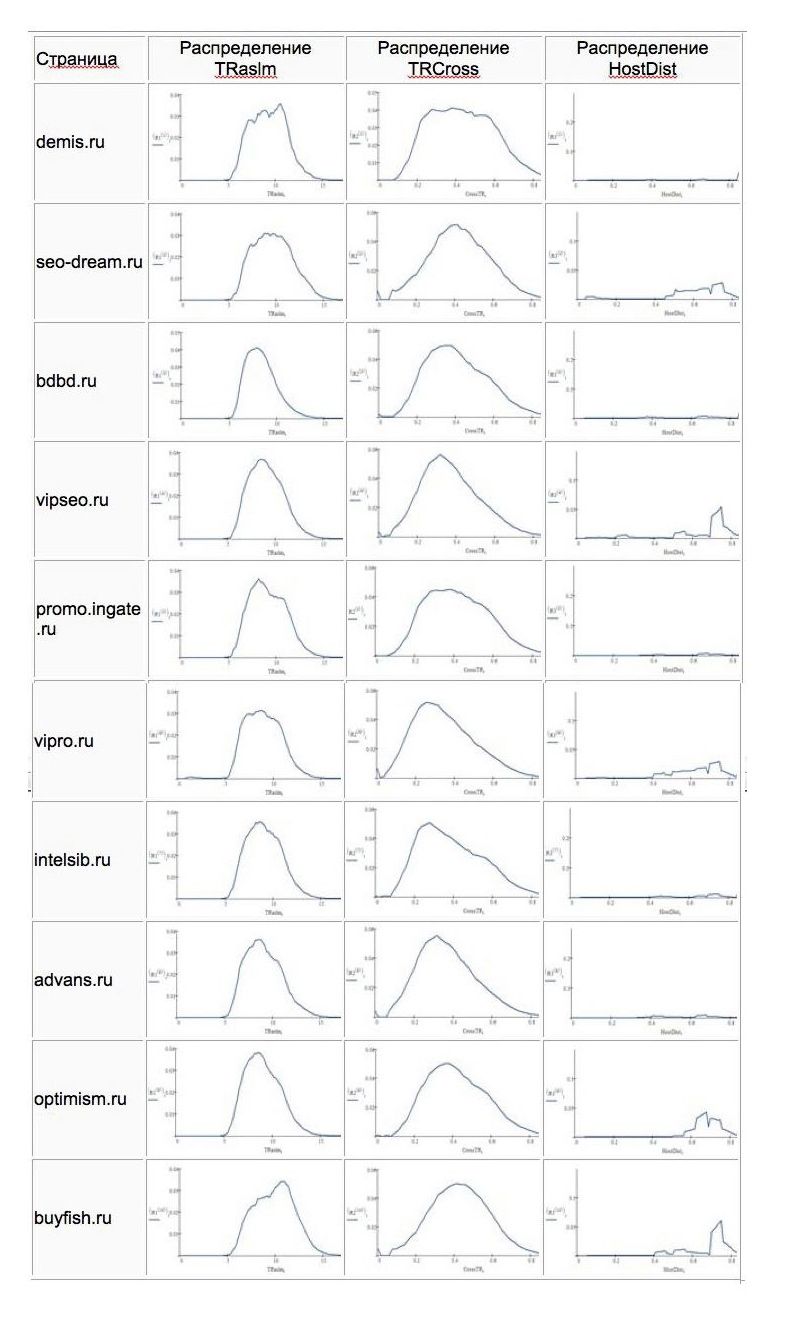

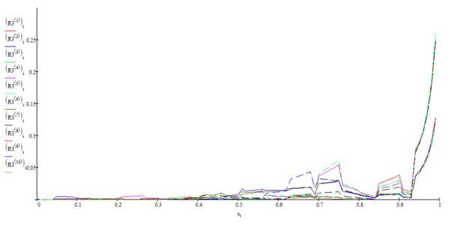

1. Распределения по фактору TRaslm

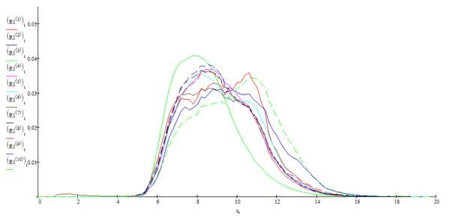

2. Распределения по фактору TRCross

3. Распределения по фактору HostDist

Графики, построенные для каждого сайта из ТОП-10, имеют схожий вид, на основании чего можно выделить для каждого из факторов закономерность и построить «идеальный» частотный паттерн.

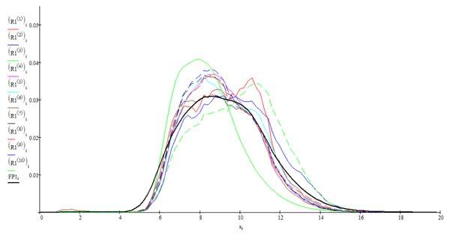

Пример: «Идеальный» частотный паттерн для фактора TRaslm

Если мы построим аналогичные усредненные паттерны по каждому фактору для сайтов, находящихся за пределами ТОП-10, то получим значительные отклонения от идеальных паттернов лидеров, причем чем дальше от ТОП, тем отклонения будут сильнее. Реализованный в SeoPult Max алгоритм способен свести отклонение к минимуму, изменив ссылочную массу акцептора таким образом, чтобы ее паттерн соответствовал паттернам текущих лидеров выдачи «Яндекса» по конкретному поисковому запросу.

В настоящее время все клиенты SeoPult могут подлючить к своим проектам алгоритм SeoPult Max, который проводит такой анализ по 184 факторам, при этом постоянно отслеживается соответствие распределений текущему паттерну. Перестройка множества доноров происходит в рамках заданного бюджета и принципа минимальных изменений уже существующего множества.

Вывод

«Размышление должно протекать в прохладе и в покое, а наши бедные сердца слишком сильно колотятся, наш слишком горяч для этого», — писал Мелвилл в «Моби Дике». Кустарный, «слишком человеческий» подход к продвижению в 2013-м не даст оптимальных результатов — только сложные математические методы обработки большого количества информации (кстати, получить ее тоже не так просто) позволяют выработать гарантированно оптимальную последовательность действий.

Автор: JuliS