Тысячи компаний используют cервис машинного зрения Rekognition от Amazon для поиска непристойных изображений и видеороликов, загружаемых пользователями

Противоречивая технология Rekognition от Amazon уже используется для удаления изображений половых членов с сайтов, посвящённых еде. По крайней мере, это один из примеров её использования. В какой-то момент лондонский сервис по доставке еды Deliveroo столкнулся с проблемами модерации контента. В случае проблем с едой клиенты Deliveroo отправляют фотографию еды вместе с жалобой. И часто они занимаются фотобомбингом при помощи своих гениталий. Или составляют из еды непристойные картинки. Да, серьёзно.

И так получается, что сотрудники Deliveroo не всегда хотят сталкиваться с таким контентом. Поэтому компания использует Rekognition для распознавания непристойных фотографий, и размывает или удаляет их перед тем, как их увидит человек.

Проблема Deliveroo представляет несколько странную грань постепенно усложняющейся проблемы. Так или иначе, многие интернет-компании основываются на контенте, создаваемом пользователями. В последние годы мы всё чаще сталкиваемся с проникновением в этот контент тёмной стороны человеческой натуры. Модерация контента стала приоритетом, поскольку сайты всё чаще сталкиваются с такими неприятными материалами, как фальшивые новости, насилие, дипфейки, травля, агрессивная риторика и другим токсичным контентом, создаваемым пользователями. Если вы – Facebook, то для решения этой проблемы вы можете разработать собственный ИИ или нанять армию модераторов – или сделать и то и другое. Однако у компаний меньшего размера с небольшим количеством ресурсов часто нет такой возможности. Вот тут им и приходит на помощь сервис модерации контента от Amazon.

Этот сервис является частью пакета услуг по компьютерному зрению Rekognition, предоставляемого Amazon Web Services. Его много ругали в прессе за то, что компания согласилась предоставлять услуги по распознаванию лиц для миграционной службы США. На сайте Rekognition вы можете найти и другие примеры применения сервиса для слежки – к примеру, способность распознавать автомобильные номера, снятые под разными углами на видео, или отслеживать путь человека по записям с камер.

Возможно, в поисках более позитивного образа сервиса компьютерного зрения, Amazon впервые заговорила об использовании Rekognition для надзора над пользовательским контентом с целью отсева насилия и непотребств. Сервис позволяет распознавать небезопасный или неприятный контент на изображениях и видеороликах, загружаемых на сайт.

И этот бизнес растёт. «Роль создаваемого пользователями контента растёт взрывными темпами год от года – сегодня мы уже делимся в соцсетях с нашими друзьями и родственниками 2-3 картинками ежедневно», — говорит мне вице-президент Amazon по ИИ, Свами Шивасубраманьян. Шивасубраманьян говорит, что Amazon начала предлагать сервис по модерированию контента в ответ на запрос клиентов ещё в 2017 году.

Компании могут платить за Rekognition вместо найма людей для изучения загружаемых изображений. Как и другие сервисы с AWS, он работает по модели оплаты за использование, а его стоимость зависит от количества обработанных нейросетью изображений.

Неудивительно, что среди первых пользователей управления контентом оказались сервисы знакомств – им необходимо быстро обрабатывать загружаемые в профили пользователей селфи. Amazon говорит, что сайты знакомств Coffee Meets Bagel и Shaadi используют этот сервис именно для этой цели – как и португальский сайт Soul, помогающий людям создавать сайты знакомств.

ИИ ищет не только обнажёнку. Нейросеть обучили распознавать всякий сомнительный контент, включая изображения оружия или насилия, или в целом неприятные образы. Вот меню классификации с сайта Rekognition:

Явная нагота:

- обнаженное тело;

- графическое изображение обнаженного мужского тела;

- графическое изображение обнаженного женского тела;

- действие сексуального характера;

- демонстрация наготы или действия сексуального характера;

- игрушки для взрослых.

Подозрительный контент:

- женский купальник или нижнее белье;

- мужские плавки или нижнее белье;

- частично обнаженное тело;

- откровенная одежда.

Контент, демонстрирующий насилие:

- графическое изображение насилия или крови;

- физическое насилие;

- насилие с использованием оружия;

- оружие;

- нанесение себе травм.

Визуальный контент, вызывающий беспокойство:

- истощенные тела;

- трупы;

- повешение.

Как это работает

Как и всё на AWS, Rekognition работает в облаке. Компания может сообщить сервису, какого рода изображения ей нужно находить. Потом она скармливает полученные от пользователей фото и видео – которые во многих случаях и так могут храниться на серверах AWS.

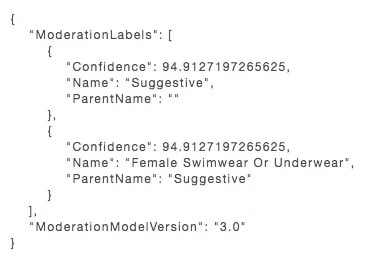

Нейросеть обрабатывает изображения, ищут этот контент и отмечают любые потенциально неприятные. Нейросеть выдаёт метаданные, описывающие содержимое изображений, вместе с процентным показателем уверенности в выданных метках. Выглядит это примерно так:

Эти данные обрабатывает уже программа на стороне клиента, которая и решает, на основании запрограммированных бизнес-правил, что делать с обработанным изображением. Оно может автоматически удалить его, пропустить, размыть его часть, или отправить модератору на рассмотрение.

У глубоких нейросетей, обрабатывающих изображение, есть множество слоёв. Каждый из них оценивает данные, представляющие различные аспекты изображений, проводит вычисления и отправляет результат в следующий слой. Сначала сеть обрабатывает низкоуровневую информацию типа базовых форм или наличия на изображении человека.

«Затем она последовательно всё сильнее уточняет данные, следующие слои становятся всё более конкретными, и так далее», — поясняет Шивасубраманьян. Постепенно, слой за слоем, нейросеть определяет содержимое изображений со всё увеличивающейся определённостью.

Вице-президент AWS по ИИ Мэтт Вуд говорит, что его команда обучает модели компьютерного зрения на миллионах как частных, так и общественно доступных изображений из разных наборов. Он говорит, что Amazon не использует для этой цели изображения, полученные от пользователей.

Кадр за кадром

Некоторые из крупнейших клиентов Rekognition не используют этот сервис для модерации контента, создаваемого пользователями. Amazon говорит, что крупные медиакомпании с огромными библиотеками цифровых видео хотят узнать содержимое каждого кадра из этих роликов. Нейросеть Rekognition может обработать каждую секунду видео, описать его при помощи метаданных и отметить потенциально опасные изображения.

«Одна из задач, с которой машинное обучение справляется хорошо – это залезать в видео или изображения и давать дополнительный контекст, — говорит мне Вуд. – Оно может сказать, что ’на этом видео женщина идёт по берегу озера с собакой’, или ’изображён частично одетый мужчина’». В таком режиме, говорит он, нейросеть способна распознать опасный, токсичный или непотребный контент на изображениях с высокой точностью.

И всё же эта область компьютерного зрения пока не достигла своей зрелости. Учёные ещё обнаруживают новые способы оптимизации алгоритмов нейросетей, чтобы те могли распознавать изображения ещё точнее и детальнее. «Мы пока не дошли до состояния уменьшающихся прибылей», — говорит Вуд.

Шивасубраманьян сказал мне, что только в прошлом месяце команда, работающая над компьютерным зрением, уменьшила количество ложно-положительных срабатываний (когда изображение по ошибке признаётся опасным) на 68%, а количество ложно-отрицательных – на 36%. «У нас есть возможность улучшать точность этих API», — говорит он.

Кроме точности, клиенты просят более детальной классификации изображений. На сайте AWS написано, что сервис даёт только основную категорию и одну подкатегорию небезопасных изображений. Поэтому, к примеру, система может выдать, что на изображении содержится обнажённая натура как основную категорию, и сексуальные действия как подкатегорию. Третья подкатегория может содержать классификацию типа сексуальных действий.

«Пока что машина склонна к фактам и работает буквально – она расскажет вам, что ’там изображено вот это’, — говорит Пьетро Перона, профессор вычислений и нейронных систем из Калтеха, советник AWS. – Но учёным хотелось бы выйти за эти рамки, и сообщать не только о том, что там изображено, но и о том, что думают эти люди, что происходит. В итоге эта область хочет развиваться именно в этом направлении – не просто выдавать список изображённого на картинке».

И такие тонкие отличия могут быть важными для модерации контента. Содержится ли на изображении потенциально оскорбительный контент или нет, может зависеть от намерений изображённых там людей.

Даже сами определения «небезопасных» и «оскорбительных» изображений довольно размыты. Они могут меняться со временем и зависеть от географического региона. А контекст – это всё, поясняет Перона. Хорошим примером служат изображения насилия.

«Насилие может быть неприемлемым в одном контексте, как, например, реальное насилие в Сирии, — говорит Перона, — но приемлемым в другом, как футбольный матч или сцена из фильма Тарантино».

Как и в случае с другими сервисами AWS, Amazon не просто продаёт инструмент модерации контента другим: она и сама является своим клиентом. Компания говорит, что использует этот сервис для сортировки создаваемого пользователями контента в изображениях и видеороликах, прикладываемых к обзорам в магазине.

Автор: Вячеслав Голованов