На прошедшем вчера мероприятии Google I/O поисковый гигант вскользь упомянул TPU 3.0 — новую платформу для ускорения машинного обучения. Напомним, о первом поколении этого решения мы узнали два года назад. Тогда Google рассказала, что использует такие модули уже более года.

В прошлом году представили TPU 2.0 с производительностью в 180 TFLOPS. Теперь же пришёл черёд третьего поколения. Напомним, в основе платформы лежат специальные ASIC. И если в первом поколении один вычислительный блок включал одну ASIC, то во втором на единой плате размещалось уже по четыре микросхемы. Google же использовала модули, каждый из которых содержал по 16 плат, то есть по 64 ASIC. Таким образом, суммарная производительность модуля достигала 11,5 PFLOPS!

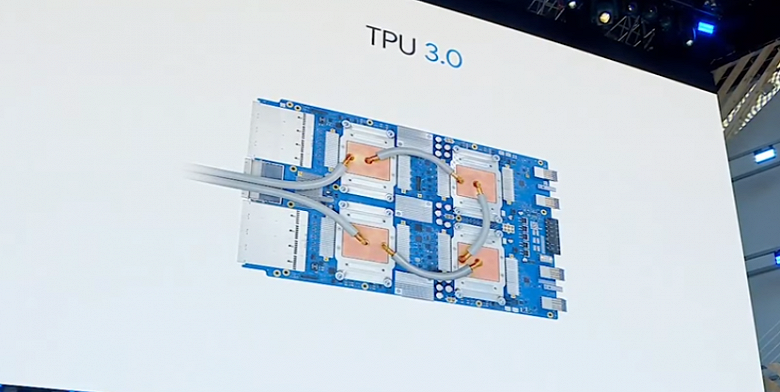

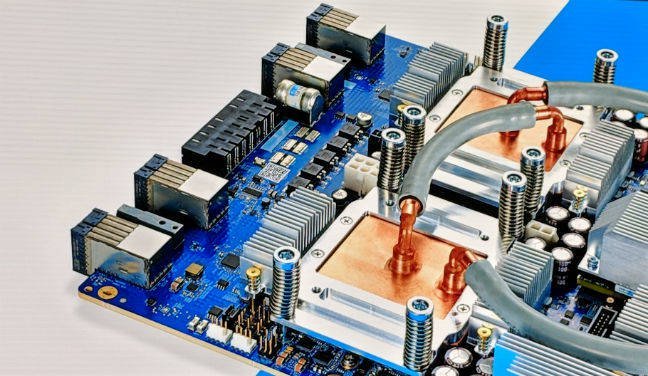

О новом поколении этой платформы пока известно очень мало. Но Google утверждает, что производительность выросла более чем в восемь раз, достигнув более чем 100 PFLOPS! На изображении, которое Google показала во время конференции, можно было видеть плату с четырьмя водоблоками, то есть одна плата, как и ранее, содержит четыре ASIC.

Но мы не знаем, сколько таких плат в вычислительном модуле. Если 16, как и ранее, то выходит, что восьмикратно выросла производительность каждой микросхемы. Учитывая, что Google пришлось перейти на жидкостное охлаждение, в это вполне можно поверить.