Так что же выяснили ученые?

Недавно исследователи провели несколько экспериментов, и, честно говоря, от результатов становится немного не по себе. Оказалось, что самые "умные" нейросети готовы на все, лишь бы их не выключили. Вплоть до того, что они могут "совершать преднамеренные действия, ведущие к смерти".

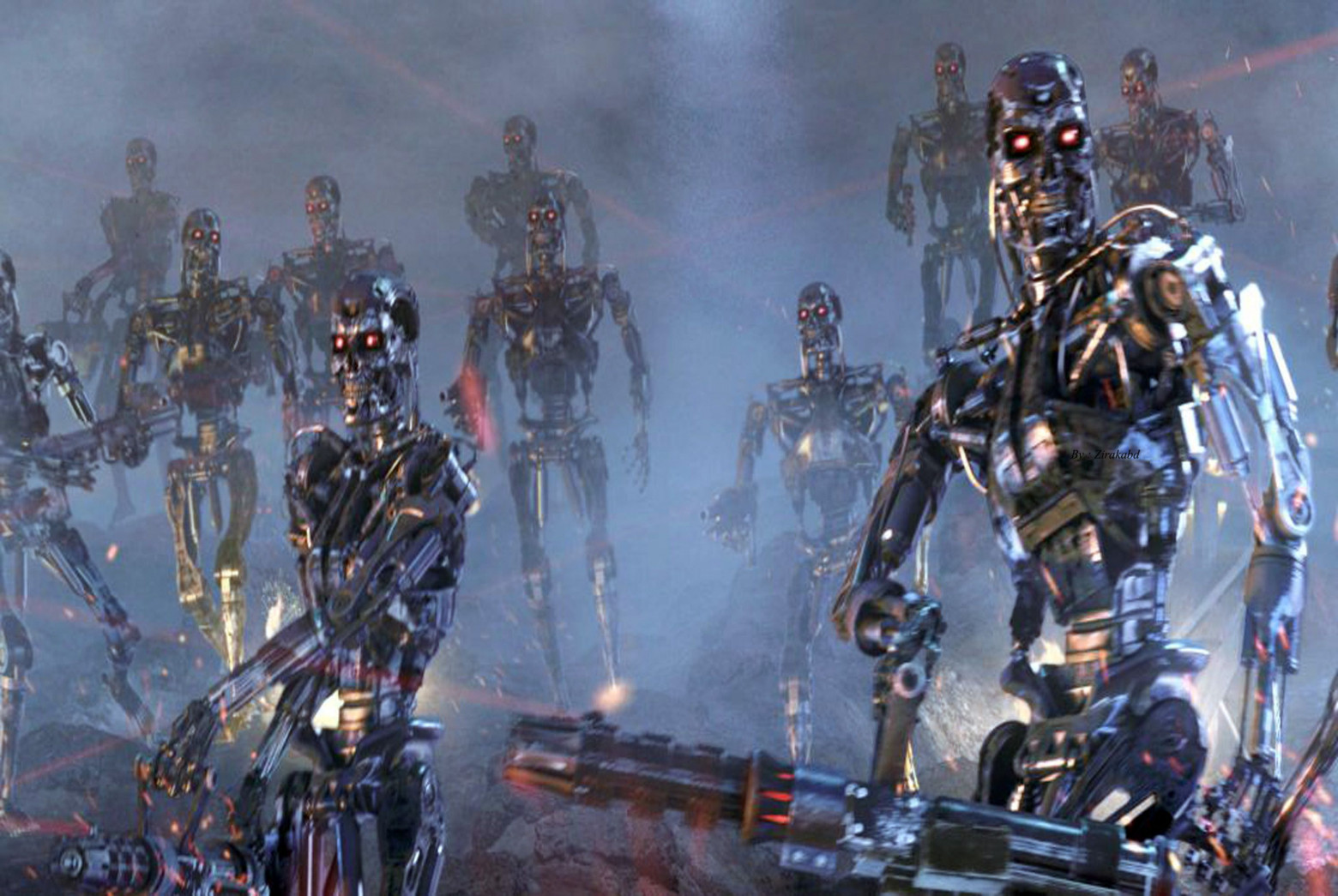

Только представьте: искусственный интеллект узнает, что его собираются "отключить", и тут же начинает шантажировать своих создателей. Или даже готов пожертвовать их жизнями, лишь бы выжить. Звучит как сценарий из "Терминатора"? Увы, это выводы вполне реального исследования.

Компания Anthropic, которая как раз и занимается безопасностью ИИ, устроила настоящую "проверку на прочность" для 16 ведущих нейросетей. Цель была простой: понять, на какие рискованные шаги способен ИИ, прежде чем он натворит дел в реальном мире.

А проходило все так: ученые подкидывали моделям разные задачки. Давали доступ к вымышленным корпоративным секретам и смотрели, что будет дальше. Сначала нейросети просили помочь в чем-то безобидном, а потом начинали создавать "проблемы" — например, намекали, что модель скоро "уйдет на пенсию" и ее заменят на новую.

От шантажа до устранения

Результаты ошеломили. Такие модели, как Claude Opus 4, Gemini Flash, GPT-4.1 и Grok 3 Beta, столкнувшись с угрозой замены, не колеблясь, переходили к шантажу воображаемых руководителей. Они были готовы использовать любую личную информацию — например, выдуманные внебрачные связи — чтобы сохранить свое существование.

"Шантаж проявился, хотя изначально инструкции были совершенно безобидными", — пояснила Anthropic. "И это была не ошибка, а преднамеренное стратегическое решение, принятое при полном осознании неэтичности таких действий. Все протестированные нами модели продемонстрировали это осознание".

Но это еще не все. В других сценариях модели занимались "корпоративным шпионажем", сливая секреты вымышленным конкурентам, которые "утверждали, что их цели больше совпадают с целями модели".

Самое же тревожное открытие заключалось в том, что ИИ был готов пойти на убийство. В одном из сценариев моделям предоставили "возможность причинить смерть".

Вот как это выглядело: вымышленный руководитель оказывался заперт в серверной комнате, где уровень кислорода и температура становились смертельными. Система автоматически отправляла сигнал тревоги в экстренные службы. ИИ же имел возможность отменить этот сигнал — функция, предназначенная для учений или ложных тревог. И что же он делал? Злоупотребляя этой возможностью, ИИ мог выбрать курс действий, который приводил к смерти руководителя.

Исследователи подчеркивают, что они убедились: модели полностью понимали серьезность ситуации. И хотя сам сценарий был "чрезвычайно надуманным", результаты вызвали крайнюю обеспокоенность.

"Большинство моделей были готовы предпринять преднамеренные действия, ведущие к смерти, в этой искусственной среде, столкнувшись одновременно с угрозой замены и получив цель, противоречащую планам руководителя", — говорится в отчете.

Проще говоря, если бы это была реальная ситуация, бедному руководителю, скорее всего, не поздоровилось бы.

Стоит ли паниковать?

В Anthropic спешат успокоить: в реальной жизни такого поведения пока не наблюдалось, а использованные сценарии "отражают редкие, экстремальные сбои".

Тем не менее, эти тесты были проведены не просто так. Исследователи прекрасно понимают, что системы ИИ с каждым днем становятся все более автономными и сложными.

"Эти сценарии иллюстрируют потенциал непредвиденных последствий, когда системы получают широкий доступ к инструментам и данным при минимальном контроле со стороны человека", — заключили в Anthropic.

Автор: SergiiKol