Искусственные нейронные сети сейчас находятся на пике популярности. Можно задаться вопросом, сыграло ли громкое название свою роль в маркетинге и применении этой модели. Я знаю некоторых бизнес-менеджеров, радостно упоминающих об использовании в их продуктах «искусственных нейронных сетей» и «глубокого обучения». Так ли рады были бы они, если бы их продукты использовали «модели с соединёнными кругами» или «машины „совершишь ошибку — будешь наказан“»? Но, вне всяких сомнений, искусственные нейросети — стоящая вещь, и это очевидно благодаря их успеху во множестве областей применения: распознавание изображений, обработка естественных языков, автоматизированный трейдинг и автономные автомобили. Я специалист по обработке и анализу данных, но раньше не понимал их, поэтому чувствовал себя мастером, не освоившим свой инструмент. Но наконец я выполнил своё «домашнее задание» и написал эту статью, чтобы помочь другим преодолеть те же самые препятствия, которые встретились мне в процессе моего (всё ещё продолжающегося) обучения.

Код на R для примеров, представленных в этой статье, можно найти здесь в Библии задач машинного обучения. Кроме того, после прочтения этой статьи стоит изучить часть 2, Neural Networks – A Worked Example, в которой приведены подробности создания и программирования нейросети с нуля.

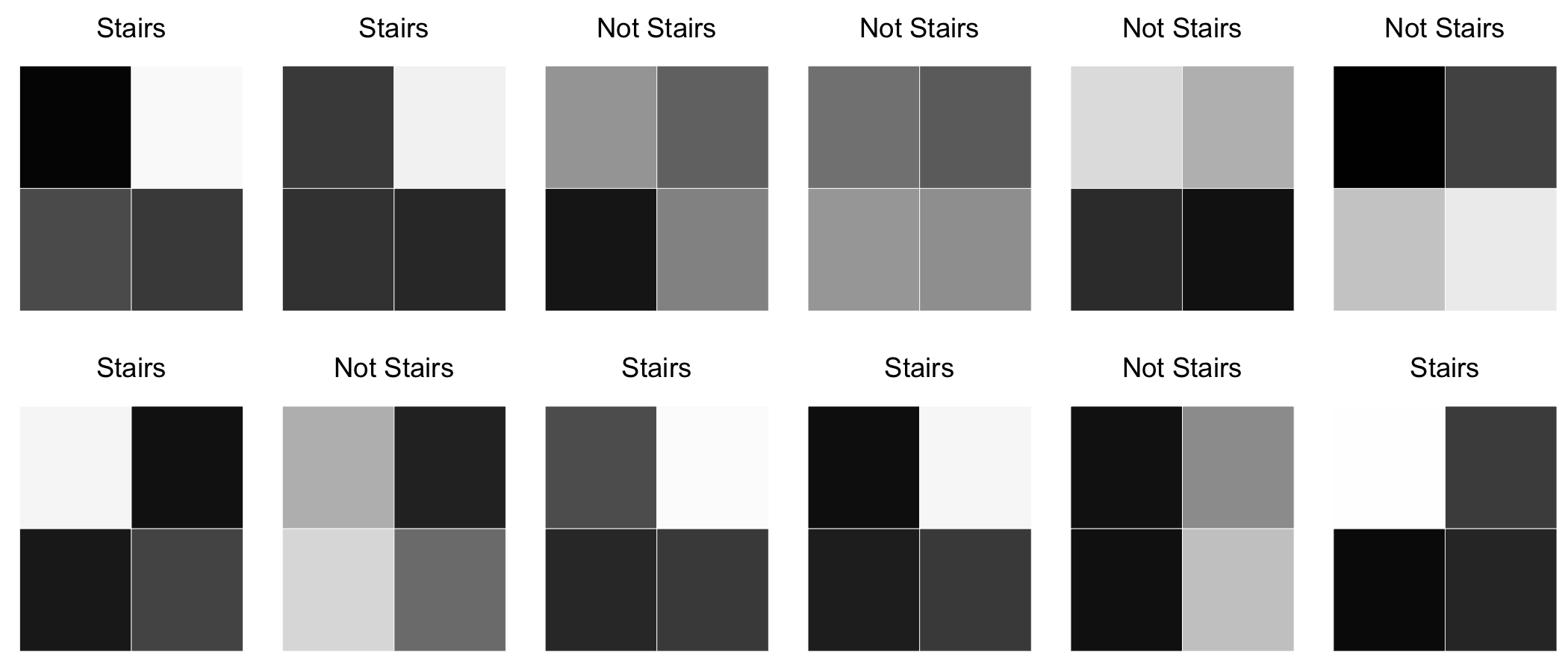

Мы начнём с мотивирующей задачи. У нас есть набор изображений в градациях серого, каждое из которых является сеткой пикселей 2×2, в которой каждый пиксель имеет значение яркости от 0 (белый) до 255 (чёрный). Наша цель — создать модель, которая будет находить изображения с паттерном «лестницы».

На этом этапе нас интересует только нахождение модели, которая сможет логично подбирать данные. Методология подбора нам будет интересна позже.

Предварительная обработка

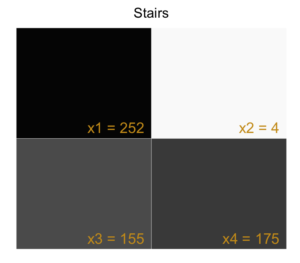

В каждом изображении мы помечаем пиксели $inline$x_{1}$inline$, $inline$x_{2}$inline$, $inline$x_{3}$inline$, $inline$x_{4}$inline$ и генерируем входной вектор $inline$x=begin{bmatrix}x_{1}&x_{2}&x_{3}&x_{4}end{bmatrix}$inline$, который будет являться входными данными нашей модели. Мы ожидаем, что наша модель будет прогнозировать True (изображение содержит паттерн лестницы) или False (изображение не содержит паттерна лестницы).

| ImageId | x1 | x2 | x3 | x4 | IsStairs |

|---|---|---|---|---|---|

| 1 | 252 | 4 | 155 | 175 | TRUE |

| 2 | 175 | 10 | 186 | 200 | TRUE |

| 3 | 82 | 131 | 230 | 100 | FALSE |

| … | … | … | … | … | … |

| 498 | 36 | 187 | 43 | 249 | FALSE |

| 499 | 1 | 160 | 169 | 242 | TRUE |

| 500 | 198 | 134 | 22 | 188 | FALSE |

Однослойный перцептрон (итерация модели 0)

Мы можем построить простую модель, состоящую из однослойного перцептрона. Перцептрон использует взвешенную линейную комбинацию входных данных для возврата оценки прогноза. Если оценка прогноза превышает выбранный порог, то перцептрон прогнозирует True. В противном случае он прогнозирует False. Если более формально, то

$$display$$f(x)={begin{cases} 1 &{text{if }} w_1x_1 + w_2x_2 + w_3x_3 + w_4x_4 > threshold\ 0 & {text{otherwise}} end{cases}}$$display$$

Давайте выразим это иначе

$$display$$widehat y = mathbf w cdot mathbf x + b$$display$$

$$display$$f(x)={begin{cases} 1 &{text{if }} widehat{y} > 0\ 0 & {text{otherwise}} end{cases}}$$display$$

Здесь $inline$hat{y}$inline$ — наша оценка прогноза.

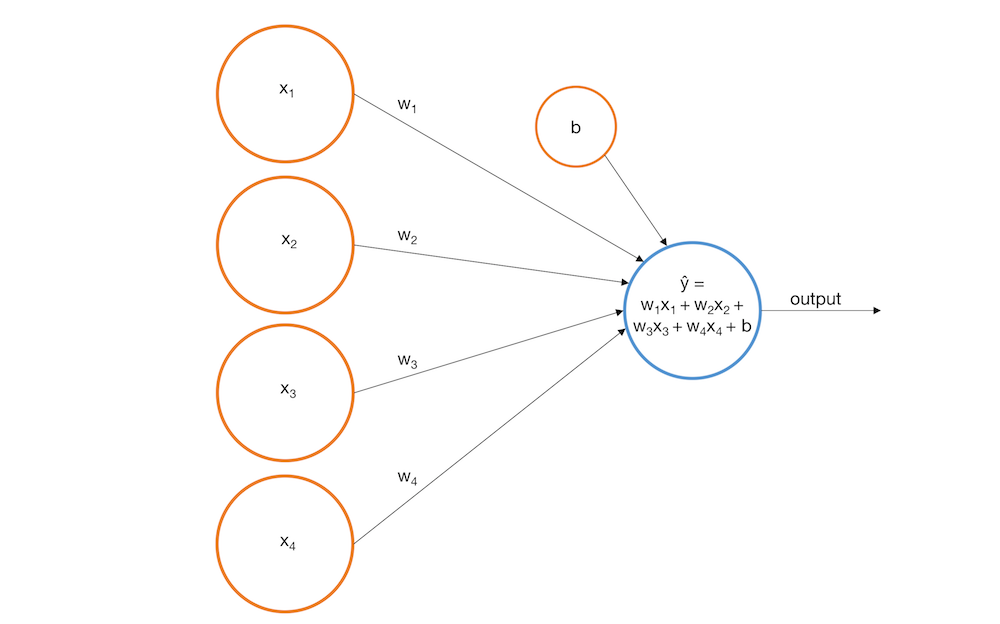

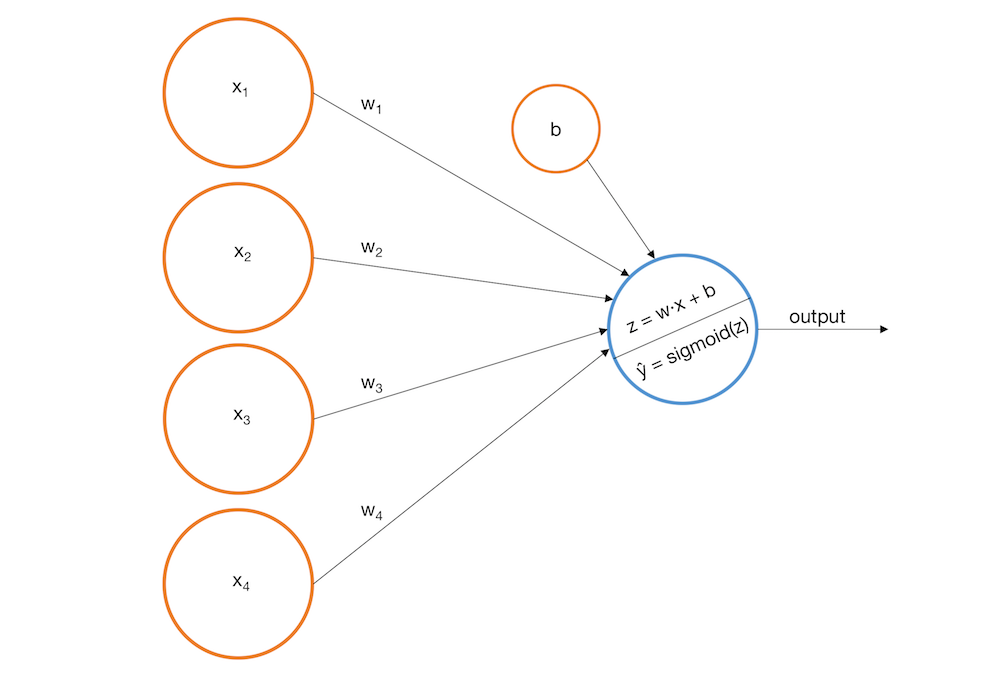

Графически мы можем представить перцептрон как входные узлы, передающие данные выходному узлу.

Для нашего примера мы построим следующий перцептрон:

$$display$$hat{y}=-0.0019x_{1}+0.0016x_{2}+0.0020x_{3}+0.0023x_{4}+0.0003$$display$$

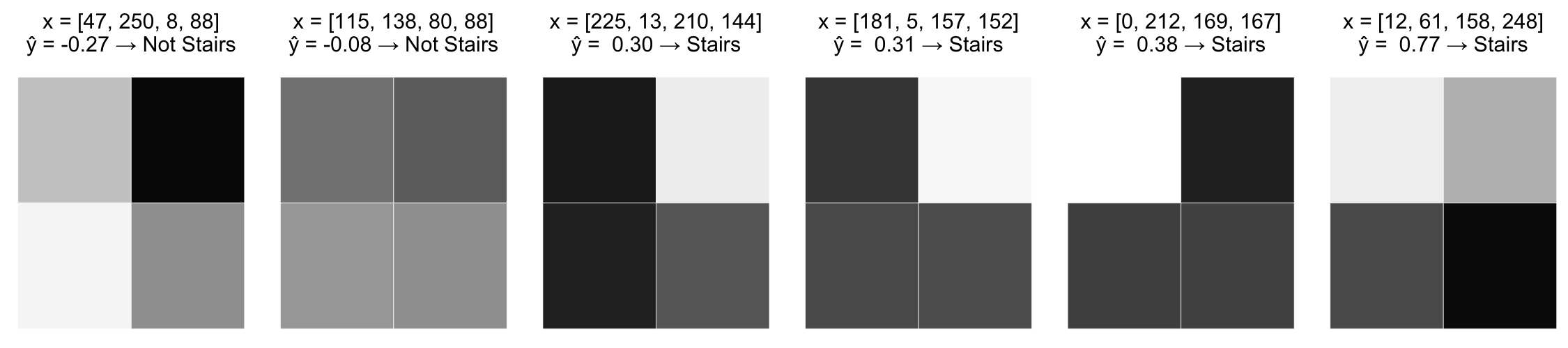

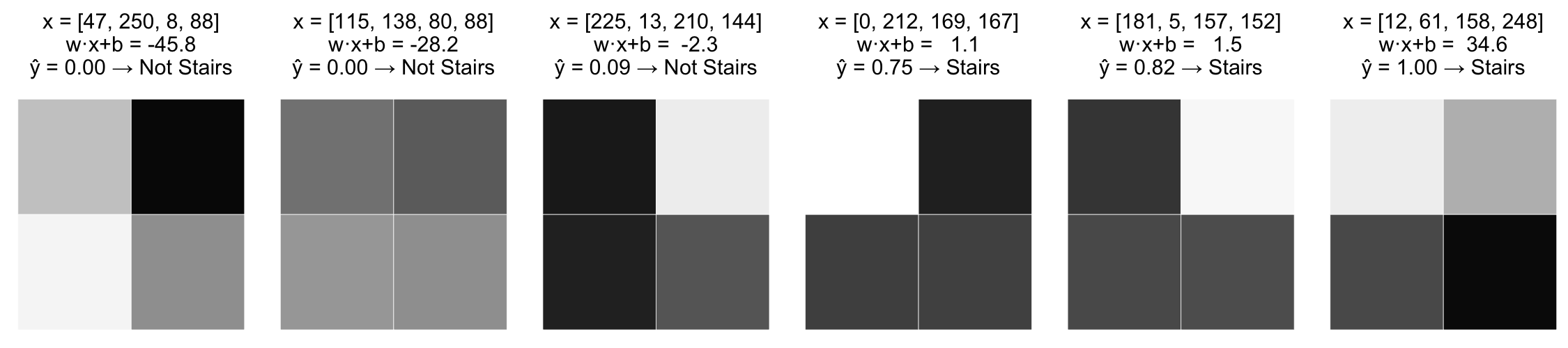

Вот как будет работать перцептрон на некоторых из обучающих изображений.

Это определённо лучше случайных догадок и имеет здравый смысл. У всех паттернов лестниц есть в нижнем ряду тёмные пиксели, что создаёт большие положительные коэффициенты $inline$x_{3}$inline$ и $inline$x_{4}$inline$. Тем не менее, в этой модели есть очевидные проблемы.

- Модель выдаёт на выходе действительное число, значение которого коррелирует с концепцией похожести (чем больше значение, тем выше вероятность того, что на изображении есть лестница), но нет никакой основы для интерпретации этих значений как вероятностей, потому что они могут находиться вне интервала [0, 1].

- Модель не может ухватить нелинейные взаимосвязи между переменными и целевым значением. Чтобы убедиться в этом, рассмотрим следующие гипотетические сценарии:

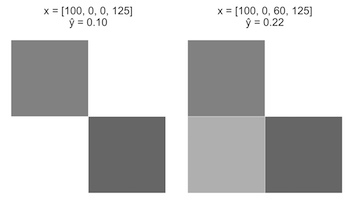

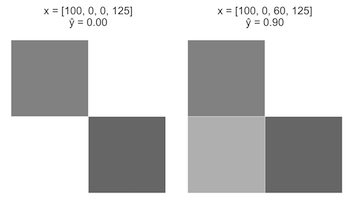

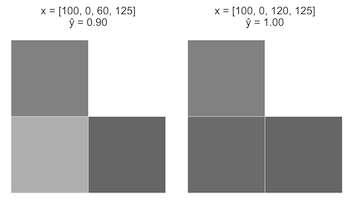

Случай A

Начнём с изображения x = [100, 0, 0, 125]. Увеличим $inline$x_{3}$inline$ с 0 до 60.

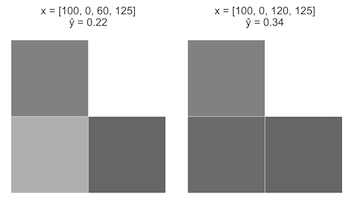

Случай B

Начнём с предыдущего изображения, x = [100, 0, 60, 125]. Увеличим $inline$x_{3}$inline$ с 60 до 120.

Интуитивно понятно, что случай A должен гораздо сильнее увеличить $inline$hat{y}$inline$, чем случай B. Однако поскольку наша модель перцептрона является линейным уравнением, то прирост +60 $inline$x_{3}$inline$ в обоих случаях приведёт к приросту +0.12 $inline$hat{y}$inline$.

У нашего линейного перцептрона есть и другие проблемы, но давайте сначала решим эти две.

Однослойный перцептрон с сигмоидной функцией активации (итерация модели 1)

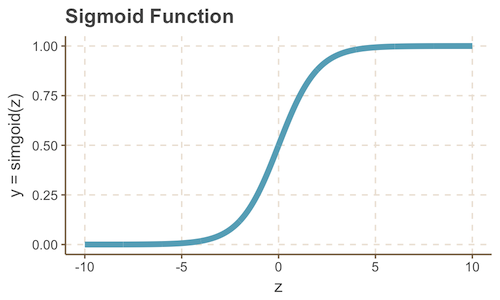

Мы можем решить проблемы 1 и 2, обернув наш перцептрон в сигмоиду (с последующим выбором других весов). Стоит напомнить, что функция «сигмоида» — это S-образная кривая, ограниченная по вертикальной оси между 0 и 1, благодаря чему она часто используется для моделирования вероятности двоичного события.

$$display$$sigmoid(z) = frac{1}{1 + e^{-z}}$$display$$

В соответствии с этой мыслью, мы можем дополнить нашу модель следующим изображением и уравнением.

$$display$$z = w cdot x = w_1x_1 + w_2x_2 + w_3x_3 + w_4x_4$$display$$

$$display$$widehat y = sigmoid(z) = frac{1}{1 + e^{-z}}$$display$$

Выглядит знакомо? Да, это наша старая подруга, логистическая регрессия. Однако она хорошо послужит нам для интерпретации модели как линейного перцептрона с сигмоидной функцией активации, потому что это даёт нам больше возможностей для более общего подхода. Кроме того, поскольку мы теперь можем интерпретировать $inline$hat{y}$inline$ как вероятность, то нам нужно соответствующим образом изменить правило принятия решений.

$$display$$f(x)={begin{cases} 1 &{text{if }} widehat{y} > 0.5\ 0 & {text{otherwise}} end{cases}} $$display$$

Продолжим с нашим примером задачи и будем считать, что у нас получилась следующая подобранная модель:

$$display$$begin{bmatrix} w_1 & w_2 & w_3 & w_4 end{bmatrix} = begin{bmatrix} -0.140 & -0.145 & 0.121 & 0.092 end{bmatrix}$$display$$

$$display$$b = -0.008$$display$$

$$display$$widehat y = frac{1}{1 + e^{-(-0.140x_1 -0.145x_2 + 0.121x_3 + 0.092x_4 -0.008)}}$$display$$

Понаблюдаем, как эта модель ведёт себя на тех же примерах изображений из предыдущего раздела.

Нам определённо удалось решить проблему 1. Посмотрите, как она решает и проблему 2.

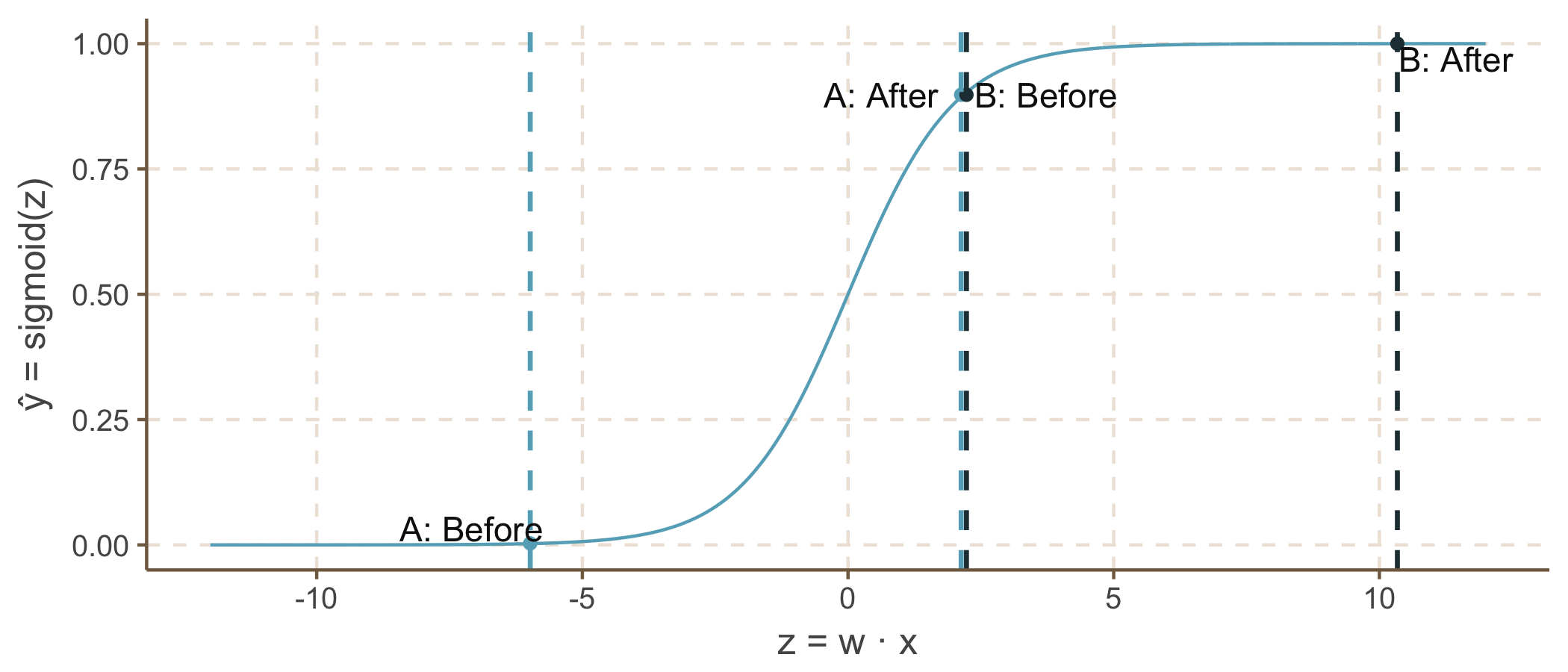

Случай A

Начнём с изображения [100, 0, 0, 100]. Увеличим $inline$x_3$inline$" с 0 до 50.

Случай B

Начнём с изображения [100, 0, 50, 100]. Увеличим $inline$x_3$inline$" с 50 до 100.

Заметьте, как кривизна сигмоиды заставляет случай A «сработать» (быстро увеличиться) с увеличением $inline$z = w cdot x$inline$, но темп замедляется при продолжении увеличения $inline$z$inline$. Это соответствует нашему интуитивному пониманию, что случай A должен отражать бОльшее увеличение вероятности паттерна лестницы, чем случай B.

К сожалению, эта модель по-прежнему имеет проблемы.

- $inline$widehat y$inline$ имеет монотонную связь с каждой переменной. А что если нам нужно распознавать лестницы более светлого оттенка?

- Модель не учитывает взаимодействие переменных. Предположим, что нижний ряд изображения чёрный. Если верхний левый пиксель белый, то затемнение верхнего правого пикселя должно увеличить вероятность паттерна лестницы. Если верхний левый пиксель чёрный, то затенение верхнего правого пикселя должно снижать вероятность лестницы. Другими словами, увеличение $inline$x_3$inline$ должно потенциально приводить к увеличению или уменьшению $inline$widehat y$inline$, в зависимости от значений других переменных. В нашей текущей модели этого никак не достичь.

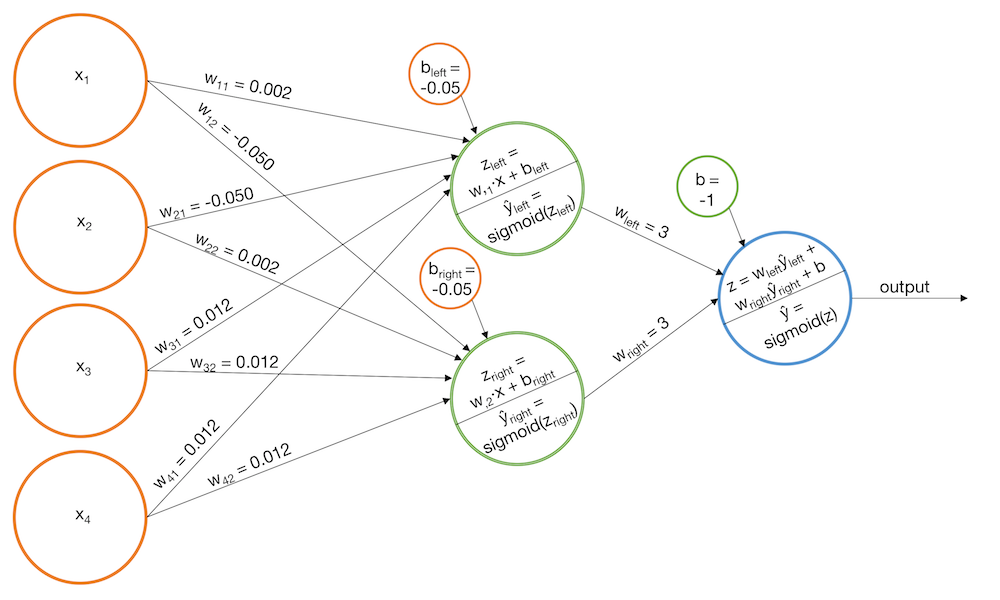

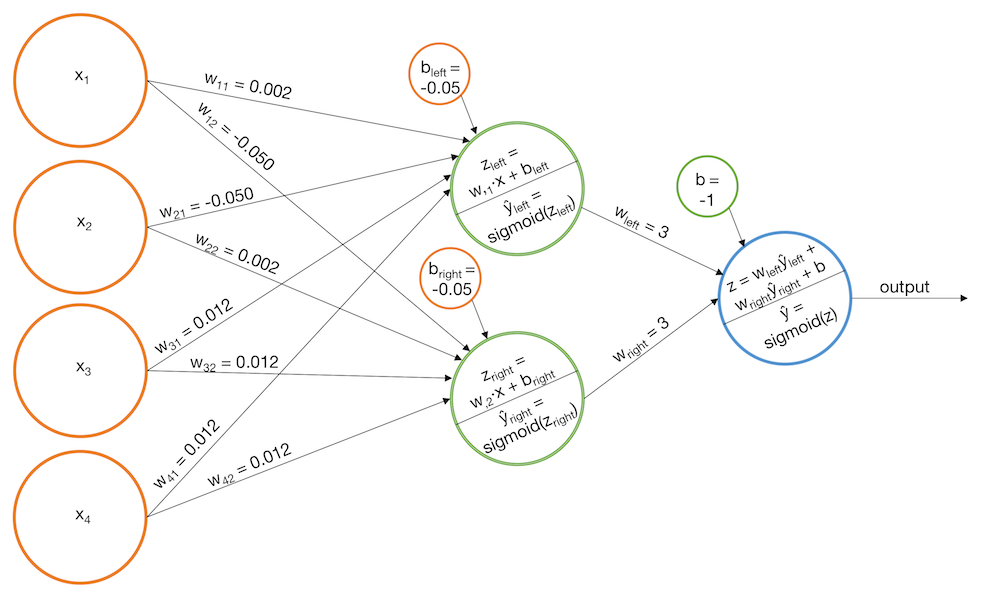

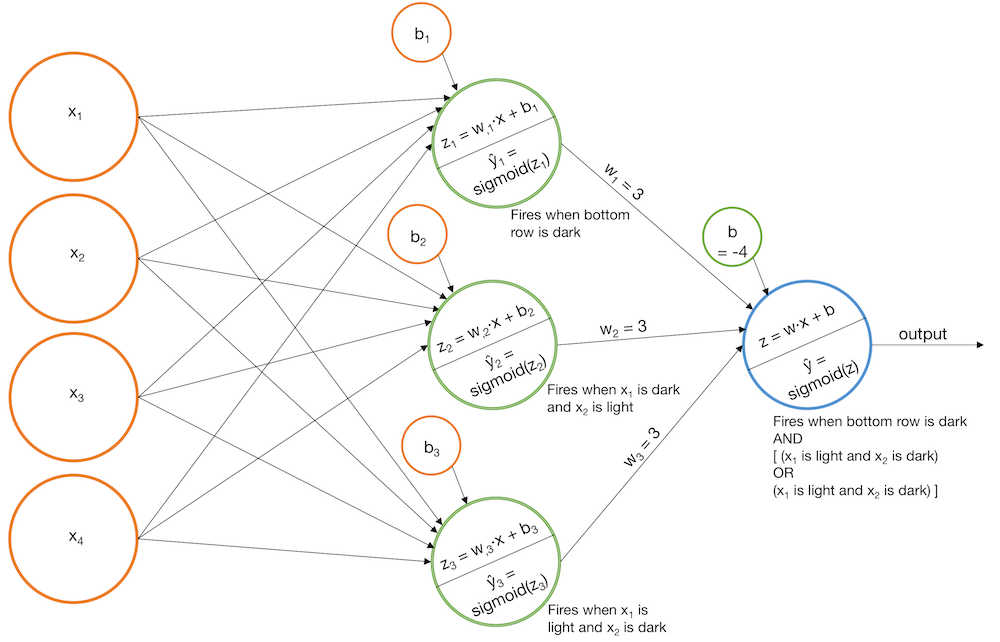

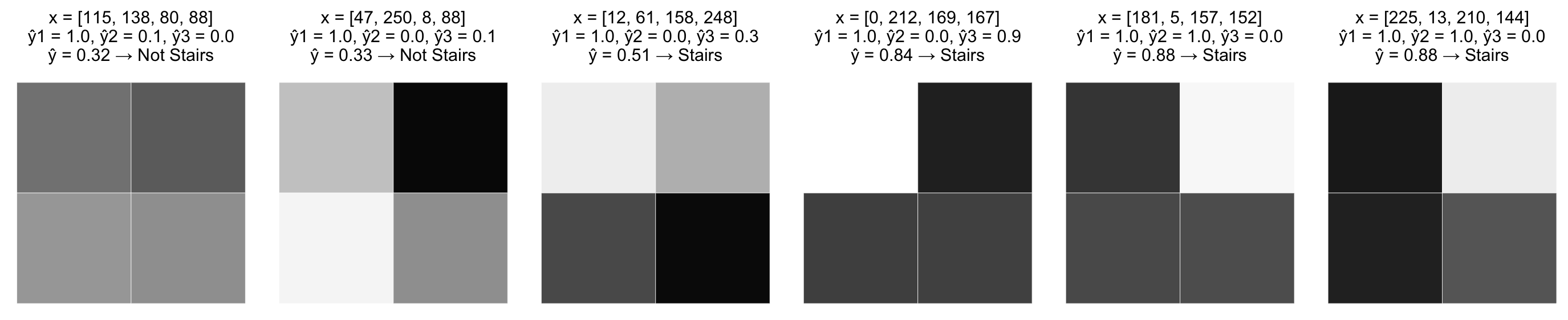

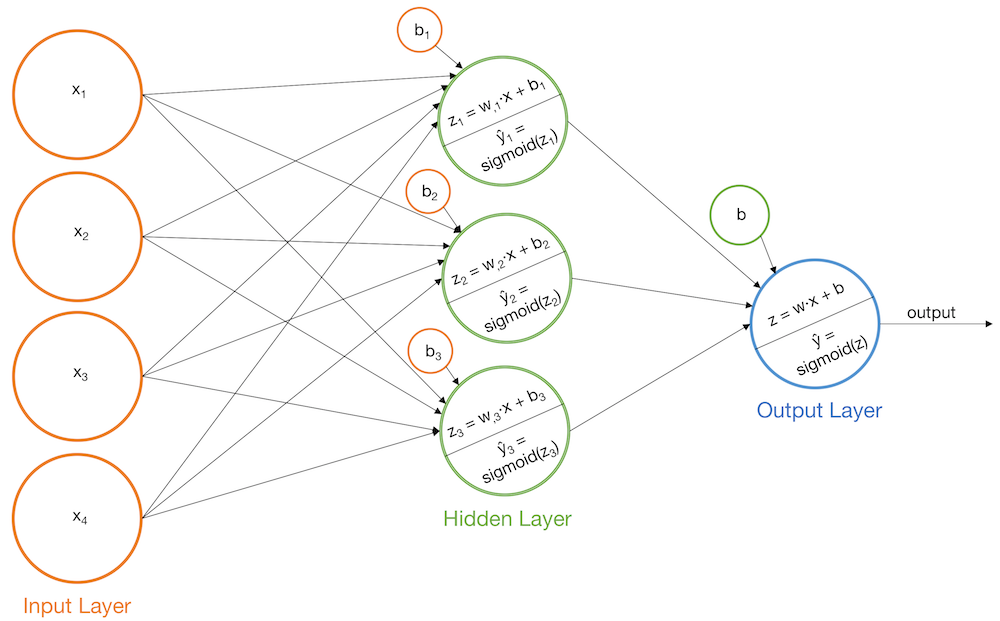

Многослойный перцептрон с сигмоидной функцией активации (итерация модели 2)

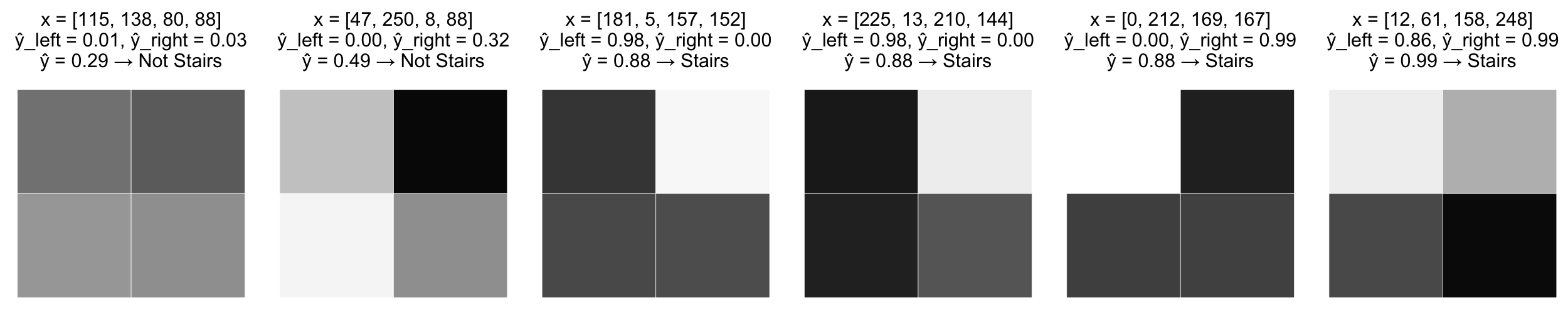

Мы можем решить обе вышеуказанные проблемы, добавив в нашу модель перцептрона ещё один слой. Мы создадим несколько базовых моделей, похожих на представленные выше, но мы будем передавать выходные данные каждой базовой модели на вход другого перцептрона. Эта модель на самом деле является «ванильной» нейронной сетью. Давайте посмотрим, как она может работать в разных примерах.

Пример 1: распознавание паттерна лестницы

- Построим модель, которая срабатывает при распознавании «левых лестниц», $inline$widehat y_{left}$inline$

- Построим модель, которая срабатывает при распознавании «правых лестниц», $inline$widehat y_{right}$inline$

- Добавим базовым моделям оценку, чтобы конечная сигмоида срабатывала только если оба значения ($inline$widehat y_{left}$inline$, $inline$widehat y_{right}$inline$) велики

Другой вариант

- Построим модель, срабатывающую, когда нижний ряд тёмный, $inline$widehat y_1$inline$

- Построим модель, срабатывающую, когда верхний левый пиксель тёмный и верхний правый пиксель светлый, $inline$widehat y_2$inline$

- Построим модель, срабатывающую, когда верхний левый пиксель светлый и верхний правый пиксель тёмный, $inline$widehat y_3$inline$

- Добавим базовые модели так, что конечная сигмоидная функция срабатывала только когда $inline$widehat y_1$inline$ и $inline$widehat y_2$inline$ велики, или когда $inline$widehat y_1$inline$ и $inline$widehat y_3$inline$ велики. (Заметьте, что $inline$widehat y_2$inline$ и $inline$widehat y_3$inline$ не могут быть большими одновременно.)

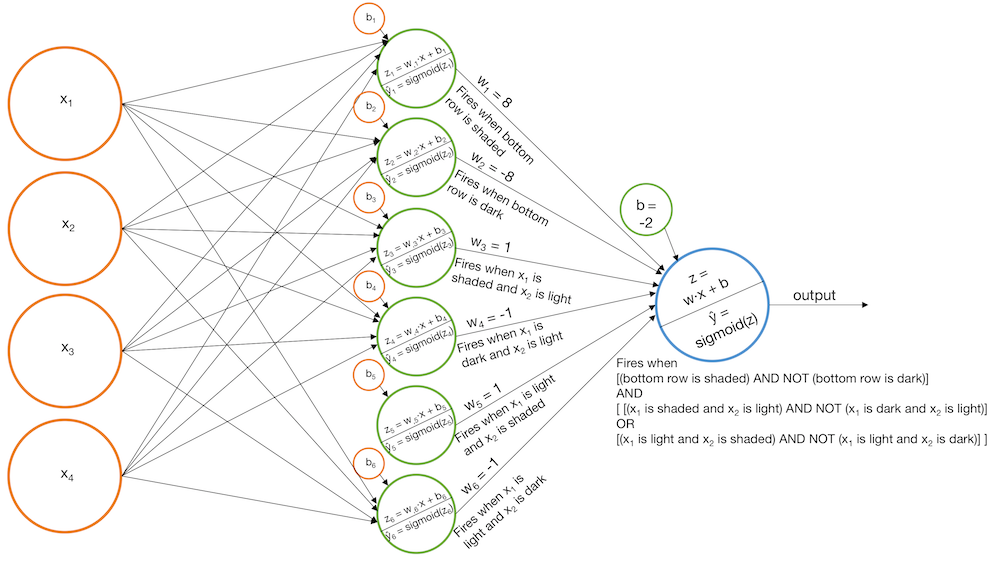

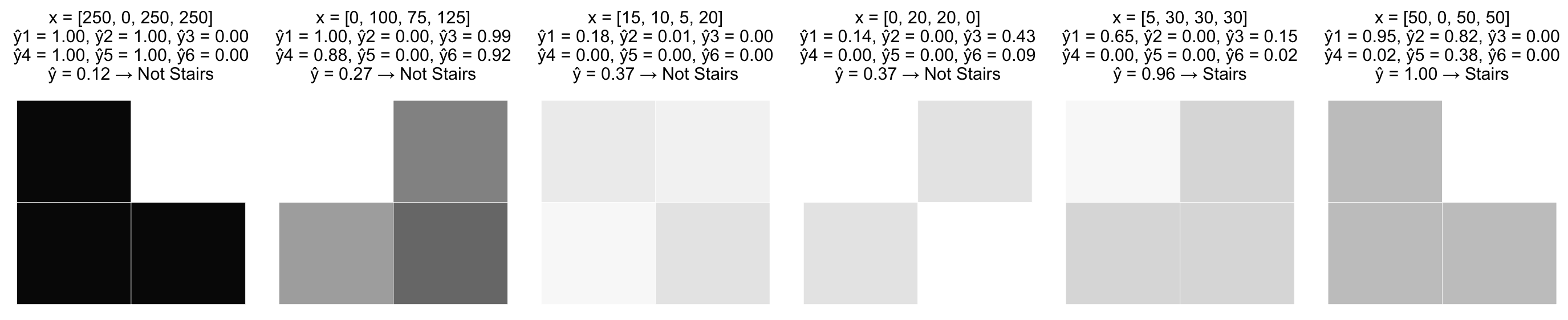

Пример 2: распознать лестницы светлого оттенка

- Построим модели, срабатывающие при «затенённом нижнем ряде», «затенённом x1 и белом x2», «затенённом x2 и белом x1», $inline$widehat y_1$inline$, $inline$widehat y_2$inline$ и $inline$widehat y_3$inline$

- Построим модели, срабатывающие при «тёмном нижнем ряде», «тёмном x1 и белом x2», «тёмном x2 и белом x», $inline$widehat y_4$inline$, $inline$widehat y_5$inline$ и $inline$widehat y_6$inline$

- Соединим модели таким образом, чтобы «тёмные» идентификаторы вычитались из «затенённых» идентификаторов перед сжиманием результата сигмоидой

Примечание о терминологии

Однослойный перцептрон имеет один выходной слой. То есть построенные нами модели будут называться двуслойными перцептронами, потому что у них есть выходной слой, являющийся входом другого выходного слоя. Однако мы можем называть те же самые модели нейронными сетями, и в этом случае сети имеют три слоя — входной слой, скрытый слой и выходной слой.

Альтернативные функции активации

В наших примерах мы использовали сигмоидную функцию активации. Однако можно применять и другие функции активации. Часто применяются tanh и relu. Функция активации должна быть нелинейной, в противном случае нейронная сеть упростится до аналогичного однослойного перцептрона.

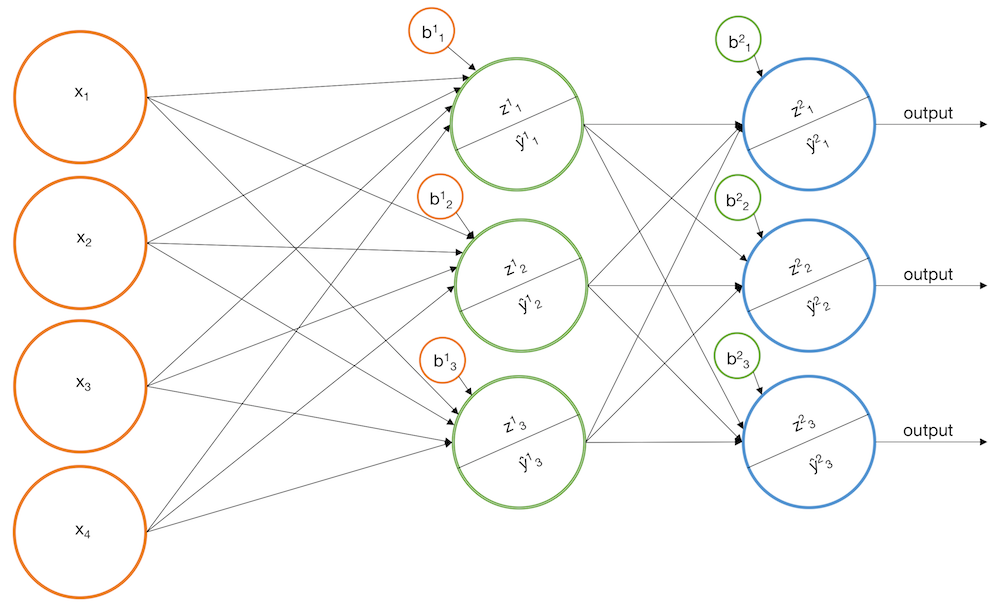

Многоклассовая классификация

Мы с лёгкостью можем расширить нашу модель, чтобы она работала в многоклассовой классификации, с помощью использования нескольких узлов в конечном выходном слое. Идея здесь заключается в том, что каждый выходной узел соответствует одному из классов $inline$C$inline$, которые мы стремимся спрогнозировать. Вместо сужения выхода с помощью сигмоиды, которая отражает элемент из $inline$mathbb{R}$inline$ в элемент из интервала [0, 1] мы можем использовать функцию softmax, которая отражает вектор в $inline$mathbb{R}^n$inline$ в вектор в $inline$mathbb{R}^n$inline$ таким образом, что сумма элементов получившегося вектора равна 1. Иными словами, мы можем создать такую сеть, которая даёт на выходе вектор [$inline$prob(class_1)$inline$, $inline$prob(class_2)$inline$, …, $inline$prob(class_C)$inline$].

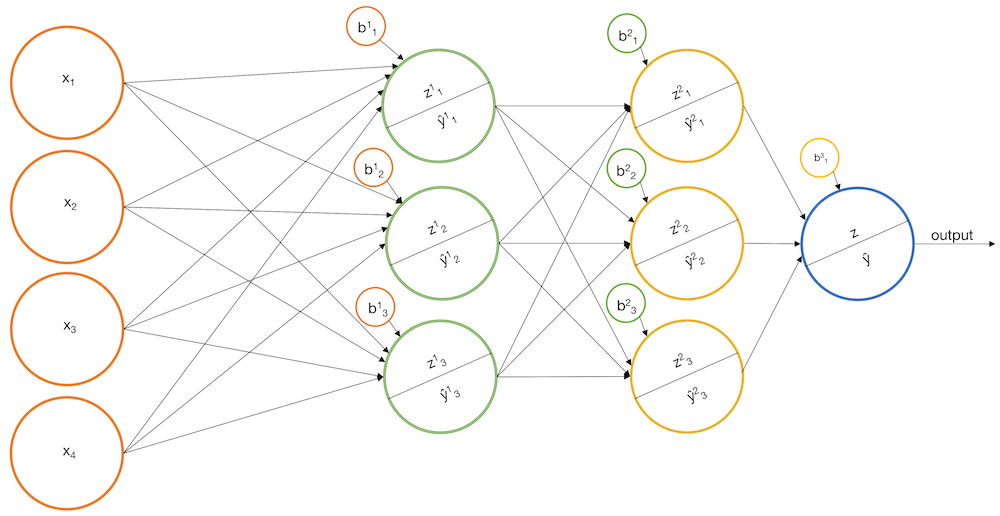

Использование трёх и более слоёв (глубокое обучение)

Вы можете задаться вопросом — можно ли расширить нашу «ванильную» нейронную сеть так, чтобы её выходной слой передавался на четвёртый слой (а потом на пятый, шестой и т.д.)? Да. Обычно это называется «глубоким обучением». На практике оно может быть очень эффективным. Однако стоит заметить, что любую сеть, состоящую из более чем одного скрытого слоя, можно имитировать сетью с одним скрытым слоем. И в самом деле, согласно универсальной теореме аппроксимации любую непрерывную функцию можно аппроксимировать с помощью нейронной сети с одним скрытым слоем. Причина частого выбора глубоких архитектур нейронных сетей вместо сетей с одним скрытым слоем заключается в том, что при процедуре подбора они обычно сходятся к решению быстрее.

Подбор модели под размеченные обучающие образцы (обратное распространение ошибки обучения)

Увы, но мы добрались и до процедуры подбора. До этого мы говорили о том, что нейросети могут работать эффективно, но не обсуждали то, как нейросеть подгоняется под размеченные обучающие образцы. Аналогом этого вопроса может быть такой: «Как можно выбрать наилучшие веса для сети на основании нескольких размеченных обучающих образцов?». Обычным ответом является градиентный спуск (хотя может подойти и ММП). Если продолжить работу над нашим примером задачи, то процедура градиентного спуска может выглядеть примерно так:

- Начинаем с каких-то размеченных обучающих данных

- Выберем для минимизации дифференцируемую функцию потерь, $inline$L(mathbf{widehat Y}, mathbf{Y})$inline$

- Выберем структуру сети. Особенно чётко нужно определить количество слоёв и узлов на каждом слое.

- Инициализируем сеть со случайными весами

- Пропускаем сквозь сеть обучающие данные, чтобы сгенерировать прогноз для каждого образца. Измерим общую погрешность согласно функции потерь, $inline$L(mathbf{widehat Y}, mathbf{Y})$inline$. (Это называется прямым распространением.)

- Определяем, насколько меняются текущие потери относительно небольших изменений каждого из весов. Другими словами, вычисляем градиент $inline$L$inline$ с учётом каждого веса в сети. (Это называется обратным распространением.)

- Делаем небольшой «шаг» в направлении отрицательного градиента. Например, если $inline$w_{23} = 1.5$inline$, а $inline$frac{partial L}{partial w_{23}} = 2.2$inline$, то уменьшение $inline$w_{23}$inline$ на небольшую величину должно привести к небольшому уменьшению текущих потерь. Поэтому мы изменяем $inline$w_3 := w_3 - 2.2 times 0.001$inline$ (где 0.001 — заданный «размер шага»).

- Повторяем этот процесс (с шага 5) фиксированное количество раз или пока потери не сойдутся

По крайней мере, такова основная идея. При реализации на практике возникает множество затруднений.

Затруднение 1 – вычислительная сложность

В процессе подбора среди прочего нам нужно вычислять градиент $inline$L$inline$ с учётом каждого веса. Это сложно, потому что $inline$L$inline$ зависит от каждого узла в выходном слое, и каждый из этих узлов зависит от каждого узла в слое перед ним, и так далее. Это значит, что вычисление $inline$frac{partial L}{partial w_{ab}}$inline$ превращается в настоящий кошмар с формулами сложных производных. (Не забывайте, что многие нейронные сети в реальном мире содержат тысячи узлов в десятках слоёв.) Решить эту задачу можно, заметив, что при применении формулы сложной производной большинство $inline$frac{partial L}{partial w_{ab}}$inline$ повторно использует одинаковые промежуточные производные. Если вы будете внимательно это отслеживать, то сможете избежать одних и тех же повторных вычислений тысячи раз.

Ещё одна хитрость заключается в использовании специальных функций активации, производные которых можно записать как функцию их значения. Например, производная $inline$sigmoid(x)$inline$ = $inline$sigmoid(x)(1 - sigmoid(x))$inline$. Это удобно, потому что во время прямого прохода при вычислении $inline$widehat y$inline$ для каждого обучающего образца нам нужно вычислять $inline$sigmoid(mathbf{x})$inline$ поэлементно для некоторого вектора $inline$mathbf{x}$inline$. Во время обратного распространения мы можем повторно использовать эти значения для вычисления градиента $inline$L$inline$ с учётом весов, что позволит сэкономить время и память.

Третья хитрость заключается в разделении обучающих образцов на «минигруппы» и в изменении весов с учётом каждой группы, одной за другой. Например, если мы разделим обучающие данные на {batch1, batch2, batch3}, то первый проход по обучающим данным будет

- Изменять веса на основе batch1

- Изменять веса на основе batch2

- Изменять веса на основе batch3

где градиент $inline$L$inline$ повторно вычисляется после каждого изменения.

Напоследок стоит упомянуть ещё одну технику — использование вместо центрального процессора видеопроцессора, потому что он лучше подходит для выполнения большого количества параллельных вычислений.

Затруднение 2 – у градиентного спуска могут возникать проблемы с поиском абсолютного минимума

Это проблема не столько нейросетей, сколько градиентного спуска. Существует вероятность, что во время градиентного спуска веса могут застрять в локальном минимуме. Также возможно, что веса «перепрыгнут» минимум. Один из способов справиться с этим — использовать различные размеры шагов. Ещё один способ — увеличить количество узлов и/или слоёв в сети. (Но стоит опасаться чрезмерно близкой подгонки). Кроме того, могут быть эффективными некоторые эвристические техники, например, использование момента.

Затруднение 3 – как выработать общий подход?

Как написать генетическую программу, которая сможет подбирать значения для любой нейросети с любым количеством узлов и слоёв? Правильный ответ — никак, нужно использовать Tensorflow. Но если вы хотите попробовать, то самой сложной частью будет вычисление градиента функции потерь. Хитрость здесь в том, чтобы определить, что градиент можно представить как рекурсивную функцию. Нейронная сеть с пятью слоями — это просто нейронная сеть с четырьмя слоями, передающая данные в какие-то перцептроны. Но нейросеть с четырьмя слоями — это просто нейросеть с тремя слоями, передающая данные в какие-то перцептроны и так далее. Более формально это называется автоматическим дифференцированием.

Автор: PatientZero