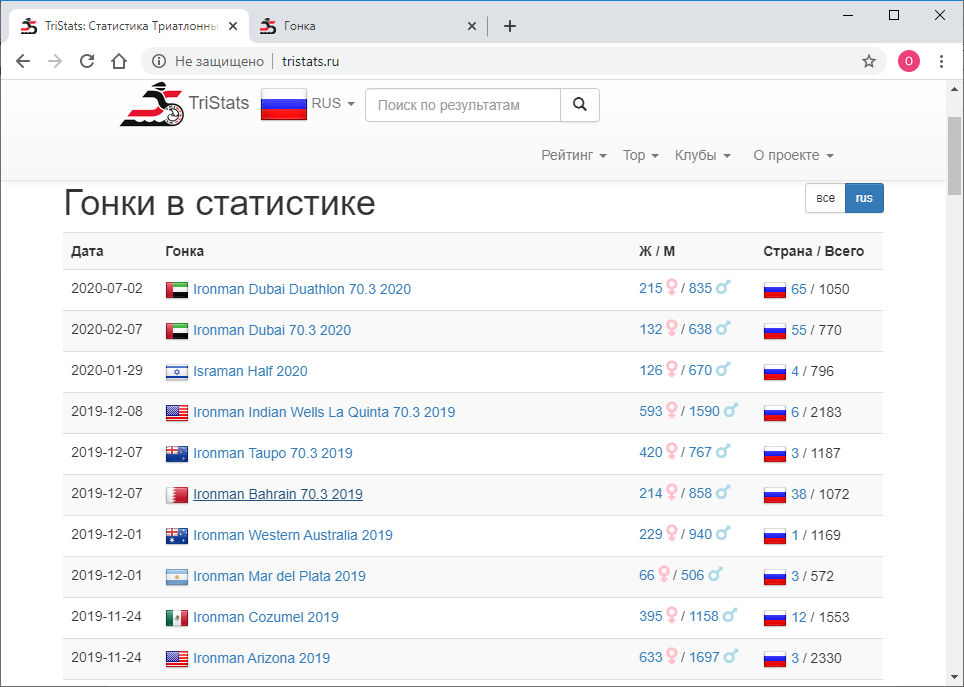

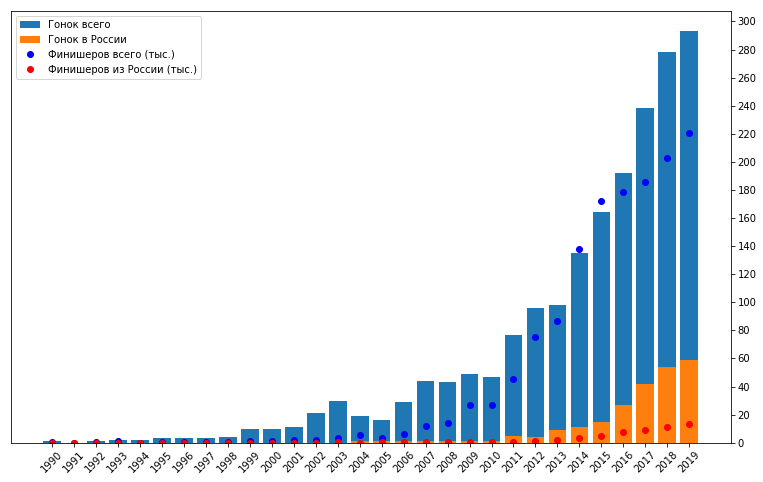

Последние пару лет в свободное время занимаюсь триатлоном. Этот вид спорта очень популярен во многих странах мира, в особенности в США, Австралии и Европе. В настоящее время набирает стремительную популярность в России и странах СНГ. Речь идет о вовлечении любителей, не профессионалов. В отличие от просто плавания в бассейне, катания на велосипеде и пробежек по утрам, триатлон подразумевает участие в соревнованиях и системной подготовке к ним, даже не будучи профессионалом. Наверняка среди ваших знакомых уже есть по крайней мере один “железный человек” или тот, кто планирует им стать. Массовость, разнообразие дистанций и условий, три вида спорта в одном – все это располагает к образованию большого количества данных. Каждый год в мире проходит несколько сотен соревнований по триатлону, в которых участвует несколько сотен тысяч желающих. Соревнования проводятся силами нескольких организаторов. Каждый из них, естественно, публикует результаты у себя. Но для спортсменов из России и некоторых стран СНГ, команда tristats.ru собирает все результаты в одном месте – на своем одноименном сайте. Это делает очень удобным поиск результатов, как своих, так и своих друзей и соперников, или даже своих кумиров. Но для меня это дало еще и возможность сделать анализ большого количества результатов программно. Результаты опубликиваны на трилайфе: почитать.

Это был мой первый проект подобного рода, потому как лишь недавно я начал заниматься анализом данных в принципе, а также использовать python. Поэтому хочу рассказать вам о техническом исполнении этой работы, тем более что в процессе то и дело всплывали различные нюансы, требующие иногда особого подхода. Здесь будет про скраппинг, парсинг, приведение типов и форматов, восстановление неполных данных, формирование репрезентативной выборки, визуализацию, векторизацию и даже параллельные вычисления.

Объем получился большой, поэтому я разбил все на пять частей, чтобы можно было дозировать информацию и запомнить, откуда начать после перерыва.

Перед тем как двинуться дальше, лучше сначала прочитать мою статью с результатами исследования, потому как здесь по сути описана кухня по ее созданию. Это займет 10-15 минут.

Прочитали? Тогда поехали!

Часть 1. Скраппинг и парсинг

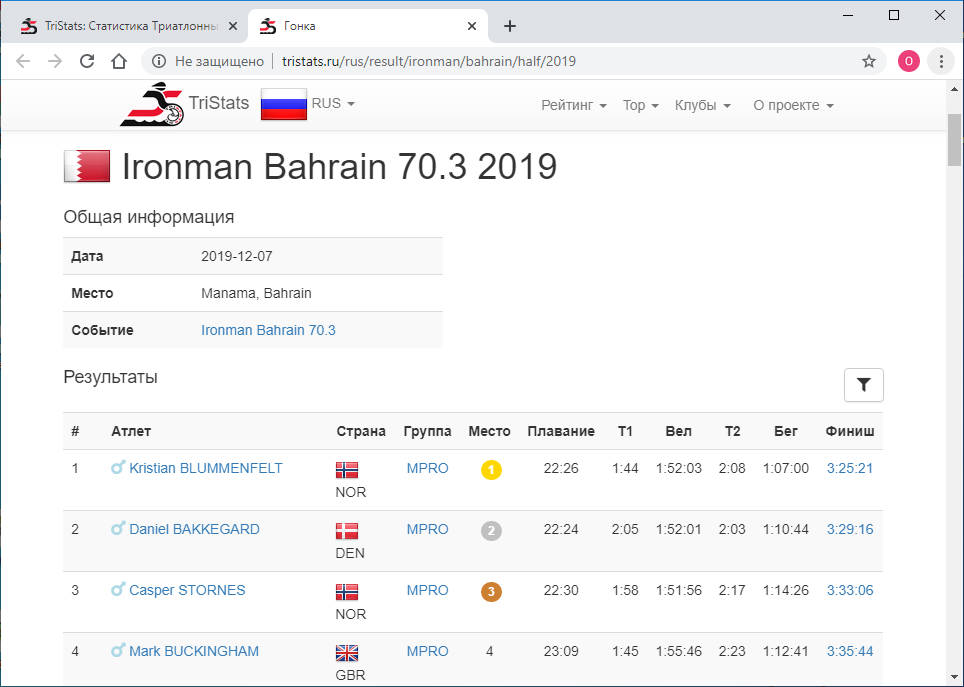

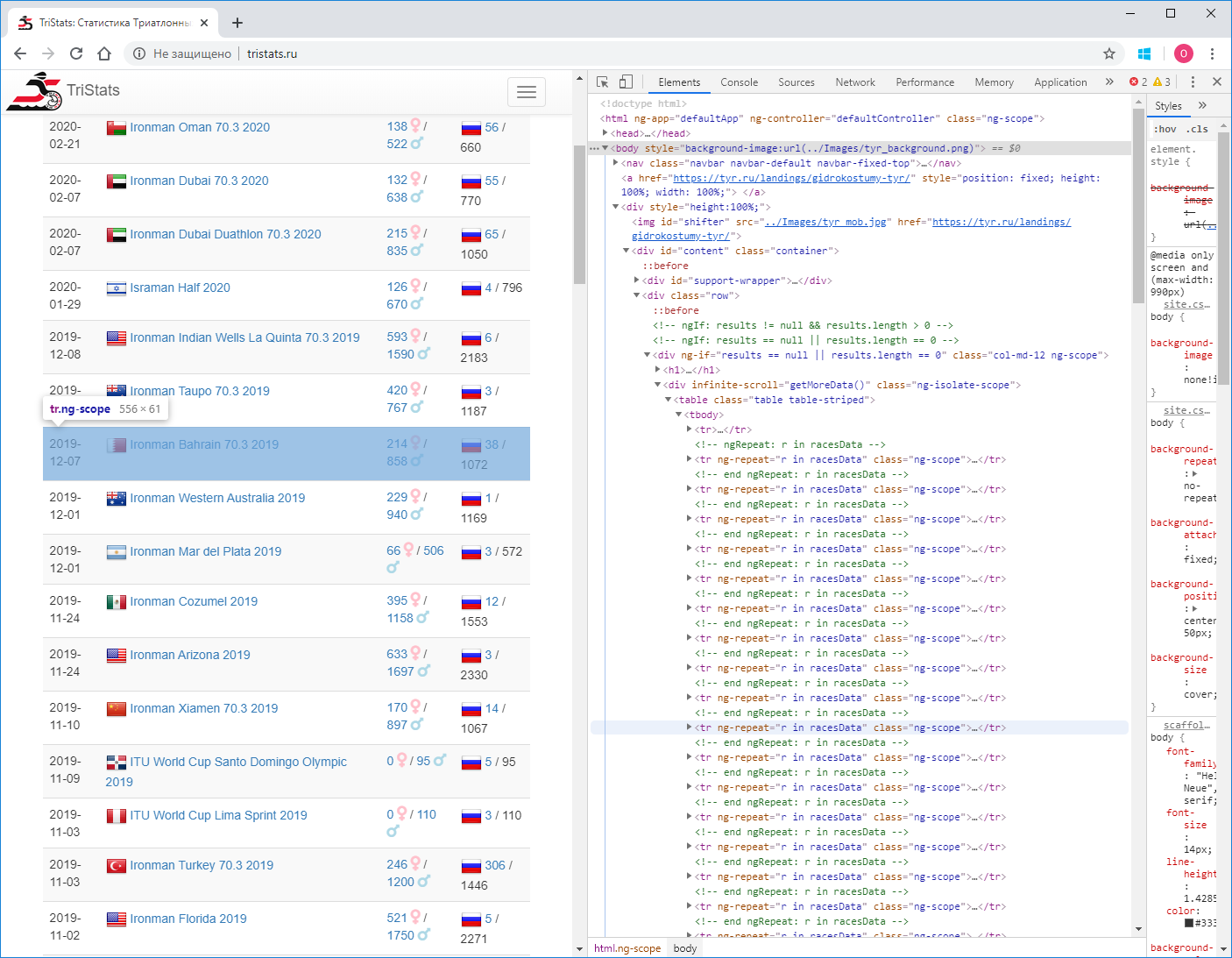

Дано: Сайт tristats.ru. На нем два вида таблиц, которые нас интересуют. Это собственно сводная таблица всех гонок и протокол результатов каждой из них.

Задачей номер один было получить эти данные программно и сохранить их для дальнейшей обработки. Так получилось, что я был на тот момент плохо знаком с веб технологиями и поэтому не знал сразу как это сделать. Начал соответственно с того, что знал – посмотреть код страницы. Это можно сделать использую правую кнопку мыши или клавишу F12.

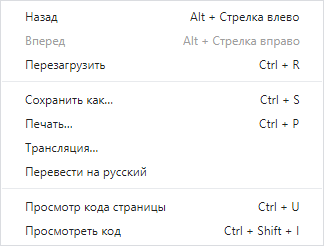

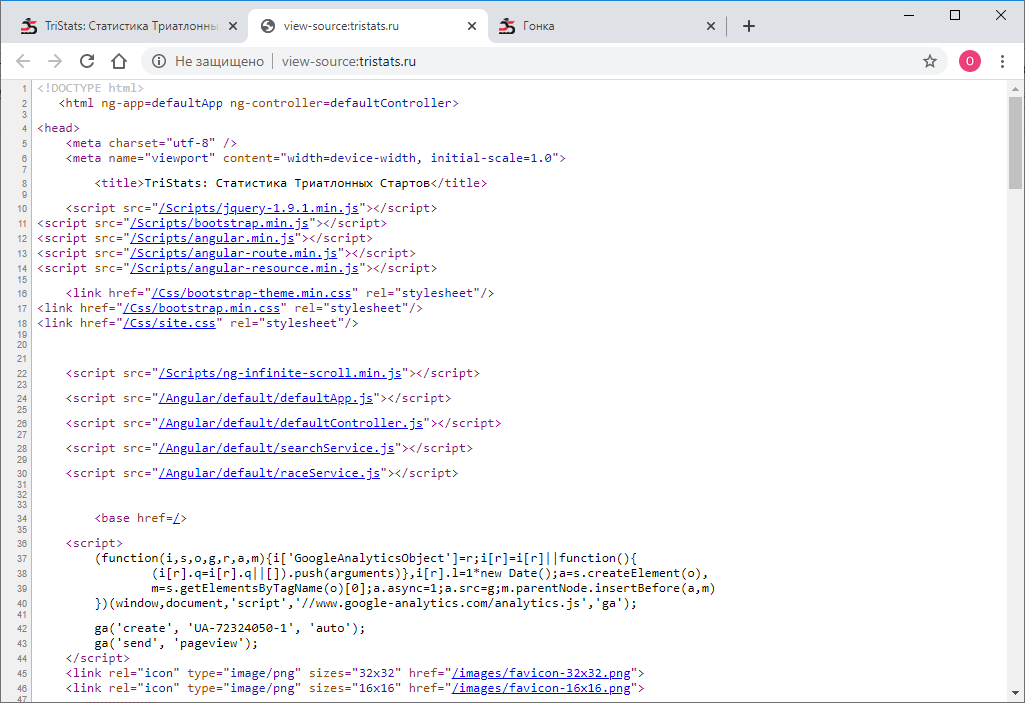

Меню в Chrome содержит два пункта Просмотр кода страницы и Посмотреть код. Не самое очевидное разделение. Естественно, они дают разные результаты. Тот, что Посмотреть код, как раз и есть то же самое, что и F12 — непосредственно текстовое html-представление того, что отображено в браузере, поэлементно.

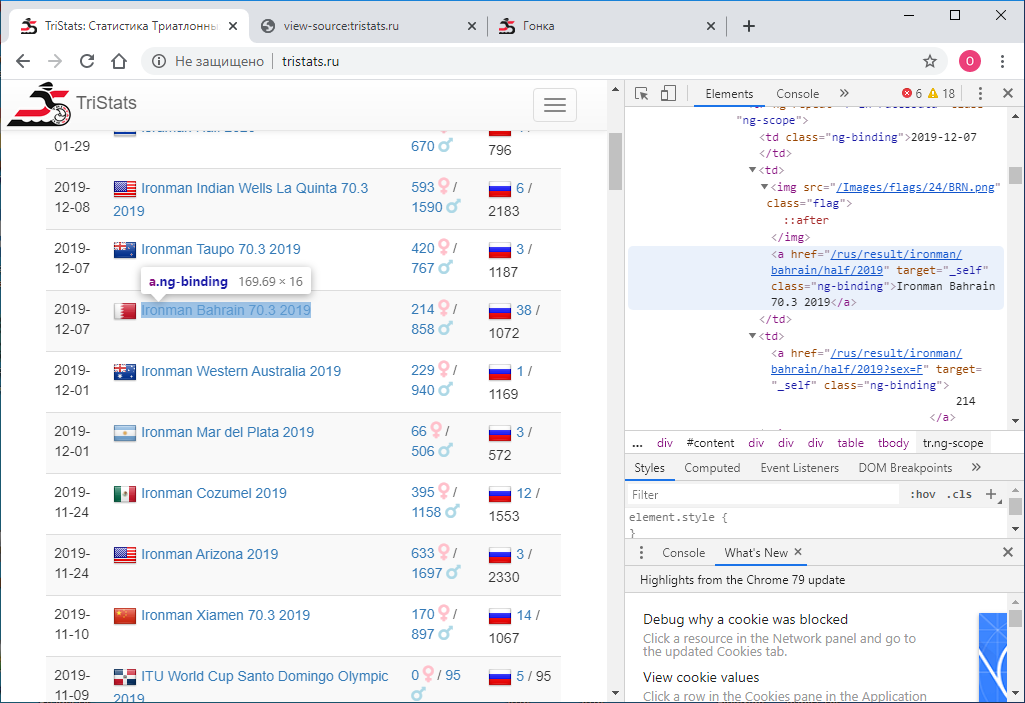

В свою очередь Просмотр кода страницы выдает исходный код страницы. Тоже html, но никаких данных там нет, только названия скриптов JS, которые их выгружают. Ну ладно.

Теперь надо понять, как с помощью python сохранить код каждой страницы в виде отдельного текстового файла. Пробую так:

import requests

r = requests.get(url='http://tristats.ru/')

print(r.content)

И получаю… исходный код. Но мне то нужен результат его исполнения. Поизучав, поискав и поспрашивав, я понял, что мне нужен инструмент для автоматизации действий браузера, например — selenium. Его я и поставил. А также ChromeDriver для работы с Google Chrome. Далее использовал его следующим образом:

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

service = Service(r'C:ChromeDriverchromedriver.exe')

service.start()

driver = webdriver.Remote(service.service_url)

driver.get('http://www.tristats.ru/')

print(driver.page_source)

driver.quit()

Этот код запускает окно браузера и открывает в нем страницу по заданному url. В результате получаем html код уже с вожделенными данными. Но есть одна загвоздка. В полученном результате только 100 записей, а всего гонок почти 2000. Как же так? Дело в том, что изначально в браузере отображаются лишь первые 100 записей, и только если прокрутить до самого низа страницы, загружаются следующие 100, и так далее. Стало быть, надо реализовать прокрутку программно. Для этого воспользуемся командой:

driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

И при каждом прокручивании будем проверять, изменился ли код загруженной страницы или нет. Если он не изменился, для надежности проверим несколько раз, например 10, то значит страница загружена целиком и можно остановиться. Между прокрутками установим таймаут в одну секунду, чтобы страница успела загрузиться. (Даже если не успеет, у нас есть запас – еще девять секунд).

А полностью код будет выглядеть так:

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

import time

service = Service(r'C:ChromeDriverchromedriver.exe')

service.start()

driver = webdriver.Remote(service.service_url)

driver.get('http://www.tristats.ru/')

prev_html = ''

scroll_attempt = 0

while scroll_attempt < 10:

driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

time.sleep(1)

if prev_html == driver.page_source:

scroll_attempt += 1

else:

prev_html = driver.page_source

scroll_attempt = 0

with open(r'D:trisummary.txt', 'w') as f:

f.write(prev_html)

driver.quit()

Итак, у нас есть html файл со сводной таблицей всех гонок. Нужно его распарсить. Для этого используем библиотеку lxml.

from lxml import html

Сначала находим все строки таблицы. Чтобы определить признак строки, просто смотрим html файл в текстовом редакторе.

Это может быть, например, «tr ng-repeat=’r in racesData’ class=’ng-scope’» или какой – то фрагмент, который больше не встречается ни в каких тегах.

with open(r'D:trisummary.txt', 'r') as f:

sum_html = f.read()

tree = html.fromstring(sum_html)

rows = tree.findall(".//*[@ng-repeat='r in racesData']")

затем заводим pandas dataframe и каждый элемент каждой строки таблица записываем в этот датафрейм.

import pandas as pd

rs = pd.DataFrame(columns=['date','name','link','males','females','rus','total'], index=range(len(rows))) #rs – races summary

Для того, чтобы разобраться, где спрятан каждый конкретный элемент, нужно просто посмотреть на html код одного из элементов наших rows в том же текстовом редакторе.

<tr ng-repeat="r in racesData" class="ng-scope">

<td class="ng-binding">2015-04-26</td>

<td>

<img src="/Images/flags/24/USA.png" class="flag">

<a href="/rus/result/ironman/texas/half/2015" target="_self" class="ng-binding">Ironman Texas 70.3 2015</a>

</td>

<td>

<a href="/rus/result/ironman/texas/half/2015?sex=F" target="_self" class="ng-binding">605</a>

<i class="fas fa-venus fa-lg" style="color:Pink"></i>

/

<a href="/rus/result/ironman/texas/half/2015?sex=M" target="_self" class="ng-binding">1539</a>

<i class="fas fa-mars fa-lg" style="color:LightBlue"></i>

</td>

<td class="ng-binding">

<img src="/Images/flags/24/rus.png" class="flag">

<!-- ngIf: r.CountryCount == 0 -->

<!-- ngIf: r.CountryCount > 0 --><a ng-if="r.CountryCount > 0" href="/rus/result/ironman/texas/half/2015?country=rus" target="_self" class="ng-binding ng-scope">2</a>

<!-- end ngIf: r.CountryCount > 0 -->

/ 2144

</td>

</tr>

Здесь проще всего захардкодить навигацию по дочерним элементам, их не так много.

for i in range(len(rows)):

rs.loc[i,'date'] = rows[i].getchildren()[0].text.strip()

rs.loc[i,'name'] = rows[i].getchildren()[1].getchildren()[1].text.strip()

rs.loc[i,'link'] = rows[i].getchildren()[1].getchildren()[1].attrib['href'].strip()

rs.loc[i,'males'] = rows[i].getchildren()[2].getchildren()[2].text.strip()

rs.loc[i,'females'] = rows[i].getchildren()[2].getchildren()[0].text.strip()

rs.loc[i,'rus'] = rows[i].getchildren()[3].getchildren()[3].text.strip()

rs.loc[i,'total'] = rows[i].getchildren()[3].text_content().split('/')[1].strip()

Вот что получилось в итоге:

| date | event | link | males | females | rus | total | |

|---|---|---|---|---|---|---|---|

| 0 | 2020-07-02 | Ironman Dubai Duathlon 70.3 2020 | /rus/result/ironman/dubai-duathlon/half/2020 | 835 | 215 | 65 | 1050 |

| 1 | 2020-02-07 | Ironman Dubai 70.3 2020 | /rus/result/ironman/dubai/half/2020 | 638 | 132 | 55 | 770 |

| 2 | 2020-01-29 | Israman Half 2020 | /rus/result/israman/israman/half/2020 | 670 | 126 | 4 | 796 |

| 3 | 2019-12-08 | Ironman Indian Wells La Quinta 70.3 2019 | /rus/result/ironman/indian-wells-la-quinta/hal... | 1590 | 593 | 6 | 2183 |

| 4 | 2019-12-07 | Ironman Taupo 70.3 2019 | /rus/result/ironman/taupo/half/2019 | 767 | 420 | 3 | 1187 |

| ... | ... | ... | ... | ... | ... | ... | ... |

| 1917 | 1994-07-02 | ITU European Championship Eichstatt Olympic 1994 | /rus/result/itu/european-championship-eichstat... | 61 | 0 | 2 | 61 |

| 1918 | 1993-09-04 | Challenge Almere-Amsterdam Long 1993 | /rus/result/challenge/almere-amsterdam/full/1993 | 795 | 32 | 1 | 827 |

| 1919 | 1993-07-04 | ITU European Cup Echternach Olympic 1993 | /rus/result/itu/european-cup-echternach/olympi... | 60 | 0 | 2 | 60 |

| 1920 | 1992-09-12 | ITU World Championship Huntsville Olympic 1992 | /rus/result/itu/world-championship-huntsville/... | 317 | 0 | 3 | 317 |

| 1921 | 1990-09-15 | ITU World Championship Orlando Olympic 1990 | /rus/result/itu/world-championship-orlando/oly... | 286 | 0 | 5 | 28 |

Сохраняем этот датафрейм в файл. Я использую pickle, но это может быть csv, или что-то еще.

import pickle as pkl

with open(r'D:trisummary.pkl', 'wb') as f:

pkl.dump(df,f)

На данном этапе все данные имеют строковый тип. Конвертировать будем позже. Самое главное, что нам сейчас нужно, это ссылки. Их будем использовать для скраппинга протоколов всех гонок. Делаем его по образу и подобию того, как это было сделано для сводной таблицы. В цикле по всем гонкам для каждой будем открывать страницу по ссылке, прокручивать и получать код страницы. В сводной таблице у нас есть информация по общему количеству участников в гонке – total, будем ее использовать для того, чтобы понять до какого момента нужно продолжать скроллить. Для этого будем прямо в процессе скраппинга каждой страницы определять количество записей в таблице и сравнивать его с ожидаемым значением total. Как только оно будет равно, значит мы доскроллили до конца и можно переходить к следующей гонке. Так же поставим таймаут – 60 сек. Ели за это время мы не добираемся до total, переходим к следующей гонке. Код страницы будем сохранять в файл. Будем сохранять файлы всех гонок в одной папке, а называть их по имени гонок, то есть по значению в колонке event в сводной таблице. Чтобы не было конфликта имен, нужно чтобы все гонки имели разные названия в сводной таблице. Проверим это:

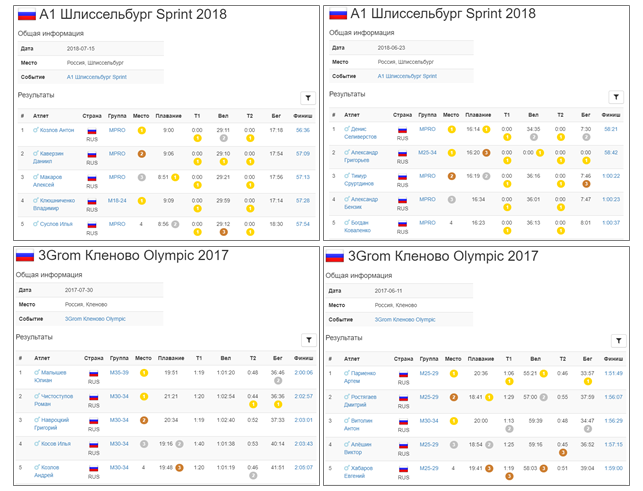

df[df.duplicated(subset = 'event', keep=False)]

| date | event | link | males | females | rus | total | |

|---|---|---|---|---|---|---|---|

| 450 | 2018-07-15 | A1 Шлиссельбург Sprint 2018 | /rus/result/a1/шлиccельбург/sprint/2018-07-15 | 43 | 15 | 47 | 58 |

| 483 | 2018-06-23 | A1 Шлиссельбург Sprint 2018 | /rus/result/a1/шлиccельбург/sprint/2018-06-23 | 61 | 15 | 76 | 76 |

| 670 | 2017-07-30 | 3Grom Кленово Olympic 2017 | /rus/result/3grom/кленово/olympic/2017-07-30 | 249 | 44 | 293 | 293 |

| 752 | 2017-06-11 | 3Grom Кленово Olympic 2017 | /rus/result/3grom/кленово/olympic/2017-06-11 | 251 | 28 | 279 | 279 |

Что ж, в сводной таблице есть повторения, причем, даты, и количества участников (males, females, rus, total), и ссылки разные. Нужно проверить эти протоколы, здесь их немного, так что можно сделать это вручную.

| date | event | link | males | females | rus | total | |

|---|---|---|---|---|---|---|---|

| 450 | 2018-07-15 | A1 Шлиссельбург Sprint 7 2018 | /rus/result/a1/шлиccельбург/sprint/2018-07-15 | 43 | 15 | 47 | 58 |

| 483 | 2018-06-23 | A1 Шлиссельбург Sprint 6 2018 | /rus/result/a1/шлиccельбург/sprint/2018-06-23 | 61 | 15 | 76 | 76 |

| 670 | 2017-07-30 | 3Grom Кленово Olympic 7 2017 | /rus/result/3grom/кленово/olympic/2017-07-30 | 249 | 44 | 293 | 293 |

| 752 | 2017-06-11 | 3Grom Кленово Olympic 6 2017 | /rus/result/3grom/кленово/olympic/2017-06-11 | 251 | 28 | 279 | 27 |

Теперь все названия уникальны, запускаем большой майнинг-цикл:

service.start()

driver = webdriver.Remote(service.service_url)

timeout = 60

for index, row in df.iterrows():

try:

driver.get('http://www.tristats.ru' + row['link'])

start = time.time()

while True:

driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

time.sleep(1)

race_html = driver.page_source

tree = html.fromstring(race_html)

race_rows = tree.findall(".//*[@ng-repeat='r in resultsData']")

if len(race_rows) == int(row['total']):

break

if time.time() - start > timeout:

print('timeout')

break

with open(os.path.join(r'D:triraces', row['event'] + '.txt'), 'w') as f:

f.write(race_html)

except:

traceback.print_exc()

time.sleep(1)

driver.quit()

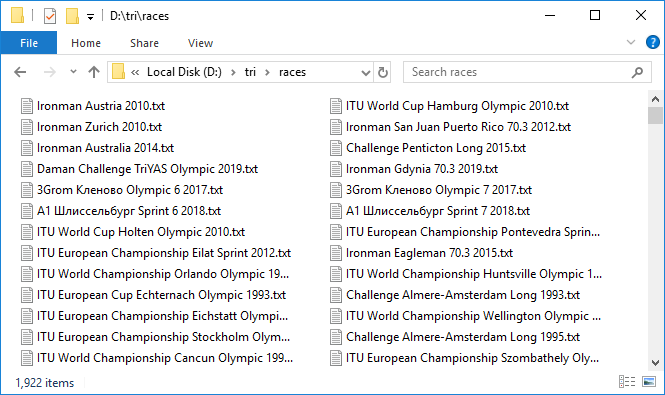

Это долгий процесс. Но когда все настроено и этот тяжелый механизм начинает вращение, один за другим добавляя файлики с данными, наступает чувство приятного волнения. В минуту загружается всего примерно по три протокола, очень медленно. Оставил крутиться на ночь. На все понадобилось около 10 часов. К утру была закачана бoльшая часть протоколов. Как это обычно бывает при работе с сетью, на нескольких случился сбой. Быстро докачал их повторной попыткой.

Итак, мы имеем 1 922 файла общим объемом почти 3 GB. Круто! Но обработка почти 300 гонок закончилась таймаутом. В чем же дело? Выборочно проверяем, оказывается, что действительно значение total из сводной таблицы и количество записей в протоколе гонки, которые мы проверяли, могут не совпадать. Это печально, потому что непонятно в чем причина такого расхождения. То ли это из-за того, что не все финишируют, то ли какой-то баг в базе. В общем первый сигнал о неидеальности данных. В любом случае, проверяем те, в которых количество записей равняется 100 или 0, это самые подозрительные кандидаты. Таких оказалось восемь. Закачиваем их заново под пристальным контролем. Кстати, в двух из них реально по 100 записей.

Ну что ж, все данные у нас. Переходим к парсингу. Опять же в цикле будем пробегать по каждой гонке, читать файл и сохранять содержимое в pandas DataFrame. Эти датафреймы объединим в dict, в котором ключами будут названия гонок – то есть значения event из сводной таблицы или названия файлов с html кодом страниц гонок, они совпадают.

rd = {} #rd – race details

for e in rs['event']:

place = []

... sex = [], name=..., country, group, place_in_group, swim, t1, bike, t2, run

result = []

with open(os.path.join(r'D:triraces', e + '.txt'), 'r')

race_html = f.read()

tree = html.fromstring(race_html)

rows = tree.findall(".//*[@ng-repeat='r in resultsData']")

for j in range(len(rows)):

row = rows[j]

parts = row.text_content().split('n')

parts = [r.strip() for r in parts if r.strip() != '']

place.append(parts[0])

if len([a for a in row.findall('.//i')]) > 0:

sex.append([a for a in row.findall('.//i')][0].attrib['ng-if'][10:-1])

else:

sex.append('')

name.append(parts[1])

if len(parts) > 10:

country.append(parts[2].strip())

k=0

else:

country.append('')

k=1

group.append(parts[3-k])

... place_in_group.append(...), swim.append ..., t1, bike, t2, run

result.append(parts[10-k])

race = pd.DataFrame()

race['place'] = place

... race['sex'] = sex, race['name'] = ..., 'country', 'group', 'place_in_group', 'swim', ' t1', 'bike', 't2', 'run'

race['result'] = result

rd[e] = race

with open(r'D:tridetails.pkl', 'wb') as f:

pkl.dump(rd,f)

| place | sex | name | country | group | place in group | swim | t1 | bike | t2 | run | result | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 1 | M | Reed, Tim | AUS | MPRO | 1 | 24:34 | 1:07 | 2:13:46 | 1:49 | 1:23:17 | 4:04:33 |

| 1 | 2 | M | Van Berkel, Tim | AUS | MPRO | 2 | 24:34 | 1:05 | 2:13:47 | 1:53 | 1:27:17 | 4:08:36 |

| 2 | 3 | M | Baldwin, Nicholas | SEY | MPRO | 3 | 26:31 | 0:59 | 2:14:06 | 1:54 | 1:25:36 | 4:09:06 |

| 3 | 4 | M | Polizzi, Alexander | AUS | MPRO | 4 | 23:21 | 1:12 | 2:14:53 | 1:54 | 1:31:16 | 4:12:36 |

| 4 | 5 | M | Chang, Chia-Hao | TWN | M18-24 | 1 | 25:18 | 1:34 | 2:23:38 | 2:13 | 1:29:01 | 4:21:44 |

| 5 | 6 | M | Rondy, Guillaume | FRA | M35-39 | 1 | 27:51 | 1:26 | 2:21:53 | 2:29 | 1:35:19 | 4:28:58 |

| 6 | 7 | F | Steffen, Caroline | SUI | FPRO | 1 | 26:52 | 1:01 | 2:24:54 | 2:10 | 1:34:17 | 4:29:14 |

| 7 | 8 | M | Betten, Sam | AUS | MPRO | 5 | 23:30 | 1:26 | 2:18:24 | 1:57 | 1:45:07 | 4:30:24 |

| 8 | 9 | M | Gallot, Simon | FRA | M30-34 | 1 | 27:50 | 1:33 | 2:20:15 | 2:13 | 1:45:22 | 4:37:13 |

| ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... | ... |

| 524 | 525 | M | Santos, Alfredo | PHI | M65-69 | 2 | 50:42 | 4:23 | 3:52:10 | 10:32 | 3:36:11 | 8:33:58 |

| 525 | 526 | F | Escober, Eula | PHI | F18-24 | 5 | 47:07 | 3:50 | 4:43:44 | 3:41 | 2:59:45 | 8:38:07 |

| 526 | 527 | M | Belen, Virgilio Jr. | PHI | M45-49 | 76 | 47:05 | 5:49 | 3:48:18 | 11:21 | 3:46:06 | 8:38:39 |

| 527 | 528 | M | Kunimoto, Kilhak | GUM | M70-74 | 2 | 40:32 | 2:50 | 3:53:37 | 6:45 | 4:01:36 | 8:45:20 |

| 528 | 529 | M | Sumicad, Siegfred | PHI | M50-54 | 54 | 59:10 | 4:38 | 4:11:55 | 6:35 | 3:23:45 | 8:46:03 |

| 529 | 530 | M | Gomez, Paul | PHI | M45-49 | 77 | 50:02 | 6:29 | 4:07:58 | 7:24 | 3:41:41 | 8:53:34 |

| 530 | 531 | M | Ramos, John Raymund | PHI | M25-29 | 26 | 43:44 | 3:04 | 4:21:13 | 5:56 | 3:45:10 | 8:59:07 |

| 531 | 532 | F | De Guzman, Clouie Anne | PHI | F30-34 | 9 | 52:29 | 3:16 | 4:03:02 | 7:01 | 3:56:39 | 9:02:27 |

| 532 | 533 | F | Samson, Maria Dolores | PHI | F45-49 | 17 | 48:56 | 4:21 | 4:16:34 | 6:26 | 3:47:06 | 9:03:23 |

| 533 | 534 | M | Salazar, Richard | PHI | M40-44 | 107 | 42:19 | 4:02 | 4:30:36 | 6:39 | 3:39:51 | 9:03:27 |

Помимо таблицы с результатами участников, html файл каждой гонки содержит еще и дату, название и место проведения соревнования. Дата и название уже есть в сводной таблице, а вот локации нет. Считаем эту информацию из html файлов и добавим в новую колонку в сводной таблице.

for index, row in rs.iterrows():

e = row['event']

with open(os.path.join(r'D:triraces', e + '.txt'), 'r') as f:

race_html = f.read()

tree = html.fromstring(race_html)

header_elem = [tb for tb in tree.findall('.//tbody') if tb.getchildren()[0].getchildren()[0].text == 'Дата'][0]

location = header_elem.getchildren()[1].getchildren()[1].text.strip()

rs.loc[index, 'loc'] = location

| event | date | loc | male | female | rus | total | link | |

|---|---|---|---|---|---|---|---|---|

| 0 | Ironman Dubai Duathlon 70.3 2020 | 2020-07-02 | Dubai, United Arab Emirates | 835 | 215 | 65 | 1050 | ... |

| 1 | Ironman Dubai 70.3 2020 | 2020-02-07 | Dubai, United Arab Emirates | 638 | 132 | 55 | 770 | ... |

| 2 | Israman Half 2020 | 2020-01-29 | Israel, Eilat | 670 | 126 | 4 | 796 | ... |

| 3 | Ironman Indian Wells La Quinta 70.3 2019 | 2019-12-08 | Indian Wells/La Quinta, California, USA | 1590 | 593 | 6 | 2183 | ... |

| 4 | Ironman Taupo 70.3 2019 | 2019-12-07 | New Zealand | 767 | 420 | 3 | 1187 | ... |

| 5 | Ironman Bahrain 70.3 2019 | 2019-12-07 | Manama, Bahrain | 858 | 214 | 38 | 1072 | ... |

| 6 | Ironman Western Australia 2019 | 2019-12-01 | Busselton, Western Australia | 940 | 229 | 1 | 1169 | ... |

| 7 | Ironman Mar del Plata 2019 | 2019-12-01 | Mar del Plata, Argentina | 506 | 66 | 3 | 572 | ... |

| 8 | Ironman Cozumel 2019 | 2019-11-24 | Cozumel, Mexico | 1158 | 395 | 12 | 1553 | ... |

| 9 | Ironman Arizona 2019 | 2019-11-24 | Tempe, Arizona, USA | 1697 | 633 | 3 | 2330 | ... |

| 10 | Ironman Xiamen 70.3 2019 | 2019-11-10 | Xiamen, China | 897 | 170 | 14 | 1067 | ... |

Сохраняем. В новый файл.

with open(r'D:trisummary1.pkl', 'wb') as f:

pkl.dump(df,f)

Часть 2. Приведение типов и форматирование

Итак, мы скачали все данные и поместили их в датафреймы. Однако все значения имеют тип str. Это относится и к дате, и к результатам, и к локации, и ко всем остальным параметрам. Необходимо привести все параметры к соответствующим типам.

Начнем со сводной таблицы.

| event | date | loc | male | female | rus | total | link | |

|---|---|---|---|---|---|---|---|---|

| 0 | Ironman Dubai Duathlon 70.3 2020 | 2020-07-02 | Dubai, United Arab Emirates | 835 | 215 | 65 | 1050 | ... |

| 1 | Ironman Dubai 70.3 2020 | 2020-02-07 | Dubai, United Arab Emirates | 638 | 132 | 55 | 770 | ... |

| 2 | Israman Half 2020 | 2020-01-29 | Israel, Eilat | 670 | 126 | 4 | 796 | ... |

| 3 | Ironman Indian Wells La Quinta 70.3 2019 | 2019-12-08 | Indian Wells/La Quinta, California, USA | 1590 | 593 | 6 | 2183 | ... |

| 4 | Ironman Taupo 70.3 2019 | 2019-12-07 | New Zealand | 767 | 420 | 3 | 1187 | ... |

| 5 | Ironman Bahrain 70.3 2019 | 2019-12-07 | Manama, Bahrain | 858 | 214 | 38 | 1072 | ... |

| 6 | Ironman Western Australia 2019 | 2019-12-01 | Busselton, Western Australia | 940 | 229 | 1 | 1169 | ... |

| 7 | Ironman Mar del Plata 2019 | 2019-12-01 | Mar del Plata, Argentina | 506 | 66 | 3 | 572 | ... |

| 8 | Ironman Cozumel 2019 | 2019-11-24 | Cozumel, Mexico | 1158 | 395 | 12 | 1553 | ... |

| 9 | Ironman Arizona 2019 | 2019-11-24 | Tempe, Arizona, USA | 1697 | 633 | 3 | 2330 | ... |

| 10 | Ironman Xiamen 70.3 2019 | 2019-11-10 | Xiamen, China | 897 | 170 | 14 | 1067 | ... |

| ... | ... | ... | ... | ... | ... | ... | ... | ... |

Дата и время

event, loc и link оставим как есть. date конвертируем в pandas datetime следующим образом:

rs['date'] = pd.to_datetime(rs['date'])

Остальные приводим к целочисленному типу:

cols = ['males', 'females', 'rus', 'total']

rs[cols] = rs[cols].astype(int)

Все прошло гладко, никаких ошибок не возникло. Значит все OK — cохраняемся:

with open(r'D:trisummary2.pkl', 'wb') as f:

pkl.dump(rs, f)

Теперь датафреймы гонок. Поскольку все гонки удобнее и быстрее обрабатывать разом, а не по одной, соберем их в один большой датафрейм ar (сокращение от all records) с помощью метода concat.

ar = pd.concat(rd)

ar содержит 1 416 365 записей.

Теперь конвертируем place и place in group в целочисленное значение.

ar[['place', 'place in group']] = ar[['place', 'place in group']].astype(int))

Далее, обработаем колонки с временными значениями. Будем приводить их в типу Timedelta из pandas. Но чтобы конвертация прошла успешно, нужно правильно подготовить данные. Можно видеть, что некоторые значения, которые меньше часа идут без указания того самого часка.

| place | sex | name | country | group | place in group | swim | t1 | bike | t2 | run | result | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 1 | M | Dejan Patrcevic | CRO | M40-44 | 1 | 29:03 | 2:50 | 2:09:17 | 1:37 | 1:22:06 | 4:04:51 |

| 1 | 2 | M | Lukas Krpec | CZE | M35-39 | 1 | 29:00 | 2:40 | 2:07:01 | 1:48 | 1:25:48 | 4:06:15 |

| 2 | 3 | M | Marin Koceic | CRO | M40-44 | 2 | 27:34 | 2:09 | 2:12:13 | 1:30 | 1:27:19 | 4:10:44 |

Нужно его добавить.

for col in ['swim', 't1', 'bike', 't2', 'run', 'result']:

strlen = ar[col].str.len()

ar.loc[strlen==5, col] = '0:' + ar.loc[strlen==5, col]

ar.loc[strlen==4, col] = '0:0' + ar.loc[strlen==4, col]

Теперь времена, все еще оставаясь строками, выглядят так:

| place | sex | name | country | group | place in group | swim | t1 | bike | t2 | run | result | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 1 | M | Dejan Patrcevic | CRO | M40-44 | 1 | 0:29:03 | 0:02:50 | 2:09:17 | 0:01:37 | 1:22:06 | 4:04:51 |

| 1 | 2 | M | Lukas Krpec | CZE | M35-39 | 1 | 0:29:00 | 0:02:40 | 2:07:01 | 0:01:48 | 1:25:48 | 4:06:15 |

| 2 | 3 | M | Marin Koceic | CRO | M40-44 | 2 | 0:27:34 | 0:02:09 | 2:12:13 | 0:01:30 | 1:27:19 | 4:10:44 |

Конвертируем в Timedelta:

for col in ['swim', 't1', 'bike', 't2', 'run', 'result']:

ar[col] = pd.to_timedelta(ar[col])

Пол

Идем дальше. Проверим что в колонке sex есть только значения M и F:

ar['sex'].unique()

Out: ['M', 'F', '']

На самом деле там еще пустая строка, то есть пол не указан. Посмотрим сколько таких случаев:

len(ar[ar['sex'] == ''])

Out: 2538

Не так много — хорошо. В дальнейшем мы попытаемся еще уменьшить это значение. А пока оставим колонку sex как есть в виде строк. Сохраним результат, перед тем как перейти к более серьезным и рискованным преобразованиям. Для того, чтобы сохранять преемственность между файлами, преобразуем объединенный датафрейм ar обратно в словарь датафреймов rd:

for event in ar.index.get_level_values(0).unique():

rd[event] = ar.loc[event]

with open(r'D:tridetails1.pkl', 'wb') as f:

pkl.dump(rd,f)

Кстати, за счет преобразования типов некоторых колонок размеры файлов уменьшились с 367 KB до 295 KB для сводной таблицы и с 251 MB до 168 MB для протоколов гонок.

Код страны

Теперь посмотрим страну.

ar['country'].unique()

Out: ['CRO', 'CZE', 'SLO', 'SRB', 'BUL', 'SVK', 'SWE', 'BIH', 'POL', 'MK', 'ROU', 'GRE', 'FRA', 'HUN', 'NOR', 'AUT', 'MNE', 'GBR', 'RUS', 'UAE', 'USA', 'GER', 'URU', 'CRC', 'ITA', 'DEN', 'TUR', 'SUI', 'MEX', 'BLR', 'EST', 'NED', 'AUS', 'BGI', 'BEL', 'ESP', 'POR', 'UKR', 'CAN', 'IRL', 'JPN', 'HKG', 'JEY', 'SGP', 'BRA', 'QAT', 'LUX', 'RSA', 'NZL', 'LAT', 'PHI', 'KSA', 'SEY', 'MAS', 'OMA', 'ARG', 'ECU', 'THA', 'JOR', 'BRN', 'CIV', 'FIN', 'IRN', 'BER', 'LBA', 'KUW', 'LTU', 'SRI', 'HON', 'INA', 'LBN', 'PAN', 'EGY', 'MLT', 'WAL', 'ISL', 'CYP', 'DOM', 'IND', 'VIE', 'MRI', 'AZE', 'MLD', 'LIE', 'VEN', 'ALG', 'SYR', 'MAR', 'KZK', 'PER', 'COL', 'IRQ', 'PAK', 'CZK', 'KAZ', 'CHN', 'NEP', 'ISR', 'MKD', 'FRO', 'BAN', 'ARU', 'CPV', 'ALB', 'BIZ', 'TPE', 'KGZ', 'BNN', 'CUB', 'SNG', 'VTN', 'THI', 'PRG', 'KOR', 'RE', 'TW', 'VN', 'MOL', 'FRE', 'AND', 'MDV', 'GUA', 'MON', 'ARM', 'F.I.TRI.', 'BAHREIN', 'SUECIA', 'REPUBLICA CHECA', 'BRASIL', 'CHI', 'MDA', 'TUN', 'NDL', 'Danish(Dane)', 'Welsh', 'Austrian', 'Unknown', 'AFG', 'Argentinean', 'Pitcairn', 'South African', 'Greenland', 'ESTADOS UNIDOS', 'LUXEMBURGO', 'SUDAFRICA', 'NUEVA ZELANDA', 'RUMANIA', 'PM', 'BAH', 'LTV', 'ESA', 'LAB', 'GIB', 'GUT', 'SAR', 'ita', 'aut', 'ger', 'esp', 'gbr', 'hun', 'den', 'usa', 'sui', 'slo', 'cze', 'svk', 'fra', 'fin', 'isr', 'irn', 'irl', 'bel', 'ned', 'sco', 'pol', 'SMR', 'mex', 'STEEL T BG', 'KINO MANA', 'IVB', 'TCH', 'SCO', 'KEN', 'BAS', 'ZIM', 'Joe', 'PUR', 'SWZ', 'Mark', 'WLS', 'MYA', 'BOT', 'REU', 'NAM', 'NCL', 'BOL', 'GGY', 'ISV', 'TWN', 'GUM', 'FIJ', 'COK', 'NGR', 'IRI', 'GAB', 'ANT', 'GEO', 'COG', 'sue', 'SUD', 'BAR', 'CAY', 'BO', 'VE', 'AX', 'MD', 'PAR', 'UM', 'SEN', 'NIG', 'RWA', 'YEM', 'PLE', 'GHA', 'ITU', 'UZB', 'MGL', 'MAC', 'DMA', 'TAH', 'TTO', 'AHO', 'JAM', 'SKN', 'GRN', 'PRK', 'NFK', 'SOL', 'Sandy', 'SAM', 'PNG', 'SGS', 'Suchy, Jorg', 'SOG', 'GEQ', 'BVT', 'DJI', 'CHA', 'ANG', 'YUG', 'IOT', 'HAI', 'SJM', 'CUW', 'BHU', 'ERI', 'FLK', 'HMD', 'GUF', 'ESH', 'sandy', 'UMI', 'selsmark, 'Alise', 'Eddie', '31/3, Colin', 'CC', 'Индия', 'Ирландия', 'Армения', 'Болгария', 'Сербия', 'Республика Беларусь', 'Великобритания', 'Франция', 'Гондурас', 'Коста-Рика', 'Азербайджан', 'GRL', 'UGA', 'VAT', 'ETH', 'ASA', 'PYF', 'ATA', 'ALA', 'MTQ', 'ZZ', 'CXR', 'AIA', 'TJK', 'GUY', 'KR', 'PF', 'BN', 'MO', 'LA', 'CAM', 'NCA', 'ZAM', 'MAD', 'TOG', 'VIR', 'ATF', 'VAN', 'SLE', 'GLP', 'SCG', 'LAO', 'IMN', 'BUR', 'IR', 'SY', 'CMR', 'GBS', 'SUR', 'MOZ', 'BLM', 'MSR', 'CAF', 'BEN', 'COD', 'CCK', 'TUV', 'TGA', 'GI', 'XKX', 'NRU', 'NC', 'LBR', 'TAN', 'VIN', 'SSD', 'GP', 'PS', 'IM', 'JE', '', 'MLI', 'FSM', 'LCA', 'GMB', 'MHL', 'NH', 'FL', 'CT', 'UT', 'AQ', 'Korea', 'Taiwan', 'NewCaledonia', 'Czech Republic', 'PLW', 'BRU', 'RUN', 'NIU', 'KIR', 'SOM', 'TKM', 'SPM', 'BDI', 'COM', 'TCA', 'SHN', 'DO2', 'DCF', 'PCN', 'MNP', 'MYT', 'SXM', 'MAF', 'GUI', 'AN', 'Slovak republic', 'Channel Islands', 'Reunion', 'Wales', 'Scotland', 'ica', 'WLF', 'D', 'F', 'I', 'B', 'L', 'E', 'A', 'S', 'N', 'H', 'R', 'NU', 'BES', 'Bavaria', 'TLS', 'J', 'TKL', 'Tirol"', 'P', '?????', 'EU', 'ES-IB', 'ES-CT', 'КГЫ', 'SOO', 'LZE', 'Могилёв', 'Гомель', 'Минск', 'Самара', 'Гродно', 'Москва']

412 уникальных значений.

В основном страна обозначается трехзначным буквенным кодом в верхнем регистре. Но как видно, далеко не всегда. На самом деле существует международный стандарт ISO 3166, в котором для всех стран, включая даже те, которых уже не существует, прописаны соответствующие трехзначные и двузначные коды. Для python одну из реализаций этого стандарта можно найти в пакете pycountry. Вот как он работает:

import pycountry as pyco

pyco.countries.get(alpha_3 = 'RUS')

Out: Country(alpha_2='RU', alpha_3='RUS', name='Russian Federation', numeric='643')

Таким образом проверим все трехзначные коды, приведя к верхнему регистру, которые дают отклик в countries.get(…) и historic_countries.get(…):

valid_a3 = [c for c in ar['country'].unique() if pyco.countries.get(alpha_3 = c.upper()) != None or pyco.historic_countries.get(alpha_3 = c.upper()) != None])

Таких оказалось 190 из 412. То есть меньше половины.

Для остальных 222 (их список обозначим tofix) сделаем словарь соответствия fix, в котором ключом будет оригинальное название, а значением трехзначный код по стандарту ISO.

tofix = list(set(ar['country'].unique()) - set(valid_a3))

В первую очередь проверим двузначные коды с помощью pycountry.countries.get(alpha_2 = …), приведя к верхнему регистру:

for icc in tofix: #icc -invalid country code

if pyco.countries.get(alpha_2 = icc.upper()) != None:

fix[icc] = pyco.countries.get(alpha_2 = icc.upper()).alpha_3

else:

if pyco.historic_countries.get(alpha_2 = icc.upper()) != None:

fix[icc] = pyco.historic_countries.get(alpha_2 = icc.upper()).alpha_3

Затем полные имена через pycountry.countries.get(name = …), pycountry.countries.get(common_name = …), приведя их к форме str.title():

for icc in tofix:

if pyco.countries.get(common_name = icc.title()) != None:

fix[icc] = pyco.countries.get(common_name = icc.title()).alpha_3

else:

if pyco.countries.get(name = icc.title()) != None:

fix[icc] = pyco.countries.get(name = icc.title()).alpha_3

else:

if pyco.historic_countries.get(name = icc.title()) != None:

fix[icc] = pyco.historic_countries.get(name = icc.title()).alpha_3

Таким образом сокращаем число нераспознанных значений до 190. Все еще достаточно много:

['URU', '', 'PAR', 'SUECIA', 'KUW', 'South African', 'Гомель', 'Austrian', 'ISV', 'H', 'SCO', 'ES-CT', Гондурас', 'GUI', 'BOT', 'SEY', 'BIZ', 'LAB', 'PUR', 'Республика Беларусь', 'Scotland', 'Азербайджан', 'Минск', 'TCH', 'TGA', 'UT', 'BAH', 'GEQ', 'NEP', 'TAH', 'ica', 'FRE', 'E', 'TOG', 'MYA', 'Болгария', 'Danish (Dane)', 'SAM', 'TPE', 'MON', 'ger', 'Unknown', 'sui', 'R', 'SUI', 'A', 'GRN', 'KZK', 'Wales', 'Москва', 'GBS', 'ESA', 'Bavaria', 'Czech Republic', '31/3, Colin', 'SOL', 'SKN', 'Франция', 'MGL', 'XKX', 'WLS', 'MOL', 'FIJ', 'CAY', 'ES-IB', 'BER', 'PLE', 'MRI', 'B', 'KSA', 'Великобритания', 'Гродно', 'LAT', 'GRE', 'ARU', 'КГЫ', 'THI', 'NGR', 'MAD', 'SOG', 'MLD', '?????', 'AHO', 'sco', 'UAE', 'RUMANIA', 'CRO', 'RSA', 'NUEVA ZELANDA', 'KINO MANA', 'PHI', 'sue', 'Tirol"', 'IRI', 'POR', 'CZK', 'SAR', 'D', 'BRASIL', 'DCF', 'HAI', 'ned', 'N', 'BAHREIN', 'VTN', 'EU', 'CAM', 'Mark', 'BUL', 'Welsh', 'VIN', 'HON', 'ESTADOS UNIDOS', 'I', 'GUA', 'OMA', 'CRC', 'PRG', 'NIG', 'BHU', 'Joe', 'GER', 'RUN', 'ALG', 'Сербия', 'Channel Islands', 'Reunion', 'REPUBLICA CHECA', 'slo', 'ANG', 'NewCaledonia', 'GUT', 'VIE', 'ASA', 'BAR', 'SRI', 'L', 'Могилёв', 'J', 'BAS', 'LUXEMBURGO', 'S', 'CHI', 'SNG', 'BNN', 'den', 'F.I.TRI.', 'STEEL T BG', 'NCA', 'Slovak republic', 'MAS', 'LZE', 'Коста-Рика', 'F', 'BRU', 'Армения', 'LBA', 'NDL', 'DEN', 'IVB', 'BAN', 'Sandy', 'ZAM', 'sandy', 'Korea', 'SOO', 'BGI', 'Индия', 'LTV', 'selsmark, Alise', 'TAN', 'NED', 'Самара', 'Suchy, Jorg', 'SLO', 'SUDAFRICA', 'ZIM', 'Eddie', 'INA', 'Ирландия', 'SUD', 'VAN', 'FL', 'P', 'ITU', 'ZZ', 'Argentinean', 'CHA', 'DO2', 'WAL']

Можно заметить, что среди них все еще много трехзначных кодов, но это не ISO. Что же тогда? Оказывается, что существует еще один стандарт – олимпийский. К сожалению, его реализация не включена в pycountry и приходится искать что-то еще. Решение нашлось в виде csv файла на datahub.io. Поместим содержимое этого файла в pandas DataFrame под названием cdf.

| official name | short name | iso2 | iso3 | ioc | |

|---|---|---|---|---|---|

| 0 | NaN | Taiwan | TW | TWN | TPE |

| 1 | Afghanistan | Afghanistan | AF | AFG | AFG |

| 2 | Albania | Albania | AL | ALB | ALB |

| 3 | Algeria | Algeria | DZ | DZA | ALG |

| 4 | American Samoa | American Samoa | AS | ASM | ASA |

| 5 | Andorra | Andorra | AD | AND | AND |

| 6 | Angola | Angola | AO | AGO | ANG |

| 7 | Anguilla | Anguilla | AI | AIA | AIA |

| 8 | Antarctica | Antarctica | AQ | ATA | NaN |

| 9 | Antigua and Barbuda | Antigua & Barbuda | AG | ATG | ANT |

| 10 | Argentina | Argentina | AR | ARG | ARG |

ioc – Intenational Olympic Committee (IOC)

len(([x for x in tofix if x.upper() in list(cdf['ioc'])]))

Out: 82

Среди трехзначных кодов из tofix нашлось 82 соответствующих IOC. Добавим их в наш словарь соответствия.

for icc in tofix:

if icc.upper() in list(cdf['ioc']):

ind = cdf[cdf['ioc'] == icc.upper()].index[0]

fix[icc] = cdf.loc[ind, 'iso3']

Осталось 108 необработанных значений. Их добиваем вручную, иногда обращаясь за помощью в Google.

{'BGI': 'BRB', 'WAL': 'GBR', 'MLD': 'MDA', 'KZK': 'KAZ', 'CZK': 'CZE', 'BNN': 'BEN', 'SNG': 'SGP', 'VTN': 'VNM', 'THI': 'THA', 'PRG': 'PRT', 'MOL': 'MDA', 'FRE': 'FRA', 'F.I.TRI.': 'ITA', 'BAHREIN': 'BHR', 'SUECIA': 'SWE', 'REPUBLICA CHECA': 'CZE', 'BRASIL': 'BRA', 'NDL': 'NLD', 'Danish (Dane)': 'DNK', 'Welsh': 'GBR', 'Austrian': 'AUT', 'Argentinean': 'ARG', 'South African': 'ZAF', 'ESTADOS UNIDOS': 'USA', 'LUXEMBURGO': 'LUX', 'SUDAFRICA': 'ZAF', 'NUEVA ZELANDA': 'NZL', 'RUMANIA': 'ROU', 'sco': 'GBR', 'SCO': 'GBR', 'WLS': 'GBR', 'Индия': 'IND', 'Ирландия': 'IRL', 'Армения': 'ARM', 'Болгария': 'BGR', 'Сербия': 'SRB', 'Республика Беларусь': 'BLR', 'Великобритания': 'GBR', 'Франция': 'FRA', 'Гондурас': 'HND', 'Коста-Рика': 'CRI', 'Азербайджан': 'AZE', 'Korea': 'KOR', 'NewCaledonia': 'FRA', 'Czech Republic': 'CZE', 'Slovak republic': 'SVK', 'Channel Islands': 'FRA', 'Reunion': 'FRA', 'Wales': 'GBR', 'Scotland': 'GBR', 'Bavaria': 'DEU', 'Tirol"': 'AUT', 'КГЫ': 'KGZ', 'Могилёв': 'BLR', 'Гомель': 'BLR', 'Минск': 'BLR', 'Самара': 'RUS', 'Гродно': 'BLR', 'Москва': 'RUS'}

Но даже ручное управление не решает проблему полностью. Остается 49 значений, которые уже невозможно интерпретировать. Вероятно, большая часть из этих значений – просто ошибки в данных.

unfixed = [x for x in tofix if x not in fix.keys()]

Out: ['', 'H', 'ES-CT', 'LAB', 'TCH', 'UT', 'TAH', 'ica', 'E', 'Unknown', 'R', 'A', '31/3, Colin', 'XKX', 'ES-IB','B','SOG','?????','KINO MANA','sue','SAR','D', 'DCF', 'N', 'EU', 'Mark', 'I', 'Joe', 'RUN', 'GUT', 'L', 'J', 'BAS', 'S', 'STEEL T BG', 'LZE', 'F', 'Sandy', 'DO2', 'sandy', 'SOO', 'LTV', 'selsmark, Alise', 'Suchy, Jorg' 'Eddie', 'FL', 'P', 'ITU', 'ZZ']

У этих ключей в словаре соответствия значением будет пустая строка.

for cc in unfixed:

fix[cc] = ''

Напоследок добавим в словарь соответствия коды, которые являются валидными, но записаны в нижнем регистре.

for cc in valid_a3:

if cc.upper() != cc:

fix[cc] = cc.upper()

Теперь пришло время применить найденные замены. Чтобы сохранить начальные данные для дальнейшего сравнения копируем колонку country в country raw. Затем используя созданный словарь соответствия исправляем в колонке country значения, которые не соответствуют ISO.

for cc in fix:

ind = ar[ar['country'] == cc].index

ar.loc[ind,'country'] = fix[cc]

Здесь, конечно, не обойтись без векторизации, в таблице почти полтора миллиона строк. Но по словарю делаем цикл, а как иначе? Проверяем, сколько записей изменено:

len(ar[ar['country'] != ar['country raw']])

Out: 315955

то есть более 20% от общего количества.

ar[ar['country'] != ar['country raw']].sample(10)

| place | sex | name | country | group | place in group | ... | country raw | |

|---|---|---|---|---|---|---|---|---|

| 285 | 286 | M | Albaek, Mads Orla | DNK | M30-34 | 63 | ... | DEN |

| 1288 | 1289 | M | Benthien, Andreas | DEU | M40-44 | 198 | ... | GER |

| 490 | 491 | M | Lontok, Joselito | PHL | M50-54 | 18 | ... | PHI |

| 145 | 146 | M | Mathiasen, Keld | DNK | M45-49 | 16 | ... | DEN |

| 445 | 446 | M | Palm, Francois | ZAF | M25-29 | 48 | ... | RSA |

| 152 | 153 | M | Muller, Johannes | DEU | M35-39 | 19 | ... | GER |

| 764 | 765 | F | Woscher Sylvia | DEU | F55-59 | 8 | ... | GER |

| 2182 | 2183 | M | Kojellis, Holger | DEU | M40-44 | 258 | ... | GER |

| 1293 | 1294 | M | Zweer, Waldemar | DEU | M25-29 | 117 | ... | GER |

| 747 | 748 | M | Petersen, Mathias | DNK | M25-29 | 79 | ... | DE |

len(ar[ar['country'] == ''])

Out: 3221

Таково количество записей без страны или со страной неформата. Количество уникальных стран сократилось с 412 до 250. Вот они:

['', 'ABW', 'AFG', 'AGO', 'AIA', 'ALA', 'ALB', 'AND', 'ANT', 'ARE', 'ARG', 'ARM', 'ASM', 'ATA', 'ATF', 'AUS', 'AUT', 'AZE', 'BDI', 'BEL', 'BEN', 'BES', 'BGD', 'BGR', 'BHR', 'BHS', 'BIH', 'BLM', 'BLR', 'BLZ', 'BMU', 'BOL', 'BRA', 'BRB', 'BRN', 'BTN', 'BUR', 'BVT', 'BWA', 'CAF', 'CAN', 'CCK', 'CHE', 'CHL', 'CHN', 'CIV', 'CMR', 'COD', 'COG', 'COK', 'COL', 'COM', 'CPV', 'CRI', 'CTE', 'CUB', 'CUW', 'CXR', 'CYM', 'CYP', 'CZE', 'DEU', 'DJI', 'DMA', 'DNK', 'DOM', 'DZA', 'ECU', 'EGY', 'ERI', 'ESH', 'ESP', 'EST', 'ETH', 'FIN', 'FJI', 'FLK', 'FRA', 'FRO', 'FSM', 'GAB', 'GBR', 'GEO', 'GGY', 'GHA', 'GIB', 'GIN', 'GLP', 'GMB', 'GNB', 'GNQ', 'GRC', 'GRD', 'GRL', 'GTM', 'GUF', 'GUM', 'GUY', 'HKG', 'HMD', 'HND', 'HRV', 'HTI', 'HUN', 'IDN', 'IMN', 'IND', 'IOT', 'IRL', 'IRN', 'IRQ', 'ISL', 'ISR', 'ITA', 'JAM', 'JEY', 'JOR', 'JPN', 'KAZ', 'KEN', 'KGZ', 'KHM', 'KIR', 'KNA', 'KOR', 'KWT', 'LAO', 'LBN', 'LBR', 'LBY', 'LCA', 'LIE', 'LKA', 'LTU', 'LUX', 'LVA', 'MAC', 'MAF', 'MAR', 'MCO', 'MDA', 'MDG', 'MDV', 'MEX', 'MHL', 'MKD', 'MLI', 'MLT', 'MMR', 'MNE', 'MNG', 'MNP', 'MOZ', 'MSR', 'MTQ', 'MUS', 'MYS', 'MYT', 'NAM', 'NCL', 'NER', 'NFK', 'NGA', 'NHB', 'NIC', 'NIU', 'NLD', 'NOR', 'NPL', 'NRU', 'NZL', 'OMN', 'PAK', 'PAN', 'PCN', 'PER', 'PHL', 'PLW', 'PNG', 'POL', 'PRI', 'PRK', 'PRT', 'PRY', 'PSE', 'PYF', 'QAT', 'REU', 'ROU', 'RUS', 'RWA', 'SAU', 'SCG', 'SDN', 'SEN', 'SGP', 'SGS', 'SHN', 'SJM', 'SLB', 'SLE', 'SLV', 'SMR', 'SOM', 'SPM', 'SRB', 'SSD', 'SUR', 'SVK', 'SVN', 'SWE', 'SWZ', 'SXM', 'SYC', 'SYR', 'TCA', 'TCD', 'TGO', 'THA', 'TJK', 'TKL', 'TKM', 'TLS', 'TON', 'TTO', 'TUN', 'TUR', 'TUV', 'TWN', 'TZA', 'UGA', 'UKR', 'UMI', 'URY', 'USA', 'UZB', 'VAT', 'VCT', 'VEN', 'VGB', 'VIR', 'VNM', 'VUT', 'WLF', 'WSM', 'YEM', 'YUG', 'ZAF', 'ZMB', 'ZWE']

Теперь никаких отклонений. Сохраняем результат в новый файл details2.pkl, предварительно преобразовав объединенный датафрейм обратно в словарь датафреймов, как это было сделано ранее.

Локация

Теперь вспомним, что упоминание о странах также есть и в сводной таблице, в колонке loc.

| event | date | loc | males | females | rus | total | link | |

|---|---|---|---|---|---|---|---|---|

| 0 | Ironman Dubai Duathlon 70.3 2020 | 2020-07-02 | Dubai, United Arab Emirates | 835 | 215 | 65 | 1050 | … |

| 1 | Ironman Dubai 70.3 2020 | 2020-02-07 | Dubai, United Arab Emirates | 638 | 132 | 55 | 770 | … |

| 2 | Israman Half 2020 | 2020-01-29 | Israel, Eilat | 670 | 126 | 4 | 796 | … |

| 3 | Ironman Indian Wells La Quinta 70.3 2019 | 2019-12-08 | Indian Wells/La Quinta, California, USA | 1590 | 593 | 6 | 2183 | … |

| 4 | Ironman Taupo 70.3 2019 | 2019-12-07 | New Zealand | 767 | 420 | 3 | 1187 | … |

| 5 | Ironman Bahrain 70.3 2019 | 2019-12-07 | Manama, Bahrain | 858 | 214 | 38 | 1072 | … |

| 6 | Ironman Western Australia 2019 | 2019-12-01 | Busselton, Western Australia | 940 | 229 | 1 | 1169 | … |

| 7 | Ironman Mar del Plata 2019 | 2019-12-01 | Mar del Plata, Argentina | 506 | 66 | 3 | 572 | … |

| 8 | Ironman Cozumel 2019 | 2019-11-24 | Cozumel, Mexico | 1158 | 395 | 12 | 1553 | … |

| 9 | Ironman Arizona 2019 | 2019-11-24 | Tempe, Arizona, USA | 1697 | 633 | 3 | 2330 | … |

Его тоже нужно привести к стандартному виду. Здесь немного другая история: не видно ни ISO, ни олимпийских кодов. Все описано в достаточно свободной форме. Через запятую перечислены город, страна и другие составляющие адреса, причем в произвольном порядке. Где-то страна на первом месте, где-то на последнем. pycountry тут уже не поможет. А записей много – на 1922 гонки 525 уникальных локаций (в исходном виде).

Но и тут нашелся подходящий инструмент. Это geopy, а именно geolocator Nominatim. Работает вот так:

from geopy.geocoders import Nominatim

geolocator = Nominatim(user_agent='triathlon results researcher')

geolocator.geocode('Бирюзовая Катунь, Алтай, Россия', language='en')

Out: Location(Бирюзовая Катунь, Ая – Бирюзовая Катунь, Айский сельсовет, Altaysky District, Altai Krai, Siberian Federal District, Russia, (51.78897945, 85.73956296106752, 0.0))

По запросу в произвольной форме выдает структурированный ответ – адрес и координаты. Если задать язык, как здесь – английский, то что сможет — переведет. Нам в первую очередь нужно стандартное название страны для последующего перевода в код ISO. Оно как раз стоит на последнем месте в свойстве address. Поскольку geolocator каждый раз отправляет запрос на сервер, процесс этот не быстрый и для 500 записей занимает несколько минут. К тому же бывает, что ответ не приходит. В этом случае иногда помогает повторный запрос. В моем с первого раза ответ не пришел на 130 запросов. Большую часть из них удалось обработать двумя повторными попытками. Однако 34 названия обработать не так и не удалось даже несколькими дальнейшими повторными попытками. Вот они:

['Tongyeong, Korea, Korea, South', 'Constanta, Mamaia, Romania, Romania', 'Weihai, China, China', 'д. Толвинка, Брянская обл.', 'Odaiba Marin Park, Tokyo, Japan, Japan', 'Sweden, Smaland, Kalmar', 'Cholpon-Ata city, Resort Center "Kapriz", Kyrgyzstan', 'Luxembourg, Region Moselle, Moselle', 'Chita Peninsula, Japan', 'Kraichgau Region, Germany', 'Jintang, Chengdu, Sichuan Province, China, China', 'Madrid, Spain, Spain', 'North American Pro Championship, St. George, Utah, USA', 'Milan Idroscalo Linate, Italy', 'Dexing, Jiangxi Province, China, China', 'Mooloolaba, Australia, Australia', 'Nathan Benderson Park (NBP), 5851 Nathan Benderson Circle, Sarasota, FL 34235., United States', 'Strathclyde Country Park, North Lanarkshire, Glasgow, Great Britain', 'Quijing, China', 'United States of America , Hawaii, Kohala Coast', 'Buffalo City, East London, South Africa', 'Spain, Vall de Cardener', 'Россия, пос. Метлино Озерский городской округ', 'Asian TriClub Championship, Hefei, China', 'Taizhou, Jiangsu Province, China, China', 'Россия, Москва, СЦП «Крылатское»', 'Buffalo, Gallagher Beach, Furhmann Blvd, United States', 'North American Pro Championship | St. George, Utah, USA', 'Weihai, Shandong, China, China', 'Tarzo - Revine Lago, Italy', 'Lausanee, Switzerland', 'Queenstown, New Zealand, New Zealand', 'Makuhari, Japan, Japan', 'Szombathlely, Hungary']

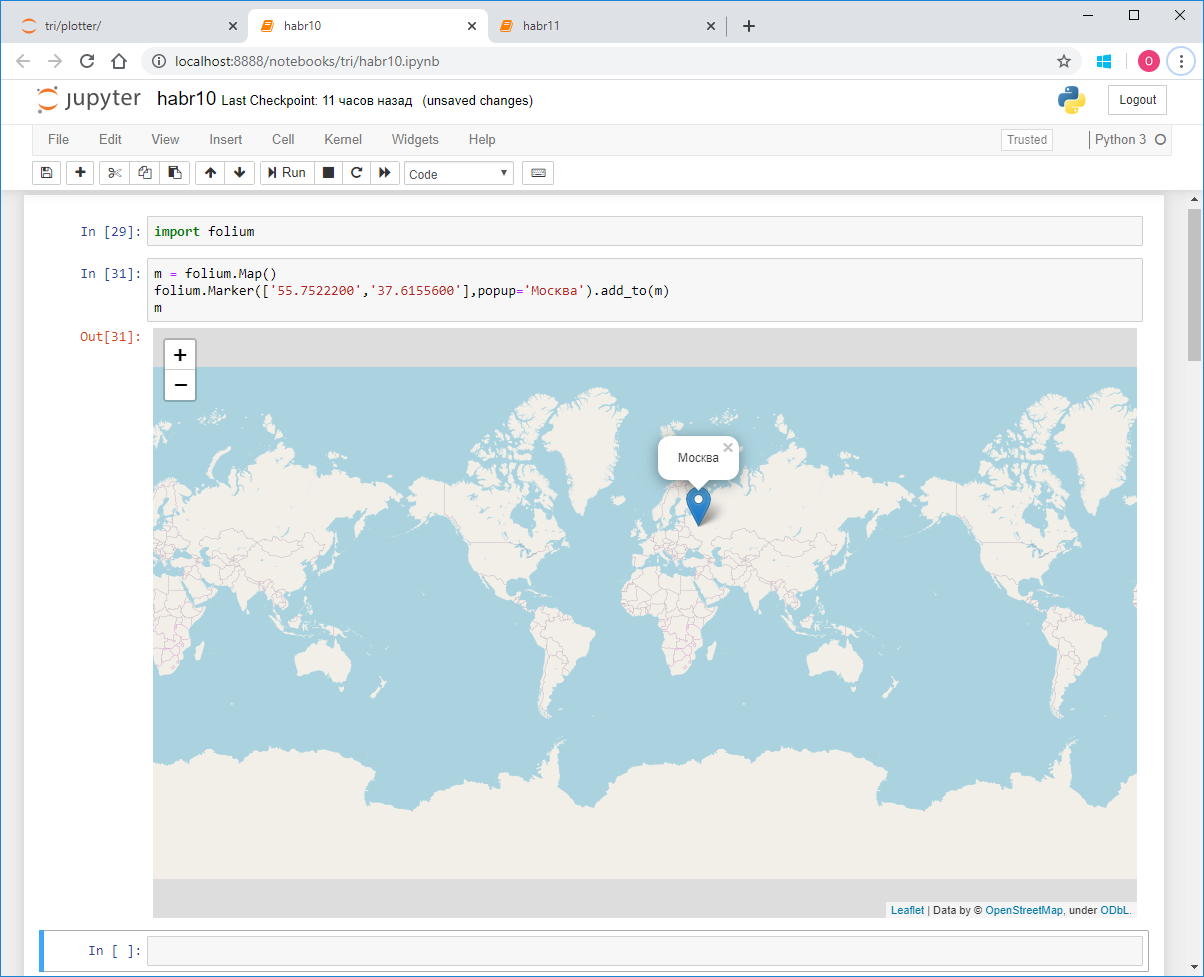

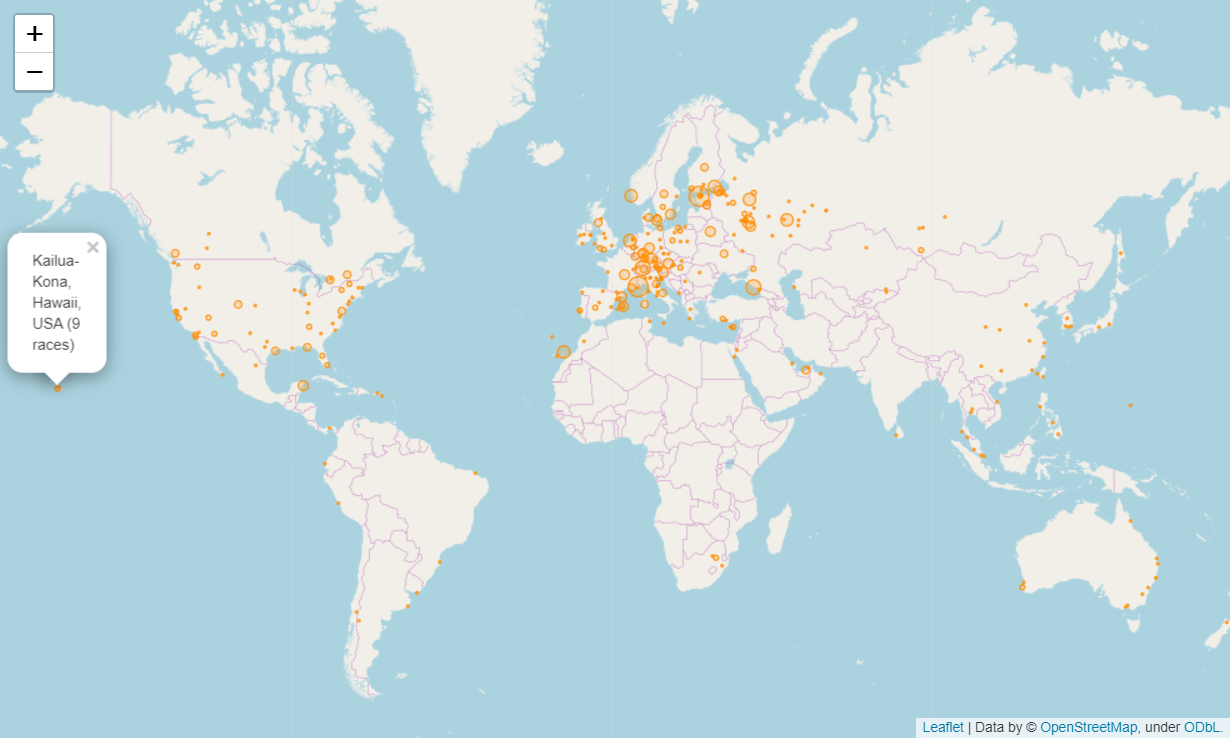

Видно, что во многих присутствует двойное упоминание страны, и это на самом деле мешает. В общем пришлось вручную обработать эти оставшиеся названия и для всех были получены стандартные адреса. Далее из этих адресов я выделил страну и записал эту страну в новую колонку в сводной таблице. Поскольку, как я уже сказал работа с geopy не быстрая, я решил сразу сохранить координаты локации – широту и долготу. Они пригодятся позже для визуализации на карте.

| event | date | loc | country | latitude | longitude | ... | |

|---|---|---|---|---|---|---|---|

| 0 | Ironman Dubai Duathlon 70.3 2020 | 2020-07-02 | Dubai, United Arab Emirates | United Arab Emirates | 25.0657 | 55.1713 | ... |

| 1 | Ironman Dubai 70.3 2020 | 2020-02-07 | Dubai, United Arab Emirates | United Arab Emirates | 25.0657 | 55.1713 | ... |

| 2 | Israman Half 2020 | 2020-01-29 | Israel, Eilat | Israel | 29.5569 | 34.9498 | ... |

| 3 | Ironman Indian Wells La Quinta 70.3 2019 | 2019-12-08 | Indian Wells/La Quinta, California, USA | United States of America | 33.7238 | -116.305 | ... |

| 4 | Ironman Taupo 70.3 2019 | 2019-12-07 | New Zealand | New Zealand | -41.5001 | 172.834 | ... |

| 5 | Ironman Bahrain 70.3 2019 | 2019-12-07 | Manama, Bahrain | Bahrain | 26.2235 | 50.5822 | ... |

| 6 | Ironman Western Australia 2019 | 2019-12-01 | Busselton, Western Australia | Australia | -33.6445 | 115.349 | ... |

| 7 | Ironman Mar del Plata 2019 | 2019-12-01 | Mar del Plata, Argentina | Argentina | -37.9977 | -57.5483 | ... |

| 8 | Ironman Cozumel 2019 | 2019-11-24 | Cozumel, Mexico | Mexico | 20.4318 | -86.9203 | ... |

| 9 | Ironman Arizona 2019 | 2019-11-24 | Tempe, Arizona, USA | United States of America | 33.4255 | -111.94 | ... |

| 10 | Ironman Xiamen 70.3 2019 | 2019-11-10 | Xiamen, China | China | 24.4758 | 118.075 | ... |

После этого с помощью pyco.countries.get(name = ‘...’).alpha_3 искал страну по названию и выделял трехзначный код.

| event | date | loc | country | latitude | longitude | ... | |

|---|---|---|---|---|---|---|---|

| 0 | Ironman Dubai Duathlon 70.3 2020 | 2020-07-02 | Dubai, United Arab Emirates | ARE | 25.0657 | 55.1713 | ... |

| 1 | Ironman Dubai 70.3 2020 | 2020-02-07 | Dubai, United Arab Emirates | ARE | 25.0657 | 55.1713 | ... |

| 2 | Israman Half 2020 | 2020-01-29 | Israel, Eilat | ISR | 29.5569 | 34.9498 | ... |

| 3 | Ironman Indian Wells La Quinta 70.3 2019 | 2019-12-08 | Indian Wells/La Quinta, California, USA | USA | 33.7238 | -116.305 | ... |

| 4 | Ironman Taupo 70.3 2019 | 2019-12-07 | New Zealand | NZL | -41.5001 | 172.834 | ... |

| 5 | Ironman Bahrain 70.3 2019 | 2019-12-07 | Manama, Bahrain | BHR | 26.2235 | 50.5822 | ... |

| 6 | Ironman Western Australia 2019 | 2019-12-01 | Busselton, Western Australia | AUS | -33.6445 | 115.349 | ... |

| 7 | Ironman Mar del Plata 2019 | 2019-12-01 | Mar del Plata, Argentina | ARG | -37.9977 | -57.5483 | ... |

| 8 | Ironman Cozumel 2019 | 2019-11-24 | Cozumel, Mexico | MEX | 20.4318 | -86.9203 | ... |

| 9 | Ironman Arizona 2019 | 2019-11-24 | Tempe, Arizona, USA | USA | 33.4255 | -111.94 | ... |

| 10 | Ironman Xiamen 70.3 2019 | 2019-11-10 | Xiamen, China | CHN | 24.4758 | 118.075 | ... |

Дистанция

Еще одно важное действие, которое нужно сделать на сводной таблице – для каждой гонки определить дистанцию. Это пригодится нам для вычисления скоростей в дальнейшем. В триатлоне существует четыре основных дистанции – спринт, олимпийская, полужелезная и железная. Можно видеть, что в названиях гонок как правило есть указание на дистанцию – это Слова Sprint, Olympic, Half, Full. Помимо этого, у разных организаторов свои обозначения дистанций. Половинка у Ironman, например, обозначается как 70.3 – по количеству миль в дистанции, олимпийская – 5150 по числу километров (51.5), а железная может обозначаться как Full или, вообще, как отсутствие пояснений – например Ironman Arizona 2019. Ironman – он и есть железный! У Challenge железная дистанция обозначается как Long, а полужелезная – как Middle. Наш российский IronStar обозначает полную как 226, а половинку как 113 – по числу километров, но обычно слова Full и Half тоже присутствуют. Теперь применим все эти знания и пометим все гонки в соответствии с ключевыми словами, присутствующими в названиях.

sprints = rs.loc[[i for i in rs.index if 'sprint' in rs.loc[i, 'event'].lower()]]

olympics1 = rs.loc[[i for i in rs.index if 'olympic' in rs.loc[i, 'event'].lower()]]

olympics2 = rs.loc[[i for i in rs.index if '5150' in rs.loc[i, 'event'].lower()]]

olympics = pd.concat([olympics1, olympics2])

#… и так далее

rsd = pd.concat([sprints, olympics, halfs, fulls])

В rsd получилось 1 925 записей, то есть на три больше, чем общее число гонок, значит какие-то попали под два критерия. Посмотрим на них:

rsd[rsd.duplicated(keep=False)]['event'].sort_index()

| event | date | loc | country | latitude | longitude | ... | |

|---|---|---|---|---|---|---|---|

| 38 | Temiradam 113 Half 2019 | 2019-09-22 | Казахстан, Актау | KAZ | 43.6521 | 51.158 | ... |

| 38 | Temiradam 113 Half 2019 | 2019-09-22 | Казахстан, Актау | KAZ | 43.6521 | 51.158 | ... |

| 65 | Triway Olympic Sprint 2019 | 2019-09-08 | Россия, Ростов-на-Дону | RUS | 47.2214 | 39.7114 | ... |

| 65 | Triway Olympic Sprint 2019 | 2019-09-08 | Россия, Ростов-на-Дону | RUS | 47.2214 | 39.7114 | ... |

| 82 | Ironman Dun Laoghaire Full Swim 70.3 2019 | 2019-08-25 | Ireland, Dun Laoghaire | IRL | 53.2923 | -6.13601 | ... |

| 82 | Ironman Dun Laoghaire Full Swim 70.3 2019 | 2019-08-25 | Ireland, Dun Laoghaire | IRL | 53.2923 | -6.13601 | ... |

Действительно, так и есть. В первой паре в названии Temiradam 113 Half 2019 есть упоминание и Half и 113. Но это не противоречие, они оба идентифицировались как половинки. Далее — Triway Olympic Sprint 2019. Здесь действительно можно запутаться – есть и Olympic и Sprint. Разобраться можно, посмотрев на протокол с результатами гонки.

| place | sex | name | country | group | place in group | swim | t1 | bike | t2 | run | result | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 1 | M | Хисматуллин Роман | RUS | MМужчины | 1 | 00:12:21 | 00:00:31 | 00:34:13 | 00:00:25 | 00:21:49 | 01:09:19 |

| 1 | 2 | M | Диков Александр | RUS | MМужчины | 2 | 00:12:21 | 00:00:28 | 00:34:15 | 00:00:26 | 00:23:07 | 01:10:38 |

| 2 | 3 | M | Горлов Дмитрий | RUS | MМужчины | 3 | 00:14:20 | 00:00:37 | 00:35:48 | 00:00:34 | 00:22:16 | 01:13:35 |

Лучшее время – 1:09. Значит это спринт. Удалим эту запись из списка олимпийских.

olympics.drop(65)

Точно так же поступим с пересекающимися Ironman Dun Laoghaire Full Swim 70.3 2019

| place | sex | name | country | group | place in group | swim | t1 | bike | t2 | run | result | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 1 | M | Brownlee, Alistair | GBR | MPRO | 1 | 00:23:19 | 00:02:18 | 02:21:19 | 00:01:55 | 01:11:42 | 04:00:33 |

| 1 | 2 | M | Smales, Elliot | GBR | MPRO | 2 | 00:24:47 | 00:02:09 | 02:29:26 | 00:01:48 | 01:12:47 | 04:10:57 |

| 2 | 3 | M | Bowden, Adam | GBR | MPRO | 3 | 00:23:24 | 00:02:18 | 02:32:09 | 00:02:06 | 01:13:49 | 04:13:46 |

Здесь лучшее время 4:00. Это характерно для половинки. Удаляем запись с индексом 85 из fulls.

fulls.drop(85)

Теперь запишем информацию о дистанции в основной датафрейм и посмотрим, что получилось:

rs['dist'] = ''

rs.loc[sprints.index,'dist'] = 'sprint'

rs.loc[olympics.index,'dist'] = 'olympic'

rs.loc[halfs.index,'dist'] = 'half'

rs.loc[fulls.index,'dist'] = 'full'

rs.sample(10)

| event | place | sex | name | country | group | place in group | ... | country raw | group raw |

|---|---|---|---|---|---|---|---|---|---|

| ... | 566 | M | Vladimir Kozar | SVK | M40-44 | 8 | ... | SVK | MOpen 40-44 |

| ... | 8 | M | HANNES COOL | BEL | MPRO | 11 | ... | BEL | MPRO M |

| ... | 445 | F | Ileana Sodani | USA | F45-49 | 4 | ... | USA | F45-49 F |

| ... | 227 | F | JARLINSKA Bozena | POL | F45-49 | 2 | ... | POL | FK45-49 |

| ... | 440 | F | Celine Orrigoni | FRA | F40-44 | 6 | ... | FRA | F40-44 F |

| ... | 325 | M | Vladimir Eckert | SVK | M40-44 | 6 | ... | SVK | MOpen 40-44 |

| ... | 139 | F | ATRASZKIEWICZ Magda | POL | F40-44 | 2 | ... | POL | FK40-44 |

| ... | 18 | M | Marijn de Jonge | NLD | MPRO | 18 | ... | NED | Mpro |

| ... | 574 | M | Luca Andalo | ITA | M40-44 | 9 | ... | ITA | MOpen 40-44 |

| ... | 67 | M | URBANKIEWICZ Aleksandra | POL | M35-39 | 1 | ... | POL | MK35-39 |

Проверим, что не осталось непокрытых записей:

len(rs[rs['dist'] == ''])

Out: 0

И проверим наши проблемные, двусмысленные:

rs.loc[[38,65,82],['event','dist']]

| event | dist | |

|---|---|---|

| 38 | Temiradam 113 Half 2019 | half |

| 65 | Triway Olympic Sprint 2019 | sprint |

| 82 | Ironman Dun Laoghaire Full Swim 70.3 2019 | half |

Все нормально. Сохраняем в новый файл:

pkl.dump(rs, open(r'D:trisummary5.pkl', 'wb'))

Возрастные группы

Теперь вернемся к протоколам гонок.

Мы уже проанализировали пол, страну и результаты участника, и привели их к стандартному виду. Но еще остались еще две графы – группа и, собственно, само имя. Начнем с групп. В триатлоне принято делить участников по возрастным группам. Также часто выделяется группа профессионалов. По сути, зачет идет в каждой такой группе отдельно — награждаются первые три места в каждой группе. По группам же идет квалификационный отбор на чемпионаты, например, на Кону.

Объединим все записи и посмотрим какие вообще группы существуют.

rd = pkl.load(open(r'D:tridetails2.pkl', 'rb'))

ar = pd.concat(rd)

ar['group'].unique()

Оказалось, что групп огромное количество – 581. Сотня случайно выбранных выглядит так:

['MSenior', 'FAmat.', 'M20', 'M65-59', 'F25-29', 'F18-22', 'M75-59', 'MPro', 'F24', 'MCORP M', 'F21-30', 'MSenior 4', 'M40-50', 'FAWAD', 'M16-29', 'MK40-49', 'F65-70', 'F65-70', 'M12-15', 'MK18-29', 'MМ50up', 'FSEMIFINAL 2 PRO', 'F16', 'MWhite', 'MOpen 25-29', 'FПараатлет', 'MPT TRI-2', 'M16-24', 'FQUALIFIER 1 PRO', 'F15-17', 'FSEMIFINAL 2 JUNIOR', 'FOpen 60-64', 'M75-80', 'F60-69', 'FJUNIOR A', 'F17-18', 'FAWAD BLIND', 'M75-79', 'M18-29', 'MJUN19-23', 'M60-up', 'M70', 'MPTS5', 'F35-40', "M'S PT1", 'M50-54', 'F65-69', 'F17-20', 'MP4', 'M16-29', 'F18up', 'MJU', 'MPT4', 'MPT TRI-3', 'MU24-39', 'MK35-39', 'F18-20', "M'S", 'F50-55', 'M75-80', 'MXTRI', 'F40-45', 'MJUNIOR B', 'F15', 'F18-19', 'M20-29', 'MAWAD PC4', 'M30-37', 'F21-30', 'Mpro', 'MSEMIFINAL 1 JUNIOR', 'M25-34', 'MAmat.', 'FAWAD PC5', 'FA', 'F50-60', 'FSenior 1', 'M80-84', 'FK45-49', 'F75-79', 'M<23', 'MPTS3', 'M70-75', 'M50-60', 'FQUALIFIER 3 PRO', 'M9', 'F31-40', 'MJUN16-19', 'F18-19', 'M PARA', 'F35-44', 'MParaathlete', 'F18-34', 'FA', 'FAWAD PC2', 'FAll Ages', 'M PARA', 'F31-40', 'MM85', 'M25-39']

Посмотрим какие из них самые многочисленные:

ar['group'].value_counts()[:30]

Out:

M40-44 199157

M35-39 183738

M45-49 166796

M30-34 154732

M50-54 107307

M25-29 88980

M55-59 50659

F40-44 48036

F35-39 47414

F30-34 45838

F45-49 39618

MPRO 38445

F25-29 31718

F50-54 26253

M18-24 24534

FPRO 23810

M60-64 20773

M 12799

F55-59 12470

M65-69 8039

F18-24 7772

MJUNIOR 6605

F60-64 5067

M20-24 4580

FJUNIOR 4105

M30-39 3964

M40-49 3319

F 3306

M70-74 3072

F20-24 2522

Можно видеть, что это группы по пять лет, отдельно для мужчин и отдельно для женщин, а также профессиональные группы MPRO и FPRO.

Итак, нашим стандартом будет:

ag = ['MPRO', 'M18-24', 'M25-29', 'M30-34', 'M35-39', 'M40-44', 'M45-49', 'M50-54', 'M55-59', 'M60-64', 'M65-69', 'M70-74', 'M75-79', 'M80-84', 'M85-90', 'FPRO', 'F18-24', 'F25-29', 'F30-34', 'F35-39', 'F40-44', 'F45-49', 'F50-54', 'F55-59', 'F60-64', 'F65-69', 'F70-74', 'F75-79', 'F80-84', 'F85-90']

#ag – age group

Этим множеством покрывается почти 95% всех финишеров.

Разумеется, нам не удастся привести к этому стандарту вообще все группы. Но мы поищем те, что похожи на них и приведем хотя бы часть. Предварительно приведем к верхнему регистру и удалим пробелы. Вот что нашлось:

['F25-29F', 'F30-34F', 'F30-34-34', 'F35-39F', 'F40-44F', 'F45-49F', 'F50-54F', 'F55-59F', 'FAG:FPRO', 'FK30-34', 'FK35-39', 'FK40-44', 'FK45-49', 'FOPEN50-54', 'FOPEN60-64', 'MAG:MPRO', 'MK30-34', 'MK30-39', 'MK35-39', 'MK40-44', 'MK40-49', 'MK50-59', 'MМ40-44', 'MM85-89', 'MOPEN25-29', 'MOPEN30-34', 'MOPEN35-39', 'MOPEN40-44', 'MOPEN45-49', 'MOPEN50-54', 'MOPEN70-74', 'MPRO:', 'MPROM', 'M0-44"']

Преобразуем их к нашим стандартным.

fix = { 'F25-29F': 'F25-29', 'F30-34F' : 'F30-34', 'F30-34-34': 'F30-34', 'F35-39F': 'F35-39', 'F40-44F': 'F40-44', 'F45-49F': 'F45-49', 'F50-54F': 'F50-54', 'F55-59F': 'F55-59', 'FAG:FPRO': 'FPRO', 'FK30-34': 'F30-34', 'FK35-39': 'F35-39', 'FK40-44': 'F40-44', 'FK45-49': 'F45-49', 'FOPEN50-54': 'F50-54', 'FOPEN60-64': 'F60-64', 'MAG:MPRO': 'MPRO', 'MK30-34': 'M30-34', 'MK30-39': 'M30-39', 'MK35-39': 'M35-39', 'MK40-44': 'M40-44', 'MK40-49': 'M40-49', 'MK50-59': 'M50-59', 'MМ40-44': 'M40-44', 'MM85-89': 'M85-89', 'MOPEN25-29': 'M25-29', 'MOPEN30-34': 'M30-34', 'MOPEN35-39': 'M35-39', 'MOPEN40-44': 'M40-44', 'MOPEN45-49': 'M45-49', 'MOPEN50-54': 'M50-54', 'MOPEN70-74': 'M70- 74', 'MPRO:' :'MPRO', 'MPROM': 'MPRO', 'M0-44"' : 'M40-44'}

Применим теперь наше преобразование к основному датафрейму ar, но предварительно сохраним изначальные значения group в новою колонку group raw.

ar['group raw'] = ar['group']

В колонке group оставим только те значения, которые соответствуют нашему стандарту.

Теперь можно оценить наши старания:

len(ar[(ar['group'] != ar['group raw'])&(ar['group']!='')])

Out: 273

Совсем немного на уровне полутора миллионов. Но ведь не узнаешь, пока не попробуешь.

Выборочные 10 выглядят так:

| event | place | sex | name | country | group | place in group | ... | country raw | group raw |

|---|---|---|---|---|---|---|---|---|---|

| ... | 566 | M | Vladimir Kozar | SVK | M40-44 | 8 | ... | SVK | MOpen 40-44 |

| ... | 8 | M | HANNES COOL | BEL | MPRO | 11 | ... | BEL | MPRO M |

| ... | 445 | F | Ileana Sodani | USA | F45-49 | 4 | ... | USA | F45-49 F |

| ... | 227 | F | JARLINSKA Bozena | POL | F45-49 | 2 | ... | POL | FK45-49 |

| ... | 440 | F | Celine Orrigoni | FRA | F40-44 | 6 | ... | FRA | F40-44 F |

| ... | 325 | M | Vladimir Eckert | SVK | M40-44 | 6 | ... | SVK | MOpen 40-44 |

| ... | 139 | F | ATRASZKIEWICZ Magda | POL | F40-44 | 2 | ... | POL | FK40-44 |

| ... | 18 | M | Marijn de Jonge | NLD | MPRO | 18 | ... | NED | Mpro |

| ... | 574 | M | Luca Andalo | ITA | M40-44 | 9 | ... | ITA | MOpen 40-44 |

| ... | 67 | M | URBANKIEWICZ Aleksandra | POL | M35-39 | 1 | ... | POL | MK35-39 |

Сохраняем новую версию датафрейма, предварительно преобразовав его обратно в словарь rd.

pkl.dump(rd, open(r'D:tridetails3.pkl', 'wb'))Имя

Теперь займемся именами. Посмотрим выборочно 100 имен с разных гонок:

list(ar['name'].sample(100))

Out: ['Case, Christine', 'Van der westhuizen, Wouter', 'Grace, Scott', 'Sader, Markus', 'Schuller, Gunnar', 'Juul-Andersen, Jeppe', 'Nelson, Matthew', 'Забугина Валерия Геннадьевна', 'Westman, Pehr', 'Becker, Christoph', 'Bolton, Jarrad', 'Coto, Ricardo', 'Davies, Luke', 'Daniltchev, Alexandre', 'Escobar Labastida, Emmanuelle', 'Idzikowski, Jacek', 'Fairaislova Iveta', 'Fisher, Kulani', 'Didenko, Viktor', 'Osborne, Jane', 'Kadralinov, Zhalgas', 'Perkins, Chad', 'Caddell, Martha', 'Lynaire PARISH', 'Busing, Lynn', 'Nikitin, Evgeny', 'ANSON MONZON, ROBERTO', 'Kaub, Bernd', 'Bank, Morten', 'Kennedy, Ian', 'Kahl, Stephen', 'Vossough, Andreas', 'Gale, Karen', 'Mullally, Kristin', 'Alex FRASER', 'Dierkes, Manuela', 'Gillett, David', 'Green, Erica', 'Cunnew, Elliott', 'Sukk, Gaspar', 'Markina Veronika', 'Thomas KVARICS', 'Wu, Lewen', 'Van Enk, W.J.J', 'Escobar, Rosario', 'Healey, Pat', 'Scheef, Heike', 'Ancheta, Marlon', 'Heck, Andreas', 'Vargas Iii, Raul', 'Seferoglou, Maria', 'chris GUZMAN', 'Casey, Timothy', 'Olshanikov Konstantin', 'Rasmus Nerrand', 'Lehmann Bence', 'Amacker, Kirby', 'Parks, Chris', 'Tom, Troy', 'Karlsson, Ulf', 'Halfkann, Dorothee', 'Szabo, Gergely', 'Antipov Mikhail', 'Von Alvensleben, Alvo', 'Gruber, Peter', 'Leblanc, Jean-Philippe', 'Bouchard, Jean-Francois', 'Marchiotto MASSIMO', 'Green, Molly', 'Alder, Christoph', 'Morris, Huw', 'Deceur, Marc', 'Queenan, Derek', 'Krause, Carolin', 'Cockings, Antony', 'Ziehmer Chris', 'Stiene, John', 'Chmet Daniela', 'Chris RIORDAN', 'Wintle, Mel', 'Борисёнок Павел', 'GASPARINI CHRISTIAN', 'Westbrook, Christohper', 'Martens, Wim', 'Papson, Chris', 'Burdess, Shaun', 'Proctor, Shane', 'Cruzinha, Pedro', 'Hamard, Jacques', 'Petersen, Brett', 'Sahyoun, Sebastien', "O'Connell, Keith", 'Symoshenko, Zhan', 'Luternauer, Jan', 'Coronado, Basil', 'Smith, Alex', 'Dittberner, Felix', 'N?sman, Henrik', 'King, Malisa', 'PUHLMANN Andre']

Все сложно. Встречаются самые разные варианты записей: Имя Фамилия, Фамилия Имя, Фамилия, Имя, ФАМИЛИЯ, Имя и т. д. То есть разный порядок, разный регистр, где-то есть разделитель — запятая. Так же существует немало протоколов, в которых идет кириллица. Там тоже нет единообразия, и могут встречаться такие форматы: “Фамилия Имя”, “Имя Фамилия”, “Имя Отчество Фамилия”, “Фамилия Имя Отчество”. Хотя на самом деле отчество встречается и в латинском написании. И здесь, кстати, встает еще одна проблема – транслитерация. Еще надо отметить, что даже там, где отчества нет, запись может не ограничиваться двумя словами. Например, у латиноамериканцев имя плюс фамилия обычно состоят из трех или четырех слов. У голландцев бывает приставка Van, у китайцев и корейцев тоже составные имена обычно из трех слов. В общем, надо как-то распутать весь этот ребус и по максимуму стандартизировить. Как правило внутри одной гонки формат имени одинаков для всех, но даже здесь встречаются ошибки, которые мы, однако, обрабатывать не будем. Начнем с того, что сохраним существующие значения в новой колонке name raw:

ar['name raw'] = ar['name']

Абсолютное большинство протоколов на латинице, поэтому первым делом я хотел бы сделать транслит. Посмотрим, какие вообще символы могут входить в имя участника.

set( ''.join(ar['name'].unique()))

Out: [' ', '!', '"', '#', '&', "'", '(', ')', '*', '+', ',', '-', '.', '/', '0', '1', '2', '3', '4', '5', '6', '7', '8', '9', ':', ';', '>', '?', '@', 'A', 'B', 'C', 'D', 'E', 'F', 'G', 'H', 'I', 'J', 'K', 'L', 'M', 'N', 'O', 'P', 'Q', 'R', 'S', 'T', 'U', 'V', 'W', 'X', 'Y', 'Z', '[', '\', ']', '^', '_', '`', 'a', 'b', 'c', 'd', 'e', 'f', 'g', 'h', 'i', 'j', 'k', 'l', 'm', 'n', 'o', 'p', 'q', 'r', 's', 't', 'u', 'v', 'w', 'x', 'y', 'z', '|', 'x7f', 'xa0', '¤', '¦', '§', '', '«', 'xad', '', '°', '±', 'µ', '¶', '·', '»', 'Ё', 'І', 'А', 'Б', 'В', 'Г', 'Д', 'Е', 'Ж', 'З', 'И', 'Й', 'К', 'Л', 'М', 'Н', 'О', 'П', 'Р', 'С', 'Т', 'У', 'Ф', 'Х', 'Ц', 'Ч', 'Ш', 'Щ', 'Ы', 'Ь', 'Э', 'Ю', 'Я', 'а', 'б', 'в', 'г', 'д', 'е', 'ж', 'з', 'и', 'й', 'к', 'л', 'м', 'н', 'о', 'п', 'р', 'с', 'т', 'у', 'ф', 'х', 'ц', 'ч', 'ш', 'щ', 'ъ', 'ы', 'ь', 'э', 'ю', 'я', 'ё', 'є', 'і', 'ў', '–', '—', '‘', '’', '‚', '“', '”', '„', '†', '‡', '…', '‰', '›', '']

Чего тут только нет! Помимо собственно букв и пробелов, еще куча разных диковинных символов. Из них допустимыми, то есть присутствующими не по ошибке, можно считать точку ‘.’, дефис ‘-’ и апостроф “’”. Помимо этого, было замечено что во многих немецких и норвежских именах и фамилиях присутствует знак вопроса ‘?’. Они, судя по всему, заменяют здесь символы из расширенной латиницы – ‘?’, ‘a’, ‘o’, ‘u’,? и др. Вот примеры:

Pierre-Alexandre Petit, Jean-louis Lafontaine, Faris Al-Sultan, Jean-Francois Evrard, Paul O'Mahony, Aidan O'Farrell, John O'Neill, Nick D'Alton, Ward D'Hulster, Hans P.J. Cami, Luis E. Benavides, Maximo Jr. Rueda, Prof. Dr. Tim-Nicolas Korf, Dr. Boris Scharlowsk, Eberhard Gro?mann, Magdalena Wei?, Gro?er Axel, Meyer-Szary Krystian, Morten Halkj?r, RASMUSSEN S?ren Balle

Запятая, хоть и встречается очень часто, является всего лишь разделителем, принятым на определенных гонках, поэтому тоже попадет в разряд недопустимых. Цифры тоже не должны появляться в именах.

bs = [s for s in symbols if not (s.isalpha() or s in " . - ' ? ,")] #bs – bad symbols

bs

Out: ['!', '"', '#', '&', '(', ')', '*', '+', '/', '0', '1', '2', '3', '4', '5', '6', '7', '8', '9', ':', ';', '>', '@', '[', '\', ']', '^', '_', '`', '|', 'x7f', 'xa0', '¤', '¦', '§', '', '«', 'xad', '', '°', '±', '¶', '·', '»', '–', '—', '‘', '’', '‚', '“', '”', '„', '†', '‡', '…', '‰', '›', '']

Временно уберем все эти символы, чтобы узнать в скольких записях они присутствуют:

for s in bs:

ar['name'] = ar['name'].str.replace(s, '')

corr = ar[ar['name'] != ar['name raw']]

Таких записей 2 184, то есть всего 0.15% от общего количества – очень мало. Взглянем выборочно на 100 из них:

list(corr['name raw'].sample(100))

Out: ['Scha¶ffl, Ga?nter', 'Howard, Brian &', 'Chapiewski, Guilherme (Gc)', 'Derkach 1svd_mail_ru', 'Parker H1 Lauren', 'Leal le?n, Yaneri', 'TencA, David', 'Cortas La?pez, Alejandro', 'Strid, Bja¶rn', '(Crutchfield) Horan, Katie', 'Vigneron, Jean-Michel.Vigneron@gmail.Com', 'МОШКОВxa0Иван', 'Telahr, J†rgen', 'St”rmer, Melanie', 'Nagai B1 Keiji', 'Rinc?n, Mariano', 'Arkalaki, Angela (Evangelia)', 'Barbaro B1 Bonin Anna G:Charlotte', 'Ra?esch, Ja¶rg', "CAVAZZI NICCOLO\'", 'D„nzel, Thomas', 'Ziska, Steffen (Gerhard)', 'Kobilica B1 Alen', 'Mittelholcz, Bala', 'Jimanez Aguilar, Juan Antonio', 'Achenza H1 Giovanni', 'Reppe H2 Christiane', 'Filipovic B2 Lazar', 'Machuca Ka?hnel, Ruban Alejandro', 'Gellert (Silberprinz), Christian', 'Smith (Guide), Matt', 'Lenatz H1 Benjamin', 'Da¶llinger, Christian', 'Mc Carthy B1 Patrick Donnacha G:Bryan', 'Fa¶llmer, Chris', 'Warner (Rivera), Lisa', 'Wang, Ruijia (Ray)', 'Mc Carthy B1 Donnacha', 'Jones, Nige (Paddy)', 'Sch”ler, Christoph', 'НЕДОШИТОВxa0Дмитрий', 'Holthaus, Adelhard (Allard)', 'Mi;Arro, Ana', 'Dr: Koch Stefan', 'МОШКОВxa0Юрий', 'ЦУБЕРАxa0Максим', 'Ziska, Steffen (Gerhard)', 'Albarracaxadn Gonza?lez, Juan Francisco', 'Ha¶fling, Imke', 'Johnston, Eddie (Edwin)', 'Mulcahy, Bob (James)', 'Gottschalk, Bj”rn', 'ГУЩИНxa0Дмитрий', 'Gretsch H2 Kendall', 'Scorse, Christopher (Chris)', 'Kiel‚basa, Pawel', 'Kalan, Magnus', 'Roderick "eric" SIMBULAN', 'Russell;, Mark', 'ROPES AND GRAY TEAM 3', 'Andrade, H?¦CTOR DANIEL', 'Landmann H2 Joshua', 'Reyes Rodraxadguez, Aithami', 'Ziska, Steffen (Gerhard)', 'Ziska, Steffen (Gerhard)', 'Heuza, Pierre', 'Snyder B1 Riley Brad G:Colin', 'Feldmann, Ja¶rg', 'Beveridge H1 Nic', 'FAGES`, perrine', 'Frank", Dieter', 'Saarema¤el, Indrek', 'Betancort Morales, Arida–y', 'Ridderberg, Marie_Louise', 'ЗАЙЦЕВxa0Андрей', 'Ka¶nig, Johannes', 'W Van(der Klugt', 'Ziska, Steffen (Gerhard)', 'Johnson, Nick26', 'Heinz JOHNER03', 'Ga¶rg, Andra', 'Maruo B2 Atsuko', 'Moral Pedrero H1 Eva Maria', 'КУТАСОВxa0Сергей', 'MATUS SANTIAGO Osc1r', 'Stenbrink, Bja¶rn', 'Wangkhan, Sm1.Thaworn', 'Pullerits, Ta¶nu', 'Clausner, 8588294149', 'Castro Miranda, Josa Ignacio', 'La¶fgren, Pontuz', 'Brown, Jann ( Janine )', 'Ziska, Steffen (Gerhard)', 'Koay, Sa¶ren', 'Ba¶hm, Heiko', 'Oleksiuk B2 Vita', 'G Van(de Grift', 'Scha¶neborn, Guido', 'Mandez, A?lvaro', 'Garcaxada Fla?rez, Daniel']

В итоге, после долгих исследований, было решено: все буквенные символы, а также пробел, дефис, апостроф и знак вопроса оставить как есть, запятую, точку и символ ‘xa0’ заменить на пробелы, а все остальные символы заменить на пустую строку, то есть просто удалить.

ar['name'] = ar['name raw']

for s in symbols:

if s.isalpha() or s in " - ? '":

continue

if s in ".,xa0":

ar['name'] = ar['name'].str.replace(s, ' ')

else:

ar['name'] = ar['name'].str.replace(s, '')

Затем избавимся от лишних пробелов:

ar['name'] = ar['name'].str.split().str.join(' ')

ar['name'] = ar['name'].str.strip() # на всякий случай

Посмотрим, что получилось:

ar.loc[corr.index].sample(10)

| place | sex | name | country | ... | name raw | |

|---|---|---|---|---|---|---|

| 63 | 64 | M | Curzillat B MARANO Annouck GJulie | FRA | ... | Curzillat B1 MARANO Annouck G:Julie |

| 425 | 426 | M | Naranjo Quintero Cndido | ESP | ... | Naranjo Quintero, C‡ndido |

| 1347 | 1348 | F | Chang Margaret Peggy | USA | ... | Chang, Margaret (Peggy) |

| 790 | 791 | M | Gonzalez Ruben | PRI | ... | Gonzalez`, Ruben |

| 1562 | 1563 | M | Garcia Hernandez Elias | MEX | ... | Garcia Hernandez/, Elias |

| 50 | 51 | M | Reppe H Christiane | DEU | ... | Reppe H2 Christiane |

| 528 | 529 | M | Ho Shihken | TWN | ... | Ho, Shih—ken |

| 819 | 820 | M | Elmously A R Abdelrahman | EGY | ... | Elmously, A.R. (Abdelrahman) |

| 249 | 250 | F | boyer Isabelle | THA | ... | `boyer, Isabelle |

| 744 | 745 | M | Garcaa Morales Pedro Luciano | ESP | ... | Garca¬a Morales, Pedro Luciano |

Было так же замечено, что существуют имена, полностью состоящие из знаков вопроса.

qmon = ar[(ar['name'].str.replace('?', '').str.strip() == '')&(ar['name']!='')] #qmon – question mark only names

Таких 3 429. Выглядит это примерно так:

| place | sex | name | country | group | place in group | ... | country raw | group raw | name raw | |

|---|---|---|---|---|---|---|---|---|---|---|

| 818 | 819 | M | ???? ??? | JPN | M45-49 | 177 | ... | JPN | M45-49 | ????, ??? |

| 1101 | 1102 | M | ?? ?? | JPN | M50-54 | 159 | ... | JPN | M50-54 | ??, ?? |

| 162 | 163 | M | ? ?? | CHN | M30-34 | 22 | ... | CHN | M30-34 | ?, ?? |

| 1271 | 1272 | F | ???? ???? | JPN | F50-54 | 15 | ... | JPN | F50-54 | ????, ???? |

| 552 | 553 | M | ??? ?? | JPN | M25-29 | 30 | ... | JPN | M25-29 | ???, ?? |

| 423 | 424 | M | ??? ???? | JPN | M55-59 | 24 | ... | JPN | M55-59 | ???, ???? |

| 936 | 937 | F | ?? ?? | JPN | F50-54 | 7 | ... | JPN | F50-54 | ??, ?? |

| 244 | 245 | M | ? ?? | KOR | M50-54 | 30 | ... | KOR | M50-54 | ?, ?? |

| 627 | 628 | M | ? ? | CHN | M40-44 | 94 | ... | CHN | M40-44 | ?, ? |

| 194 | 195 | M | ?????? ????? | RUS | 188 | ... | RUS | M | ?????? ????? |

Наша цель приведения имен к одному стандарту состоит в том, чтобы одинаковые имена выглядели одинаково, а разные по-разному. В случае с именами, состоящими из одних лишь знаков вопроса, они отличаются лишь количеством символов, но это не дает полной уверенности, что имена с одинаковым количеством действительно одинаковы. Поэтому заменим их все на пустую строку и не будем рассматривать в дальнейшем.

ar.loc[qmon.index, 'name'] = ''

Всего записей, где имя – пустая строка получилось 3 454. Не так много — переживем. Теперь, когда мы избавились от ненужных символов, можно перейти к транслитерации. Для этого сперва приведем все к нижнему регистру, чтобы не делать двойную работу.

ar['name'] = ar['name'].str.lower()

Далее создаем словарик:

trans = {'а':'a', 'б':'b', 'в':'v', 'г':'g', 'д':'d', 'е':'e', 'ё':'e', 'ж':'zh', 'з':'z', 'и':'i', 'й':'y', 'к':'k', 'л':'l', 'м':'m', 'н':'n', 'о':'o', 'п':'p', 'р':'r', 'с':'s', 'т':'t', 'у':'u', 'ф':'f', 'х':'kh', 'ц':'ts', 'ч':'ch', 'ш':'sh', 'щ':'shch', 'ь':'', 'ы':'y', 'ъ':'', 'э':'e', 'ю':'yu', 'я':'ya', 'є':'e', 'і': 'i','ў':'w','µ':'m'}

В него также попали буквы из так называемой расширенной кириллицы — 'є', 'і', 'ў', которые используются в белорусском и украинском языках, а также греческая буква 'µ'. Применяем преобразование:

for s in trans:

ar['name'] = ar['name'].str.replace(s, trans[s])

Теперь из рабочего нижнего регистра переведем все в привычный формат, где имя и фамилия начинаются с большой буквы:

ar['name'] = ar['name'].str.title()

Посмотрим, что получилось.

ar[ar['name raw'].str.lower().str[0].isin(trans.keys())].sample(10)

| place | sex | name | ... | country raw | name raw | |

|---|---|---|---|---|---|---|

| 99 | 100 | M | Nikolay Golovkin | ... | RUS | Николай Головкин |

| 95 | 96 | M | Maksim Vasilevich Chubakov | ... | RUS | Максим Васильевич Чубаков |

| 325 | 326 | F | Ganieva Aygul | ... | RUS | Ганиева Айгуль |

| 661 | 662 | M | Maksut Nizamutdinov | ... | RUS | Максут Низамутдинов |

| 356 | 357 | F | Kolobanova Svetlana | ... | RUS | Колобанова Светлана |

| 117 | 118 | M | Guskov Vladislav | ... | RUS | Гуськов Владислав |

| 351 | 352 | M | Kolesnikov Dmitriy | ... | RUS | Колесников Дмитрий |

| 92 | 93 | M | Kuznetsov Oleg | ... | RUS | Кузнецов Олег |

| 50 | 51 | M | Khoraykin Maksim | ... | RUS | Хорайкин Максим |

| 6 | 7 | M | Brylev Aleksey | ... | RUS | Брылев Алексей |

Проверим напоследок уникальные символы:

set( ''.join(ar['name'].unique()))

Out: [' ', "'", '-', '?', 'A', 'B', 'C', 'D', 'E', 'F', 'G', 'H', 'I', 'J','K', 'L', 'M', 'N', 'O', 'P', 'Q', 'R', 'S', 'T', 'U', 'V', 'W', 'X', 'Y', 'Z', 'a', 'b', 'c', 'd', 'e', 'f', 'g', 'h', 'i', 'j', 'k', 'l', 'm', 'n', 'o', 'p', 'q', 'r', 's', 't', 'u', 'v', 'w', 'x', 'y', 'z']

Все правильно. В итоге исправления коснулись 1 253 882 или 89% записей, количество уникальных имен снизилось с 660 207 до 599 186, то есть на 61 тысячу или почти на 10 %. Здорово! Cохраняем в новый файл, предварительно переведя объединение записей ar обратно в словарь протоколов rd.

pkl.dump(rd, open(r'D:tridetails4.pkl', 'wb'))

Теперь надо восстановить порядок. То есть что бы все записи имели вид – Имя Фамилия или Фамилия Имя. Какой именно – предстоит определить. Правда помимо имени и фамилии в некоторых протоколах записаны еще и отчества. И может так получиться, что один и тот же человек в разных протоколах записан по-разному – где-то с отчеством, где-то без. Это будет мешать его идентифицировать, поэтому попробуем удалить отчества. Отчества у мужчин обычно имеют окончание «вич», а у женщин — «вна». Но есть и исключения. Например – Ильич, Ильинична, Никитич, Никитична. Правда таких исключений очень мало. Как уже было отмечено формат имен в рамках одного протокола можно считать постоянным. Поэтому, чтобы избавиться от отчеств, нужно найти гонки, в которых они присутствуют. Для этого надо найти суммарное количество фрагментов «vich» и «vna» в колонке name и сравнить их с общим количеством записей в каждом протоколе. Если эти числа близки, значит отчество есть, а иначе нет. Искать строгое соответствие неразумно, т.к. даже в гонках, где записывают отчества могут принимать участие, например, иностранцы, и их запишут без него. Случается и так, что у участник забыл или не захотел указывать свое отчество. С другой стороны, есть ведь и фамилии оканчивающиеся на «vich», их много в Белоруссии, и других странах с языками славянской группы. К тому же мы сделали транслит. Можно было заняться этим анализом до транслитерации, но тогда есть шанс упустить протокол, в котором есть отчества, но изначально он уже на латинице. Так что все нормально.

Итак, будем искать все протоколы, в которых число фрагментов «vich» и «vna» в колонке name больше 50% от общего числа записей в протоколе.

wp = {} #wp – with patronymic

for e in rd:

nvich = (''.join(rd[e]['name'])).count('vich')

nvna = (''.join(rd[e]['name'])).count('vna')

if nvich + nvna > 0.5*len(rd[e]):

wp[e] = rd[e]

Таких протоколов 29. Вот один из них:

| place | sex | name | country | ... | name raw | |

|---|---|---|---|---|---|---|

| 0 | 1 | M | Yaroslav Stanislavovich Pavlishchev | RUS | ... | Ярослав Станиславович Павлищев |

| 1 | 2 | M | Vladimir Vasilevich Perezhigin | RUS | ... | Владимир Васильевич Пережигин |

| 2 | 3 | M | Vladislav Evgenevich Litvinchuk | RUS | ... | Владислав Евгеньевич Литвинчук |

| 3 | 4 | M | Sergey Gennadevich Gavrilenko | RUS | ... | Сергей Геннадьевич Гавриленко |

| 4 | 5 | M | Ivan Markovich Markin | RUS | ... | Иван Маркович Маркин |

| 5 | 6 | M | Nikolay Evgenevich Sokolov | RUS | ... | Nikolay Evgenevich Sokolov |

| 6 | 7 | M | Aram Pavlovich Kukhtiev | RUS | ... | Арам Павлович Кухтиев |

| 7 | 8 | M | Andrey Anatolevich Andreev | RUS | ... | Андрей Анатольевич Андреев |

| 8 | 9 | M | Denis Valerevich Bulgakov | RUS | ... | Денис Валерьевич Булгаков |

| 9 | 10 | M | Aleksandr Ivanovich Kuts | RUS | ... | Александр Иванович Куць |

Причем интересно, что, если вместо 50% взять 20% или наоборот 70% — результат не изменится, будут все те же 29. Значит мы сделали правильный выбор. Соответственно, меньше 20% — эффект фамилий, больше 70% — эффект отдельных записей без отчеств. Проверив страну с помощью сводной таблицы, оказалось, что 25 из них в России, 4 в Абхазии.

Движемся дальше. Будем обрабатывать только записи с тремя составляющими, то есть те, где есть (предположительно) фамилия, имя, отчество.

sum_n3w = 0 # sum name of 3 words

sum_nnot3w = 0 # sum name not of 3 words

for e in wp:

sum_n3w += len([n for n in wp[e]['name'] if len(n.split()) == 3])

sum_nnot3w += len(wp[e]) - n3w

Таких записей большинство – 86 %. Теперь те, в которых три составляющих разделим на колонки name0, name1, name2:

for e in wp:

ind3 = [i for i in rd[e].index if len(rd[e].loc[i,'name'].split()) == 3]

rd[e]['name0'] = ''

rd[e]['name1'] = ''

rd[e]['name2'] = ''

rd[e].loc[ind3, 'name0'] = rd[e].loc[ind3,'name'].str.split().str[0]

rd[e].loc[ind3, 'name1'] = rd[e].loc[ind3,'name'].str.split().str[1]

rd[e].loc[ind3, 'name2'] = rd[e].loc[ind3,'name'].str.split().str[2]

Вот как теперь выглядит один из протоколов:

| name | name0 | name1 | name2 | ... | name raw | |

|---|---|---|---|---|---|---|

| 0 | Lekomtsev Denis Nikolaevich | Lekomtsev | Denis | Nikolaevich | ... | Лекомцев Денис Николаевич |

| 1 | Ivanov Andrey Aleksandrovich | Ivanov | Andrey | Aleksandrovich | ... | Иванов Андрей Александрович |

| 2 | Ivanov Evgeniy Vasilevich | Ivanov | Evgeniy | Vasilevich | ... | Иванов Евгений Васильевич |

| 3 | Setepov Vladislav | ... | Сетепов Владислав | |||

| 4 | Mishanin Sergey Yurevich | Mishanin | Sergey | Yurevich | ... | Мишанин Сергей Юрьевич |