Что нам готовит день грядущий? В каком мире мы будем жить через 20-30 лет? Будущее, такое волнующие и неопределенное. Как в древности, так и сейчас поток людей, идущих с вопросами к оракулам, магам, провидцам, не иссякает. Зачастую людей интересует даже не столько завтрашний день, а куда более далекое будущее, необозримое с точки зрения длины человеческой жизни. Казалось бы, «дурь полная», но уж такова человеческая сущность. Начиная с ХІХ века, на место экзальтированных старцев пришли новые провидцы – научные фантасты.

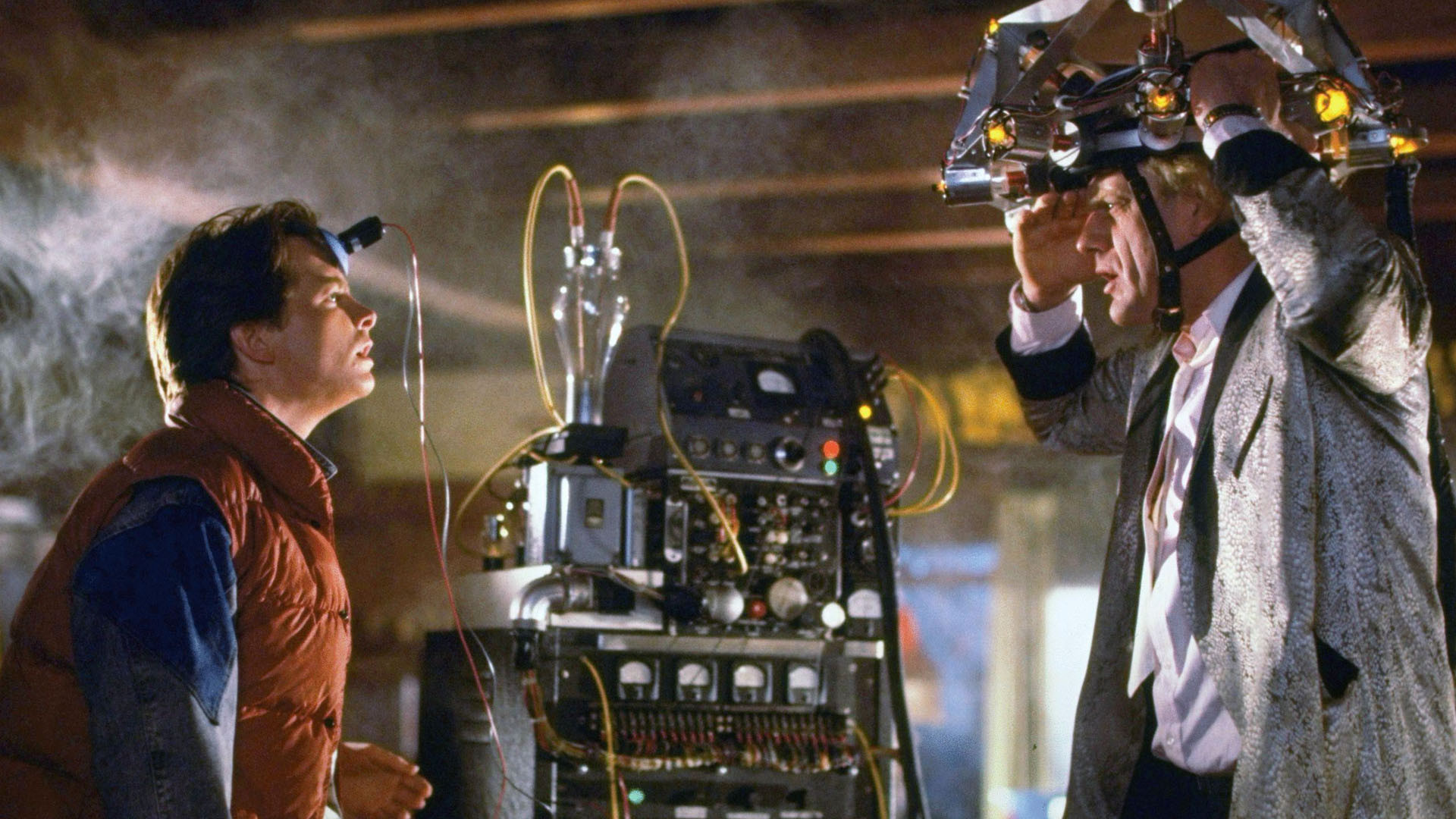

Пересмотрев намедни в очередной раз вторую часть великолепной трилогии «Назад в будущее», вышедшую на широкий экран в 1989 году, с горечью подметил, что в надвигающемся 2015 году улицы наших городов так и не заполонят летающие машины, домашние энергетические реакторы, перерабатывающие мусор, – утопия, голографические кинотеатры – несбыточный миф, даже пылеотталкивающую обложку для журнала за прошедшие четверть столетия не придумали. В то же время в некоторых сферах нашей повседневной жизни предвиденья были довольно точными.

Размышления, навеянные вышеизложенным, и подтолкнули более детально разобраться с теми инновациями, которые затронули центры хранения и обработки данных. Да, на протяжении уже многих лет тот же Intel обновляет свои линейки процессоров, программное обеспечение также не стоит на месте, но дает ли это нам право говорить о сколько-то серьезных изменениях в функционировании дата центров? Давайте более детально посмотрим на те инновации, о которых мы много слышим последние 10 лет. На каком этапе внедрения они находятся сейчас?

Низкий коэффициент энерго эффективности (PUE)

Когда в 2007 году организация Green Grid только представила свою меру энергоэффективности (PUE), Национальная лаборатория им. Лаврентия Барклая опубликовала отчет по результатам исследования 20-ти дата-центров, которое показало, что среднее значение коэффициента PUE составило 2.2. Очевидно, что компании не всегда заинтересованы доводить значение PUE до минимально возможного, энергоэффективность сопряжена и с большими финансовыми инвестициями, и с техническими сложностями, которые создают дополнительные проблемы при возведении новых дата-центров. Но в данном направлении хороший пример показывают такие ИТ-гиганты, как Google и Facebook. Их дата центры характеризуются PUE в районе 1.2-1.3, что выводит компании в лидеры по энергоэффективности. В то же время опубликованный в 2013 году материал на основе сведений анализа мировых исследовательских организаций показал, что на момент проведения исследования среднестатистический уровень PUE по существующим в мире дата-центрам составляет чуть более 2.0. Решение задачи энергоэффективности дата-центров — это первоочередная цель, которую надо решить для уменьшения затрат на функционирование ИТ инфраструктуры.

Борьба с простоем

Уже давно инженеры информационных систем пришли к той мысли, что все сетевое оборудование должно работать с максимальной производительностью 24 часа в сутки. На данный момент мы столкнулись с тем, что благодаря повсеместной доступности серверных платформ, мы имеем множество изолированных кластеров, которые работают перманентно, существуют исключительно для поддержания работы конкретных программ либо же неких сетевых опций, что в свою очередь ведет к существованию огромного числа серверов, которые большую свою часть времени просто не задействованы. Доклад, опубликованный исследовательской компанией McKinsey, показал, что в дата-центрах, где проводилось исследование, процент бесцельно простаивающих серверов доходил до 30%. Хоть и много было сделано за последние 10 лет в направлении виртуализации, которая способствовала уменьшению простоя серверов, задача еще стоит довольно остро. Интернет-компании больших масштабов уже сейчас вполне эффективно используют виртуализацию, а это один из факторов повышения рентабельности ведения бизнеса. По результатам оценки, проведенной в 2014 году маркетинговой компанией Gartner, до 70% рабочих нагрузок, приходящихся на платформы х86, относятся как раз к системам виртуализации. Пока же владельцы дата центров не доведут простой существующих мощностей до разумного минимума, серверы и далее будут в холостую пожирать столь ценную электроэнергию.

Водяное охлаждение

Такого рода охлаждение, конечно же, придумано не сегодня. Еще в 60-х годах ХХ века для бесперебойной работы массивных энергорасточительных ЭВМ использовались схемы охлаждения на основе жидкостей. Для современных супер компьютеров жидкостное охлаждение — это тоже не новинка, но вот использование такого рода технологий в ЦОДах встречается нечасто. Зачастую это экспериментальные установки, применение таких систем скорее единичное. В тоже время теория нам говорит, что жидкости могут в тысячи раз более эффективно отводить избыточное тепло от рабочего оборудования серверных шкафов, нежели это делает воздух. Но, к сожалению, владельцы дата-центров, как крупных, так и не очень, до сих пор опасаются широко применять эту технологию в силу необходимости изменять уже существующую инфраструктуру, менять культуру работы персонала с оборудованием, размещенным в жидкой среде, отсутствие примеров крупных ЦОДов с функционирующей такой системой. Успешным примером применения жидкостного охлаждения может послужить Национальная лаборатория возобновляющейся энергии (Перигрин, США), где созданный в 2013 году дата центр, обеспечивающий размещенный там же суперкомпьютер, показывает PUE на уровне феноменальных 1.06! Так же установленная система в г. Перингтон в холодные месяцы, может направлять выделенное от оборудования тепло на обогрев кампуса Национальной лаборатории. Именно такие позитивные примеры должны стать толчком к повсеместному применению технологии жидкостного охлаждения.

Распределение пиковых нагрузок

Пиковые нагрузки это воистину бич сетевой инфраструктуры и кошмар инженеров. Так сложилось, что наш ритм жизни на протяжении суток диктует неравномерное потребление мощностей дата-центров. Соответственно, чтоб мы не испытывали проблем с загрузкой страниц наших любимых социальных сетей в интервал времени примерно с 19:00 по 21:00 час местного времени компании, предоставляющие сетевые сервисы, вынуждены содержать избыточное количество вычислительных мощностей, которые все остальное время, в общем-то, и не востребованы. Да, конечно сетевые инженера находят способы решения этой проблемы: тут и кеширование, и интеллектуальные системы по перераспределению нагрузки между серверными кластерами. Но представим себе хоть на минуту, что бы было, если бы удалось устранить (свести к абсолютному минимуму) латентность сети? Это бы кардинально изменило всю существующею телекоммуникационную инфраструктуру на Земле. А пока имеем факты: 64 миллисекунды необходимо электромагнитной волне, чтоб преодолеть расстояние в пол Земного экватора. Учитывая неровности маршрутов, задержки отклика запроса, связанные с функционированием сетевой инфраструктуры, и кучу других факторов, на данный момент организовать достаточно эффективную переброску вычислительных ресурсов между разными частями света довольно проблематично, компании рискуют получить кучу разъярённых клиентов, что не удовлетворены предложенным им сервисом.

Управление инфраструктурой дата-центров (DCIM)

Еще одно из великолепных начинаний, которое сейчас находиться в «шатком» состоянии. Философия DCIM включает в себя принцип создания единых норм управления и функционирования дата центров. Стандартизация оборудования, ПО, подходов к управлению может сделать огромный вклад в удешевление затрат как на производство, так и на поддержание сетевой инфраструктуры. Движением в этом направлении можно назвать появление унифицированных коэффициентов PUE, CUE, DCeР. Недавнее консолидированное заявление основных ИТ-гигантов уделять больше внимания программному обеспечению с открытым кодом и уже на его основе реализовывать межкорпоративные проекты — ещё один шаг к этой цели. Но по причине разного рода интересов, как государственных, так и коммерческих, процесс единения идет очень медленно. В конечном итоге платим за издержки разрозненности мы с вами.

Модульные дата центры

Вот тут стоит уже отметить очевидный прогресс. Начиная с 2003 года, впервые запатентованная корпорацией Google, технология напичканных серверным оборудованием контейнеров, которые можно за сутки доставить в любую точку земли и наладить там фактически полноценный узел данных, действительно восхищает. Конечно же, не стоит забывать и про необходимые телекоммуникационные каналы, и про площадку, куда будут устанавливаться эти контейнеры, да и обслуживающий персонал играет очень важную роль. Но все же это очевидный прорыв. В данный момент контейнерный подход в создании новых дата центров пришелся по вкусу основным участникам ИТ-рынка. Мобильность переброски оборудования, скорость его развёртывания, унификация, высокое качество сборки высококвалифицированными работниками на материнских заводах — все эти качества оценили по достоинству как гражданские организации, так и военные. Количество существующих примеров применения технологии исчисляется сотнями.

Дата-центры севернее 48 широты

Возведение ЦОДов в климатических условиях севера, как и некоторые другие будоражащие сознание идеи, не нашли широкой поддержки на сегодня. По некоторым оценкам экспертов, наиболее эффективно возводить дата-центры именно севернее 48 широты, как раз там и будут наиболее благоприятные условия для низкозатратного атмосферного охлаждения серверных залов. Если же проанализировать существующую географию размещения ЦОДов, то лишь Европу можно хоть как то отметить в этом плане. Сразу приходят на ум дата центры в Швеции и Финляндии, чего только стоит один ЦОД Google в Лулео. Но это все же скорее единичные случаи, и мировые провайдеры скорее акцентируют внимание на близости своих инфраструктурных детищ к непосредственным потребителям их мощностей, отдавая предпочтение максимально низкому значению латентности сети, не желая рисковать потерять потенциальных клиентов, выиграв на снижении операционных затратах.

Основная линия – никаких рисков

Посмотрев на основные тенденции в существующих дата центрах и проектировании новых, вывод напрашивается сам собою. Такие молодые и бурно развивающиеся ИТ компании – революционеры в своем роде, ведут довольно консервативную, если не сказать закостенелую, модель поведения на рынке, что тормозит повсеместное введение новых, перспективных разработок. Операторы и дизайнеры не готовы идти на какие-либо, даже наименьшие, риски ради увеличения эффективности функционирования существующей сетевой инфраструктуры, даже если позитивный результат в направлении прогресса уже показан на конкретных примерах. Наверное, если детально вникнуть во все нюансы, может, в этом и есть своя какая-то высшая логика. Но вывод напрашивается немного пессимистический: как мы не дождались предсказанных создателями трилогии «Назад в будущее» в 2015 году летающих автомобилей, так и не дождёмся мы их еще через четверть века.

Автор: Mykolauskas