CD признано в качестве практики корпоративного программного обеспечения, это — результат естественной эволюции устоявшихся принципов CI. Однако CD по-прежнему довольно редкое явление, возможно, из-за сложности управления и страха перед неудачными деплоями, влияющими на доступность системы.

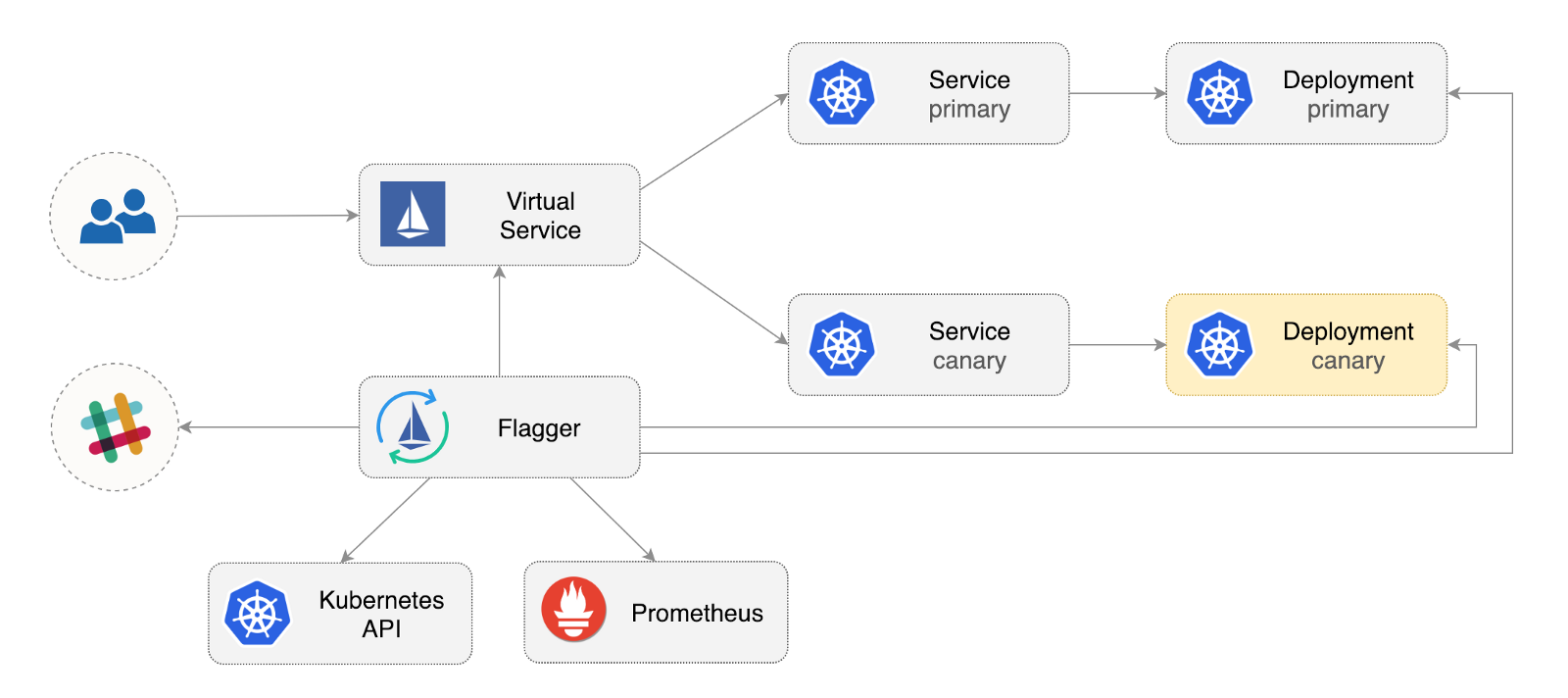

Flagger — это оператор Kubernetes с открытым исходным кодом, цель которого — исключить запутанные взаимосвязи. Он автоматизирует продвижение canary деплоев с использованием смещения трафика Istio и метрик Prometheus для анализа поведения приложения во время управляемого выкатывания.

Ниже приведено пошаговое руководство по настройке и использованию Flagger в Google Kubernetes Engine (GKE).

Настройка кластера Kubernetes

Вы начинаете с создания кластера GKE с надстройкой Istio (если у вас нет учетной записи GCP, зарегистрироваться можно здесь — для получения бесплатных кредитов).

Войдите в Google Cloud, создайте проект и включите для него биллинг. Установите утилиту командной строки gcloud и настройте свой проект с помощью gcloud init.

Установите проект по умолчанию, область вычислений и зону (замените PROJECT_ID на свой проект):

gcloud config set project PROJECT_ID

gcloud config set compute/region us-central1

gcloud config set compute/zone us-central1-aВключите сервис GKE и создайте кластер с HPA и надстройками Istio:

gcloud services enable container.googleapis.com

K8S_VERSION=$(gcloud beta container get-server-config --format=json | jq -r '.validMasterVersions[0]')

gcloud beta container clusters create istio

--cluster-version=${K8S_VERSION}

--zone=us-central1-a

--num-nodes=2

--machine-type=n1-standard-2

--disk-size=30

--enable-autorepair

--no-enable-cloud-logging

--no-enable-cloud-monitoring

--addons=HorizontalPodAutoscaling,Istio

--istio-config=auth=MTLS_PERMISSIVEПриведенная выше команда создаст пул нод по умолчанию, включающий две ВМ n1-standard-2 (vCPU: 2, RAM 7,5 GB, диск: 30 GB). В идеале стоит изолировать компоненты Istio от своих рабочих нагрузок, но простого способа запуска подов Istio в выделенном пуле нод не существует. Манифесты Istio считаются доступными только для чтения, и GKE будет отменять любые изменения, например, привязку к ноде или отсоединение от пода.

Настройте учетные данные для kubectl:

gcloud container clusters get-credentials istioСоздайте привязку роли администратора кластера:

kubectl create clusterrolebinding "cluster-admin-$(whoami)"

--clusterrole=cluster-admin

--user="$(gcloud config get-value core/account)"Установите инструмент командной строки Helm:

brew install kubernetes-helmHomebrew 2.0 теперь также доступен для Linux.

Создайте учетную запись службы и привязку роли кластера для Tiller:

kubectl -n kube-system create sa tiller &&

kubectl create clusterrolebinding tiller-cluster-rule

--clusterrole=cluster-admin

--serviceaccount=kube-system:tillerРазверните Tiller в неймспейс kube-system:

helm init --service-account tillerВам следует рассмотреть возможность использования SSL между Helm и Tiller. Для получения дополнительной информации о защите установки Helm см. docs.helm.sh

Подтвердите настройки:

kubectl -n istio-system get svcЧерез несколько секунд GCP должен назначить внешний IP-адрес для сервиса istio-ingressgateway.

Настройка входного шлюза Istio

Создайте статический IP-адрес с именем istio-gateway, используя IP-адрес шлюза Istio:

export GATEWAY_IP=$(kubectl -n istio-system get svc/istio-ingressgateway -ojson | jq -r .status.loadBalancer.ingress[0].ip)

gcloud compute addresses create istio-gateway --addresses ${GATEWAY_IP} --region us-central1Теперь вам нужен интернет-домен и доступ к своему регистратору DNS. Добавьте две записи А (замените example.com на свой домен):

istio.example.com A ${GATEWAY_IP}

*.istio.example.com A ${GATEWAY_IP}Убедитесь, что подстановочный символ DNS работает:

watch host test.istio.example.comСоздайте общий шлюз Istio для предоставления услуг за пределами service mesh по HTTP:

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: public-gateway

namespace: istio-system

spec:

selector:

istio: ingressgateway

servers:

- port:

number: 80

name: http

protocol: HTTP

hosts:

- "*"Сохраните вышеуказанный ресурс как public-gateway.yaml, а затем примените его:

kubectl apply -f ./public-gateway.yamlНи одна производственная система не должна предоставлять услуги в Интернете без SSL. Чтобы защитить входной шлюз Istio с помощью cert-manager, CloudDNS и Let's Encrypt, прочитайте, пожалуйста, документацию Flagger GKE.

Установка Flagger

Надстройка GKE Istio не включает экземпляр Prometheus, который занимается очисткой службы телеметрии Istio. Поскольку Flagger использует метрики Istio HTTP для выполнения canary анализа, вам необходимо задеплоить следующую конфигурацию Prometheus, аналогичную той, которая поставляется с официальной схемой Istio Helm.

REPO=https://raw.githubusercontent.com/stefanprodan/flagger/master

kubectl apply -f ${REPO}/artifacts/gke/istio-prometheus.yamlДобавьте репозиторий Flagger Helm:

helm repo add flagger [https://flagger.app](https://flagger.app/)Разверните Flagger в неймспейс istio-system, включив уведомления Slack:

helm upgrade -i flagger flagger/flagger

--namespace=istio-system

--set metricsServer=http://prometheus.istio-system:9090

--set slack.url=https://hooks.slack.com/services/YOUR-WEBHOOK-ID

--set slack.channel=general

--set slack.user=flaggerВы можете установить Flagger в любом неймспейсе, если он может взаимодействовать с сервисом Istio Prometheus через порт 9090.

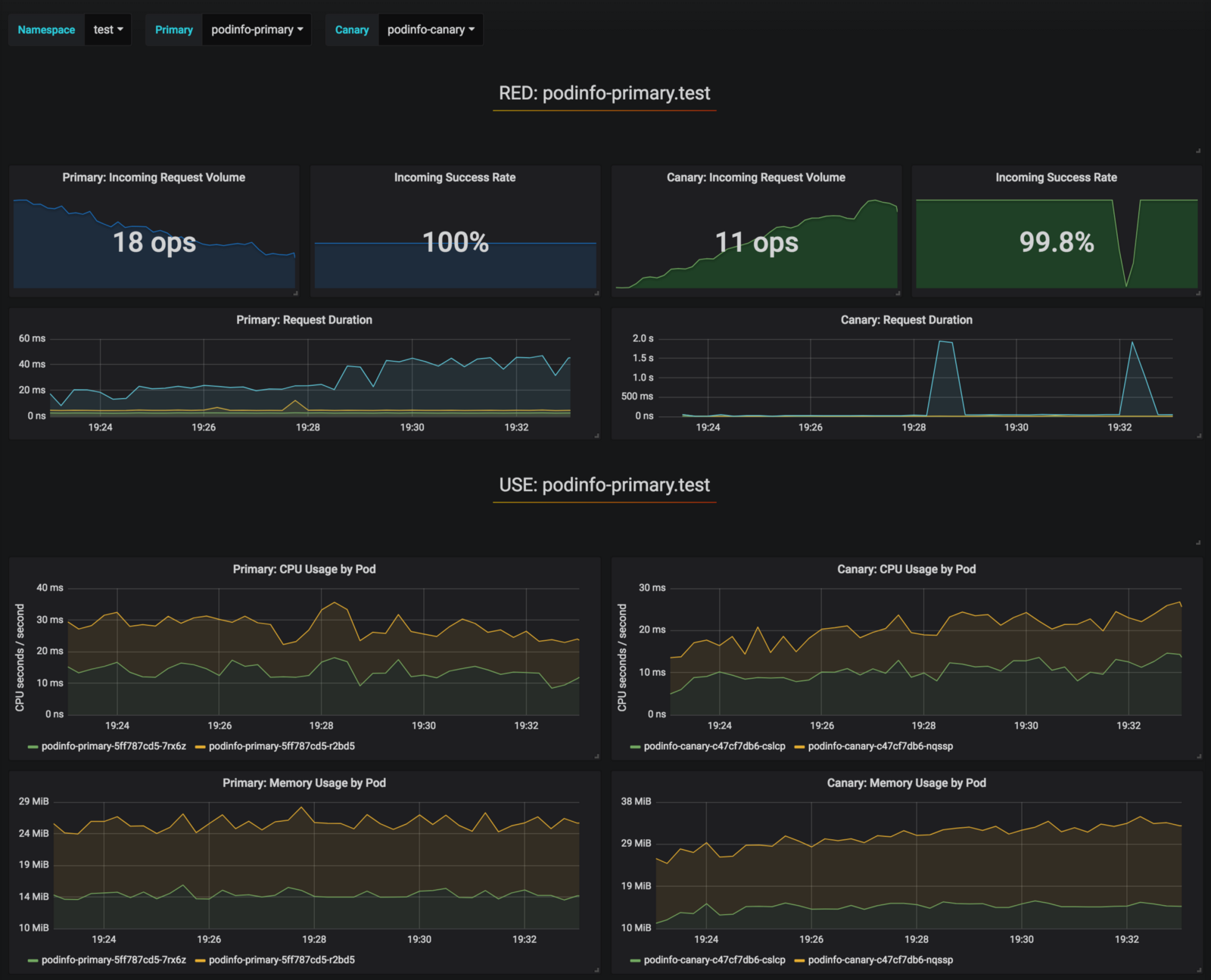

Flagger имеет панель мониторинга Grafana для canary анализа. Установите Grafana в неймспейс istio-system:

helm upgrade -i flagger-grafana flagger/grafana

--namespace=istio-system

--set url=http://prometheus.istio-system:9090

--set user=admin

--set password=change-meРаскройте Grafana через открытый шлюз, создав виртуальный сервис (замените example.com на ваш домен):

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: grafana

namespace: istio-system

spec:

hosts:

- "grafana.istio.example.com"

gateways:

- public-gateway.istio-system.svc.cluster.local

http:

- route:

- destination:

host: flagger-grafanaСохраните вышеуказанный ресурс как grafana-virtual-service.yaml, а затем примените его:

kubectl apply -f ./grafana-virtual-service.yamlПри переходе к http://grafana.istio.example.com в браузере вас долнжо направить на страницу входа в систему Grafana.

Деплой веб-приложений с Flagger

Flagger деплоит Kubernetes и, при необходимости, горизонтальное автоматическое масштабирование (HPA), затем создает серию объектов (деплои Kubernetes, сервисы ClusterIP и виртуальные сервисы Istio). Эти объекты раскрывают приложение в service mesh и управляют canary анализом и продвижением.

Создайте тестовый неймспейс с включенным внедрением Istio Sidecar:

REPO=https://raw.githubusercontent.com/stefanprodan/flagger/master

kubectl apply -f ${REPO}/artifacts/namespaces/test.yamlСоздайте деплой и инструмент автоматического горизонтального масштабирования пода:

kubectl apply -f ${REPO}/artifacts/canaries/deployment.yaml

kubectl apply -f ${REPO}/artifacts/canaries/hpa.yamlРазверните сервис тестовой нагрузки для генерации трафика во время canary анализа:

helm upgrade -i flagger-loadtester flagger/loadtester

--namepace=testСоздайте пользовательский canary ресурс (замените example.com на свой домен):

apiVersion: flagger.app/v1alpha3

kind: Canary

metadata:

name: podinfo

namespace: test

spec:

targetRef:

apiVersion: apps/v1

kind: Deployment

name: podinfo

progressDeadlineSeconds: 60

autoscalerRef:

apiVersion: autoscaling/v2beta1

kind: HorizontalPodAutoscaler

name: podinfo

service:

port: 9898

gateways:

- public-gateway.istio-system.svc.cluster.local

hosts:

- app.istio.example.com

canaryAnalysis:

interval: 30s

threshold: 10

maxWeight: 50

stepWeight: 5

metrics:

- name: istio_requests_total

threshold: 99

interval: 30s

- name: istio_request_duration_seconds_bucket

threshold: 500

interval: 30s

webhooks:

- name: load-test

url: http://flagger-loadtester.test/

timeout: 5s

metadata:

cmd: "hey -z 1m -q 10 -c 2 http://podinfo.test:9898/"Сохраните вышеуказанный ресурс как podinfo-canary.yaml, а затем примените его:

kubectl apply -f ./podinfo-canary.yamlПриведенный выше анализ, в случае успеха, будет выполняться в течение пяти минут с проверкой метрик HTTP каждые полминуты. Вы можете определить минимальное время, необходимое для проверки и продвижения canary деплоя, по следующей формуле: interval * (maxWeight / stepWeight). Поля Canary CRD документируются здесь.

Через пару секунд Flagger создаст canary объекты:

# applied

deployment.apps/podinfo

horizontalpodautoscaler.autoscaling/podinfo

canary.flagger.app/podinfo

# generated

deployment.apps/podinfo-primary

horizontalpodautoscaler.autoscaling/podinfo-primary

service/podinfo

service/podinfo-canary

service/podinfo-primary

virtualservice.networking.istio.io/podinfoОткройте браузер и перейдите к app.istio.example.com, вы должны увидеть номер версии демо-приложения.

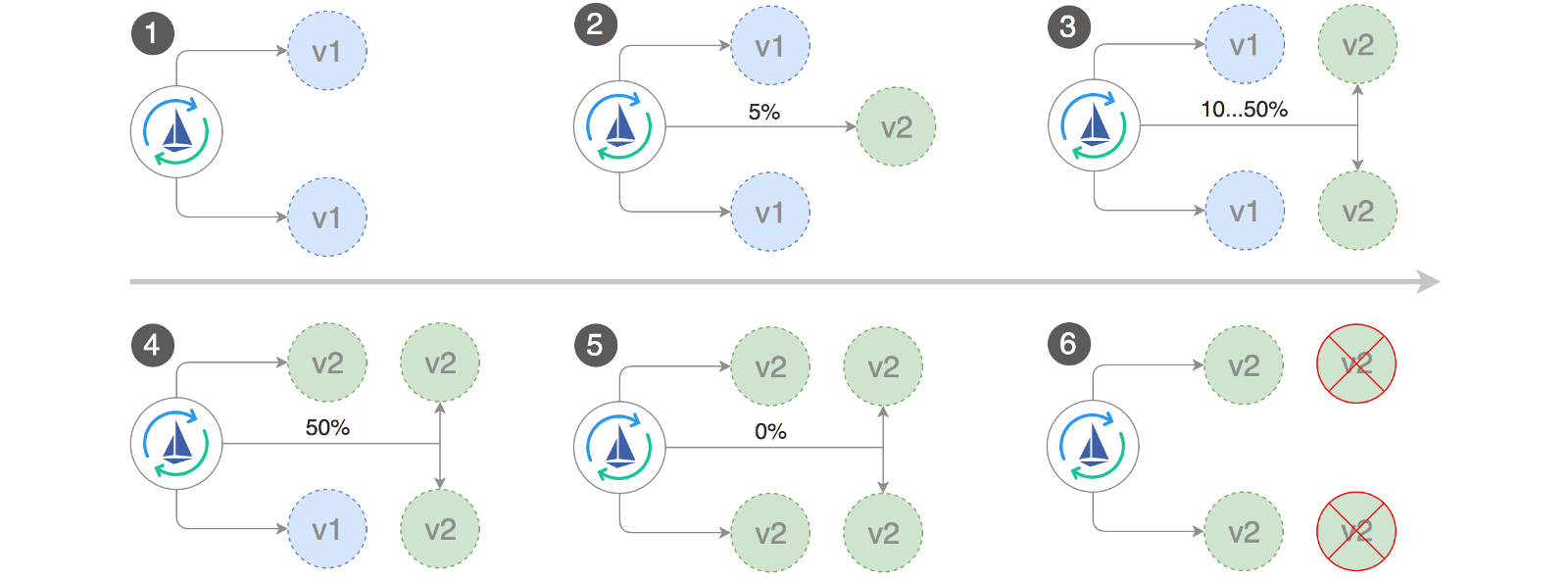

Автоматический canary анализ и продвижение

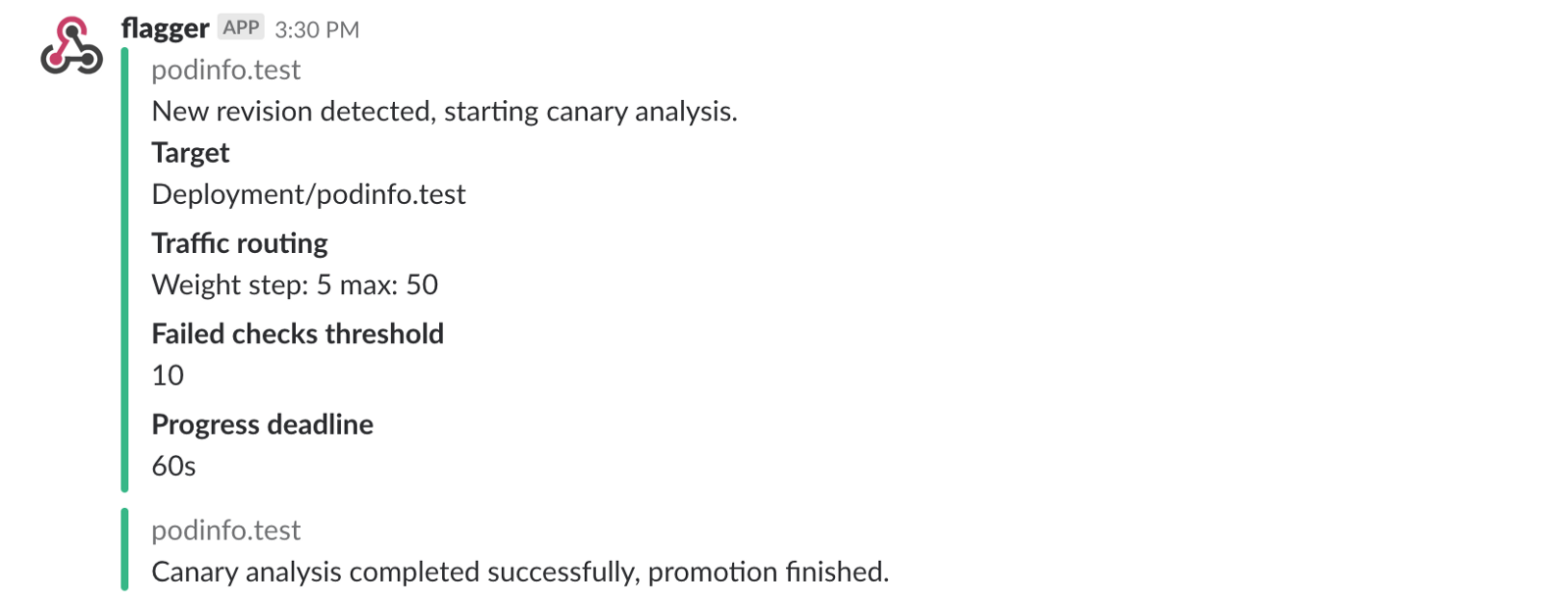

Flagger реализует цикл управления, который постепенно перемещает трафик на canary, одновременно измеряя ключевые показатели производительности, например, уровень успешности HTTP-запросов, среднюю продолжительность запросов и работоспособность пода. На основе анализа KPI canary продвигается или прерывается, а результаты анализа публикуются в Slack.

Canary деплой запускается при изменении одного из следующих объектов:

- Деплой PodSpec (образ контейнера, команда, порты, env и т.д.)

- ConfigMaps монтируются как тома или преображаются в переменные среды

- Секреты монтируются как тома или преображаются в переменные среды

Запуск canary деплоя при обновлении образа контейнера:

kubectl -n test set image deployment/podinfo

podinfod=quay.io/stefanprodan/podinfo:1.4.1Flagger обнаруживает, что версия деплоя изменилась, и начинает ее анализировать:

kubectl -n test describe canary/podinfo

Events:

New revision detected podinfo.test

Scaling up podinfo.test

Waiting for podinfo.test rollout to finish: 0 of 1 updated replicas are available

Advance podinfo.test canary weight 5

Advance podinfo.test canary weight 10

Advance podinfo.test canary weight 15

Advance podinfo.test canary weight 20

Advance podinfo.test canary weight 25

Advance podinfo.test canary weight 30

Advance podinfo.test canary weight 35

Advance podinfo.test canary weight 40

Advance podinfo.test canary weight 45

Advance podinfo.test canary weight 50

Copying podinfo.test template spec to podinfo-primary.test

Waiting for podinfo-primary.test rollout to finish: 1 of 2 updated replicas are available

Promotion completed! Scaling down podinfo.testВо время анализа результаты canary можно отслеживать с помощью Grafana:

Обратите внимание: если новые изменения применить в отношении деплоя во время canary анализа, то Flagger перезапустит фазу анализа.

Составьте список всех "канареек" в вашем кластере:

watch kubectl get canaries --all-namespaces

NAMESPACE NAME STATUS WEIGHT LASTTRANSITIONTIME

test podinfo Progressing 15 2019-01-16T14:05:07Z

prod frontend Succeeded 0 2019-01-15T16:15:07Z

prod backend Failed 0 2019-01-14T17:05:07ZЕсли вы включили уведомления Slack, то получите следующие сообщения:

Автоматический откат

Во время canary анализа можно генерировать синтетические ошибки HTTP 500 и высокую задержку ответа, чтобы проверить, не остановит ли Flagger деплой.

Создайте тестовый под и выполните в нем следующее действие:

kubectl -n test run tester

--image=quay.io/stefanprodan/podinfo:1.2.1

-- ./podinfo --port=9898

kubectl -n test exec -it tester-xx-xx shГенерация ошибок HTTP 500:

watch curl http://podinfo-canary:9898/status/500Генерация задержки:

watch curl http://podinfo-canary:9898/delay/1Когда число неудачных проверок достигает порогового значения, трафик направляется обратно к первичному каналу, canary масштабируется до нуля, а деплой помечается как неудачный.

Ошибки canary и пики задержек регистрируются как события Kubernetes и записываются Flagger в формате JSON:

kubectl -n istio-system logs deployment/flagger -f | jq .msg

Starting canary deployment for podinfo.test

Advance podinfo.test canary weight 5

Advance podinfo.test canary weight 10

Advance podinfo.test canary weight 15

Halt podinfo.test advancement success rate 69.17% < 99%

Halt podinfo.test advancement success rate 61.39% < 99%

Halt podinfo.test advancement success rate 55.06% < 99%

Halt podinfo.test advancement success rate 47.00% < 99%

Halt podinfo.test advancement success rate 37.00% < 99%

Halt podinfo.test advancement request duration 1.515s > 500ms

Halt podinfo.test advancement request duration 1.600s > 500ms

Halt podinfo.test advancement request duration 1.915s > 500ms

Halt podinfo.test advancement request duration 2.050s > 500ms

Halt podinfo.test advancement request duration 2.515s > 500ms

Rolling back podinfo.test failed checks threshold reached 10

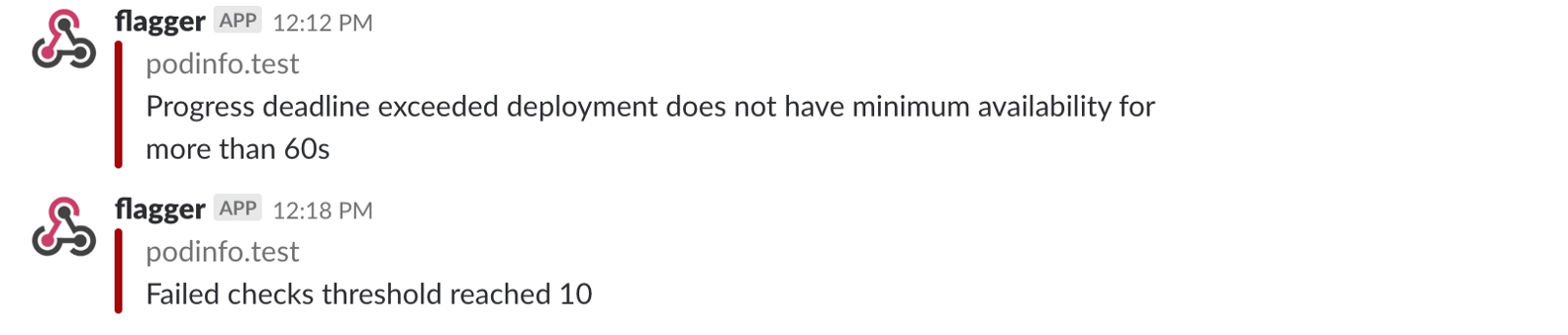

Canary failed! Scaling down podinfo.testЕсли вы включили уведомления Slack, то получите сообщение, когда будет превышен крайний срок выполнения или достижения максимального количества неудачных проверок в ходе анализа:

В заключение

Запуск service mesh, например, Istio, вдобавок к Kubernetes предоставит автоматические метрики, логи и протоколы, но деплой рабочих нагрузок все еще зависит от внешних инструментов. Flagger стремится изменить эту ситуацию, добавляя Istio возможности прогрессивной поставки.

Flagger совместим с любыми CI/CD-решениями для Kubernetes, и канареечный анализ можно легко расширить с помощью вебхуков для выполнения системных тестов интеграции/приемки, нагрузочных тестов или любых других пользовательских проверок. Поскольку Flagger является декларативным и реагирует на события Kubernetes, его можно использовать в пайплайнах GitOps вместе с Weave Flux или JenkinsX. Если вы используете JenkinsX, можете установить Flagger с надстройками jx.

Flagger поддерживается Weaveworks и обеспечивает canary деплои в Weave Cloud. Проект тестируется на GKE, EKS и "голом железе" с kubeadm.

Если у вас есть предложения по улучшению Flagger, пожалуйста, отправьте вопрос или PR на GitHub по адресу stefanprodan/flagger. Взносы более чем приветствуются!

Спасибо Рэю Цану.

Автор: RENESiS