Добрый день!

Добрый день!

Сегодня я расскажу тебе о конференциях ICDAR и CBDAR , состоявшихся в конце августа в стольном граде Вашингтоне. Точнее, не о конференциях целиком – наука там достаточно специфична, не зря помимо сотрудников ABBYY русскоязычных участников там было раз-два и обчёлся. Здесь речь пойдёт о работах команды под руководством учёного-энтузиаста по имени Кай Кунзе (Kai Kunze).

Область интересов Кая не вполне соответствует тематике конференций, но тесно с ней переплетается. Достаточно подробно Кай рассказал о своих разработках на своём пленарном докладе (Keynote talk) конференции CBDAR. А занимается Кай тем, что учит компьютер понимать, чем занимается пользователь. Так как большинство участников конференции (в том числе и я) слабо разбирается в «железе», то эта тема в докладах не была освещена должным образом, поэтому под катом рассказов о железе нет.

Далее я буду излагать видение этого учёного (насколько мне удалось его понять), не упоминая слишком часто, что суждения здесь принадлежат не мне, а Каю Кунзе.

На сегодняшнем этапе развития технологий узким местом для работы представляется внимание пользователя. Устройствами, которые не требуют особого внимания к себе, пользоваться удобнее. Таким образом, компьютеры должны стать проактивными. Как это должно выглядеть? Разберём на небольшом примере.

Предположим, вы ремонтируете какое-то устройство, настолько сложное, что вам приходится часто сверяться с инструкцией. Как было бы удобно, если бы кто-то услужливо открывал вам нужную страницу инструкции в зависимости от того, что именно вы сейчас делаете. Этого легко достичь, если бы этот кто-то понимал, что вы делаете и в чём у вас затруднения. Для того чтобы достичь такого понимания, и создаётся система распознавания деятельности.

Входную информацию система получает из разнообразных сенсоров, которые вешаются на человека – гироскопы, микрофоны, компас, ультразвуковые и инерциальные сенсоры и т.п. Каким образом система обучается, авторы не раскрывают, но, думаю, ничего прорывного в этом моменте нет: скорее всего, используются скрытые марковские модели, де-факто уже ставшие стандартом для распознавания непрерывных процессов. Система уже хорошо обучается и распознаёт разные виды деятельности (во время доклада Кай честно сознался, что сейчас система настраивается на конкретного пользователя, так как сигналы от разных людей, выполняющих одну и ту же работу, очень сильно варьируются). Для каждого рода деятельности нужны свой набор сенсоров. Но возникает ещё ряд проблем.

Можете ли вы представить себе, что ваша бабушка с утра навесит на себя с десяток датчиков, а при смене деятельности будет их заменять? Ну, разве только если вы – Кай Кунзе, которому именно бабушка помогла в исследованиях. Поэтому для реальной работы нужно автоматически калибровать данные с датчиков, чтобы динамически определять, на какой части тела находится датчик, и потом уже оценивать данные, получаемые с него. На самом деле уже сегодня люди носят на себе датчики, в том же смартфоне есть и гироскоп, и микрофон, по словам Кая уже достаточно чувствительные для его целей. С распространением GoogleGlasses задача будет уже совершенно реальной.

Предполагается активизировать набор баз из имеющихся у людей сенсоров, и, как прогнозирует сам Кай, между 2015 и 2020 годами точность распознавания будет более 95% – и это для обычных людей со смартфонами, а не для студентов, обвешанных датчиками.

Теперь вернёмся к теме конференций. Кай и его коллеги представили две разработки. Первая – это попытка по электроэнцефалограмме выяснить, что человек читает – научную статью, новости или мангу (Кай работает в университете Осака). Причём в данном эксперименте систему обучали на одном испытуемом, а тестировали на другом. Результат пока отрицательный: что именно человек читает, выяснить не удаётся – система даёт случайные ответы. Зато очень хорошо получилось отличать чтение от просмотра видео и картинок — правда экспериментов было сделано не слишком много (трижды каждое задание), так что всерьёз о положительном результате говорить пока рано.

Вторая разработка группы, о которой они поведали на конференции, – это система eye-tracking’а для анализа того, что пользователь читает на документе. Этой системе было посвящено аж два доклада. Идея проста – небольшой камерой фиксировать направление взгляда, когда пользователь изучает какой-либо документ, – неважно, бумажный или на компьютере. Очки для этого выглядят вот так:

Перед каждым экспериментом система калибруется, предлагая пользователю последовательно посмотреть в центр документа и в четыре угла. Чтобы побороть перспективные искажения, документ пока что выбирается из базы, где хранится в неискажённом виде.

База была, прямо скажем, не очень большой, но документы из неё узнавались довольно надёжно. Система делала много запросов (на каждый уходило порядка 40 миллисекунд) и почти всегда верно узнавала, какой из документов пользователь читает.

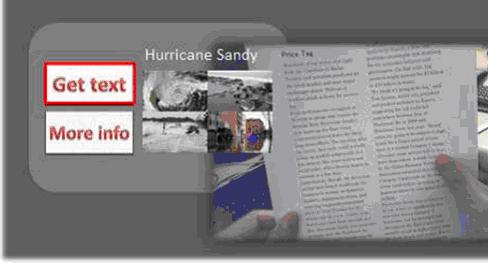

Нужно это может быть для множества разных целей. Например, можно вести статистику из серии «только 10% пользователей дочитывают до этого места». Как это делать, было освещено в докладах. Сразу скажем – идея про контроль чтения пользовательского соглашения озвучена не была :) Докладчик продемонстрировал лог своего чтения, где было видно, как он перевёл взгляд на соседнюю страницу, встретив непонятную аббревиатуру. Для развития этой системы, помимо камеры, отслеживающей взгляд, испытуемому специальный полупрозрачный шлем виртуальной реальности (see-through head mounted display, HMD), которым можно было управлять с помощью взгляда (кнопка считалась нажатой, если пользователь смотрел на неё больше двух секунд). Выглядело со стороны пользователя это примерно вот так:

В докладе рассказали об испытаниях этого устройства. Эксперимент был таким – пользователю давали читать текст (из базы), в котором содержалась строчка «а теперь посмотри на монитор». В статье рапортовали о 100% recall (всегда, когда пользователь смотрел на экран, система это понимала) и 44% precision (более чем в половине случаев, когда система думала, что пользователь смотрит на экран, она ошибалась).

Понятно, что пока что это только научная разработка и «вырастет» ли из неё что-то, сказать трудно. Но Кай Кунзе теперь – это как раз тот человек, который взглядом может двигать указатель мыши и нажимать на плюсик, оценивая этот обзор.

Слайды большого пленарного доклада можно посмотреть здесь.

Дмитрий Дерягин

департамент разработки технологий

Автор: 57DeD