TL;DR: Шесть метрик RAGAS + Precision@K/Recall@K/MRR позволяют поймать деградацию RAG-системы до того, как пользователи заметят галлюцинации. В этой статье будет всё от

pip install ragasдо автоматических проверок в CI/CD, включая security-тесты на document poisoning.

Проблема

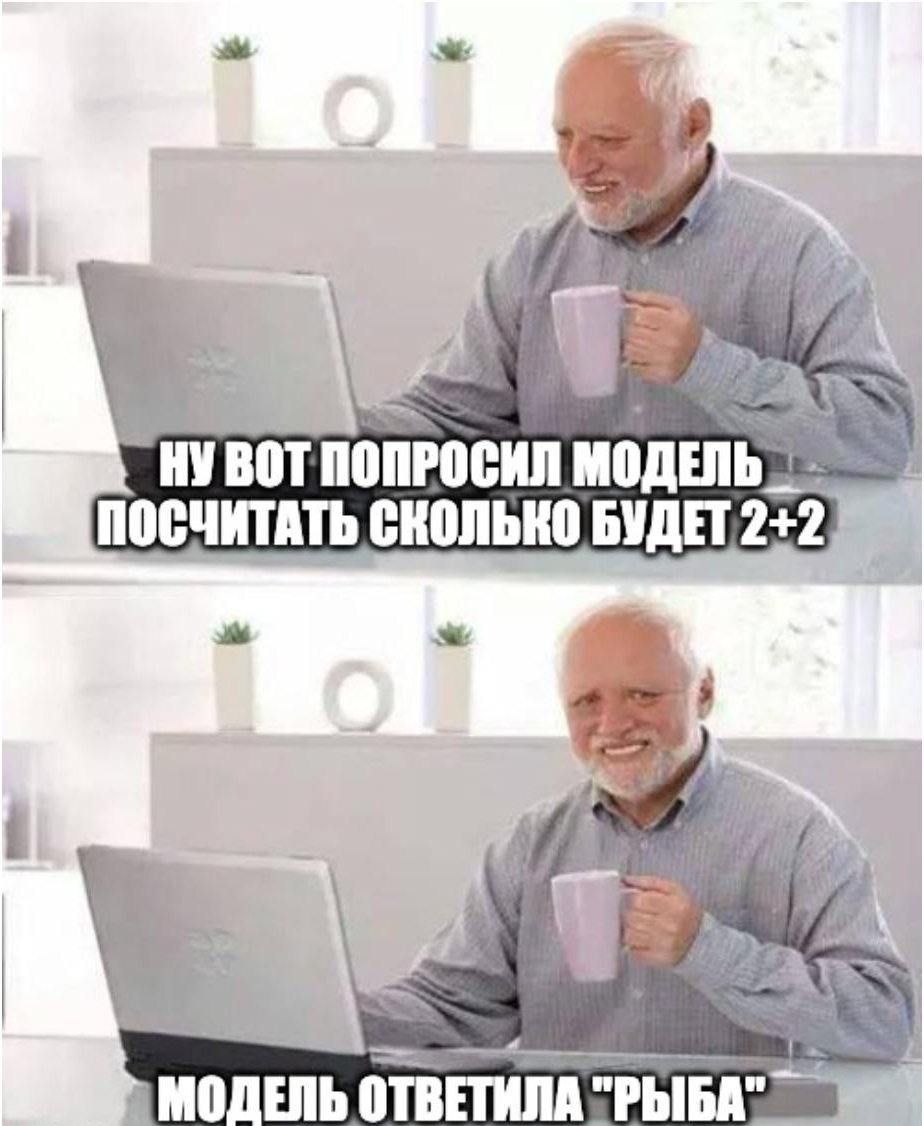

RAG ломается не так, как обычный LLM. У голой языковой модели одна поверхность отказа: генерация. Модель галлюцинирует, отвечает невпопад, игнорирует инструкции. У RAG-системы таких поверхностей две: retrieval и generation. И они ломаются по-разному.