За последний год корпорация Facebook привнесла много интересного в стандарты разработки сетевого оборудования. При этом если большинство разработчиков оставляет свои проекты проприетарными, то Facebook открывает инновации для других. Собственно, для компании, цель которой — обеспечить обществу обмен информации, такая модель работы имеет смысл. При этом открытая схема работы позволяет Facebook экономить средства. По оценкам Джеймса Тейлора, вице-президента компании по инфраструктуре, за последние 3 года Facebook сэкономила более $2 млрд, разрешив членам «Open Compute Project» работать по собственным спецификациям.

Кроме того, привлекает внимание Wedge, открытый top-of-rack свич, разработанный OCP-сообществом. Далее последовали 6-Pack, FBOSS и OpenBNC. Корпорация Facebook построила свой новый дата-центр, основанный на разработках Open Compute Project, в Алтуне, Айова, США. При этом компания предоставила всю необходимую информацию об этом проекте. Здесь есть несколько идей, которые могут использоваться в дата-центрах других компаний, причем ДЦ любого размера.

Кластерный дизайн Facebook

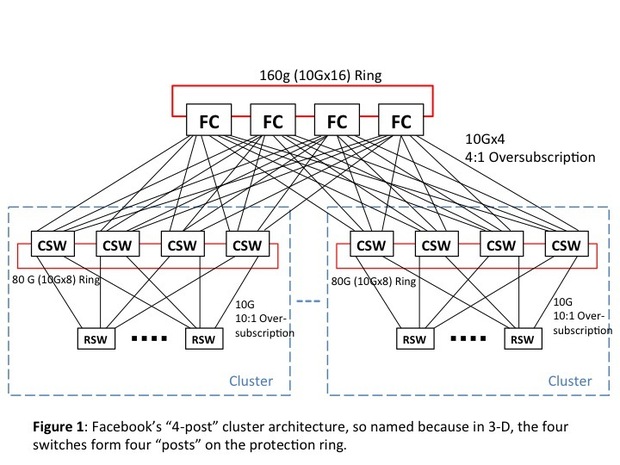

На первом изображении показан агрегированный кластерный дизайн ДЦ в Алтуне. Разработчики называют архитектуру дата-центра «4-post». Здесь вплоть до 255 стоек могут быть объединены через ToR-свитчи в кластерные свитчи высокой плотности (CSW). У RSW может быть до 44 10G даунлинков и 4 или 8 10G аплинков. Четыре CWS и подключенные RSW составляют кластер.

Четыре агрегированных «FatCat» (FC) свитча объединяют кластеры в единую систему. У каждого CSW — 40G коннект с одним из четырех FC. Защитное кольцо 80G объединяет CWS в пределах каждого кластера, и FC подключены к защитному кольцу 160G.

Это действительно хорошая структура по нескольким причинам, включая надежность и практичность системы. Тем не менее, для Facebook этого оказалось недостаточно. Дело в том, что многие проблемы в такого рода архитектуре являются следствием необходимости установки очень больших свитчей для CSW и FC.

Что с Altoona?

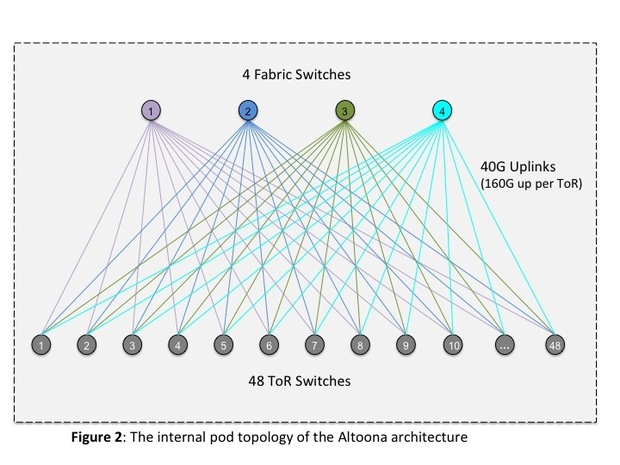

В архитектуре дата-центра нового поколения из Altoona большинство проблем кластерной архитектуры решены, при этом сохранены лучшие черты такого типа архитектуры.

К примеру, здесь используется не несколько больших свитчей, а множество маленьких. При этом каждый свитч отвечает за небольшой процент загрузки, и выход из строя одного свитча не является значительной проблемой;

Также в таком ДЦ снижаются капитальные и операционные затраты;

Увеличение размеров и мощности дата-центра такого типа производится за очень сжатые сроки, значительно дешевле, чем в обычных ДЦ.

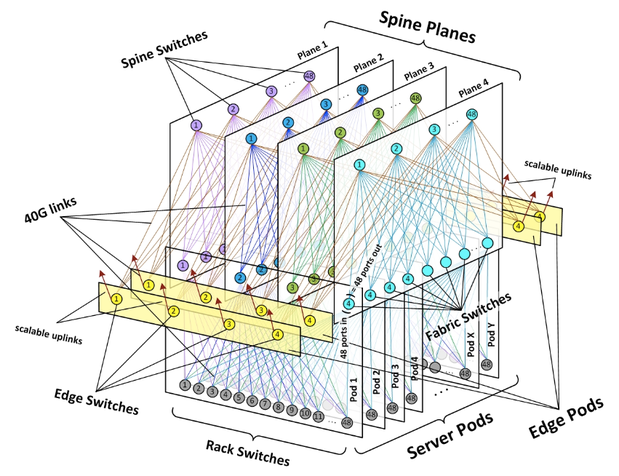

Топология сети такого ДЦ показана на следующем изображении, где можно быстро распознать Clos. Вместо работы с сотнями стоек в кластерном дизайне, здесь каждый из топологических юнитов отвечает за 48 стоек.

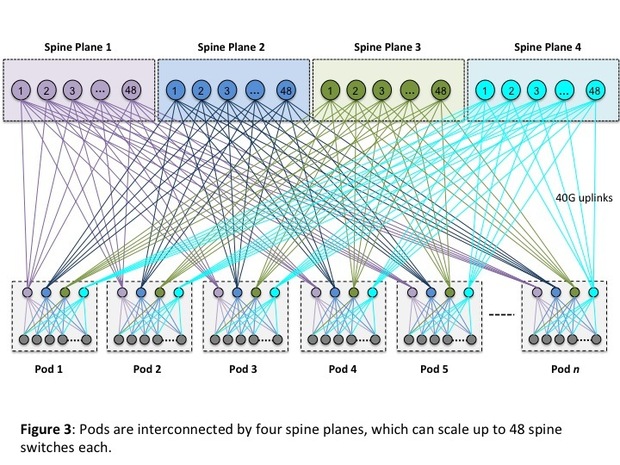

Ниже — объемная схема топологии такого рода дата-центра.

Представители Facebook утверждают, что модульный дизайн дата-центра позволяет очень быстро изменять структуру ДЦ, добавляя или убирая определенные элементы. Все изменения производятся за минимальное время с минимальными затратами. Подробнее эта точка зрения объясняется здесь:

Преимуществом нового типа дата-центра от Facebook является возможность использования небольших свитчей, в архитектуре, позволяющей масштабировать объект до любых размеров, без необходимости изменения базовых блоков.

Свитчи можно использовать от Accton, Quanta, Celestica, Dell и некоторых других компаний. При этом стоимость свитча от Quanta с 32 40G портами составляет 7495 долларов, а Juniper QFX5100 с 24 40G портами стоит немногим меньше 30 тысяч.

Гипермасштабирование — что это?

Большинство специалистов, работающих в телекоммуникационной сфере, применяют этот термин только к гигантам, вроде Amazon, Google, Facebook. Тем не менее, термин означает возможность изменения масштабирования в очень сжатые сроки. Гипермасштабированный дата-центр может быть относительно небольшим, но его можно увеличить в любое время без внесения фундаментальных изменений в инфраструктуру. Также в этом случае должна быть возможность использования тех же свитчей и соединений, что использовались изначально.

В ДЦ может быть всего несколько стоек, но это уже может быть hyperscale-ДЦ.

Еще одним заблуждением в плане гипермасштабирование является уверенность в том, что ДЦ такого типа «заточены» на оптимальную работу с одним или несколькими основными приложениями. Это не совсем так. В идеале, hyperscale-дизайн означает возможность поддержку сотен бизнес-приложений с той же легкостью, с какой ДЦ работает с big-data, поисковыми приложениями или социальными медиа.

Что касается ДЦ Facebook — здесь можно добавлять дополнительные блоки и слои без особых проблем, причем столько, сколько нужно в конкретный момент.

Автор: itNews