В 2016/2017 годах мы обнаружили, что на каждой из наших конференций есть 1-3 доклада о Big Data, нейросетях, искусственном интеллекте или машинном обучении. Стало понятно, что под эту тему можно собрать хорошую конференцию, о чём я сегодня вам и расскажу.

Вкусно: мы решили собрать под одной крышей учёных, инженеров-практиков, архитекторов и сделать упор на технологии — казалось бы, обычное дело, но нет.

Сложно: копнув глубже, можно увидеть, что отдельными вопросами все занимаются не сообща, а врозь.

Учёные строят нейросети в теории, архитекторы делают распределённые системы для корпораций с целью обработки огромных потоков данных в реальном времени, без конечной цели унифицировать к ним доступ, инженеры-практики пишут под это всё софт для сугубо узких задач, которые потом нереально перенести на что-то другое. В общем, каждый копает свою грядку и не лезет к соседу… Так? Да нет же!

На деле: Все занимаются частью общего. Как сама Smart Data (а «умные данные» — это очень узкий перевод) по природе своей, так и те, кто с ней работает, по сути, делают распределённую сеть различных наработок, которые могут создавать порой неожиданные сочетания. Это и формирует фундамент Умных данных в своей красоте и практической значимости.

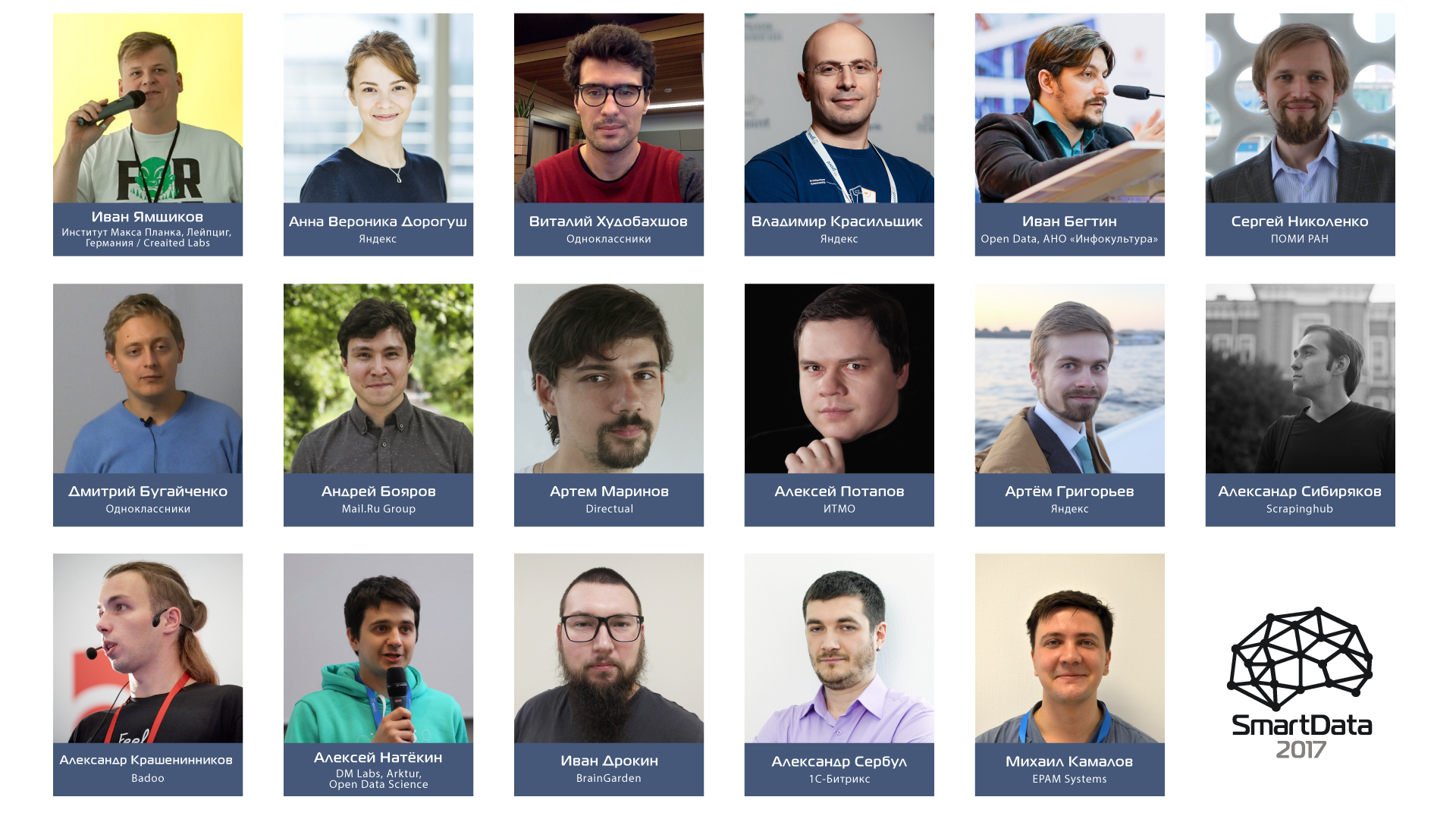

Итак, что это за кусочки паззла и кто их создает, можно будет посмотреть и даже обсудить с создателями на конференции SmartData 2017 Piter 21 октября 2017. Подробности под катом.

Дальше будет много букв, мы же за большие и умные данные, хотя исторически анонс подразумевает быстрый и ёмкий текст, краткий и точный, как выстрел снайпера в ясную летнюю ночь.

Обычно мы делим все доклады на три-четыре категории, но тут так не получится, каждый доклад — самостоятельная история.

Вначале было Имя. А «Имя — это фича»

Двусмысленность и заезженность названия (даже мы эксплуатируем этот оборот второй раз за месяц), казалось бы, за гранью добра и зла. Но это даже близко не касается содержания открывающего кейноута Виталия Худобахшова.

Кейноут: Виталий khud Худобахшов — «Имя — это фича»

Кейноут: Виталий khud Худобахшов — «Имя — это фича»

Как бы странно это ни казалось образованному человеку, вероятность быть одинокой/одиноким «зависит» от имени. Мы поговорим про любовь и отношения, а точнее, что именно могут рассказать об этом данные социальной сети. Это примерно всё равно, что сказать: «Вероятность быть сбитым машиной, если тебя зовут Серёжа, выше, чем если бы тебя звали Костя!» Звучит довольно дико, не правда ли? Ну, как минимум, ненаучно.

Таким образом, мы поговорим о самых неожиданных и контринтуитивных наблюдениях, которые можно сделать с помощью анализа данных в социальных сетях. Конечно, мы не обойдём вниманием вопросы статистической значимости таких наблюдений, влиянии ботов и ложных корреляций.

В общем и целом, у Виталия Худобахшова в распоряжении одна из самых больших баз для аналитики в нашей стране. Доступ к ней у Виталия с 2015 года в роли ведущего аналитика в Одноклассниках, где он занимается различными аспектами анализа данных.

Дмитрий Бугайченко — «От клика к прогнозу и обратно: Data Science пайплайны в ОК»

Дмитрий Бугайченко — «От клика к прогнозу и обратно: Data Science пайплайны в ОК»

Умные данные у Виталия и машинное обучение у Дмитрия связаны, даже части их жизненных путей в чём-то похожи. Анализ больших данных в Одноклассниках стал для Дмитрия уникальным шансом совместить теоретическую подготовку и научный фундамент с разработкой реальных, востребованных продуктов. И этим шансом он с радостью воспользовался, придя туда пять лет назад.

В ходе доклада расскажем о технологиях обработки и хранения данных экосистемы Hadoop, а также о многом другом. Этот доклад будет полезен тем, кто занимается машинным обучением не только для развлечения, но и для профита.

В качестве примера рассмотрим одну сложную задачу — персонализацию новостной ленты ОК. Не вдаваясь в детали, обсудим сбор данных (пакетном и real-time), ETL, а также обработку, необходимую для получения модели.

Но просто получить модель недостаточно, поэтому мы также поговорим о том, как получить основанные на модели прогнозы в сложной высоконагруженной распределённой среде и как их использовать для принятия решений.

И если всё же хочется совсем погрузится в алгоритмизацию машинного обучения на практике и работе с большими данными, то тогда диалог лучше вести с человеком, прошедшим одну из самых жёстких школ по алгоритмам в стране (Школа анализа данных — ШАД). Встречайте: Анна Вероника Дорогуш.

Анна Вероника Дорогуш — «CatBoost — следующее поколение градиентного бустинга»

Анна Вероника Дорогуш — «CatBoost — следующее поколение градиентного бустинга»

Двойное имя, как двойное направление доклада по особенностям нового открытого алгоритма градиентного бустинга CatBoost от Яндекса. В докладе пойдёт речь о том, как была разработана технология, которая умеет работать с категориальными характеристиками, и зачем выкладывать её в открытый доступ. Также про CatBoost будут ответы на вечное: что (применять)? где (работает)? кому (стоит обратить внимание)?

Доклад будет полезен специалистам по машинному обучению и специалистам по работе с данными: после его прослушивания они получат понимание, как наиболее эффективно пользоваться CatBoost и где он может принести пользу уже сейчас.

Артём ortemij Григорьев — «Краудсорсинг: как приручить толпу?»

Артём ortemij Григорьев — «Краудсорсинг: как приручить толпу?»

Пара специалистов из ОК, пара из Яндекс — уже толпа, а с ней и четвёртая, «другая» задача в докладе, на этот раз ещё более прикладная. В задачах машинного обучения и анализа данных зачастую требуется собрать большое количество ручной разметки. При малом количестве исполнителей работа может занимать месяцы. Артём собирается показать, как это можно делать быстро и дёшево! И этот опыт возможно перенести на другие задачи (а они точно есть), где требуется много исполнителей на ограниченный срок. В докладе, основанном на опыте создания и использования Толоки, краудсорсинговой платформы Яндекса, будут рассмотрены вопросы контроля качества, мотивации исполнителей, а также различные модели агрегации результатов разметки.

Артём в Яндексе с 2010 года, руководитель группы, отвечает за разработку инфраструктуры сбора экспертных оценок, развитие сервисов для асессоров и краудсорсинговой платформы Яндекс.Толока.

Александр alexkrash Крашенинников — «Hadoop high availability: опыт Badoo»

Александр alexkrash Крашенинников — «Hadoop high availability: опыт Badoo»

Большие и умные данные требуют определенной инфраструктуры. Будем честны — очень требуют. Что выбрать?

Инфраструктура Hadoop – популярное решение для таких задач, как распределённые хранение и обработка данных. Хорошая масштабируемость и развитая экосистема подкупают и обеспечивают Hadoop’у прочное место в инфраструктуре различных информационных систем. Но чем больше ответственности возлагается на этот компонент, тем важнее обеспечивать его отказоустойчивость и высокую доступность.

Доклад Александра будет про обеспечение высокой доступности компонентов Hadoop-кластера. Кроме этого, поговорим:

- о «зоопарке», с которым мы имеем дело; *

- о том, зачем обеспечивать высокую доступность: точки отказа системы и последствия отказов;

- о средствах и решениях, существующих для этого;

- о практическом опыте внедрения: подготовка, деплой, проверки.

Доклад будет наиболее полезен тем, кто уже использует Hadoop (для углубления своих знаний). Другой части аудитории доклад будет интересен с точки зрения обзора архитектурных решений, применяемых в этом программном комплексе.

* Александр как никто другой понимает, что такое «зоопарк».

Он сам — руководитель DataTeam в компании Badoo. Занимается разработкой инструментов для обработки данных в рамках ETL и процессинга различного рода статистики, инфраструктурой Hadoop. Опыт web-dev более 10 лет. Для достижения наилучших результатов не гнушается использовать гремучие смеси из языков программирования (Java, PHP, Go), баз данных (MySQL, Exasol) и технологий распределённых вычислений (Hadoop, Spark, Hive, Presto).

Александр asibiryakov Сибиряков — «Автоматический поиск контактной информации в интернете»

Александр asibiryakov Сибиряков — «Автоматический поиск контактной информации в интернете»

Чем больше данных, тем больше «информационного мусора». Проработав пять лет в Яндексе и два года в Avast! в роли архитектора, Александр построил автоматическое разрешение ложных срабатываний. После чего интерес к обработке данных в больших объёмах и информационному поиску только усиливался, как оно обычно бывает с делом, которое действительно тебе нравится.

Речь в докладе Александра пойдёт о распределённом роботе для обхода веба, поиска и извлечения контактной информации с корпоративных веб-сайтов. Фактически, это два компонента: веб-робот для получения контента и отдельное приложение для анализа и извлечения.

Основной фокус доклада будет направлен на само извлечение, на поиск работающей архитектуры, последовательность алгоритмов и способы сбора обучающих данных. Доклад будет полезен всем, кто работает с обработкой веб-данных или предоставляет решения для обработки больших объёмов данных.

Алексей natekin Натёкин — «Карты, бустинг, 2 стула»

Алексей natekin Натёкин — «Карты, бустинг, 2 стула»

По общему мнению моих коллег, Алексей — весьма харизматичен, что отлично линкуется с тем фактом, что он является диктатором и координатором Open Data Science — крупнейшего в Восточной Европе онлайн сообщества Data Scientist-ов. В дополнение к сказанному, Алексей является продюсером серьезных проектов по машинному обучению и анализу данных.

А теперь о докладе. Все любят градиентный бустинг. Он показывает отличные результаты в большинстве практических приложений, а фраза «стакать xgboost-ы» стала мемом. Как правило, речь идёт про бустинг деревьев решений, а для обучения используют CPU и машины с кучей оперативной памяти. В последнее время многие по разным причинам закупились видео-картами и решили: а почему бы нам не позапускать бустинг на них, нейросети же на GPU существенно ускоряются. К сожалению, не всё так просто: реализации бустинга на GPU есть, но в их полезности и осмысленности есть много нюансов. Попробуем вместе разобраться на докладе Алексея — нужна ли вам в 2017-2018 видеокарта, чтобы обучать градиентный бустинг.

P.S. Кстати, у информации есть свой срок годности, притом у каждого типа данных он разный. Так, в случае Алексея была предоставлена другая фотография, её можно посмотреть на сайте конференции, чтобы всё же правильно его идентифицировать.

Сергей snikolenko Николенко —

Сергей snikolenko Николенко — Ещё одна победа роботов: AlphaGo и глубокое обучение с подкреплением «Глубокие свёрточные сети для обнаружения объектов и сегментации изображений»

А это наглядная иллюстрация ещё одного срока годности информации: пока готовился этот пост, успела поменяться целая концепция доклада.

В итоге, в докладе Сергея мы обсудим, как сети, распознающие отдельные объекты, превращаются в сети, выделяющие объекты среди массы других. Мы поговорим и о знаменитом YoLo, и о single-shot detectors, и о линии моделей от R-CNN до совсем недавно появившейся Mask R-CNN. И в принципе о том, что свёрточные нейронные сети давно стали основным классом моделей для обработки изображений, а нам с этим жить.

Кстати, это не все данные, которые возможно получить у Сергея Николенко — специалиста по машинному обучению (глубокое обучение, байесовские методы, обработка текстов и многое другое) и анализу алгоритмов (сетевые алгоритмы, конкурентный анализ). Автора более 100 научных публикаций, нескольких книг, авторских курсов «Машинное обучение», «Обучение глубоких сетей» и др.

Владимир vlkrasil Красильщик — «Назад в будущее современной банковской системы»

Владимир vlkrasil Красильщик — «Назад в будущее современной банковской системы»

Историческая справка: «первая распределённая онлайн-система обмена банковской информацией в Российской федерации начала свою жизнь в 1993 году, и это был не Сбербанк»

Современные банковские Big Data системы — это не только обработка и хранение сотен миллионов транзакций в день и взаимодействие с мировыми торговыми площадками на космических скоростях, но также жёсткий контроль и отчётность со стороны аудиторов и регуляторов. В докладе рассмотрим, что такое Audit-Driven Development и откуда оно взялось, подскажем, как организовать битемпоральное хранилище фактов, чтобы не облажаться перед контролирующими органами, и докажем, что в любой современной распределённой системе просто обязана быть встроена машина времени. Также в процессе выступления будет раскрыта «универсальная формула факта» и чем чаще всего оказываются задачи так называемой «аналитики».

Немного о спикере, вернее, много: Владимир с отличием окончил кафедру Математического Обеспечения СПбГЭТУ «ЛЭТИ» и уже более 14 лет разрабатывает программное обеспечение для государственных, образовательных и финансовых учреждений, а также автомобильных и телекоммуникационных концернов. Работает в Санкт-Петербургском филиале компании Яндекс разработчиком Яндекс.Маркет. Владимир является резидентом российского сообщества Java-разработчиков JUG.ru и выступает на таких отраслевых конференциях, как JPoint, Joker, JBreak и PGDay.

Иван Дрокин — «Нет данных? Нет проблем! Deep Learning на CGI»

Иван Дрокин — «Нет данных? Нет проблем! Deep Learning на CGI»

Итак, слова «датасет», «свёрточные сети», «рекурентные сети» не страшные и даже не требуют расшифровки? Тогда доклад Ивана Дрокина про глубокие свёрточные сети нашёл свою аудиторию.

«We need to go deeper»

В настоящий момент глубокие свёрточные сети являются state-of-the-art алгоритмами во многих задачах компьютерного зрения. Однако большинство таких алгоритмов требуют огромных обучающих выборок, и качество модели целиком зависит от качества данных и их количества. В ряде задач сбор данных затруднен или подчас невозможен.*

В докладе мы рассмотрим пример обучения глубоких свёрточных сетей для локализации ключевых точек объекта на полностью синтетическом наборе данных.

* В одном таком эксперименте данные собирались анкетированием и оцифровывались силами студентов одного из Вузов в рамках дипломной работы. Обработка одного массива, даже при наличии современных средств работы с данными, заняла 2 недели только на ввод данных в систему. А для боевого проекта этих данных требуется в разы больше. Есть ли у вас лишние «студенческие» силы на сбор этих данных? Нет? Тогда, надеюсь, вы поставили в план и доклад Артёма Григорьева.

Инструктор по погружению — Иван Дрокин, сооснователь и chief science officer компании Brain Garden, специализирующейся на разработке и внедрении интеллектуальных решений полного цикла. В профессиональные интересы входят приложение глубокого обучения к анализу и обработке естественных языков, изображений, видеопотока, а также обучение с подкреплением и вопрос-ответные системы. Имеет глубокую экспертизу в облатях финансовых рынков, хедж-фондов, биоинформатике, вычислительной биологии.

Артём onexdrk Маринов — «Сегментируем 600 миллионов пользователей в режиме реального времени каждый день»

Артём onexdrk Маринов — «Сегментируем 600 миллионов пользователей в режиме реального времени каждый день»

Не будем проводить аналогию с «Большим Братом», так как данные в проекте, на котором основан доклад Артёма, собираются обезличено. К чему НЕ приводить подобную аналогию?

Каждый день пользователи совершают миллионы действий в интернете. Проекту FACETz DMP необходимо структурировать эти данные и проводить сегментацию для выявления предпочтений пользователей (ТАДАМ!). В своём докладе Артём расскажет, как, используя Kafka и HBase, можно:

- сегментировать 600 миллионов пользователей после перехода с MapReduce на Realtime;

- обрабатывать 5 миллиардов событий каждый сутки;

- хранить статистику по количеству уникальных пользователей в сегменте при потоковой обработке;

- отслеживать влияние изменений параметров сегментации.

Артём Маринов занимается рекламными технологиями с 2013 года, последние два года работал в компании Data-Centric Alliance в качестве лидера разработки DMP Facetz, сейчас работает в компании Directual. До этого несколько лет вёл разработку ряда рекламных проектов в компании Creara. Специализируется в области BigData и работе с высокими нагрузками. Основные языки — Java / Scala, в профессии уже около 8 лет.

Алексей a_potap Потапов — «Глубокое обучение, вероятностное программирование и метавычисления: точка пересечения»

Алексей a_potap Потапов — «Глубокое обучение, вероятностное программирование и метавычисления: точка пересечения»

Итак, есть генеративные и дискриминантные модели, которые могут выступать в роли подходов к определению некоторых параметров линейных классификаторов, которые в свою очередь могут выступать в роли способа решения задач классификатора, когда решение принимается на основании линейного оператора над входными данными, соответственно обладающих свойство линейной сепарабельности, а саму операцию линейной классификации для двух классов можно представить как отображение объектов в многомерном пространстве на гиперплоскость … в доме, который построил Джек. *

Этот абзац призван подготовить вас к тому, что будет много про генеративные и дискриминативные модели, их связи между собой и практическое применение в рамках двух наиболее перспективных подходов к машинному обучению — глубокого обучения и вероятностного программирования.

* Данная последовательность не является частью доклада Алексея Потапова, профессора кафедры компьютерной фотоники и видеоинформатики ИТМО.

Чтобы понять, насколько Алексею нравится его дело, достаточно посмотреть его активность за 2 года: опубликовано два пособия и 27 научных работ, включая 12 работ в реферируемых журналах и одну монографию; получено 5 свидетельств о регистрации программ для ЭВМ; а ещё участие в 5 международных конференциях, хотя, возможно, и это не показатель.

Иван ibegtin Бегтин — «Открытые данные: о доступности госданных и как их искать»

Иван ibegtin Бегтин — «Открытые данные: о доступности госданных и как их искать»

Иван достаточно известный человек, но если кто не в курсе, краткая вводная часть.

Иван Бегтин — директор и соучредитель АНО «Инфокультура» , член экспертного совета при Правительстве, член комитета гражданских инициатив Алексея Кудрина, лауреат премии в области общественно-политической журналистики «Власть N4» (2011 г.), лауреат премии «pressЗвание» в номинации «Зона особого внимания» (2012 г.), соучредитель общероссийского конкурса Apps4Russia. Автор общественных проектов «ГосЗатраты», «Публичные доходы», «Гослюди», «Государство и его информация» и множества других. Посол в России фонда Open Knowledge Foundation.

Зачем эти данные? Биография Ивана — лучшая вводная к его докладу об открытых данных правительства.

Государственная политика открытых данных в России и в мире позволяет обеспечить доступ к данным, создаваемым в органах власти, неограниченному числу пользователей. Это открывает новые возможности для бизнеса, готового создавать на их основе новые продукты и развивать имеющиеся, но требует знания и понимания того, как устроены сбор, анализ и публикация данных.

В докладе Ивана будет рассказано, как именно и для чего данные собираются, как правительство их использует. И, конечно, как получить к ним доступ и использовать в своем проекте. Кроме того, данные не всегда достоверны, в них накапливаются ошибки, поэтому разберёмся и с тем, как эти ошибки можно учитывать.

Может быть, если уж их собирают с нас в таком количестве, их пора использовать?

Михаил Камалов — «Рекомендательные системы: от матричных разложений к глубинному обучению в поточном режиме»

Михаил Камалов — «Рекомендательные системы: от матричных разложений к глубинному обучению в поточном режиме»

«А к этому докладу мы вам рекомендуем взять доклад Артёма Маринова, который как нельзя лучше подчеркнет практическую значимость данного материала».

Ничего не напоминает?

В настоящее время рекомендательные системы активно применяются как в сфере развлечений (Youtube, Netflix), так и в сфере интернет-маркетинга (Amazon, Aliexpress). В связи с этим, в докладе будут рассмотрены практические аспекты применения глубинного обучения, коллаборативной и контентной фильтрации и фильтрации по времени как подходов в рекомендательных системах. Дополнительно будет рассмотрено построение гибридных рекомендательных систем и модификации подходов для онлайн обучения на Spark.

Погружение в практические системы для простых пользователей, которыми являемся и мы с вами, будет осуществляться под руководством Михаила Камалова, Аналитика в EPAM Systems с 2016, экспертом в области задач, связанных с NLP и информационным поиском.

Андрей Бояров — «Deep Learning: Распознавание сцен и достопримечательностей на изображениях»

Андрей Бояров — «Deep Learning: Распознавание сцен и достопримечательностей на изображениях»

Всем, кто дошёл до этого места — наши благодарности за терпение и интерес.

Как уже было сказано в начале этой статьи, в области больших и умных данных нет оторванных от общей миссии исследований и докладов. Так, к этому докладу, в канве описания предыдущего, можно рекомендовать доклад Ивана Дрокина для более глубокого погружения в свёрточные нейронные сети.

В докладе Андрея Боярова пойдёт речь о построении системы для решения задачи scene recognition при помощи state-of-the-art подхода, основанного на глубоких свёрточных нейронных сетях. Что актуально для корпорации Mail.Ru, где Андрей работает в качестве программиста-исследователя.

Задача распознавания достопримечательностей вытекает из распознавания сцен. Здесь нам нужно среди всех изображений сцен выделить те, на которых присутствуют разнообразные известные места: дворцы, памятники, площади, храмы и т.д. Однако при решении этой задачи важно обеспечить низкий уровень ложных срабатываний. В докладе будет рассмотрено решение задачи распознавания достопримечательностей на основе нейронной сети для scene recognition.

Александр AlexSerbul Сербул — «Прикладное машинное обучение в электронной коммерции: сценарии и архитектуры пилотов и боевых проектов»

Александр AlexSerbul Сербул — «Прикладное машинное обучение в электронной коммерции: сценарии и архитектуры пилотов и боевых проектов»

Находясь практически на финишной прямой создания нашей сети докладов необходимо всё же свериться с практическим опытом. В этом нам поможет Александр Сербул, курирующий направление контроля качества интеграции и внедрений ООО «1С-Битрикс», а также направления AI, deep learning и big data. В том числе, Александр выступает в роли архитектора и разработчика в проектах компании, связанных с высокой нагрузкой и отказоустойчивостью («Битрикс24»), консультирует партнеров и клиентов по вопросам архитектуры высоконагруженных решений, эффективному использованию технологий кластеризации продуктов «1С-Битрикс» в контексте современных облачных сервисов (Amazon Web Services и др.)

Всё вышеперечисленное было вложено в доклад о реализованных в компании пилотах и боевых проектах, использующих различные популярные и «редкие» алгоритмы машинного обучения: от рекомендательных систем до глубоких нейронных сетей. В проектах сделан упор на техническую реализацию на платформах Java (deeplearning4j), PHP, Python (keras/tf) с использованием открытых библиотек Apache Mahout (Taste), Apache Lucene, Jetty, Apache Spark (в т.ч. Streaming), спектра инструментов в Amazon Web Services. Даны ориентировки в важности тех или иных алгоритмов и библиотек, актуальности их применения и востребованности на рынке.

А это те самые реализованные проекты:

- кластеризация пользователей Битрикс24 с помощью Apache Spark

- расчёт вероятности ухода (churn), возможной прибыли (CLV) и других бизнес-метрик в условиях big data и высоких нагрузок

- коллаборативная рекомендательная система на более чем 20 000 интернет-магазинов

- кластеризация товарного каталога методом LSH

- content-based рекоментадельный сервис для более чем 100 млн. пользователей рунета

- классификатор обращений в техническую поддержку Битрикс24 на базе нейронной сети (кроме n-gramm моделей, рассмотрим также пилоты с одномерной свёрткой)

- чат-бот ответов на вопросы на базе нейросети, осуществляющей соединение семантических пространств вопросов и ответов.

Кейноут: Иван Ямщиков — «Neurona: зачем мы научили нейросеть писать стихи в стиле Курта Кобейна?»

Кейноут: Иван Ямщиков — «Neurona: зачем мы научили нейросеть писать стихи в стиле Курта Кобейна?»

Как связаны Курт Кобейн, Гражданская оборона, искусство (классическое, музыкальное и изобразительное) и большие данные?

Если хабрапост Machine Learning: State of the art вдруг не попался на глаза на главной странице хабра… Ничего страшного, ещё есть время. А пока статья читается, есть возможность построить связи с другими докладами: от нейросети и GPU, памятников архитектуры, распознавания и Deep Learning придём, наконец, к вопросу «искусственного интеллекта».

Есть много примеров применения машинного обучения и искусственных нейронных сетей в бизнесе, но в этом докладе Иван поговорит о творческих возможностях ИИ. Расскажет, как делали Neurona, Нейронную Оборону и Пианолу. В конце концов, будут обобщены и представлены современные задачи в области построения творческого ИИ, а также приведены ответы на вопросы, почему это важно и интересно.

Иван Ямщиков на данный момент — научный сотрудник Института Макса Планка (Лейпциг, Германия) и консультант Яндекса. Он исследует новые принципы работы искусственного интеллекта, которые могли бы помочь понять, как работает наш .

Итак, наша сеть завершена и ждёт встречи. Все доклады протестированы на совместимость и взаимодополняемость.* Спланировать свой путь можно по готовой программе на сайте конференции. И рекомендуется учитывать наличие дискуссионных зон, где всегда можно поговорить с докладчиком лично после его сессии, не ограничиваясь блоком вопросов в конце доклада.

*Рекомендации не обязательны к использованию и являются личным мнением автора, которое может не разделять любой участник или наш Программный Комитет. Автор сам озадачен вопросами ИИ и дальнейшего взаимодействия с ИоТ, поэтому смотрит на всё предвзято.

Автор: BigSolarWolf