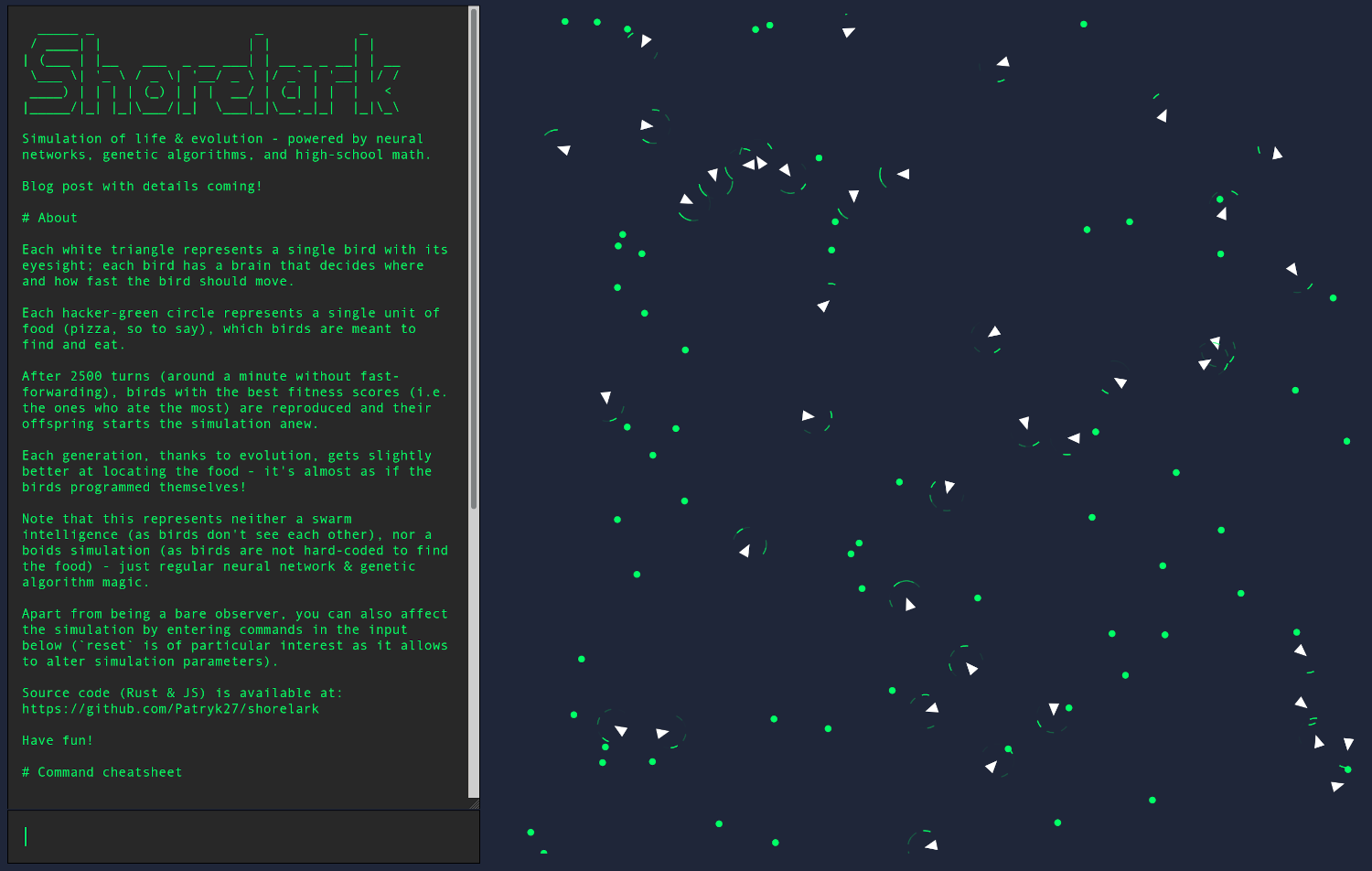

Это предпоследняя часть серии статей по разработке симуляции эволюции с помощью нейронной сети и генетического алгоритма.

В сегодняшнем выпуске:

Сексуальные многоугольники

Сертифицированные ISO диаграммы ASCII

------------

| ...%....|

| ......|

| @>....|

| ...|

| .|

------------Клевые числа