Рубрика «ComfyUI»

Как развернуть что угодно с ИИ-агентами, даже ComfyUI с жирными моделями

2026-01-12 в 13:00, admin, рубрики: ComfyUI

Антон

Продакт-менеджер Интелион Облако

Сколько VRAM нужно для нейросетей?

2025-12-21 в 16:16, admin, рубрики: ComfyUI, memory bandwidth, neural networks, quantization, VRAM, Видеокарты, генеративные модели, нейросеть для генерации изображений, нейросеть локальноЭтот пост будет полезен людям, кто хочет разобраться в локальных моделях, особенно использующим их, как инструмент в создании контента, арта и дизайна (контекст нейросетей - image и video). Так же поговорим о выборе видеокарты и параметрах влияющих на генеративные workflow.

VRAM requirements

Для начала - график с оптимальными и минимальными значениями VRAM для image и video моделей.

Дизайнер-видеомонтажёр — это просто! (Клип за 1000р)

2025-09-18 в 17:06, admin, рубрики: after effects, AI, chatgpt, ComfyUI, premier pro, замена лица, ИИ, искуственный интеллект, музыка, Работа с видео

Идеи не падают с неба — они складываются из того, что нас окружает. Кто работал на фрилансе или шабашил наверняка сталкивался с проблемами продать подороже (купить подешевле).

Установка FLUX.1 Kontext для ComfyUI — подробное пошаговое руководство

2025-07-09 в 3:07, admin, рубрики: ComfyUI, flux, FLUX.1 Kontext, веб-дизайн, гайд, генерация изображений, дизайн, нейросети, установка

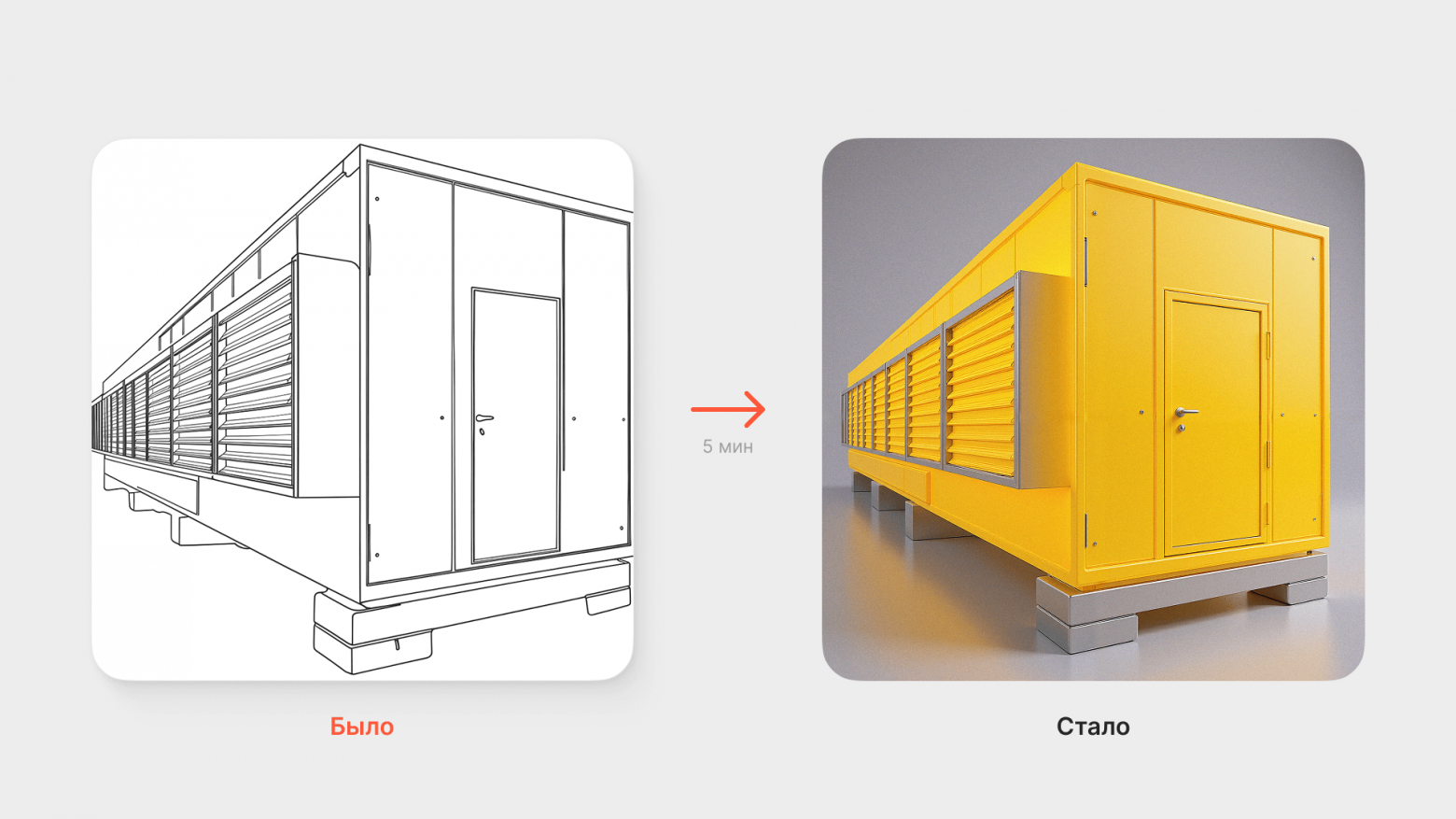

Больше не нужно несколько часов составлять воркфлоу для ComfyUI или Forge, чтобы сгенерировать картинку по стилю с референса.

Установка Stable Diffusion + ComfyUI

2025-06-22 в 5:42, admin, рубрики: ComfyUI, stablediffusion, tutorialДисклеймер

Я пишу эту статью, как туториал для себя (на случай, если придётся переустанавливать) и для друзей. Все это, конечно же, можно нагуглить, но только что уже это сделал, погуглил, початогепетил и собрал результаты в виде одной инструкции. Возможно, кому-то полезно будет.

Я не являюсь опытным пользователем нейросетей, это мой первый опыт установки и использования, но он может быть полезен, т.к. я прошелся по граблям и нашёл рабочий вариант. Советы и указания на косяки приветствуются.

Подготовка

Мои исходные данные: OS: Linux Mint 22 x86_64, GPU: NVIDIA 5070 Ti, установлен NVIDIA driver 570.153.02.

Генерация видео: Обзор интересных подходов | Text-2-video | Part 1

2025-05-17 в 17:15, admin, рубрики: AI, animatediff, ComfyUI, computer vision, ml, stable diffusion, video generation, нейросети, собеседования, собеседования задачиТут я расскажу про основные подходы в генерации видео, материал будет полезен ML/Computer vision разработчикам, чтобы держать руку на пульсе, и людям интересующимся нейросетями + AI

План следующий:

-

Методы адаптации T2I в T2V: AnimateDiff, Text2Video Zero

-

Обзор классических подходов: Stable Video Diffusion, CogVideo

-

Новые модельки 2025: Wan2.1, HunyuanVideo, FramePack

Это первая часть из списка статей, тут будет только про T2I в T2V

Intro

CLIP или SigLIP. База по Computer vision собеседованиям. Middle-Senior

2025-05-09 в 21:02, admin, рубрики: CLIP, ComfyUI, ml, SigLIP, Компьютерное зрение, собеседование в IT, собеседование вопросыВопросы о CLIP-моделях встречаются почти на каждом техническом собеседовании.

Неважно, занимаетесь ли вы видеоаналитикой, создаёте генеративные модели или работаете над поиском по изображениям — CLIP и его потомки (BLIP , SigLIP Читать полностью »

Как добавить в OpenWebUI генерацию изображений через ComfyUI

2025-02-21 в 11:05, admin, рубрики: ComfyUI, hostkey, openwebui, stablediffusion, генерация изображений, нейросети, облачные сервисыOpenWebUI как хороший медиакомбайн для работы с нейросетями умеет и в генерацию изображений. Не своими силами, конечно, но позволяет даже неподготовленному пользователю написать промт и получить картинку, как если бы вы работали в ChatGPT или GigaChat. Сделать это можно через API OpenAI или используя интерфейсы доступа к моделям StableDiffusion или Flux типа stable-diffusion-webui (она же Automatic1111) или ComfyUI.

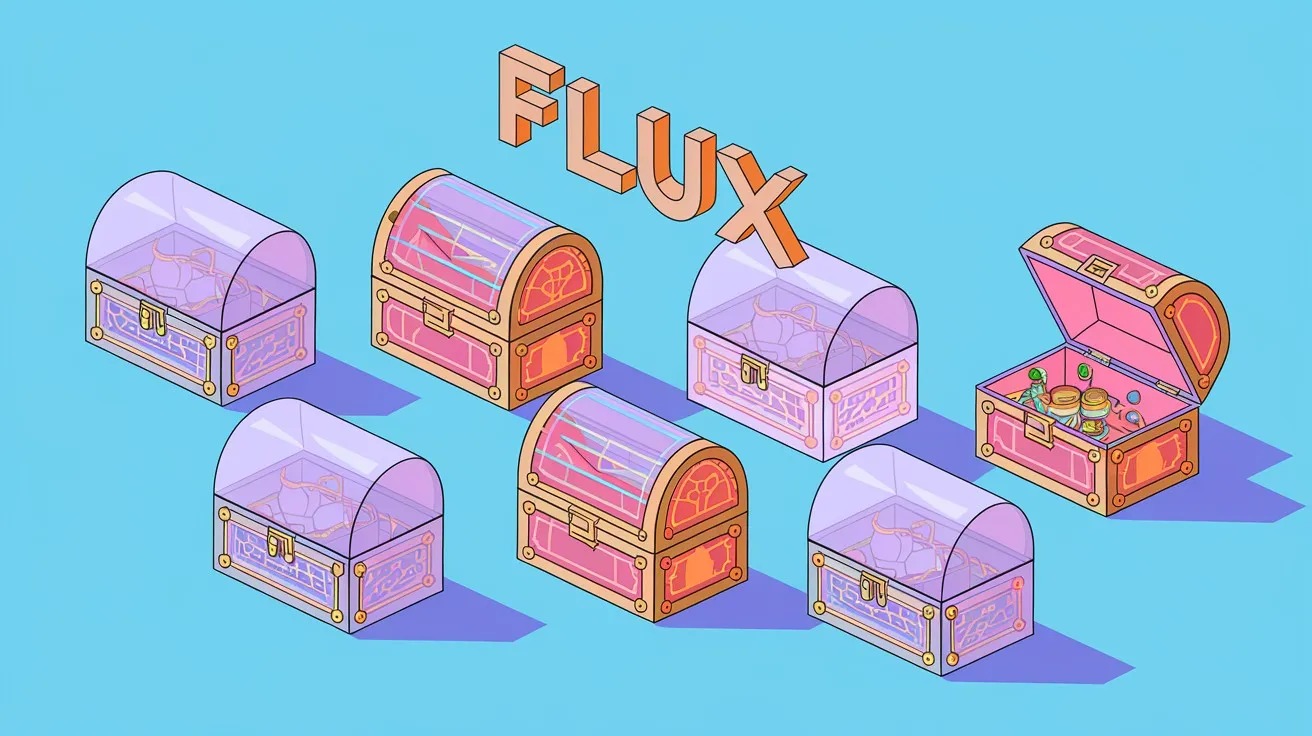

Бесплатная альтернатива Midjourney: 7 типов моделей Flux. Как установить и развернуть модели Flux на компьютере

2024-12-14 в 9:41, admin, рубрики: ComfyUI, flux, midjourney, генерация изображений

В этой статье я расскажу вам о том, как установить, развернуть и использовать 7 моделей Flux на разных платформах.