Идея использовать нейросети для шифрования информации витала в голове у меня давно (с конца 2000х). Но, как это водится, то времени не хватало, то желания. Так что пишу это только сейчас (хотя может материал уже и устарел).

Читать полностью »

Метка «нейронные сети»

Сеть-шифровальщик или как я от нейросети странного хотел

2017-04-14 в 15:47, admin, рубрики: машинное обучение, метки: python, нейронные сети, шифрованиеРекуррентная нейронная сеть решает задачу поддержания равновесия

2016-01-07 в 15:24, admin, рубрики: Песочница, метки: искусственный интеллект, нейрон, нейронные сети, пид-регулятор, рекуррентная нейросеть, синапсСразу постановка задачи.

Дано:

Примитивное виртуальное пространство для проведения эксперимента:

1. Аквариум высотой 1000 мм.

2. Дырявое дно аквариума. Уровень воды уменьшается на 1 мм за такт.

3. Стакан с водой, доливка которой в аквариум повышает уровень воды на 6 мм.

Также имеется заготовка нейронной сети, состоящая из:

1. 1000 рецепторов. По 1 рецептору на миллиметр.

2. 1 эффектор. Возбужденный в текущем такте, дает команду вылить стакан воды в аквариум.

Хотелось бы:

1. Добиться поддержания определенного нами уровня воды в аквариуме. Ну, или близко к нему. В текущем примере 500 мм.

Читать полностью »

Быстрая нейронная сеть для каждого

2015-03-26 в 18:09, admin, рубрики: Песочница, метки: java, tutorial, нейронные сети Данная статья продемонстрирует возможность легко написать свою нейронную сеть на языке Javа. Дабы не изобретать велосипед, возьмем уже хорошо проработанную библиотеку Fast Artificial Neural Network. Использование нейронных сетей в своих Java-проектах — реально. Часто можно услышать упреки в адрес Java касательно скорости выполнения. Хотя разница не так велика — подробно об этом можно узнать в публикации «Производительность C++ vs. Java vs. PHP vs. Python. Тест «в лоб»». Мы будем использовать обертку вокруг библиотеки FANN.

Читать полностью »

Что скрывают нейронные сети?

2014-06-03 в 15:19, admin, рубрики: восстание машин, Глубокая сеть, глубокое обучение, искусственный интеллект, нейронные сети, метки: восстание машин, Глубокая сеть, глубокое обучение, нейронные сетиСтатья является вольным переводом The Flaw Lurking In Every Deep Neural Net.

Недавно опубликованная статья с безобидным заголовком является, вероятно, самый большой новостью в мире нейронных сетей с момента изобретения алгоритма обратного распространения. Но что же в ней написано?

В статье "Интригующие свойства нейронных сетей" за авторством Christian Szegedy, Wojciech Zaremba, Ilya Sutskever, Joan Bruna, Dumitru Erhan, Ian Goodfellow and Rob Fergus, команды, включающей авторов из проекта Google по глубокому обучению, кратко описываются два открытия в поведении нейронных сетей, противоречащие тому, что мы думали прежде. И одно из них, честно говоря, ошеломляет.

Читать полностью »

Логика мышления. Часть 4. Фоновая активность

2014-03-04 в 9:08, admin, рубрики: биоинформатика, искусственный интеллект, мозг, нейронные сети, робототехника, метки: искусственный интеллект, Мозг, нейронные сети

Вернемся к описанию работы реальных нейронов. Сигналы от одних нейронов через их аксоны поступают на входы других нейронов. В химических синапсах происходит выброс медиатора, который в зависимости от типа синапса оказывает либо активирующее, либо тормозящее воздействие на принимающий сигнал нейрон. Чувствительностью синапса, которая может меняться, определяется вклад этого синапса в общее возбуждение. Если суммарное воздействие превышает определенный порог, то происходит деполяризация мембраны и нейрон генерирует спайк. Спайк – это одиночный импульс, продолжительность и амплитуда которого не зависит от того, какая синаптическая активность его породила.

Читать полностью »

Логика мышления. Часть 3. Персептрон, сверточные сети

2014-03-02 в 17:02, admin, рубрики: биоинформатика, искусственный интеллект, нейронные сети, робототехника, метки: искусственный интеллект, нейронные сети

В первой части мы описали свойства нейронов. Во второй говорили об основных свойствах, связанных с их обучением. Уже в следующей части мы перейдем к описанию того как работает реальный мозг. Но перед этим нам надо сделать последнее усилие и воспринять еще немного теории. Сейчас это скорее всего показаться не особо интересным. Пожалуй, я и сам бы заминусовал такой учебный пост. Но вся эта «азбука» сильно поможет нам разобраться в дальнейшем.

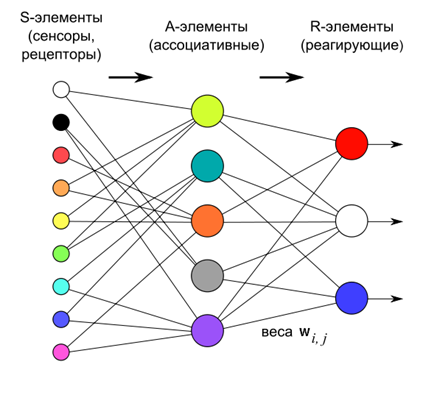

Персептрон

В машинном обучении разделяют два основных подхода: обучение с учителем и обучение без учителя. Описанные ранее методы выделения главных компонент – это обучение без учителя. Нейронная сеть не получает никаких пояснений к тому, что подается ей на вход. Она просто выделяет те статистические закономерности, что присутствуют во входном потоке данных. В отличие от этого обучение с учителем предполагает, что для части входных образов, называемых обучающей выборкой, нам известно, какой выходной результат мы хотим получить. Соответственно, задача – так настроить нейронную сеть, чтобы уловить закономерности, которые связывают входные и выходные данные.

Читать полностью »

Нейронные сети, «вредные» советы

2014-02-06 в 9:38, admin, рубрики: искусственный интеллект, машинное обучение, нейронные сети, метки: машинное обучение, нейронные сетиИсторически, искусственные нейронные сети за свою уже более чем полувековую историю испытывали как периоды стремительных взлетов и повышенного внимания общества, так и сменявшие их периоды скепсиса и равнодушия. В хорошие времена ученым и инженерам кажется, что наконец-то найдена универсальная технология, способная заменить человека в любых когнитивных задачах. Как грибы после дождя, появляются различные новые модели нейронных сетей, между их авторами, профессиональными учеными-математиками, идут напряженные споры о большей или меньшей степени биологичности предложенных ими моделей. Профессиональные ученые-биологи наблюдают эти дискуссии со стороны, периодически срываясь и восклицая «Да такого же в реальной природе не бывает!» – и без особого эффекта, поскольку нейросетевики-математики слушают биологов, как правило, только тогда, когда факты биологов согласуются с их собственными теориями. Однако, с течением времени, постепенно накапливается пул задач, на которых нейронные сети работают откровенно плохо и энтузиазм людей остывает.Читать полностью »

Разработка нечеткой нейронной сети NEFClass M

2013-10-17 в 9:59, admin, рубрики: Алгоритмы, искусственный интеллект, Исследования и прогнозы в IT, нейронные сети, метки: нейронные сетиАнализ недостатков системы NEFClass показывает, что их причиной является несовершенство алгоритма обучения нечетких множеств NEFClass. Для того что бы исправить это, необходимо заменить эмпирический алгоритм обучения на строгий алгоритм численной оптимизации. Как и оригинальная, так и модифицированная модель NEFClass основывается на архитектуре нечеткого персептрона. Архитектурные различия оригинальной и модифицированной моделей состоит в виде функций принадлежности нечетких множеств, функции t-нормы для вычисления активаций нейронов правил, а также в виде агрегирующей функции (t-конормы), определяющей активации выходных нейронов. Применение численных методов оптимизации требует дифференцируемости функций принадлежности нечетких множеств – условие, которому треугольные функции принадлежности не удовлетворяют. Поэтому в модифицированной модели нечеткие множества имеют гауссовскую функцию принадлежности.

Требование дифференцируемости диктует также вид t-нормы (пересечения) для вычисления активации нейронов правил. В системе NEFClass для этого используется функция минимума; в модификации это произведение соответствующих значений. Наконец, вид агрегирующей функции (t-конормы) для модифицированной модели ограничен только взвешенной суммой. Причина состоит в том, что функция максимума, которая используется в оригинальной системе, не удовлетворяет условию дифференцируемости.

Основное изменение, касается алгоритма обучения нечетких множеств. Целевой функцией в модифицированной системе NEFClass выступает минимизация среднеквадратичной ошибки на обучающей выборке по аналогии с классическими нейросетями

Читать полностью »

Мой опыт работы с SOINN

2013-08-20 в 6:41, admin, рубрики: SOINN, искусственный интеллект, нейронные сети, метки: SOINN, искусственный интеллект, нейронные сетиЗанимаясь алгоритмическим трейдингом, я довольно продолжительное время строил торговых роботов на основе классических индикаторов и методов технического анализа. Попутно, почитывая различные статьи, я натыкался на упоминания о нейронных сетях, которые с той или иной степенью успешности трейдеры применяют для торговли. Эта тема меня увлекла.Читать полностью »

Нейросеть на практике: Задача коммивояжера

2013-08-04 в 13:34, admin, рубрики: биоинформатика, нейронные сети, метки: нейронные сети Добрый день, уважаемые хабропользователи.

Хотел бы поделиться практическим применением одного из алгоритмов нейродинамики, в продолжении моего поста Моделирование нейросети Машина Больцмана.

Реализация на примере решения задачи коммивояжера.

Немного напомню в чем ее суть.

Читать полностью »