Нейросеть Stable Diffusion известна многим. Она позволяет генерировать изображения по текстовому описанию. Но, как оказалось, с её помощью можно также создавать и музыку. Суть в том, что система может создавать аудиоспектрограммы — визуальные изображения звуковых частот в треке. После этого нужно лишь «воспроизвести» полученный звук.

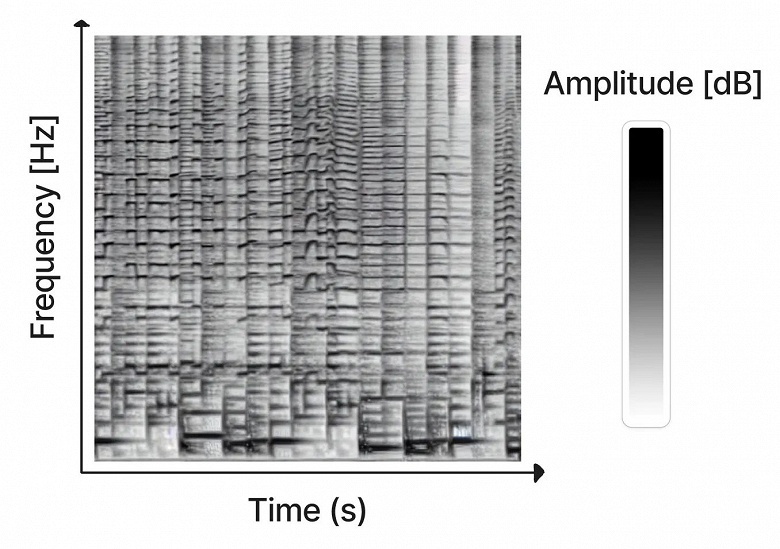

В спектрограмме (или сонограмме) на оси представлен порядок воспроизведения частот слева направо. По оси Y размещаются данные о частотах звука, а цвет пикселей задаёт амплитуду звука в каждой момент времени.

Нейросеть обучили на сонограммах, которые описывают музыкальные жанры или звуки. В результате получилась Riffusion — нейросеть, способная генерировать звук из изображения, которое создаётся по текстовому описанию. Для вывода именно аудиодорожки используется Torchaudio.

При этом разработчики смогли заставить нейросеть генерировать такие аудиоклипы, которые могли бы плавно «перетекать» друг в друга. То есть, темп музыки не меняется резко.

- Веб-интерфейс можно взять здесь.

- Нейросеть скачать можно здесь.

- Попробовать онлайн здесь.

- Сгененрировать спектрограмму здесь.

Ранее сообщалось, что художники начали настоящую войну против нейросети на ArtStation.