Статья является переводом двух статей AJ Cruz:

Nexus 1000v Part 1 of 2 (Theory)

Nexus 1000v Part 2 of 2 (Installation & Operation)

Частично пересекается со статьями:

Установка Nexus 1000V на vSphere 5.1 (Часть первая)

Установка Nexus 1000V на vSphere 5.1 (Часть вторая)

Но там другой стиль изложения и другие особенности, например установка VEM в ядро гипервизора через VMware Update Manager.

Nexus 1000v Часть 1 из 2 (Теория)

Это будет первая из двух публикаций о моем исследовании свича Nexus 1000v.

Здесь я расскажу о теории Nexus 1000v. А во второй части опишу установку и эксплуатацию.

В то время как я буду продолжать свой пост, я могу упоминать различную терминологию, которая нуждается в определении. Поэтому я сразу обозначу некоторые термины:

- vSphere Distributed Switch (vSphere Распределенный Свич)

- Virtual Distributed Switch (Виртуальный Распределенный Свич)

- DVS

- Distributed Virtual Switch (Распределенный Свич)

Все вышеуказанное — это как vSphere Distributed Switch обычно упоминается в интернете и в разного рода документации.

Они все означают одно и то же и относятся к виртуальному свичу в целом.

Cisco Nexus 1000v — это один из вариантов реализации

Давайте узнаем что же такое

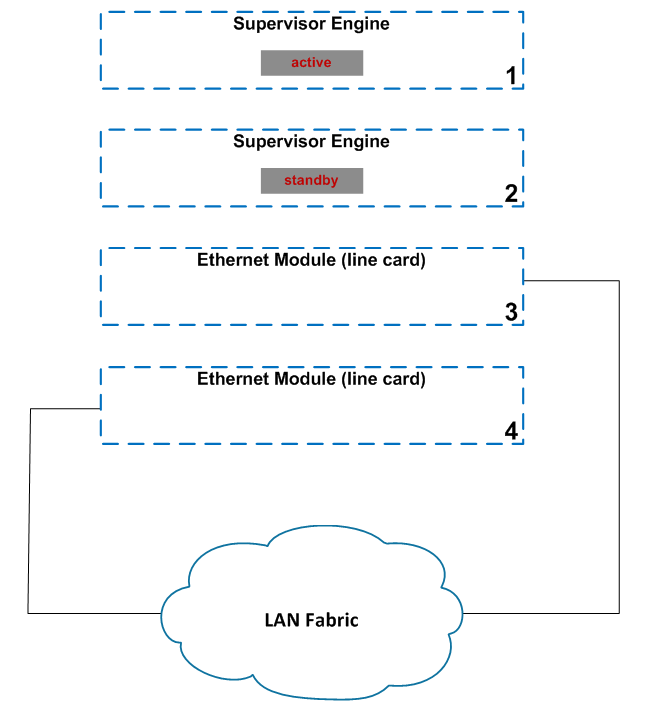

Довольно стандартный. У нас есть пара Supervisor Engines в разъемах 1 и 2, Sup в разъеме 1 активен. Также у нас есть пара модулей ввода-вывода (IOM, линейные платы, модули Ethernet, интерфейсные карты) в слотах 3 и 4. Линии LAN матрицы созданы чтобы показать, каким образом мы могли бы подсоединиться к остальной нашей инфраструктуре.

Теперь посмотрите на графическое представление

У нас есть такие же четыре модуля, но теперб они работают в качестве программного обеспечения в рамках VMware («V» в

VSM — Апплаинс виртуальной машины (Виртуальный модуль управления) Виртуальная машина, которая представляет собой «мозг» (как Supervisor Engine)

VEM — Виртуальный Ethernet-модуль. Программное обеспечение на каждом хосте ESXi, участвующем в

SVS — Свич вертиуализации сервера. В SVS конфигурация определяет то, каким образом VEMы связываются со своим родительским VSM. В общих чертах похоже (по крайней мере в моей голове) на трассировку магистралей в стандартных модульных свичах.

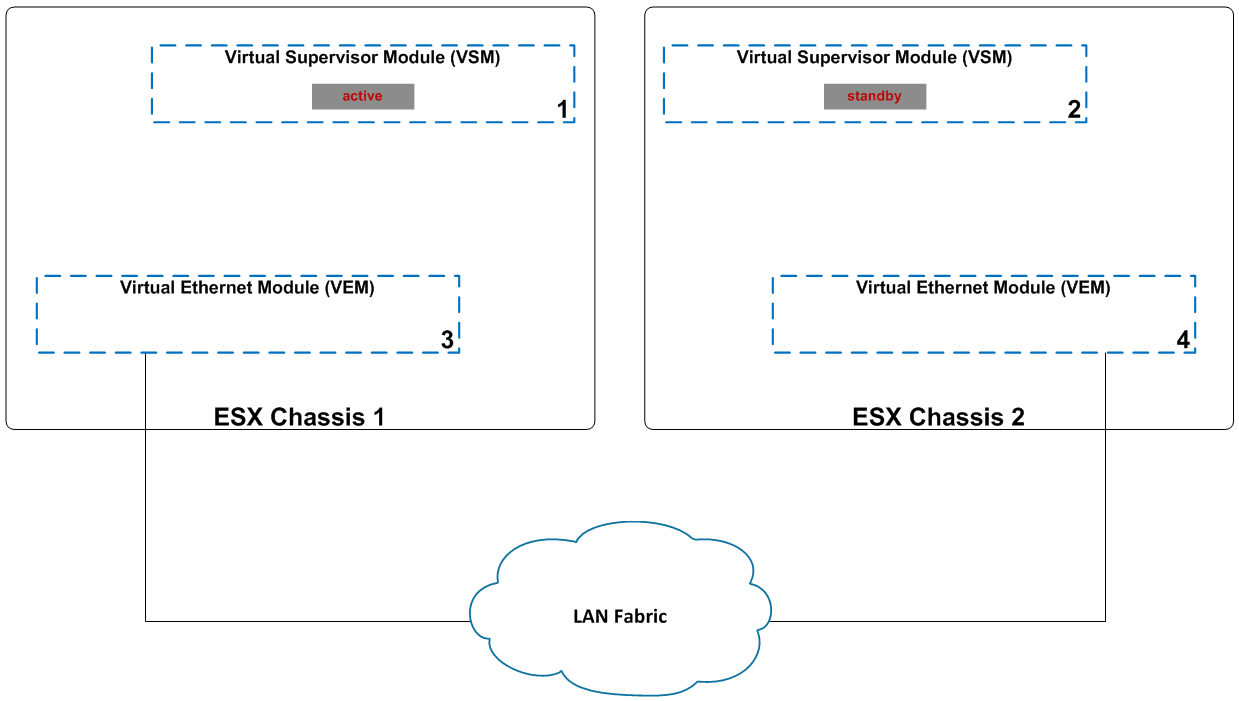

Давайте копнем немного глубже и посмотрим, как виртуальные машины «подключаются» к

Не важно принадлежат ли профили портов к VEM или VSM, я устанавливаю их на VEM чтобы сделать работу более понятной. Что же представляет собой профиль порта?

В виртуальном свиче (и это логично) мы не выполняем операция на физическом интерфейсе. Фактически, виртуальный интерфейс к которому подключается VM даже не существует до тех пор пока не был настроен адаптер VM. Итак, что нам нужно сделать — это создать контейнер, куда мы все поместим. Контейнер содержит информацию о конфигурации (vlan, политику QoS (Quality of Service) и т.д.) и выступает в качестве своего рода воронки или точки агрегации для виртуальных машин.

Когда мы редактируем настройки виртуальной машины и выбираем подключение к сети ее адаптера, мы увидим выпадающий список (с помощью изображение выше) с пунктами «B» и «А».

Почему же мы не видим два другим профиля портов (X или Y)?

Профиль порта vethernet — тип профиля порта, который используется для подключений виртуальной машины. Доступен в выпадающем списке подключений к сети настроек адаптера Виртуальной Машины.

Профиль порта Ethernet — тип профиля порта, который используется для физического подсоединения из ESX сервера. Не отображается в настройках адаптера VM.

Таким образом, хотя виртуальные машины назначены на профиль порта vethernet, физические сетевые адаптеры назначены на профиль порта ethernet. Как профили портов vethernet знают какой профиль порта ethernet использовать для исходящего трафика?

На 1000v не запущено связующее дерево. Профили портов Ethernet должны быть настроены с уникальными VLAN. Другими словами, определенный VLAN должен быть привязан к одному профилю порта ethernet. 1000v позволит вам настроить несколько профилей Ethernet-портов с одним и тем же VLAN, но в дальнейшем это приведет к проблемам.

Это не значит что мы не можем иметь резервирование каналов восходящей связи. Как можно видеть на последнем изображении: два сетевых адаптера назначены одному провилю порта ethernet. Резервирование может быть достигнуто с помощью LACP или vPC хост-режима (mac-пиннинг). Я не хочу слишком углубляться в процесс mac-пиннинга, но он в основном работает так же, как и звучит. MAC-адрес определенной виртуальной машины прикрепляется к однуму из физических выходных портов. Разделение VM межуд физическими сетевыми адаптерами (происходит автоматически посредством VPC хост-режима) обеспечивает измерение распределения нагрузки.

vPC Host Mode (vPC Хост Режим) — НЕ VPC!!! Выбросите vPC из головы. vPC хост режим = MAC-пиннинг. Если вы уже работали с VMware — это то же самое, что и «Маршрут на основе идентификатора исходного виртуального порта».

Это метод распределения нагрузки, не требующий специальной конфигурации свича. Как уже упоминалось, MAC-адреса просто привязывают на один физический порт или на другой.

Далее я хотел бы изучить немного больше о соединениях SVS. Первоначально VEM (ESXi хост) и VSM должны быть смежными с Уровнем 2. Последние версии 1000v поддерживают развертывания на Уровне 3 и это рекомендуемый метод развертывания. Связь между VEM и VSM — IP. Фактически, при развертывании на Уровне 3 весь трафик отправляется через UDP-порт 4785. Тем не менее, это не происходит автоматически. Нам нужно настроить профиль порта vethernet vmkernel с помощью команды "capability l3control". Именно это дает указание VEM инкапсулировать все связанное с плоскостью контроля в UDP 4785 и отправлять на VSM.

Теперь мы видим, что столкнулись с проблемой «курица или яйцо», особенно если VSM работает на VEM.

System VLAN — разрешает сквозной доступ к настроенному трафику VLAN трафик, что означает немедленный доступ к сети в отсутствие VSM-соединения; порты vmkernel необходимо настроить с системным VLAN. Кроме того, команда «system vlan <#>» выставляется и на порт профиля vethernet и на порт ethernet-профиля.

Последнее, что я хочу упомянуть — как в Nexus 1000v появляются граничные порты. Я упоминал, что виртуальные интерфейсы не существуют до тех пор пока не подключена VM. После того, как VM назначен профиль порта vethernet внутри ее сетевых настроек и она находится в онлайн-статусе, на Nexus 1000v создается veth-интерфейс. Veth интерфейс представляет собой физический граничный хост-порт на общем физическом свиче. Veth интерфейс наследует конфигурацию родительского порта профиля vethernet.

Профили порта Ethernet привязаны к физическим сетевым адаптерам в vSphere GUI (подробнее об этом читайте в следующей публикации). В рамках Nexus 1000v они показаны как многоуровневые интерфейсы Ethernet: первый — модуль #, второй — номер порта (vmnic). Используя последнее изображение в качестве ссылки, vmnic 3 будет отображаться в 1000v как E3/4. Три потому, что VEM — это модуль 3 и 4 потому, что он является четвертым vmnic в блоке. Тем не менее, мы по прежнему не выполняем какую-либо конфигурацию на этих интерфейсах, все делается в профиле порта.

Окончательная заметку по вопросу о нумерации VEM. VEM всегда будут модули 1 и 2. VEM по умолчанию будут пронумерованы последовательно по мере добавления ESXi хостов и будут помещены онлайн.

Теперь у нас есть хорошая база теории 1000v, мы готовы перейти ко второй публикации в этой серии.

Nexus 1000v Часть 2 из 2 (Установка и работа)

В части 2 этой серии мы пройдем через установку свича Cisco Nexus 1000v и рассмотрим некоторые основные операции.

Я предполагаю что читатель имеет базовые знания в области сетевых технологий VMware и архитектуры и операций 1000v.

Если вы хотели бы сначала изучить теорию 1000v — смотрите часть первую: «Nexus 1000v Часть 1 из 2 (Теория)»

Обратите внимание, что я начинаю с рабочей средой ESXi, включая vCenter. Если вы хотите увидеть, как я все настроил, то смотрите мой пост «Моя VMware Lab».

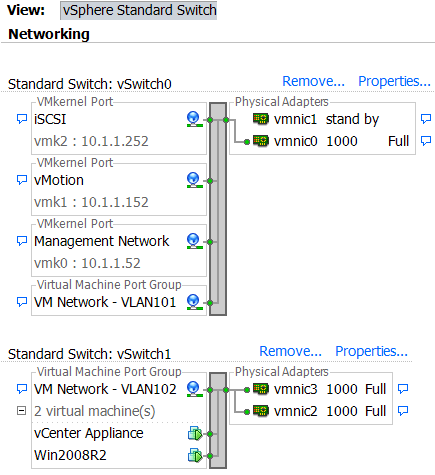

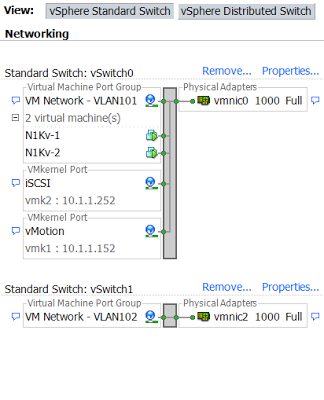

Я начинают с моими сетевыми настройками ESXi на два стандартных vSwitch. vSwitch0 для управления / подключений VMkernel (в том числе одна группа портов VM на управление VLAN) и vSwitch1 — для VM трафика.

У меня есть четыре сетевые карта, vmnic0 и vmnic1 назначены свичу vSwitch0, vmnic2 и vmnic3 — свичу vSwitch1:

Вот некоторые сведения о моей настройке:

VLAN101 - 10.1.1.0/24 и VLAN102 - 10.1.2.0/24

vCenter Appliance - 10.1.2.50

ESXi host- 10.1.1.52

Шлюзы по умолчанию - .254

Моя цель установки заключается в том, чтобы заменить vSwitch1 на Nexus1000v и убедиться, что мой vCenter и VM Win2008R2 по-прежнему пингуют

Установка Nexus 1000v состоит из пяти основных шагов:

- 1. Установить/предоставить VSM виртуальные машины

- 2. Зарегистрировать плагин Nexus 1000v в vCenter

- 3. Настроить связь VSM-vCenter (SVS подключение)

- 4. Установить программное обеспечение VEM на каждый хост ESXi и выставить статус модулей на Online

- 5. Настроить сетевую конфигурацию хоста

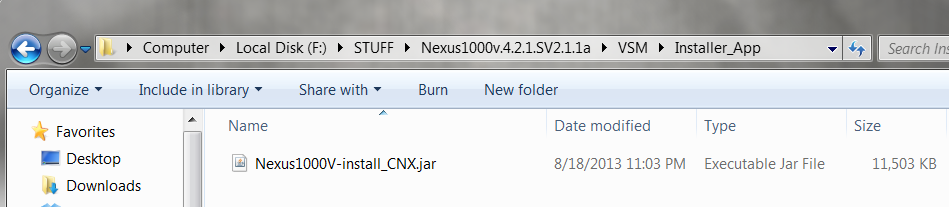

Мы можем либо установить 1000v вручную или с помощью Cisco Java Installer. Поскольку Java Installer — это рекомендуемый способ — именно его я и буду использовать в демонстрации. Java Installer выполняет шаги 1-3, и потенциально 4 (это значит, что мы завершили установку).

Шаги 1-3:

Перейдите в приложения для установки VSM и дважды щелкните значок программы установки:

Выберите полную установку и нажмите на радио-кнопку для пользовательского выбора:

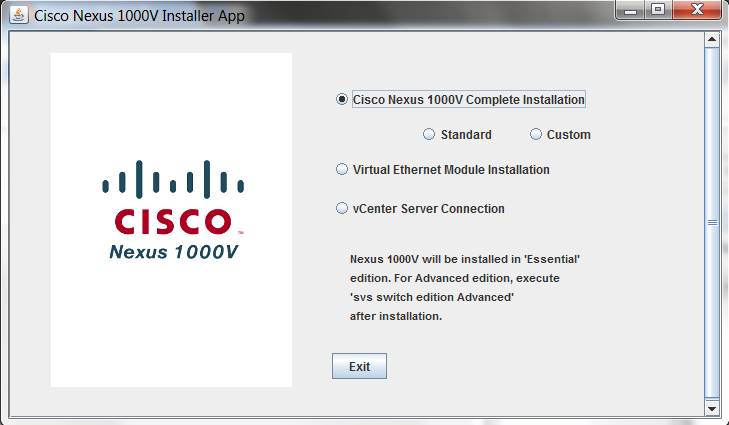

Нажмите Далее, введите vCenter Server IP-адрес и учетные данные и нажмите Далее.

Программа установки установит два VSM не важно у Вас один хост ESXi или несколько. Если у Вас только один — см. информацию для хоста 2. Заполните установщик всей необходимой информацией:

Вы можете самостоятельно заполнить все поля или же выбрать опции по кнопке [Browse], только убедитесь, что если Вы заполняете самостоятельно, то не делаете ошибок. Программа установки не проверяет ввод до тех пор пока вы не покинете экран. Так что если Вы вдруг допустили ошибку, то придется начать заново.

К названию виртуальной машины будет автоматически добавлено " -1" и " -2" для VSM 1 и 2 соответственно.

Выберите файл .OVA из директории установки Nexus. Обратите внимание, что ova с цифрами «1010» в названии предназначен для Nexus 1010.

Мы введем в работу слой 3, что является предпочтительным методом.

При развертывании слоя 3 порт Управления и порт Пакета игнорируются. Я просто назначу их все на управление VLAN.

После того как вы все заполните нажмите [Next]

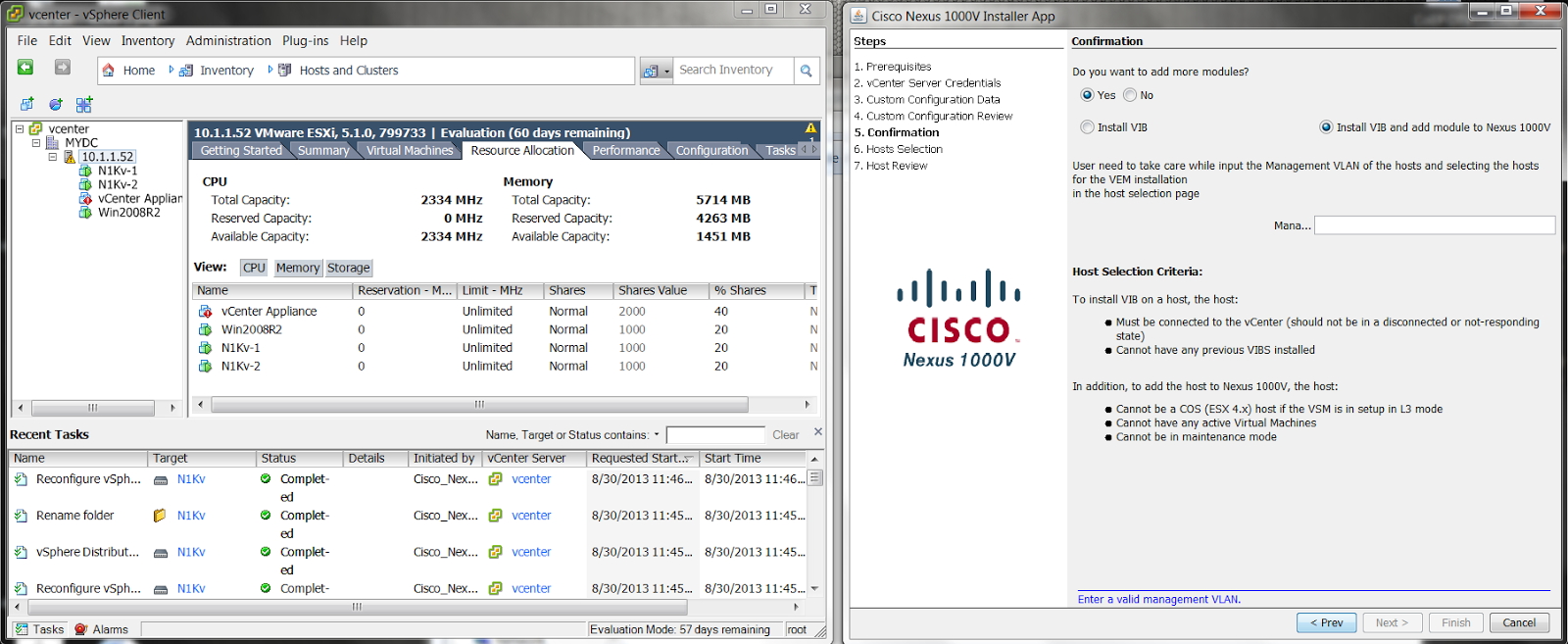

В то время как все двигается самое время расположить окна. Я хотел бы разделить экран на две части, оставив vCenter в левой части экрана, чтобы видеть что происходит в vSphere в то время установщик 1000v делает свое дело.

Вы увидите весь результат на экране. Если все выглядит хорошо, нажмите Далее. Отдохните и позвольте ESXi сотворить свои чудеса во время процесса установки. По завершении установки Вам будет показан экран с подтверждением:

Пока не закрывайте это окно — мы еще раз проверим все уже пройденные на данный момент шаги. Программа установки только что завершила шаги с 1 по 3. Давайте самостоятельно все проверим. Во первых, мы можем видеть на изображении выше, что теперь есть две новые виртуальные машины N1Kv-1 и N1Kv-2. Таким образом мы знаем, что шаг 1 выполнен.

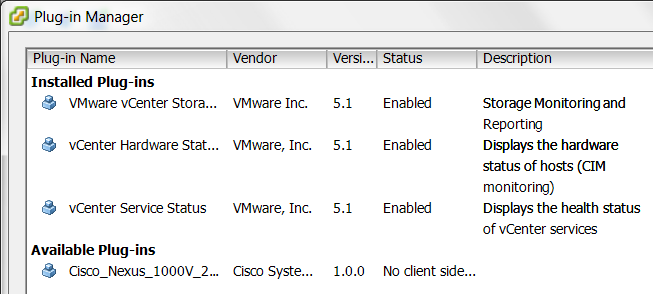

Для проверки шага 2 в vCenter нажмите «Plug-ins» (Плагины) в меню, а затем «Manage Plug-ins» (Управление плагинами).

Мы видим, что для Nexus 1000V был установлен новый плагин. Закройте это окно.

Для проверки шага 3 мы посмотрим и на 1000v и внутрь vSphere.

SSH к 1000v и перейдите в конец файла конфигурации:

N1Kv# sh run

!Command: show running-config

!Time: Sat Aug 31 04:57:40 2013

version 4.2(1)SV2(1.1a)

svs switch edition essential

-----output omitted------

svs-domain

domain id 1

control vlan 1

packet vlan 1

svs mode L3 interface mgmt0

svs connection vcenter

protocol vmware-vim

remote ip address 10.1.2.50 port 80

vmware dvs uuid "8f 99 26 50 21 ce f8 b2-97 7e 6d 49 a2 b6 9f d8" datacenter-name MYDC

admin user n1kUser

max-ports 8192

connect

vservice global type vsg

tcp state-checks invalid-ack

tcp state-checks seq-past-window

no tcp state-checks window-variation

no bypass asa-traffic

vnm-policy-agent

registration-ip 0.0.0.0

shared-secret **********

log-level

N1Kv#

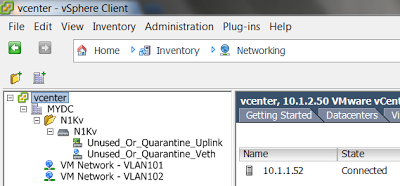

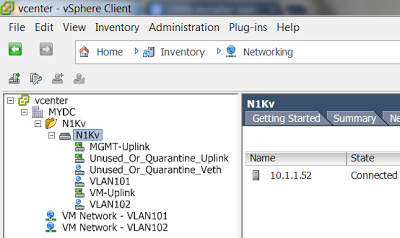

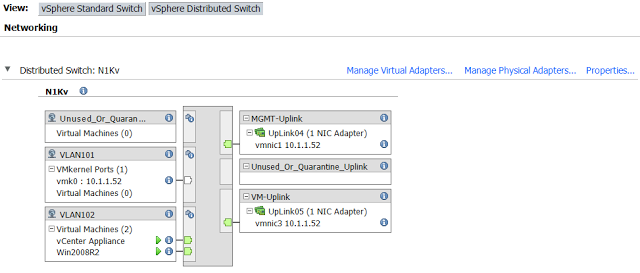

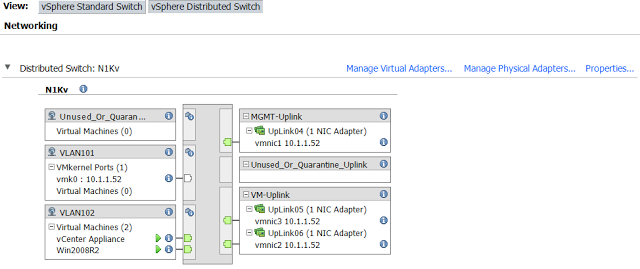

Мы видим здесь конфигурацию «svs connection vcenter». Программа установки настроила для нас подключение. Теперь давайте взглянем в vCenter, чтобы удостовериться что она создала новый

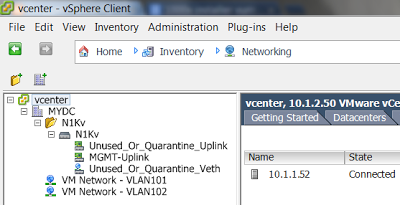

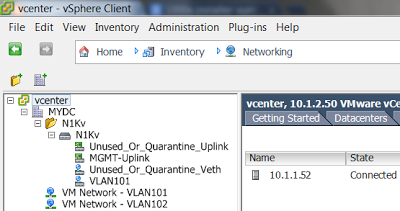

В vCenter нажмите CTRL+SHIFT+N или перейдите в Home->Inventory->Networking.

Разверните дерево для проверки что связь 1000v и

Теперь давайте перейдем к шагу 4 — установке программного обеспечения VEM на ESXi. Если мы посмотрим на нашу программу установки то увидим, что у нас есть опция «установить VIB и добавить модуль». Что такое VIB?

VIB означает vSphere Installation Bundle (Комплект установки vSphere). Это просто кусок программного обеспечения или приложения, который мы можем установить на ESXi. В нашем случае это программное обеспечение Nexus 1000v VEM.

Один нюанс — установщик 1000v работает с VMware Update Manager (VUM). Так как у меня его нет, я не могу использовать программу установки. Так что на данный момент закройте программу установки — мы будем делать все вручную.

Шаг 4.

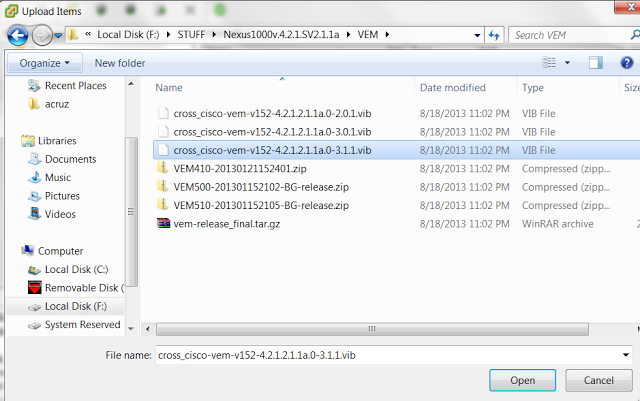

Сначала мы должны скопировать файл VIB на ESX. Вы можете сделать это абсолютно любым способом. SCP работает. Я обычно просто копирую его в мое хранилище данных с помощью vCenter. Чтобы сделать это перейдите в vCenter и нажмите CTRL+SHIFT+H, чтобы попасть обратно в Home->Inventory->Hosts & Clusters. Перейдите в раздел «Configuration» («Настройки»), затем «Storage» («Хранение»). Правой кнопкой мыши щелкните на хранилище данных и нажмите «Browse Datastore.» («Обзор хранилища»). В корневом уровне нажмите кнопку «Upload files to this datastore» («Загрузить файлы в хранилище данных») и щелкните «Upload File» («Загрузить файл»).

Перейдите к VIB файлу, выберите его (я просто выбрал последнюю версию), и нажмите [Open].

Включите SSH и ESXi шелл на хосте ESX и SSH непосредственно на ESXi.

Если вы не знакомы с этим процессом, смотрите: Использование Шелла ESXi в ESXi 5.x

в CLI перейдите в хранилища данных и копирование vib файл в /tmp/ таким образом, мы можем работать с ним.

~ #

~ # ls

altbootbank dev local.tgz proc store usr vmupgrade

bin etc locker productLocker tardisks var

bootbank lib mbr sbin tardisks.noauto vmfs

bootpart.gz lib64 opt scratch tmp vmimages

~ #

~ # cd /vmfs

/vmfs #

/vmfs # ls

devices volumes

/vmfs #

/vmfs # cd volumes

/vmfs/volumes #

/vmfs/volumes # ls

2c12e47f-6088b41c-d660-2d3027a4ae4d 521e1a46-2fa17fa3-cb7d-000c2956018f datastore1 (1)

3d762271-7f5b622d-3cfa-b4a79357ee70 521e1a4d-e203d122-8854-000c2956018f shared

521b4217-727150b0-5b58-000c2908bf12 521e1a4e-8824f799-5681-000c2956018f

/vmfs/volumes #

/vmfs/volumes # cd shared

/vmfs/volumes/521b4217-727150b0-5b58-000c2908bf12 #

/vmfs/volumes/521b4217-727150b0-5b58-000c2908bf12 # ls

6001.18000.080118-1840_amd64fre_Server_en-us-KRMSXFRE_EN_DVD.iso

Cisco_bootbank_cisco-vem-v152-esx_4.2.1.2.1.1a.0-3.1.1.vib

N1Kv-1

N1Kv-2

NSC

Win2008R2_1

cross_cisco-vem-v152-4.2.1.2.1.1a.0-3.1.1.vib

nexus-1000v.4.2.1.SV2.1.1a.iso

vCenter Appliance

/vmfs/volumes/521b4217-727150b0-5b58-000c2908bf12 # cp cross_cisco-vem-v152-4.2.1.2.1.1a.0-3.1.1.vib /tmp/

/vmfs/volumes/521b4217-727150b0-5b58-000c2908bf12 #

Теперь перейдите к /tmp и выполните установку vib:

/vmfs/volumes/521b4217-727150b0-5b58-000c2908bf12 # cd /tmp

/tmp #

/tmp # esxcli software vib install -v /tmp/*.vib

Installation Result

Message: Operation finished successfully.

Reboot Required: false

VIBs Installed: Cisco_bootbank_cisco-vem-v152-esx_4.2.1.2.1.1a.0-3.1.1

VIBs Removed:

VIBs Skipped:

/tmp #

На данный момент мы наполовину завершили шаг 4. Теперь мы должны подключить VEM модуль к сети. Для этого необходимо создать группу порт VMkernel с опцией «capability l3control». Перед этим давайте проверим наш статус на 1000v:

N1Kv# sh mod

Mod Ports Module-Type Model Status

--- ----- -------------------------------- ------------------ ------------

1 0 Virtual Supervisor Module Nexus1000V active *

2 0 Virtual Supervisor Module Nexus1000V ha-standby

Mod Sw Hw

--- ------------------ ------------------------------------------------

1 4.2(1)SV2(1.1a) 0.0

2 4.2(1)SV2(1.1a) 0.0

Mod MAC-Address(es) Serial-Num

--- -------------------------------------- ----------

1 00-19-07-6c-5a-a8 to 00-19-07-6c-62-a8 NA

2 00-19-07-6c-5a-a8 to 00-19-07-6c-62-a8 NA

Mod Server-IP Server-UUID Server-Name

--- --------------- ------------------------------------ --------------------

1 10.1.1.10 NA NA

2 10.1.1.10 NA NA

* this terminal session

N1Kv#

Мы видим два VSM модуля: 1 и 2. В настоящее время ни один VEM не находится онлайн.

Давайте сначала создадим профиль порта ethernet для управления восходящим каналом VLAN.

Но прежде давайте снова переместим наши окна. Я люблю разделять экран, чтобы смотреть что происходит в vCenter в то время как я работаю на 1000v. В vCenter нажмите CTRL+SHIFT+N чтобы вернуться к сети. С открытым окном теперь давайте создадим профиль порта:

N1Kv# conf t

Enter configuration commands, one per line. End with CNTL/Z.

N1Kv(config)# port-profile type ethernet MGMT-Uplink

N1Kv(config-port-prof)# vmware port

N1Kv(config-port-prof)# switchport mode access

N1Kv(config-port-prof)# switchport access vlan 101

N1Kv(config-port-prof)# no shutdown

N1Kv(config-port-prof)# system vlan 101

N1Kv(config-port-prof)# state enable

N1Kv(config-port-prof)#

Как только устанавливаем «state enable» — профиль порта сразу добавляется в vCenter.

Теперь давайте создадим порт профиля vethernet для управления трафиком. На этот порт мы добавим «capability l3control»

N1Kv(config-port-prof)# port-profile type vethernet VLAN101

N1Kv(config-port-prof)# vmware port

N1Kv(config-port-prof)# switchport mode access

N1Kv(config-port-prof)# switchport access vlan 101

N1Kv(config-port-prof)# no shutdown

N1Kv(config-port-prof)# system vlan 101

N1Kv(config-port-prof)# capability l3control

Warning: Port-profile 'VLAN101' is configured with 'capability l3control'. Also configure the corresponding access vlan as a system vlan in:

* Port-profile 'VLAN101'.

* Uplink port-profiles that are configured to carry the vlan

N1Kv(config-port-prof)# 2013 Aug 31 06:56:59 N1Kv %MSP-1-CAP_L3_CONTROL_CONFIGURED: Profile is configured with capability l3control. Also configure the corresponding VLAN as system VLAN in this port-profile and uplink port-profiles that are configured to carry the VLAN to ensure no traffic loss.

N1Kv(config-port-prof)# state enable

N1Kv(config-port-prof)#

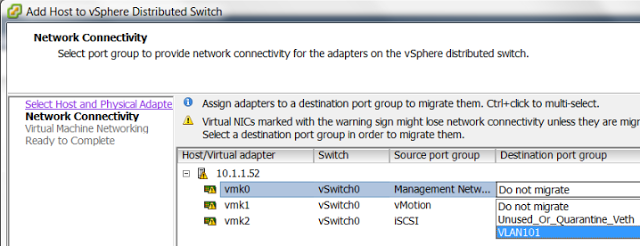

Теперь на заключительном этапе нам необходимо переместить vmnic на порт ethernet-профиля, и переместить одно из наших соединений vmkernel на порт профиля vethernet.

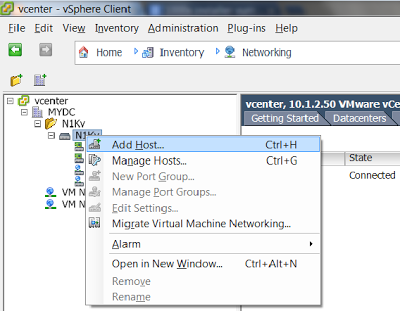

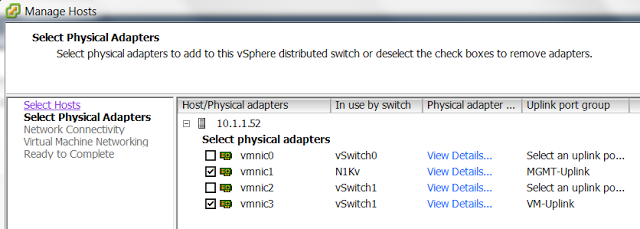

Щелкните правой кнопкой на

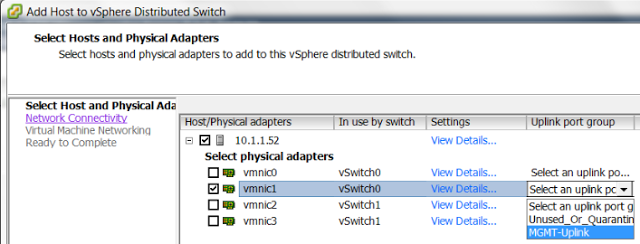

Выберите хост ESXi и vmnic для перемещения. Я выбираю один из двух сетевых адаптеров на свиче vSwitch0, чтобы не потерять связь с ESXi, плюс мой iSCI привязан к vmnic0, поэтому я не могу переместить его прямо сейчас. Справа выберите порт профиля MGMT-Uplink в выпадающем списке и нажмите [Next]:

На следующем экране нужно выбрать порт vmkernel для переноса на 1000v. Я собираюсь использовать VMK0 (Management) и в выпадающем списке я выбираю порт профиля vethernet «VLAN101», затем жму [Next]:

Пока не волнуйтесь по поводу переноса виртуальных машин, нажмите кнопку [Next].

На следующем экране показано визуальное представление

Перейдите обратно к терминалу 1000v и вы должны увидеть:

N1Kv(config-port-prof)# 2013 Aug 31 07:19:28 N1Kv %VEM_MGR-2-VEM_MGR_DETECTED: Host esx2 detected as module 3

2013 Aug 31 07:19:28 N1Kv %VEM_MGR-2-MOD_ONLINE: Module 3 is online

Когда vCenter закончил свою работу, давайте проверим в консоли 1000v:

N1Kv(config-port-prof)# sh mod

Mod Ports Module-Type Model Status

--- ----- -------------------------------- ------------------ ------------

1 0 Virtual Supervisor Module Nexus1000V active *

2 0 Virtual Supervisor Module Nexus1000V ha-standby

3 248 Virtual Ethernet Module NA ok

Mod Sw Hw

--- ------------------ ------------------------------------------------

1 4.2(1)SV2(1.1a) 0.0

2 4.2(1)SV2(1.1a) 0.0

3 4.2(1)SV2(1.1a) VMware ESXi 5.1.0 Releasebuild-799733 (3.1)

Mod MAC-Address(es) Serial-Num

--- -------------------------------------- ----------

1 00-19-07-6c-5a-a8 to 00-19-07-6c-62-a8 NA

2 00-19-07-6c-5a-a8 to 00-19-07-6c-62-a8 NA

3 02-00-0c-00-03-00 to 02-00-0c-00-03-80 NA

Mod Server-IP Server-UUID Server-Name

--- --------------- ------------------------------------ --------------------

1 10.1.1.10 NA NA

2 10.1.1.10 NA NA

3 10.1.1.52 564d33c8-ba44-2cce-c463-65954956018f 10.1.1.52

* this terminal session

N1Kv(config-port-prof)#

Готово. Модуль 3 онлайн, шаг 4 завершен.

Шаг 5.

Теперь давайте создадим наш VM vlan, профиль порта ethernet для загрузки и профиль порта vethernet для наших VM:

N1Kv(config-port-prof)# vlan 102

N1Kv(config-vlan)# name SERVERS

N1Kv(config-vlan)# port-profile type ethernet VM-Uplink

N1Kv(config-port-prof)# vmware port

N1Kv(config-port-prof)# switchport mode access

N1Kv(config-port-prof)# switchport access vlan 102

N1Kv(config-port-prof)# no shutdown

N1Kv(config-port-prof)# state enable

N1Kv(config-port-prof)#

N1Kv(config-port-prof)# port-profile type vethernet VLAN102

N1Kv(config-port-prof)# vmware port

N1Kv(config-port-prof)# switchport mode access

N1Kv(config-port-prof)# switchport access vlan 102

N1Kv(config-port-prof)# no shutdown

N1Kv(config-port-prof)# state enable

N1Kv(config-port-prof)#

Далее нам необходимо переместить физический NIC на порт профиля ethernet VM-Uplink. Чтобы сделать это изменение настолько менее болезненным, насколько это возможно, я перемещу один NIC, мигрирую виртуальные машины, затем перемешу другой NIC.

Теперь, когда хост ESXi уже добавлен на

Выберите один из vmnic-ов на vSwitch1, выберите группу портов VM-Uplink и нажмите [Next]

Нажмите [Next] ([Далее]) еще два раза, затем [Finish] ([Завершить])

Теперь мы готовы к переносу VM. Я собираюсь начать пинговать мой Win2008R2 VM.

Нажмте CTRL+SHIFT+H чтобы вернуться в Home->Inventory->Hosts & Clusters (Главная -> Каталог-> Хосты и Кластеры).

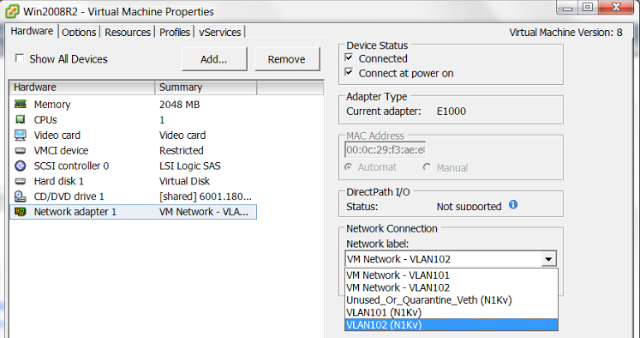

Я правой кнопкой мыши щелкаю на своей VM и перехожу к «Edit Settings» («Редактировать настройки»). Затем я выбираю сеть VLAN102 vethernet порт профиль из выпадающего списка и жму [OK].

C:Usersacruz>ping -t 10.1.2.21

Pinging 10.1.2.21 with 32 bytes of data:

Reply from 10.1.2.21: bytes=32 time=20ms TTL=127

Reply from 10.1.2.21: bytes=32 time=18ms TTL=127

Reply from 10.1.2.21: bytes=32 time=16ms TTL=127

Reply from 10.1.2.21: bytes=32 time=13ms TTL=127

Reply from 10.1.2.21: bytes=32 time=13ms TTL=127

Reply from 10.1.2.21: bytes=32 time=17ms TTL=127

Reply from 10.1.2.21: bytes=32 time=123ms TTL=127

Reply from 10.1.2.21: bytes=32 time=11ms TTL=127

Reply from 10.1.2.21: bytes=32 time=11ms TTL=127

Reply from 10.1.2.21: bytes=32 time=19ms TTL=127

Reply from 10.1.2.21: bytes=32 time=19ms TTL=127

Reply from 10.1.2.21: bytes=32 time=17ms TTL=127

Ping statistics for 10.1.2.21:

Packets: Sent = 16, Received = 16, Lost = 0 (0% loss),

Approximate round trip times in milli-seconds:

Minimum = 11ms, Maximum = 123ms, Average = 33ms

C:Usersacruz>

Мы видим запаздывание, но я ничего не потерял.

Я делаю то же самое для моего прибора vCenter и любых других виртуальных машин до тех пор пока мой стандартный vSwitch 1 не станет пуст:

Наш заключительный шаг в настройке — переместить vmnic2 на 1000v порт профиля VM-Uplink, но прежде чем я это сделаю, давайте настроим порт профия VM-Uplink для распределения нагрузки; в противном случае мы столкнемся с проблемами.

Я не хочу делать какие-либо специфические настройки на своем свиче (LACP), поэтому произведу mac-пиннинг.

N1Kv(config-port-prof)# port-profile VM-Uplink

N1Kv(config-port-prof)# channel-group auto mode on mac-pinning

N1Kv(config-port-prof)#

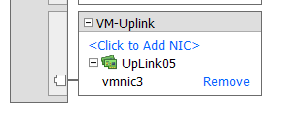

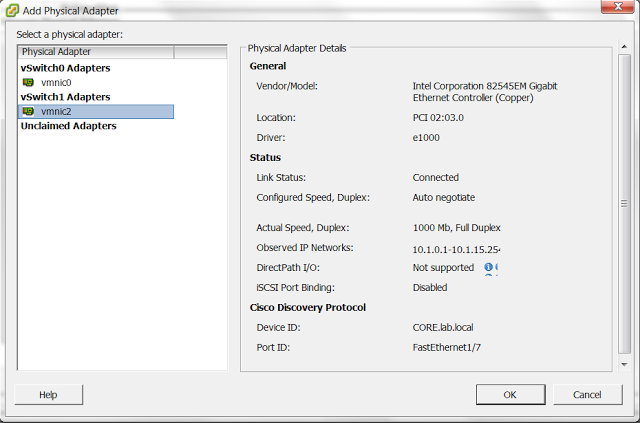

В демонстрационных целях я собираюсь переместить vmnic2 другим способом. Вместо того чтобы нажать правой кнопкой мыши на

Мы видим расположение нашего

Прокрутите вниз к группе портов VM-Uplink и нажмите "" ("<Нажмите чтобы добавить NIC>").

Выберите физический адаптер, который хотите добавить, и нажмите [OK].

Нажмите кнопку [Yes] ([Да]), чтобы убрать vmnic2 со свича vSwitch1 и подключить его к NIKv

Нажмите [OK] и через некоторое время добавится vmnic:

В качестве заключительного шага я собираюсь щелкнуть на стандартный vSwitch и убрать vSwitch 1.

Еще немного полезной информации. В консоли NIKv можно выбрать "show interface status" («показывать состояние интерфейса»), так же как и на обычном свиче и см. все порты 1000v.

Вы можете выбрать "show interface virtual" («показывать виртуальные интерфейсы») и увидите все veth-порты и на каких хостах они находятся.

Вот и все. Наслаждайтесь знакомством с Nexus 1000v.

Автор: chemtech