Сжатие имеет большое значение! «Тяжелые» страницы вредят компании (в процессе передачи данных) и пользователям (в процессе скачивания).

С широким распространением мобильных устройств, особенно в странах с низкой скоростью соединения, уменьшения размера страницы особенно важно для успеха их использования. В этой беседе Colt расскажет о множестве исследований об альтернативных способах сжатия, минификации, внесении изменений в файл и расскажет о данных CSS, JSON, HTML, XML и Javascript в интернете; и как GZIP иногда помогает, и как нередко может помешать. В этом видео вы узнаете о ряде способов для уменьшения размера передачи страниц и об идеях как интегрировать предмет обсуждения в процесс продаж их разработок.

Рубрика «gzip» - 2

GZIP недостаточно. Видео от компании Google с субтитрами на русском

2015-04-13 в 0:20, admin, рубрики: gzip, Веб-разработка, сжатие данныхАлгоритмы сжатия данных без потерь, часть 2

2014-09-03 в 19:11, admin, рубрики: bzip2, gzip, lz77, lz78, lzw, rar, zip, Алгоритмы, крепко жму ваши данныеТехники сжатия данных

Для сжатия данных придумано множество техник. Большинство из них комбинируют несколько принципов сжатия для создания полноценного алгоритма. Даже хорошие принципы, будучи скомбинированы вместе, дают лучший результат. Большинство техник используют принцип энтропийного кодирования, но часто встречаются и другие – кодирование длин серий (Run-Length Encoding) и преобразование Барроуза-Уилера (Burrows-Wheeler Transform).

Читать полностью »

Алгоритмы сжатия данных без потерь

2014-07-26 в 17:58, admin, рубрики: bzip2, gzip, pkzip, rar, winrar, zip, Алгоритмы, алкоголизм, архиваторы, папа не пей, сжатиеЧасть первая – историческая.

Введение

Существующие алгоритмы сжатия данных можно разделить на два больших класса – с потерями, и без. Алгоритмы с потерями обычно применяются для сжатия изображений и аудио. Эти алгоритмы позволяют достичь больших степеней сжатия благодаря избирательной потере качества. Однако, по определению, восстановить первоначальные данные из сжатого результата невозможно.

Алгоритмы сжатия без потерь применяются для уменьшения размера данных, и работают таким образом, что возможно восстановить данные в точности такими, какие они были до сжатия. Они применяются в коммуникациях, архиваторах и некоторых алгоритмах сжатии аудио и графической информации. Далее мы рассмотрим только алгоритмы сжатия без потерь.

Основной принцип алгоритмов сжатия базируется на том, что в любом файле, содержащем неслучайные данные, информация частично повторяется. Используя статистические математические модели можно определить вероятность повторения определённой комбинации символов. После этого можно создать коды, обозначающие выбранные фразы, и назначить самым часто повторяющимся фразам самые короткие коды. Для этого используются разные техники, например: энтропийное кодирование, кодирование повторов, и сжатие при помощи словаря. С их помощью 8-битный символ, или целая строка, могут быть заменены всего лишь несколькими битами, устраняя таким образом излишнюю информацию.

Читать полностью »

Быстрый gzip на javascript для браузера и node.js

2014-03-21 в 12:53, admin, рубрики: browser, gzip, javascript, node.js, метки: browser, gzip, javascript, node.jsНедавно появился проект pako, это порт на яваскрипт известной библиотеки для компрессии и декомпрессии данных — zlib.

Очень любопытен результат тестов.

Читать полностью »

Разархивирование поэзии в замедленном режиме (gzip)

2013-10-25 в 13:08, admin, рубрики: gzip, lz77, Алгоритмы, архиваторы, Демосцена, поэзия, метки: gzip, lz77, архиваторы, поэзияЛюбительница поэзии и программист Джулия Эванс написала красивую программку gzip.jl, которая показывает, как gzip осуществляет декомпрессию текста, сжатого с помощью алгоритма LZ77.

(лучше смотреть без звука)

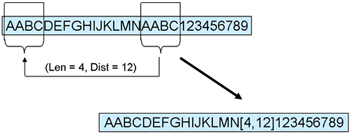

LZ77 использует словарный подход и кодирует совпадения текста. При повторном упоминании одинакового фрагмента алгоритм использует код предыдущего упоминания (красным цветом).

Новый алгоритм Zopfli улучшает сжатие zlib на 3-8%

2013-03-01 в 7:16, admin, рубрики: Deflate, gzip, zlib, Алгоритмы, архиватор, компрессия, Серверная оптимизация, метки: Deflate, gzip, zlib, архиватор, компрессия  Один из сотрудников Google в свободное время разработал новый алгоритм сжатия Zopfli, который на 3,7-8,3% эффективнее, чем стандартная библиотека zlib на максимальном уровне сжатия. Изначально алгоритм создавался для формата сжатия без потерь WebP, но его можно применять и для другого контента.

Один из сотрудников Google в свободное время разработал новый алгоритм сжатия Zopfli, который на 3,7-8,3% эффективнее, чем стандартная библиотека zlib на максимальном уровне сжатия. Изначально алгоритм создавался для формата сжатия без потерь WebP, но его можно применять и для другого контента.

Новый алгоритм является реализацией стандартных алгоритмов Deflate, поэтому он совместим с zlib и gzip, а разархивирование данных уже поддерживается всеми браузерами. Достаточно подключить Zopfli на сервере. Например, его можно использовать с веб-сервером Nginx без изменений в модуле gzip, просто указав новый «прекомпрессор».

Правда, сжатие с помощью Zopfli требует примерно в 100 больше ресурсов, чем zlib, зато декомпрессия в браузере осуществляется с той же скоростью.

Читать полностью »

Протокол Railgun для сжатия трафика

2013-02-27 в 13:25, admin, рубрики: CloudFlare, diff, Google Go, gzip, tcp, оптимизация, протокол, Серверная оптимизация, Сетевые технологии, сжатие трафика, метки: CloudFlare, diff, Google Go, gzip, tcp, оптимизация, протокол, сжатие трафика

CDN-провайдер CloudFlare в прошлом году разработал протокол Railgun для сжатия сетевого трафика. Бинарный протокол, написанный на языке программирования Google Go, передаёт хэши веб-страниц и diff’ы между ними, с поддержкой версионности. После внедрения этой технологии степень сжатия в некоторых случаях достигает 99.6%, что недостижимо с помощью gzip. Сайты 4Chan и Imgur после внедрения Railgun сократили некэшируемый трафик примерно на 50%.

Сейчас компания CloudFlare объявила, что поддержка протокола реализована также у Amazon Web Services и около 30 крупнейших хостинговых компаний. Поставить Railgun теперь как никогда просто: есть плагины для WordPress, Joomla, Drupal и прочих CMS, выпущены пакеты для большинства популярных дистрибутивов Linux и BSD.

Читать полностью »

Краткое сравнение xz и традиционных утилит сжатия

2013-01-31 в 9:02, admin, рубрики: bzip2, gzip, linux, lzma, метки: bzip2, gzip, lzmaРешил сравнить разные утилиты для сжатия данных.

У меня есть задача: делать mysqldump большой базы с однотипными данными (статистика посещения).

Отрезал гигабайт от дампа, пожал xz с разными уровнями сжатия, а также gzip и bzip2.

xz у меня коробочный из CentOS x86_64 (4.999.9beta)

Сжатие данных / [Из песочницы] Сравнение программ сжатия в применении к передаче больших объёмов данных

2012-02-28 в 9:40, admin, рубрики: bzip2, gzip, передача данных, сжатие, метки: bzip2, gzip, передача данных, сжатие Всё началось с простой задачи: скачать по 100-мегабитной сети большой объём данных с помощью rsync. Возник вопрос, можно ли ускорить этот процесс. Утилита top показала, что на сервере-источнике шифрование занимает не более 10 процентов процессора, поэтому было решено что можно попробовать сжатие данных. Тогда мне было неясно, будет ли хватать производительности процессора для упаковки данных с необходимой скоростью, поэтому была выставлена самая маленькая степень сжатия, а именно использовался флаг --compress-level=1 для rsync. Оказалось, что загрузка процессора не превысила 65%, то есть производительности процессора хватило, при этомЧитать полностью »