“Записи” с поверхности головного создают для ученых небывалые идеи о том, как парализованным людям с помощью головного

Может ли парализованный человек, который не способен говорить, например, как физик Стивен Хокинг, использовать имплантант

Сегодня это главная цель постоянно развивающихся исследований университетов США, которые уже более пяти лет доказывают, что записывающие устройства, помещенные под череп человека могут детектировать мозговую деятельность, связанную с человеческим разговором.

Пока полученные результаты являются предварительными, Эдвард Чанг, нейрохирург из Университета Калифорнии, Сан-Франциско, говорит, что он работает над построением беспроводного нейрокомпьютерного интерфейса, который может переводить сигналы

Работы по созданию речевого протеза опираются на успех в проведенных экспериментах: парализованные люди, выступающие как добровольцы, использовали имплантанты

Теперь команда Чанга пытается повторить то же самое для способности человека разговаривать. Эта задача намного сложнее, отчасти потому, что в совокупности человеческий язык является уникальным именно для него и эта технология не может быть с легкостью протестирована, например, на животных.

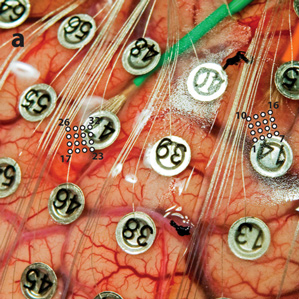

В своем университете, Чанг проводит эксперименты по речи совместно с операциями на головной

Чанг изучает активность головного

Идея состоит в том, чтобы записать электрическую активность в двигательной области коры головного

Одно из самых страшных последствий заболевания, как боковой (латеральный) амиотрофический склероз (БАС), так это то, как распространяется паралич, люди теряют не только способность двигаться, но и способность говорить. Некоторые пациенты БАС используют устройства, которые позволяют использовать остаточную способность к общению. В случае Хокинга, он использует программное обеспечение, которое позволяет ему очень медленно по слогам произносить слова, сокращая мышцы его щеки. Другие пациенты используют устройства отслеживания движения глаза (“ай-трекеры”), чтобы управлять компьютерной мышью.

Идея использования нейрокомпьютерного интерфейса для достижения практически разговорной речи была предложена еще раньше, компанию, которая с 1980 года тестирует технологию, которая использует один электрод, чтобы записывать напрямую внутри человеческого

Другое исследование, которое в этом году опубликовал Марк Слуцкий с Северо-Западного университета — он сделал попытку расшифровать сигналы в двигательной области коры головного

Слуцкий говорит, что пока эта точность может показаться очень низкой, но она была достигнута с относительно небольшой выборкой слов, сказанных в ограниченное количество времени. «Мы ожидаем, достижения гораздо лучших результатов декодирования в будущем», говорит он. Система распознавания речи также может помочь понять, какие слова люди пытаются сказать, говорят ученые.

Статью подготовила команда Telebreeze Team

Наша страница на Facebook и Twitter

Автор: ChristinaGass