С начала работы над Fetchee у нас был план предложить решение для парсинга данных о товарах интернет-магазинов корпоративным клиентов и стартап-сообществу. Отзывы, которые мы собрали за время работы, говорили о его потенциальной востребованности и подвели к запуску нового продукта, который поможет разработчикам быстро создавать собственные приложения, на основе одной из главных функций Fetchee — сбора eCommerce данных и слежения за ценами в любых интернет-магазинах мира.

Читать полностью »

Рубрика «парсинг контента» - 2

Product API от Fetchee: автоматический парсинг товаров интернет-магазинов

2016-11-11 в 7:56, admin, рубрики: api, data mining, json, Блог компании Fetchee, интернет-магазины, парсинг контента, слежение за ценамиКак мы боролись с парсерами

2016-03-04 в 6:56, admin, рубрики: centos-admin.ru, Блог компании centos-admin.ru, парсинг контента

Ключевые моменты:

* Реализация скрипта для проверки PTR посетителей;

* Конфигурирование nginx в IfIsEvil-style с ветвлениями map;

* Имена location в переменных map;

* Управление ветвлением через try_files /nonexist $map_var.

Многие высоконагруженные и популярные сайты страдают от того, что кроме живых посетителей их посещают разнообразные парсеры, боты и прочие автоматические сканеры, которые не несут никакого полезного эффекта, а только создают паразитный трафик и нагрузку на, и без того, нагруженную систему. В данном случае я не имею виду поисковых ботов, которые хоть и зачастую нагружают проект не нормировано, но просто необходимы любому проекту.

Один из наших клиентов регулярно испытывал проблему лавинообразного роста нагрузки в определенное время суток. Периодически, раз в сутки и чаще происходили наплывы посещений со значительным ростом LA на серверах. Было принято решение построить защиту от паразитного трафика.

Как программисты ищут квартиры

2015-02-13 в 11:34, admin, рубрики: open source, python, недвижимость, ненормальное программирование, парсинг контента

На самом деле все происходит не так...

Базы знаний. Часть 1 — введение

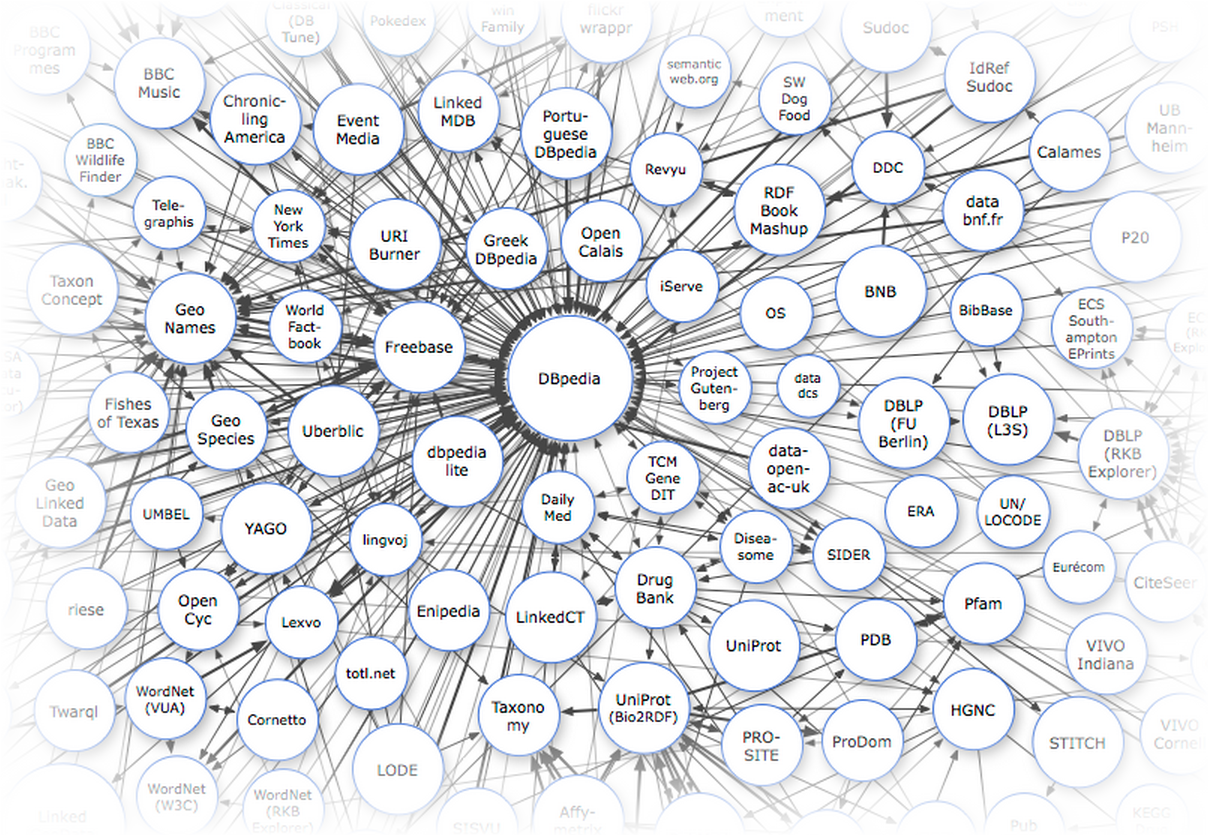

2013-10-16 в 9:31, admin, рубрики: api, freebase, Linked data, owl, rdf, semantic web, sparql, онтологии, открытые данные, парсеры, парсинг контента, Семантическая Сеть, метки: api, freebase, Linked data, owl, rdf, semantic web, sparql, онтологии, открытые данные, парсеры, парсинг контента Одной из причин причина слабого использования Linked Data-баз знаний в обычных, ненаучных приложениях является то, что мы не привыкли придумывать юзкейсы, видя перед собой только данные. Трудно спорить с тем, что сейчас в России производится крайне мало взаимосвязанных данных. Однако это не значит, что разработчик, создающий приложение для русскоязычной аудитории совсем уж отрезан от мира семантического веба: кое-что всё-таки у нас есть.

Основными источниками данных для нас являются международные базы знаний, включающие русскоязычный контент: DBpedia, Freebase и Wikidata. В первую очередь это справочные, лингвистические и энциклопедические данные. Каждый раз когда вам в голову приходит мысль распарсить кусочек википедии или викисловаря — ущипните себя как следует и вспомните о том, что всё, что хранится в категориях, инфобоксах или таблицах, уже распарсено и доступно через API с помощью SPARQL или MQL-интерфейса.

Я попробую привести несколько примеров полезных энциклопедических данных, которые вы не найдете нигде, кроме Linked Data.

Эта статья — первая из цикла Базы знаний. Следите за обновлениями.

- Часть 1 — Введение

- Часть 2 — Freebase: делаем запросы к Google Knowledge Graph

- Часть 3 — Dbpedia — ядро мира Linked Data

- Часть 4 — Wikidata — семантическая википедия

История одного парсера

2013-07-14 в 14:00, admin, рубрики: 1С-Битрикс, csv, php, битрикс, парсинг контента, Песочница, метки: csv, PHP, битрикс, парсинг контентаCайт без доступов

По долгу службы на мои плечи легла задача перенести пачку(>100) статей с одного сайта заказчика на другой. Одно из условий было — переносить не только название и текст статьи, но и метатеги keywords и description. В итоге статьи должны были перекочевать в инфоблок битрикса.

В силу реализации сайта-источника на неком конструкторе сайтов сделать sql dump никак не представлялось возможным, т.к. все, что позволяла админка сего конструктора — выбрать шаблон, привязать домен и, как бонус, добавлять/редактировать контент. Не было там ни phpMyAdmin, ни ftp, ни какого-либо инструмента, позволяющего легким движением руки осуществить задуманное.

Читать полностью »

Convextra — универсальный парсер контента

2013-05-14 в 8:09, admin, рубрики: convextra, data mining, парсинг контента, я пиарюсь, метки: convextra, data mining, parser, парсинг контентаПару месяцев назад на хабре уже проскальзывало упоминание о сервисе извлечения данных с веб-страниц Convextra, который позволяет парсить даже сложные структуры данных буквально в 2-3 клика. Несмотря на то, что на момент написания той статьи сервис находился в альфа стадии и больше глючил, чем работал, аудитория хабра тепло восприняла идею и мы получили много полезных отзывов, предложений и багрепортов. Поэтому хочется рассказать о том, что из предложенного вами и в каком виде удалось реализовать за это время.

Как написать парсер страниц за 5 минут

2012-08-01 в 17:17, admin, рубрики: .net, data mining, html, парсинг контента, метки: .net, c++, html, парсинг контентаЗачем?

У меня возникла необходимость построить графики статистики игроков c iccup.com

Когда разбирался с библиотекой искал на хабре, но ничего подходящего мне не нашел.

Поэтому попутно написал эту статью.

Технические детали

Никакого API так нету, и не будет в ближайшие время. Поэтому выбор способов получения данных не велик, придется парсить страницы.

Я решил делать это с помощью библиотекой htmlagilitypack. Она довольно проста и удобна. XPath поиск занимает около 100мс.

Читать полностью »

Электронная библиотека для PocketBook: автоматическая обработка

2012-05-09 в 9:45, admin, рубрики: php, pocketbook, каталогизация, обработка данных, парсинг контента, электронные книги, метки: PHP, pocketbook, каталогизация, обработка данных, парсинг контента, электронные книги Наверное каждому электрочитателю хотелось бы всю свою коллекцию книг содержать прямо на электронной книге-читалке, и при этом, не смотря на общую тормознутость устройства, иметь удобную навигацию.

Зачастую в электронной книге проблематично содержать сотни и тысячи книжек: либо аппарат долго тупит, считывая информацию о каждой книге из ее внутренностей, либо вручную поддерживать коллекцию с разбивкой по каталогам — тот еще геморрой.

Читать полностью »