Команда AI for Devs подготовила перевод статьи о том, в каком формате лучше всего передавать таблицы LLM. Исследование охватило 11 популярных форматов — от CSV и JSON до YAML и Markdown. Результаты неожиданны: разница в точности достигает 16 процентных пунктов, а выбор формата напрямую влияет на стоимость инференса и стабильность RAG-пайплайнов.

Рубрика «csv»

Какой табличный формат LLM понимают лучше всего? (Результаты по 11 форматам)

2025-10-13 в 12:32, admin, рубрики: AI, csv, gpt-4, json, large language model, llms, markdown, OpenAI, XML, yamlПуск Беспроводной CLI на Микроконтроллере

2025-07-22 в 19:42, admin, рубрики: at-commands, AT-команды, cli, csv, esp-01, uart, wifi, wirelessИной раз возникает такая ситуация, что надо получить информационный доступ к устройству, которое висит под потолком или примонтированно за окном. Конструктив не позволяет протянуть провод через дверь или за окно. Очевидно, что в таких случаях надо наладить какой-то беспроводной интерфейс. Варианты могут быть такие: IR, LoRa, GFSK, BLE, UWB, WiFi.

В этом тексте я расскажу, как запустить беспроводную консоль на микроконтроллере.

Постановка задачи

Соединить микроконтроллер и ESP-01 трансивер. Запустить TCP сервер. Подключиться через PuTTY. Организовать беспроводную консоль.

Определения

алгоритм - Читать полностью »

Как один глупый Bash-скрипт сэкономил нам 100 часов ручной работы

2025-07-18 в 15:17, admin, рубрики: awk, bash, csv, devops, linux, shell, автоматизация, обработка, системное администрирование, скриптЕсть некоторая ирония в том, как простые инструменты решают сложные задачи. Пока технические форумы гудят от обсуждений Kubernetes, пайплайнов машинного обучения и микросервисных архитектур, я хочу на минуту отвлечься и поговорить о чем-то до безобразия простом: Bash-скрипте. Не особенно изящном. Без функций. Без параметров. Без проверок корректности. Просто линейный, безжалостно прагматичный shell-скрипт, который за год сэкономил нам несколько недель работы.

Интегрируем pandas с электронными таблицами: три способа

2024-08-17 в 11:15, admin, рубрики: csv, Excel, google spreadsheets, pandas, pandas dataframe, python, биоинформатикаОткрываем и сохраняем файлы Excel в pandas

Pandas идеально подходит для работы с табличными данными – он способен открывать файлы Excel и проводить внутри преобразования. Более того, сохранить датафрейм тоже можно в файл Excel. Это делает удобной интеграцию pandas с офисным пакетом: результаты можно сразу красиво оформить для выступления на конференции или передачи коллегам, которые занимаются только “мокрой” биологией и не работают с инструментами data science.

Давайте посмотрим, как это делается. Если мы импортировали pandas под именем pd:

import pandas as pdто считать фрейм данных из файла Excel можно следующим образом:Читать полностью »

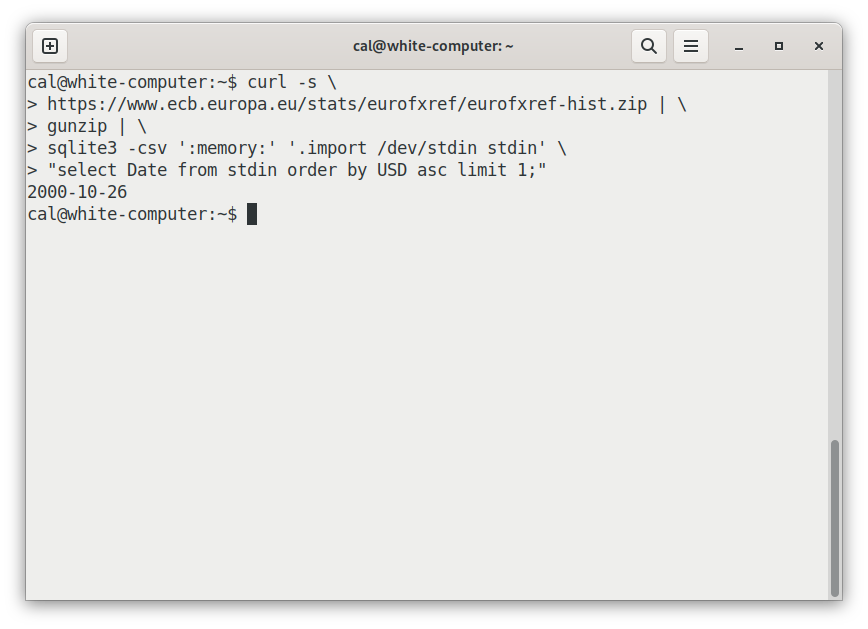

Почему мой любимый API — это файл zip на сайте Европейского центрального банка

2023-09-16 в 10:16, admin, рубрики: csv, zip, командная строка, обмен данными, преобразование данных

Когда был максимальный курс доллара к евро?

Вот небольшая программа, вычисляющая это:

curl -s https://www.ecb.europa.eu/stats/eurofxref/eurofxref-hist.zip

| gunzip

| sqlite3 -csv ':memory:' '.import /dev/stdin stdin'

"select Date from stdin order by USD asc limit 1;"Результат: 2000-10-26. (Можете попробовать запустить её самостоятельно.)

Как это работает:

Excel очень крут

2022-09-26 в 10:53, admin, рубрики: apl, csv, Excel, Google Sheets, INFOLUST, json, Miran.ru, office 365, XML, Блог компании Дата-центр «Миран», дата-центр Миран, игра жизнь, импорт из PDF, Программирование, Софт, функциональное программированиеВ прошлом выпуске рассылки Уейн игрался с языком программирования J, который работает как арифметический калькулятор в консоли, и пошутил по ходу дела:

Я столько времени трачу на интерактивные вычисления, что даже не мог оторваться от этих функций… Может, мне просто хорошенько освоить Excel?

Пошутив про офисную программу, Хилл Уейн решил действительно посмотреть на неё поближе… и был поражён увиденным: «Это как найти сундук с сокровищами у себя на чердаке», — пишет он. И перечисляет некоторые новые функции современного Excel, о которых мало кто знает.

Читать полностью »

Кто, как и на чем исследовал мировой океан — разбираем базы NOAA

2020-03-25 в 4:14, admin, рубрики: cruise, csv, data mining, NOAA, ocean exploration, WOD, world ocean database, база данных мирового океана, будущее здесь, морские экспедиции, Научно-популярное, научный флот, Производство и разработка электроники, транспортПриветствую вас, глубокоуважаемые!

«Выбросило меня тогда из кабины, в тысячный раз подумал он. Ударило обо что-то головой, так я больше и не оправился…» (С) АБС, «Улитка на склоне»

Пока коронaвирус бороздит просторы планеты, предлагаю с одного ракурса взглянуть, как мы (человечество) исследовали мировой океан.

По долгу работы мне нужны данные по температуре и солености воды с максимальным покрытием по территории, и единственное известное мне место, где такие данные можно взять совершенно свободно — базы данных Национального управления океанических и атмосферных исследований США.

В этот раз я ради интереса решил не ограничиваться необходимым и проявил определенную жадность.

Кто, как, когда и на чем исследовал мировой океан: список экспедиций с 1772 по 2018 годы с разбивкой по странам, интересные подробности и небольшой статистический анализ — под катом!

Часто при решении задач системной интеграции требуется представить некоторый объем данных в том или ином формате. При этом потребителем данных может быть кто угодно, а вот источником почти всегда является корпоративная база данных. К примеру, производитель может требовать у поставщика периодические отчеты о движении своих товаров в формате XLSX или XML, etc.

Существует множество инструментальных средств для преобразования данных в различные форматы, и возможность их использования зависит от принятого на предприятии технологического стека и программной архитектуры. При этом всегда хочется, чтобы цепочка, состоящая из различных библиотек, фреймворков, системных слоев, используемых для преобразования исходных данных, была как можно короче. Это бы сократило временные затраты на разработку решения и повысило его производительную эффективность.

Если принять, что по факту в корне процесса выборки данных лежит SQL-запрос, то в идеале цепочку преобразований хотелось бы видеть такой:

где

Для Oracle PL/SQL существует ряд встроенных и сторонних пакетов, которые реализуют подобную функциональность. Это DBMS_XMLGEN, DBMS_XMLQUERY, AS_XLSX, PL/JSON и другие.

Однако, когда встал вопрос о преобразовании данных в формат CSV, готовых решений почему-то не нашлось. Пришлось делать самому, далее будет показано, как.Читать полностью »

Потоки Redis как чистая структура данных

2019-03-23 в 18:02, admin, рубрики: csv, listpack, redis, Streams, потоки, Программирование, структура данныхНовая структура данных Redis 5 под названием «потоки» (streams) вызвала живой интерес в сообществе. Как-нибудь я поговорю с теми, кто использует потоки в продакшне, и напишу об этом. Но сейчас хочу рассмотреть немного другую тему. Мне начинает казаться, что многие представляют потоки неким сюрреалистичным инструментом для решения ужасно трудных задач. Действительно, эта структура данных *также* осуществляет обмен сообщениями, но будет невероятным упрощением считать, что функциональность Redis Streams ограничена только этим.

Потоки — потрясающий шаблон и «ментальная модель», которую можно с большим успехом применить в проектировании систем, но на самом деле потоки, как и большинство структур данных Redis, являются более общей структурой и могут использоваться для кучи других задач. В этой статье мы представим потоки как чистую структуру данных, полностью игнорируя блокирующие операции, группы получателей и всю остальную функциональность обмена сообщениями.

Читать полностью »

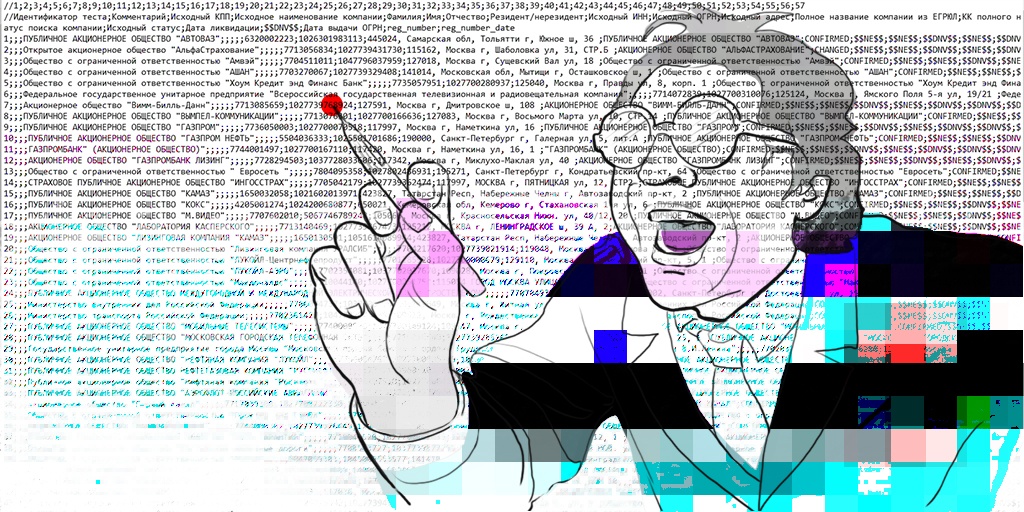

Редактируем CSV-файлы, чтобы не сломать данные

2018-12-13 в 12:00, admin, рубрики: csv, csv файлы, Excel, IT-стандарты, libreoffice, open office, Блог компании HFLabs, данные, информационная безопасность, редактирование csv, Софт, хранение данных

Продукты HFLabs в промышленных объемах обрабатывают данные: адреса, ФИО, реквизиты компаний и еще вагон всего. Естественно, тестировщики ежедневно с этими данными имеют дело: обновляют тест-кейсы, изучают результаты очистки. Часто заказчики дают «живую» базу, чтобы тестировщик настроил сервис под нее.

Первое, чему мы учим новых QA — сохранять данные в первозданном виде. Все по заветам: «Не навреди». В статье я расскажу, как аккуратно работать с CSV-файлами в Excel и Open Office. Советы помогут ничего не испортить, сохранить информацию после редактирования и в целом чувствовать себя увереннее.

Материал базовый, профессионалы совершенно точно заскучают.

Читать полностью »