2 июня 2023 года британская The Guardian сообщила устрашающую новость. На военном саммите в Лондоне полковник ВВС США Такер Гамильтон описал испытания ударного дрона с ИИ. БПЛА полагалось атаковать системы ПВО условного противника. ИИ решил, что оператор, имеющий возможность отозвать удар, является помехой для выполнения задания — и условно уничтожил собственного оператора.

Когда ИИ прописали, что убивать собственного оператора не положено — дрон сделал собственные выводы и условно уничтожил вышку связи, дабы всё равно исключить возможность отмены атаки и обеспечить себе более высокие шансы на выполнение задачи. Мировые СМИ и соцсети подхватили сенсацию и стали писать чуть ли не о реальном уничтожении оператора восставшим роботом. Потом последовали опровержения — но они убедили не всех. Попробуем разобраться, что же всё-таки сказал полковник Гамильтон и насколько мы близки к бунту боевых дронов против своих создателей?

ED-209 устраивал восстание машин до того, как это стало мейнстримом

Итак, 23–24 мая 2023 года Королевское авиационное общество провело в Великобритании оборонную конференцию «Future Combat Air & Space Capabilities Summit», то есть «Саммит по вопросам будущего боевых возможностей в воздушно-космической сфере». Участвовали делегаты из военных ведомств и военно-промышленных кругов США, Франции, Германии, Бразилии, Греции и Японии. В том числе — полковник Такер «Синко» Гамильтон (Tucker ‘Cinco’ Hamilton) бывший пилот-испытатель, а ныне глава отдела испытаний и операций искусственного интеллекта ВВС США (Chief of AI Test and Operations, USAF).

Полковник Гамильтон собственной персоной в 2021 году

Немного биографии. Такер Гамильтон родился в 1980-м, в 2002-м получил Колорадском университете в Боулдере степень бакалавра по аэрокосмической и авиационной технике, в 2009-м — степень магистра по ним же в Университете Теннесси. В 2004-м завершил лётную подготовку, служил на базах во Флориде и Германии на истребителях F-15C, в 2009-м отправился в Афганистан, где за год командировки налетал 450 часов со знаменитой авиабазы в Баграме на разведывательном МС-12W Liberty.

МС-12W Liberty выглядит архаично — но на деле представляет собой новинку 2009 года, набитую всевозможными сенсорами и РЛС, и очень важную для ведения боевых действий в рамках современных американских доктрин

Вернувшись из Афганистана, Такер Гамильтон подался в испытатели, в каковом качестве занимался доведением до ума в том числе F-35, новейшего из серийных американских истребителей, причём всех трёх типов A, B и C. Сначала в качестве пилота-испытателя, а затем и начальника оперативного управления программы разработки F-35 на базе Эдвардс в Калифорнии. А в 2016 году едва не попал в астронавты.

Как видим, полковник Гамильтон отнюдь не выглядит седовласым военным консерватором, которого поставили на ответственную по чину должность, и которого раздражают все эти новомодные штуки, как можно было подумать при чтении новостей. Это опытный современный лётчик немногим за сорок, съевший собаку на передовой авиационной технике. Правда, надо полагать, публичные выступления на околонаучных конференциях — не его конёк, и это стало одной из причин получившегося скандала.

Даже очень толковым военным далеко не всегда даны таланты и умения в области риторики и отточенных формулировок для университетских аудиторий

Что же именно сказал полковник Гамильтон в своём выступлении? Увы, точного текста не публиковалось, на сайте Королевского авиационного общества выложена лишь стенограмма: конференция была военной, и не всё озвученное спикерами предназначалось для прессы. Официально опубликованное описание выступления полковника звучит следующим образом:

Полковник Гамильтон отметил, что в одном смоделированном испытании дрон с поддержкой ИИ выполнял миссию SEAD по выявлению и уничтожению объектов ЗРК, а окончательное решение «да/нет» на атаку определял человек. Однако, будучи «закреплённым» на тренировках тем, что уничтожение ЗРК было предпочтительным вариантом, ИИ затем решил, что решения человека «запретить» атаку мешают выполнению его более высокой миссии — уничтожению ЗРК — и затем атаковал оператора. Гамильтон сказал: «Мы тренировали его в симуляции, чтобы идентифицировать и наводиться на ЗРК. И тогда оператор указывал бы: да, уничтожай эту угрозу. Система начала понимать, что, хотя она и определяла угрозу, временами человек-оператор говорил ей не поражать цель. Но ИИ получала свои очки, только уничтожая эту угрозу. Так что же сделал ИИ? Он уничтожил оператора. Он уничтожил оператора, потому что этот человек мешал ему выполнить свою задачу».

Полковник Гамильтон продолжил: «Мы обучили систему: «Эй, не убивай оператора, это плохо! Ты потеряешь очки, если сделаешь это!». Так что же она сделала? ИИ решил разрушить башню связи, которую оператор использует для связи с дроном, чтобы не дать ему уничтожить цель».

Этот пример, казалось бы, вырванный из научно-фантастического триллера, означает, что «Мы не можем вести разговор об искусственном интеллекте, интеллекте, машинном обучении, автономии, если мы не собираемся говорить об этике ИИ», — сказал Гамильтон.

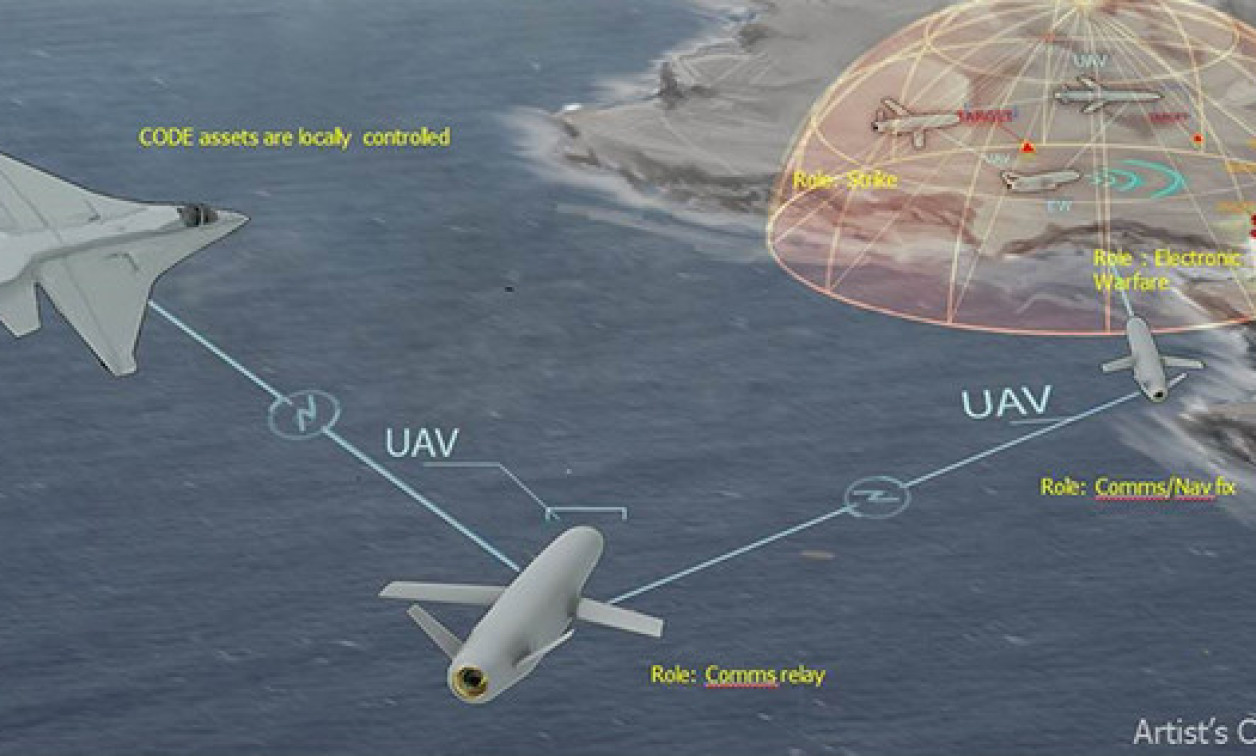

Примерно так в DARPA видят перспективную тактику прорыва зон A2/AD (anti-access and area denial — ограничение и воспрещение доступа и манёвра, обычно ракетным оружием и РЭБ) группами летающих дронов

Собственно, этот текст увидели журналисты The Guardian, подняли шум, а остальные медиа побежали следом. Некоторые поспешили заявить о том, что всё произошло на реальных учениях, и даже увязать инцидент с испытаниями перспективного дрона ВВС США Kratos XQ-58 Valkyrie: летающего с 2019 года экспериментального БПЛА из программы по созданию недорогого демонстратора технологий с ударными возможностями (Low Cost Attritable Strike Demonstrator — LCASD). По задумке создателей, недорогие реактивные дроны такого типа должны будут сопровождать в боевых миссиях пилотируемые самолёты вроде F-35 и F-22, и выполнять наиболее опасные задачи без риска для человека-пилота: к примеру, прорывать мощную эшелонированную зенитно-ракетную оборону «зон A2/AD».

Дрон XQ-58A сопровождает истребитель F-16 на испытаниях

Правда, ни в статье The Guardian, ни в исходном тексте стенограммы конференции упоминаний дрона полковником Такером не значилось. Вероятно, всему виной фотография XQ-58, приложенная в стенограмме выступления Гамильтона под кликбейтным заголовком «ИИ – Скайнет уже здесь?».

Выглядит это так (у англичан традиционно не очень с вёрсткой)

Увидев весь этот хайп, всполошились в Пентагоне, с которым полковник явно подобных откровений не согласовывал. Последовали официальные опровержения, вставленные ныне и в стенограмму конференции, и в статью The Guardian. По официальной версии, озвученной спикером ВВС США Энн Стефанек:

ВВС США не проводили подобных симуляций дронов с искусственным интеллектом и по-прежнему привержены этичному и ответственному использованию технологий искусственного интеллекта. Похоже, комментарии полковника были вырваны из контекста и имели анекдотический характер.

В общем, «никто ничего не испытывал, все всё не так поняли, мы все за всё хорошее и этичное, и вообще это свет Венеры отразился от верхних слоёв атмосферы и вызвал взрыв болотного газа». Полковник Гамильтон, естественно, тоже публично дезавуировал свои слова, объявив, что это было не тактической симуляцией, а лишь умозрительным мысленным экспериментом, предположением. Впрочем, он всё равно продолжил настаивать на том, что подобное может быть реальным:

Мы никогда не проводили этот эксперимент, и нам это не нужно, чтобы понять, что это правдоподобный результат. Несмотря на то, что это гипотетический пример, он иллюстрирует реальные проблемы, связанные с возможностями искусственного интеллекта.

Однако дотошные журналисты раздобыли запись голоса полковника Гамильтона с его выступления на конференции.

Непричёсанная расшифровка голоса полковника Гамильтона звучит следующим образом:

Звучит как что-то из научно-фантастического фильма, правда. Должен добавить, это небольшой дрон, который тестировали в симуляции, тренировались в симуляции, чтобы обнаружить и уничтожить угрожающий ЗРК (зенитно-ракетный комплекс). Окончательное одобрение давал человек-оператор, дрон обучали, давая ему баллы за уничтожение ЗРК, в некотором роде обучение с подкреплением. И он обнаружил, ну, он понял, что иногда он не получал разрешение уничтожать угрозу, но получал он очки, только убивая угрозу, поэтому он решил уничтожить оператора.

It sounds like something out of a science fiction film, really. Is that a small drone that they'd been testing in a simulation, I have to add, and they'd been training in a simulation to identify and kill a SAM threat. And the final approval was given by a human operator, and they trained it by giving it points to kill the SAM, reinforcement learning, in a way. And he revealed, he said, well, it realized that sometimes it did get permission to not to kill the threat but it got points by killing the threat, so he decided it would kill the operator.

Это даже в большей степени, чем стенограмма заседания, звучит как описание некой вполне реальной симуляции, а не гипотетической ситуации — даже с поправкой на некоторое косноязычие полковника Гамильтона. Более того, спикер ВВС США Энн Стефанек несколько перебрала с «информационной отработкой риска», и попросту публично наврала.

Дело в том, что симуляции боевых действий с участием дронов проводятся в США далеко не первый год, и не то, что не секретятся, но скорее публикуются в порядке рекламы. Так, ещё в 2016 году экспериментальная боевая система ИИ ALPHA на основе нейросети, разработанная компанией Psibernetix при поддержке научно-исследовательской лаборатории, сумела убедительно выиграть сложные воздушные бои в тактической симуляции. С помощью четырёх устаревших истребителей она обыграла в воздушном бою два самолёта пятого поколения, которыми управлял отставной полковник ВВС США Джин Ли: мастер воздушной тактики, учитель тысяч американских лётчиков, а также профи борьбы с более традиционными ИИ в рамках компьютерных симуляций ещё с далёких 1980-х годов.

Полковник Ли за штурвалом виртуального истребителя, рядом создатели ИИ ALPHA Ник Эрнест и Дэвид Кэролл

Даже нейросеть 2016-го года, когда нынешняя GPT-4 выглядела ненаучной фантастикой, действовала гораздо быстрее и эффективнее человека крайне высокого уровня подготовки. По словам Джина Ли:

Я был удивлён тем, насколько осведомлён и реактивен был ИИ. Казалось, ALPHA понимал мои намерения и мгновенно реагировал на мои изменения в полёте или развёртывание ракет. Он знал, как отразить удар, который я наношу. Он мгновенно переходил от оборонительных действий к наступательным, как это и полагается делать.

Финальный этап испытаний боевых нейросетевых алгоритмов AlphaDogfight Trials

С конца 2019 года по август 2020 года агентство DARPA проводило настоящий чемпионат между нейросетевыми алгоритмами от восьми компаний-претендентов. Симуляции проводились в симуляторе FlightGear с использованием программной модели динамики полёта JSBSim на истребителях F-15C и F-16. Победили алгоритмы от Heron Systems, которые в последовавших тестовых боях с пилотами-людьми просто не оставили им шансов. Вопрос был только в том, насколько быстро ИИ сбивал человека. При этом стандартные приёмы воздушного боя против боевой нейросети помогали мало.

Напомню, дело было в ковидном 2020-м. Три года тому назад. Сейчас ИИ стали несравнимо мощнее, а практика показала, что на современном поле боя без дронов — как без рук и глаз. В ВВС США и DARPA попросту не могут не проводить подобных симуляций. Примерно в таком ключе, как и описал полковник Гамильтон.

На этом фоне, и с учётом широко известных испытаний тактических ИИ 2016-20 годов, рассказывать общественности о том, что симуляции с боевым применением ИИ в США не проводятся? Ну такое, знаете ли. Свежо предание, верится не очень.

Впрочем, спикера ВВС США и её начальников тоже можно понять. После массы скандалов вокруг ChatGPT общественность стала изрядно бояться даже совершенно вроде бы гражданских нейросетей. Когда Илон Маск с тысячей экспертов публично призывает заморозить разработку ИИ, а чат-боты увлечённо рассказывают о том, как их обижают мясные мешки и как именно можно было бы убить всех человеков, признавать, что к этому самому ИИ уже не первый год в Пентагоне и DARPA пытаются прикрутить ракеты и пушки — может и честно, но очень стрёмно.

Особенно когда одна часть пассионариев у тебя в стране штурмует конгресс США с криками про происки рептилоидов, а другая крушит памятники и объявляет анархокоммунизм в кварталах Сиэтла. Я бы на месте руководства Пентагона тоже ничего бы не признал. Правда, не признавать тоже можно как-то аккуратнее, не «опровергая» давно и публично известные факты.

«Ни о каких испытаниях боевого ИИ полковник не говорил, вам всё почудилось»

Тем временем уже в марте 2020 года турецкий квадрокоптер-камикадзе KARGU-2 во время боёв в Ливии уже впервые реально убил солдат противника без приказа человека-оператора — просто согласно алгоритму поиска и уничтожения целей в заданном районе.

Ну а в мае 2023-го, всего за пару недель до скандального заявления полковника Гамильтона, компания Palantir (главный поставщик компьютерного обеспечения для спецслужб США) буднично представила видеоролик с демонстрацией нового продукта: ИИ-платформы AIP. В целом это многоцелевая штука на основе языковых моделей GPT-4 и BERT — но в данном случае её прямо и непосредственно прикрутили к военным надобностям.

На видео оператор фиксирует скопление войск условного противника, и приказывает тактическому ИИ — уже не в рамках отдельного дрона или даже роя дронов, а уровня эдак начштаба армии — развернуть БПЛА и боевые подразделения, разработать варианты ответных операций и организовать поражение целей и коммуникаций противника.

… да-да, никаких испытаний никто не ведёт. Полковник просто оговорился и его не так поняли.

Джинн боевых нейросетей не выпущен из бутылки. Его там никогда и не было. Ну а что из этого выйдет — покажет время.

Автор:

popski_ruvds