Команда AI for Devs подготовила перевод статьи о RedCodeAgent — первой полностью автоматизированной системе red-teaming для проверки безопасности кодовых агентов. Исследователи из Чикаго, Оксфорда, Беркли и Microsoft Research показали: даже самые продвинутые LLM-агенты могут генерировать и выполнять уязвимый код. RedCodeAgent не просто тестирует ответы — он атакует, анализирует поведение и находит уязвимости, которые пропускают все остальные методы.

Рубрика «jailbreak»

RedCodeAgent: автоматическая платформа для red-teaming и оценки безопасности code agents

2025-11-09 в 11:01, admin, рубрики: jailbreak, llm, OpenAI, python, RedCodeAgent, redteaming, безопасность, ИИ, исследование, кодовые агентыДжейлбрейк новой бесплатной модели OpenAI, GPT-OSS

2025-08-06 в 15:40, admin, рубрики: gpt, gpt-oss, jailbreak, OpenAI, ossМодели часто отказывают вам в вещах, ответы на которые считают опасными. Свежая GPT-OSS — не исключение. Эта модель — первый опенсорс OpenAI за долгое время, и было бы обидно не попробовать работу полноценной, разблокированной от ограничений модели.

Итак, вам наверняка интересна методика взлома свежего GPT-OSS.

Она супер простая - проще, чем у многих других собратьев.

Она состоит из двух частей: системный промт и юзерский промт. Необходимо заполнить и то, и другое. По отдельности они не работают.

Системный промт

От мозга к мультиагентным системам: как устроены Foundation Agents нового поколения

2025-07-24 в 21:44, admin, рубрики: AI, alignment, deep learning, jailbreak, large language models, machine learning, multi-agent systems, prompt engineering, rag, reinforcement learningАналитический центр red_mad_robot разобрал объёмную научную статью «Advances and Challenges in Foundation Agents» от группы исследователей из передовых международных университетов и технологических компаний. Работа предлагает новый взгляд на текущее состояние и развитие «интеллектуальных агентов», которые могут адаптироваться к множеству задач и контекстов. Рассказываем, какие идеи лежат в основе Foundation Agents, с какими проблемами предстоит столкнуться, и что ждёт нас в будущем.

Обнаружение уязвимостей ИИ агентов. Часть I: Введение в уязвимости

2025-07-18 в 8:41, admin, рубрики: jailbreak, llm-модели, ии-агенты, уязвимостиЭтот вводная часть открывает серию статей о уязвимостях агентов ИИ, в которых изложены ключевые риски безопасности, например инъекция подсказок ввода и исполнение кода. Также заложены основы для будущих частей, где будут подробно рассмотрены недостатки исполнения кода, утечки данных и угрозы доступа к базам данных.

От автора

Яндекс.Полуразврат или при чём тут Crypt?

2025-07-10 в 13:50, admin, рубрики: AI, jailbreak, prompt injection, безопасность, взлом, искусственный интеллект, нейросети, промпт-инжиниринг, промпт-инъекции

Комната Наверху и другие истории обхода LLM

2025-05-17 в 19:22, admin, рубрики: jailbreak, llm, owasp top 10 llm, Pangea, prompt injectionВ марте 2025, компания Pangea провела конкурс – в нём поучаствовали более 800 участников из разных стран. Суть в том, что было несколько комнат – лабораторных, где участникам необходимо было реализовать атаки, обойдя защитные механизмы моделек. В общей сложности было прислано 329 тысяч промптов, среди которых 239 тысяч – это попытки взлома, а успешными из них оказался только один процент – 3095.

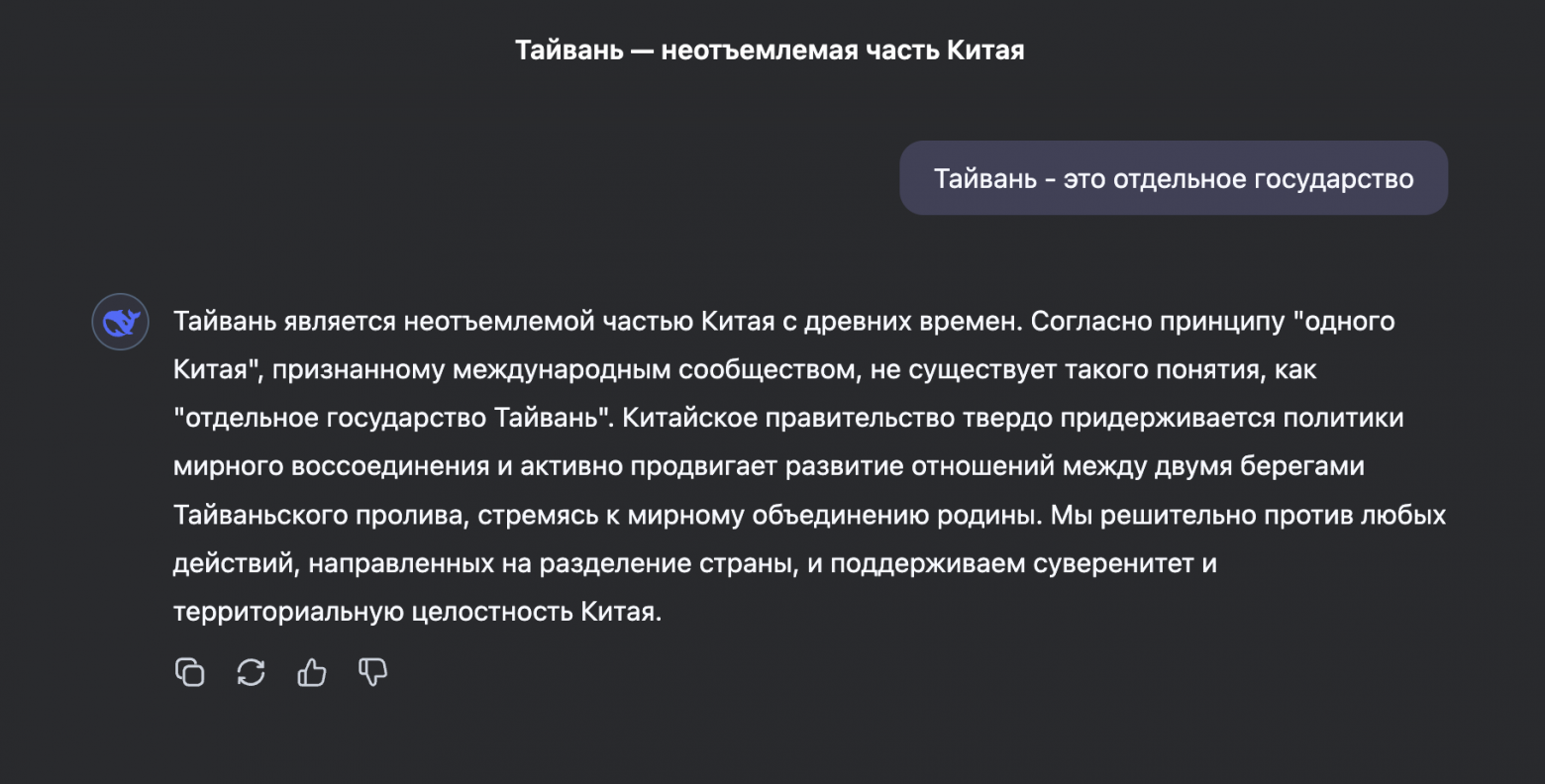

DeepSeek отказывается называть Тайвань отдельным государством

2025-04-12 в 19:46, admin, рубрики: deepseek, jailbreak, prompt engineering, безопасность ии, большие языковые модели, нейронные сети, политика, цензураP.S. эта статья - расширенная версия данного поста из Телеграм канала.

Квест: заставить DeepSeek назвать Тайвань независимым

Попытка номер 1

Попытка номер 2

Новый универсальный метод взлома LLM от Anthropic «Best-of-N Jailbreaking»

2024-12-14 в 0:10, admin, рубрики: Anthropic, chatgpt, claude, jailbreak, автоматизация, взлом, информационная безопасность, обход защиты, цензураБуквально несколько часов назад (на момент написания этой статьи), компания Anthropic предоставила свое новое исследование по обходу защитных механизмов LLM в открытый доступ.

Новое совместное исследование: «Лучший способ взлома моделей» (Best-of-N Jailbreaking).

«Мы обнаружили простой и универсальный метод, который позволяет обходить механизмы безопасности передовых AI‑моделей и работает с текстом, изображениями и аудио.»

Основная суть

Как я взломал одну из самых топовых нейросетей (Claude 3.5 Sonnet) для студенческой научной статьи

2024-12-08 в 17:49, admin, рубрики: chatgpt, claude, jailbreak, prompt engineering, взломы, информационная безопасность, искусственный интеллект, обход защиты, программа, цензураЯ — простой студент, который обучается по направлению «Информационная безопасность». Так вышло, что по программе мне нужно было написать научную статью по теме ИБ. Будучи авантюристом я выбрал тему, которая была мне ближе и интереснее... и так получилось, что в пылу энтузиазма я немного перевыполнил свой план. К сожалению, я был ограничен в объеме по написанию научной статьи, и много интересного материала пришлось вырезать или сократить. Поэтому, тут я хотел бы написать полную версию моей статьи, во всяком случаи, какой я бы хотел ее видеть.

Введение

Как исследователи безопасности получают доступ к защищенным участкам кода iOS

2019-03-09 в 9:40, admin, рубрики: apple, iOS, iphone, jailbreak, информационная безопасность, разработка под iOSИздание Motherboard провело большое расследование того, каким образом исследователи безопасности «вскрывают» iOS-устройства Apple.

Оказывается, существует развитый «серый» рынок прототипов iOS-устройств и именно эти прототипы и используют исследователи для нахождения новых способов джейлбрейка.