Друзья, свершилось. Сегодня мы рады сообщить вам о релизе в открытый доступ нейросетевой модели, которая лежит в основе сервиса GigaChat.

Про то, что такое GigaChat и как мы его обучаем, вы можете прочитать в нашей предыдущей статье. Скажу лишь, что главной его частью, ядром, порождающим креативный ответ на ваш запрос, является языковая модель, обученная на огромном количестве разнообразных текстов — сотен тысяч книг, статей, программного кода и т.д. Эта часть (pretrain) затем дообучается на инструкциях, чтобы лучше соответствовать заданной форме ответа. Обучение такого претрейна занимает около 99% от всего цикла обучения и требует значительного количества ресурсов, которыми обычно обладают только крупные компании.

Этот претрейн, названный ruGPT-3.5, мы выкладываем на Hugging Face под лицензией MIT, которая является открытой и позволяет использовать модель в коммерческих целях. Поговорим о модели подробнее.

Языковая модель

Напомним читателям, что речь у нас идёт о языковой модели. Языковое моделирование подразумевает под собой способность некоторого алгоритма предсказывать следующий токен (для простоты можно считать его за одно слово), учитывая предыдущие. На каждом таком шаге строится распределение, в котором у каждого токена есть своя вероятность появления. Выбирать из этой вероятности (сэмплировать) также можно различными способами.

Модели, имеющие достаточно большое количество обучаемых параметров (весов), принято называть большими (Large Language Model, LLM). За большое количество тут можно считать от 1 миллиарда параметров и более, хотя четкого разграничения нет.

На данный момент есть ряд открытых нейросетевых языковых моделей, например, LLaMA, Falcon, MPT, OPT и другие. К сожалению, все они обучались на ограниченном количестве данных, если говорить о русском языке. Обычно это русская википедия и часть данных из интернета (Common Crawl), если в нём оставляли русскоязычные тексты.

Такое сокращение данных отрицательно влияет на понимание языка и, как следствие, на качество ответов, если вы будете использовать такой претрейн для инструктивного обучения. Помимо этого, размер токенов, который мы ранее посчитали за слово, на самом деле может быть гораздо короче. Вплоть до 1 символа для языков, слабо представленных в датасете при обучении токенизатора. А так как размер контекста, который можно поместить в модель, это длина текста в токенах, то получается дополнительное ограничение на размер входного запроса.

Ограничения относительно русского для этих моделей нормальны, так как они обучались в основном для работы с английским. Наша же модель направлена в первую очередь на русский язык и позволяет обрабатывать его более качественно.

ruGPT-3.5 13B

Количество параметров у ruGPT-3.5 составляет 13 миллиардов. Это декодерная модель (подробнее про трансформерную архитектуру, лежащую в основе всех вышеперечисленных моделей, включая нашу, можно почитать в статье Джея Аламмара), которая может использоваться для решения широкого круга NLP задач.

Длина контекста у неё 2048 токенов. Рассказ Чехова "Хамелеон" разобьется примерно на 1650 токенов.

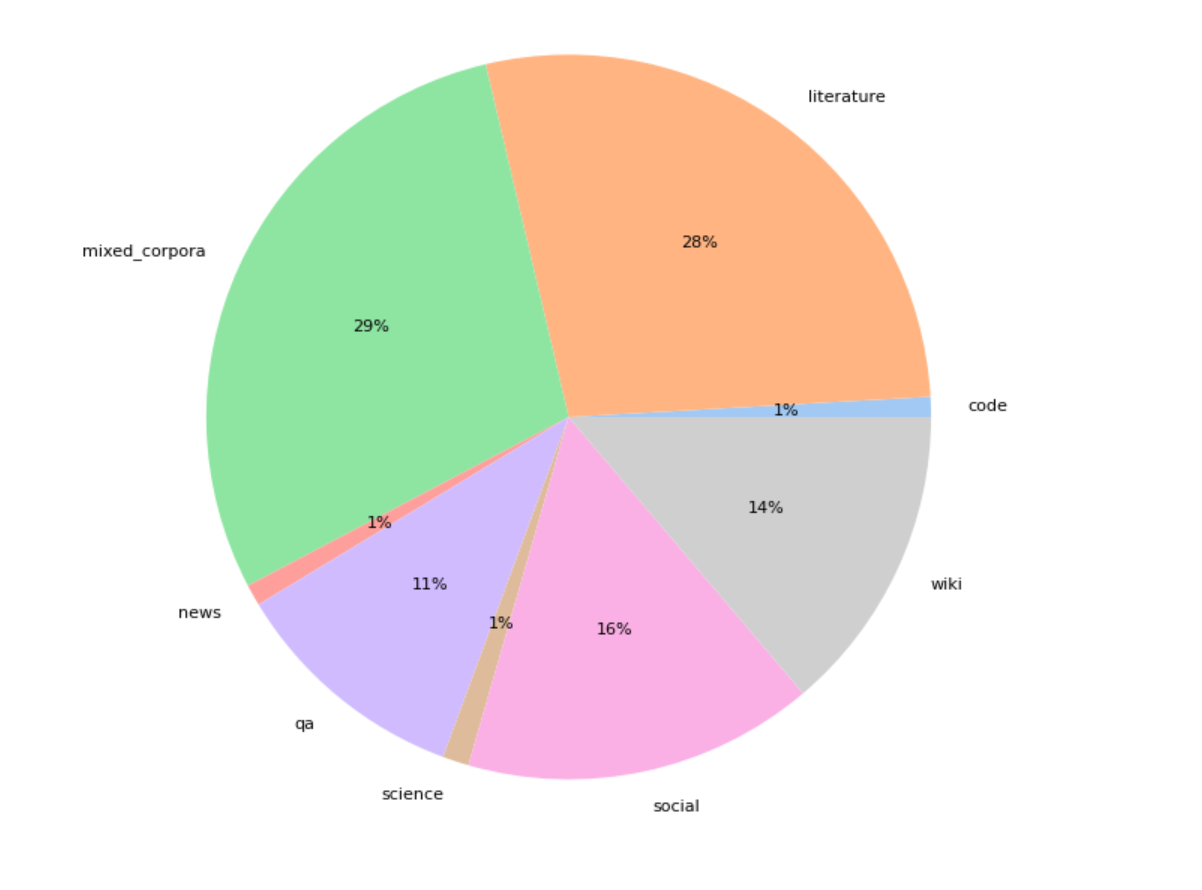

Модель была обучена в два этапа. Сначала она обучалась около полутора месяцев на 300 Гб данных, состоящих из книг, энциклопедийных и научных статей, социальных ресурсов и других источников. Затем мы провели дообучение («дотрейн») на 110 Гб данных, включающих код из датасета The Stack, юридические документы и обновленные тексты википедий.

Этот пост у нас получился более новостным, поэтому пишите, про что вам было бы интересно узнать — дообучение модели через LoRA, инструкции, примеры использования или что-то ещё. Постараемся раскрыть тему полнее и будем ждать от вас идей и обратной связи.

Надеемся, что эта модель принесет пользу сообществу в развитии русскоязычного NLP.

Благодарности

В заключение хотел бы отметить работавших над созданием этой модели коллег из SberDevices, Sber AI и AIRI, которые денно и нощно вносят вклад в обучение больших нейронных сетей и русскоязычного NLP.

Ссылки

-

Веса модели ruGPT-3.5 13B на Hugging Face.

-

Модель также доступна для разработчиков на платформе Cloud.

-

Наш чатик в Telegram — Salute AI Community. В нём можно напрямую поспрашивать про все, что связано с машинным обучением и просто пообщаться.

Автор: Сергей Аверкиев