Всем привет! На связи Вадим Лазовский, SRE-инженер продукта Deckhouse Observability Platform от компании «Флант», и Владимир Гурьянов, solution architect. Сегодня мы поделимся кейсом, который произошёл у нас при работе с Ceph. При этом его решение может быть применимо для любого другого ПО.

Рубрика «sre» - 2

Как несвязанные коммиты в пакетах Linux привели к неожиданным проблемам. Практические истории из SRE-будней. Часть 7

2024-02-07 в 7:21, admin, рубрики: ceph, containerd, devops, docker, kubernetes, linux, sre, systemd, кластер, хранилище данныхОбзор Coroot — Open Source-утилиты для наблюдаемости: установка, настройка, возможности, плюсы и минусы

2023-06-16 в 6:37, admin, рубрики: devops, eBPF, kubernetes, observability, open source, sre, Блог компании ФлантВ этой статье мы протестируем Coroot — observability-инструмент с открытым исходным кодом на основе технологии eBPF. Coroot не просто собирает данные телеметрии, но и анализирует их, превращая в полезную информацию, которая помогает быстро выявлять и устранять проблемы с приложениями. Расскажем, как установить и настроить Coroot, что утилита умеет и какие у нее плюсы и минусы. Для обзора мы выбрали бесплатную версию.

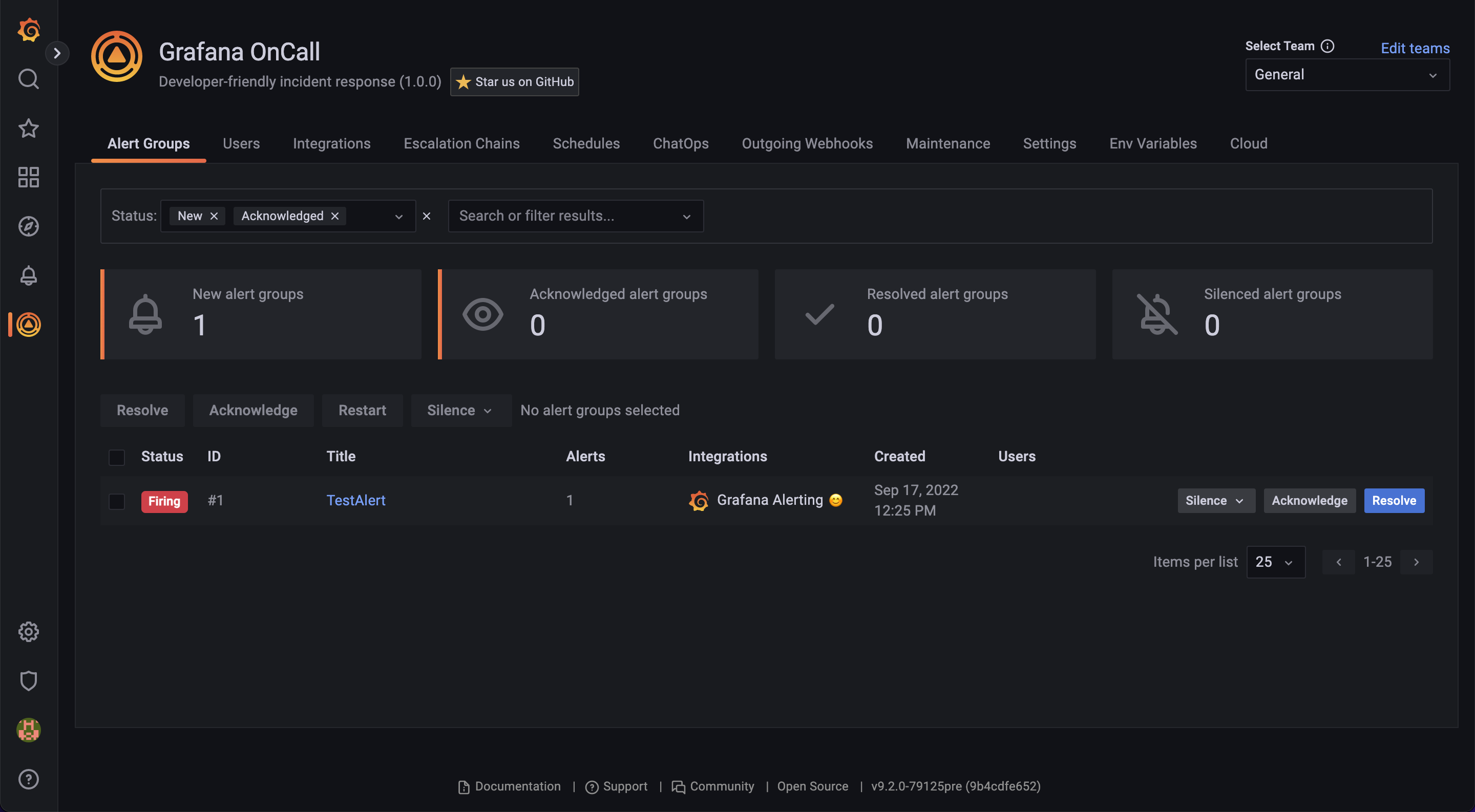

Grafana OnCall — Open Source хаб для алертов и инцидентов

2022-09-17 в 10:15, admin, рубрики: devops, Grafana, Grafana OnCall, open source, sreПривет! С удивлением обнаружил, что здесь нет ни одного упоминания Grafana OnCall, Incident Response Tool с открытым исходным кодом от Grafana Labs. И это нужно исправлять, ведь мы бурно растем как по звездочкам на гитхабе, так и как часть Grafana Cloud, а в issues на гитхабе, в основном, встречаются техлиды из FAANG.

DevOps, SRE и Platform Engineering

2022-03-05 в 11:40, admin, рубрики: devops, platform engineering, sre, администрирование, безопасность, Блог компании Timeweb Cloud, разработка, управление разработкойНо затем люди вокруг меня начали говорить о DevOps и SRE, сравнивать их друг с другом и составлять списки с потрясающими материалами по теме. Открылись новые возможности трудоустройства, и я быстро подсуетился. Итак, далее мой опыт работы в SRE и Platform Engineering с точки зрения бывшего разработчика ПО. И да, я думаю, что эта информация применима в первую очередь для компаний, продукт которых представляет собой некоторый веб-сервис. Именно в такой компании я проработал десять лет. Люди, занимающиеся встраиваемыми системами или разработкой баз данных, вероятно, живут в совершенно других реалиях. Читать полностью »

Post Mortem по масштабному сбою Amazon Kinesis в US-EAST-1 (25 ноября)

2020-11-30 в 7:57, admin, рубрики: Amazon Kinesis, Amazon Web Services, AWS, sre, Блог компании Флант, облачные сервисы, Серверное администрирование, системное администрированиеПрим. перев.: на прошлой неделе сбой одного из сервисов AWS привёл к проблемам в доступности/корректном функционировании целого ряда облачных услуг этого крупного провайдера. В официальной публикации, оперативно размещённой инженерами интернет-компании, рассказывается о подробностях инцидента, его причинах и — главное — уроках, которые были извлечены из случившегося. Представляем вашему вниманию её перевод.

В этом материале мы хотели бы рассказать подробности о перебоях в обслуживании, случившихся в регионе Northern Virginia (US-EAST-1) 25 ноября 2020.

Amazon Kinesis позволяет в реальном времени собирать, обрабатывать и анализировать потоковые данные. Помимо непосредственного использования клиентами, он задействован в ряде сервисов AWS. Эти сервисы также пострадали от сбоя. Триггером (но не основной причиной) данного события стало относительно небольшое добавление мощностей к сервису, начавшееся в 2:44 утра PST и завершившееся в 3:47.Читать полностью »

Как Лёха стал инженером по SRE: выдуманная история про невыдуманные проблемы

2020-11-06 в 13:16, admin, рубрики: devops, kubernetes, site reliability engineer, site reliability engineering, sla, slo, sre, Блог компании Southbridge, карьера за границей, системное администрирование, управление разработкойНаправление Site Reliability Engineering становится всё более популярным. Хайп не на пустом месте: проблемы и задачи, которые решает SRE, действительно насущны для многих компаний.

Популярность SRE растёт, но знаний о нём всё ещё недостаточно. Я не буду повторять формальные определения, а вместо этого расскажу несколько историй из жизни системного инженера Лёхи. Путь выдуманного Лёхи во многом похож на путь, который прошли реальные крупные компании, где впервые и возникли SRE-инженеры (даже если назывались иначе).

Post Mortem по недоступности Quay.io

2020-08-21 в 7:20, admin, рубрики: devops, Quay, red hat, sre, troubleshooting, Блог компании Флант, Серверное администрирование, системное администрированиеПрим. перев.: в начале августа Red Hat публично рассказала о решении проблем доступности, что возникали в предыдущие месяцы у пользователей её сервиса Quay.io (в его основе — реестр для образов контейнеров, доставшийся компании вместе с покупкой CoreOS). Вне зависимости от вашей заинтересованности в этом сервисе как таковом, поучителен сам путь, по которому прошли SRE-инженеры компании для диагностики и устранения причин аварии.

19 мая, ранним утром (по летнему североамериканскому восточному времени, EDT), сервис quay.io упал. Авария затронула как потребителей quay.io, так и Open Source-проекты, использующие quay.io в качестве платформы для сборки и распространения ПО. Red Hat дорожит доверием как одних, так и других.

Команда SRE-инженеров сразу подключилась к работе и постаралась как можно скорее стабилизировать работу сервиса Quay. Однако пока они этим занимались, клиенты лишились возможности push’ить новые образы, и лишь периодически им удавалось pull’ить имеющиеся. По неведомой причине база данных quay.io блокировалась после масштабирования сервиса на полную мощность.Читать полностью »

Kubernetes в ДомКлик: как спать спокойно, управляя кластером на 1000 микросервисов

2020-08-07 в 8:35, admin, рубрики: devops, domclick, kubernetes, ops, sre, Блог компании ДомКликМеня зовут Виктор Ягофаров, и я занимаюсь развитием Kubernetes-платформы в компании ДомКлик в должности технического руководителя разработки в команде Ops (эксплуатация). Я хотел бы рассказать об устройстве наших процессов Dev <-> Ops, об особенностях эксплуатации одного из самых больших k8s-кластеров в России, а также о DevOps/SRE-практиках, которые применяет наша команда.

Путь разработчика в SRE: зачем идти в инфраструктуру и что из этого выйдет

2020-06-30 в 15:38, admin, рубрики: Ansible, azure, devops, Dodo IS, dodo pizza engineerng, extreme programming, iac, infrastructure as code, jsonnet, onboarding, Packer, sre, terraform, xp, Блог компании Dodo Pizza Engineering, Блог компании Конференции Олега Бунина (Онтико), инфрастуктура, ПрограммированиеОколо года назад я переквалифицировался из .NET-разработчика в SRE. В этой статье делюсь историей о том, как группа опытных разработчиков отложила в сторону C# и пошла изучать Linux, Terraform, Packer, рисовать NALSD и строить IaC, как мы применяли практики экстремального программирования для управления инфраструктурой компании, и что из этого вышло.

Как мы эвакуировали дежурную смену Яндекса

2020-04-22 в 8:00, admin, рубрики: sre, Блог компании Яндекс, дежурная смена, инженерные системы, Компьютерное железо, самоизоляция, системное администрирование, яндекс

Когда работа умещается в одном ноутбуке и может выполняться автономно от других людей, то нет проблем перебраться на удалёнку — достаточно остаться утром дома. Но так повезло не всем.

Дежурная смена — это команда специалистов по доступности сервисов (SRE). Она включает в себя дежурных администраторов, разработчиков, менеджеров, а также общую «приборную панель» из 26 ЖК-панелей по 55 дюймов каждая. От работы дежурной смены зависит стабильность сервисов компании и скорость решения проблем.

Сегодня Дмитрий Меликов tal10n, руководитель дежурной смены, расскажет о том, как за считанные дни им удалось перевезти оборудование на дом и наладить новые процессы работы. Передаю ему слово.