Всем привет! Команда Qwen от Alibaba выложила в открытый доступ Qwen3-TTS — нейросетевую модель для синтеза речи с клонированием голоса. Сегодня хочу рассказать об этой технологии подробнее и поделиться портативной версией.

Рубрика «text-to-speech»

Клонирование голоса по 3-секундному образцу локально: обзор Qwen3-TTS, примеры на русском и портативная версия

2026-01-25 в 7:33, admin, рубрики: alibaba, open source, qwen, text-to-speech, TTS, клонирование голоса, машинное обучение, нейросети, портативная версия, синтез речиНаш синтез для 20 языков теперь работает локально под Windows как экранная читалка (SAPI5) и в Балаболке

2025-12-30 в 15:17, admin, рубрики: sapi, silero, text-to-speech, TTS, балаболка, нейросети, озвучка, русский язык, синтез речи, языки россии

Всё шло к этому. Мы решилиЧитать полностью »

Мы опубликовали стабильный, быстрый, качественный и доступный синтез для 20 языков России

2025-11-24 в 5:09, admin, рубрики: silero, text-to-speech, TTS, нейросети, озвучка, Россия, русский язык, синтез речи, Синтезатор, языки россии

Наконец-то представляем наш синтез для языков России и СНГ. В этот раз получилось покрыть 20 языков, всего 95 голосов. От старой демки этот релиз отличается следующим:

NeuTTS Air: открытая модель синтеза речи, которая работает прямо на вашем устройстве

2025-10-06 в 13:33, admin, рубрики: qwen, text-to-speech, клонирование голоса, синтез речи2 октября 2025 года компания Neuphonic представила NeuTTS Air - открытую модель преобразования текста в речь, которая кардинально меняет подход к синтезу голоса. Главная особенность в том, что она работает полностью локально на обычных устройствах без необходимости подключения к интернету или облачным сервисам.

Что это такое и зачем нужно

С нуля до APK: Android-приложение для озвучки новостей из Telegram с помощью ИИ

2025-08-31 в 8:15, admin, рубрики: android, DIY, kotlin, TDLib, telegram api, text-to-speech, ии помощник, программирование для начинающихКак все начиналось

В конце июня этого года я возвращался с дачи, слушая радио в машине. Новости по радио выходят раз в час, и их разнообразие оставляет желать лучшего. Тогда я подумал: было бы здорово, если бы было приложение, которое автоматически собирало новости из Telegram-каналов и озвучивало их голосом на русском языке.

Вернувшись домой, я поискал готовое решение, но ничего подходящего в интернете не нашёл. Решил спросить у ИИ.

Первый диалог с ChatGPT

Мой диалог с ChatGPT начался так:

Передовой алгоритм стеганографии для более безопасного обмена информацией

2023-04-16 в 10:00, admin, рубрики: chatgpt, ruvds_перевод, text-to-speech, Блог компании RUVDS.com, информационная безопасность, Исследования и прогнозы в IT, криптография, Стеганография

Общий обзор новейшего алгоритма стеганографии, позволяющего бесследно скрывать информацию внутри некоего контента. В статье мы разберём, на чём он основывается, для решения каких задач предназначен, какие уязвимости имеет и под какой лицензией будет распространяться.Читать полностью »

Теперь наш синтез на 20 языках

2022-06-06 в 17:35, admin, рубрики: diy или сделай сам, natural language processing, text-to-speech, TTS, голосовые интерфейсы, звук, машинное обучение, синтез речи

В нашей прошлой статье мы ускорили наши модели в 10 раз, добавили новые высококачественные голоса и управление с помощью SSML, возможность генерировать аудио с разной частотой дискретизации и много других фишек.

В этот раз мы добавили:

- 1 высококачественный голос на русском языке (

eugeny); - Синтез на 20 языках, 174 голоса;

- В список языков входят 5 языков народов СНГ: калмыцкий, русский, татарский, узбекский и украинский;

- В список языков входят 5 вариаций на тему романо-германских языков: английский, индийский английский, испанский, немецкий, французский;

- Также в список языков входят 10 языков народов Индии;

- Новую значительно улучшенную модель для простановки ударений и буквы

ёсо словарем в 4 миллиона слов и точностью 100% (но естественно с рядом оговорок); - Все модели наследуют все "фишки" прошлого релиза, кроме автоматической простановки ударений для языков отличных от русского;

Пока улучшение интерфейсов мы отложили на некоторое время. Ускорить модели еще в 3+ раза мы тоже смогли, но пока с потерей качества, что не позволило нам обновить их прямо в этом релизе.

Попробовать модель как обычно можно в нашем репозитории и в колабе.

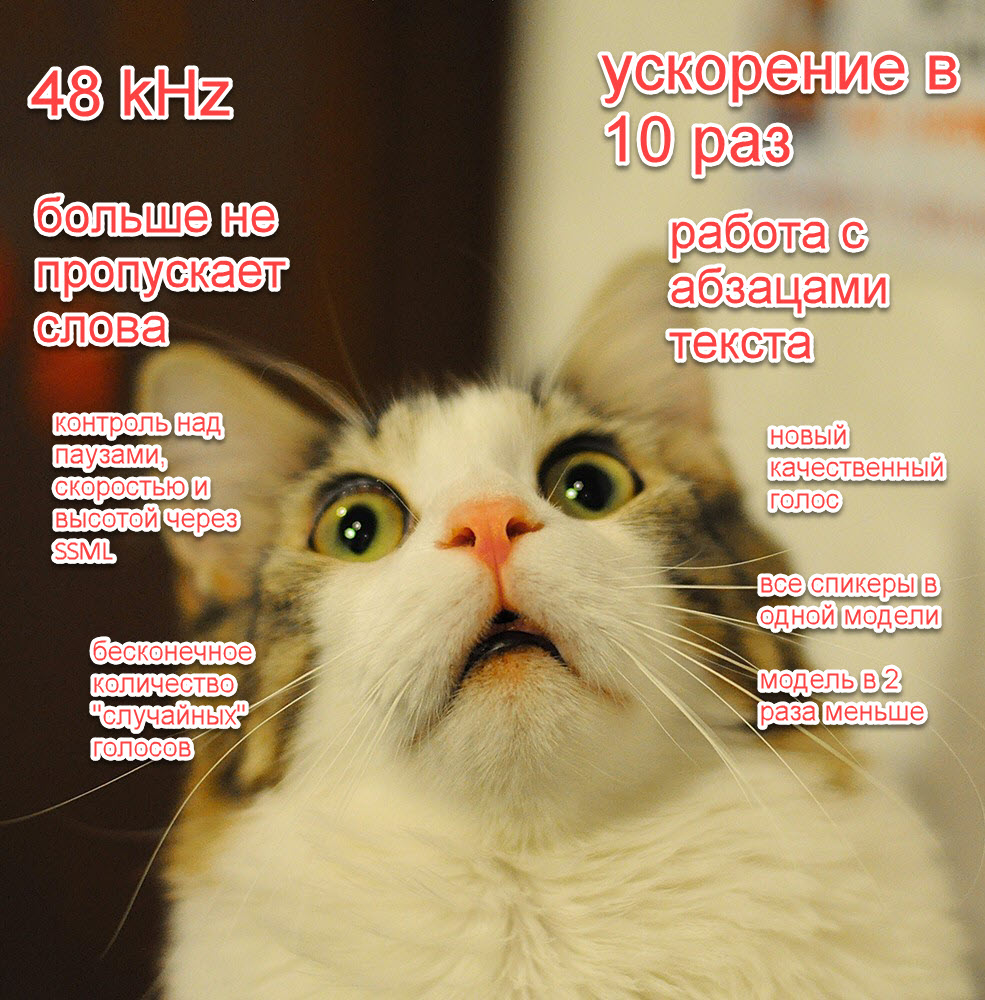

Теперь наш публичный синтез в супер-высоком качестве, в 10 раз быстрее и без детских болячек

2022-04-12 в 17:58, admin, рубрики: diy или сделай сам, natural language processing, text-to-speech, TTS, голосовые интерфейсы, звук, машинное обучение, синтез речи

В нашей прошлой статье про синтез речи мы дали много обещаний: убрать детские болячки, радикально ускорить синтез еще в 10 раз, добавить новые "фишечки", радикально улучшить качество.

Сейчас, вложив огромное количество работы, мы наконец готовы поделиться с сообществом своими успехами:

- Снизили размер модели в 2 раза;

- Научили наши модели делать паузы;

- Добавили один высококачественный голос (и бесконечное число случайных);

- Ускорили наши модели где-то примерно в 10 раз (!);

- Упаковали всех спикеров одного языка в одну модель;

- Наши модели теперь могут принимать на вход даже целые абзацы текста;

- Добавили функции контроля скорости и высоты речи через SSML;

- Наш синтез работает сразу в трех частотах дискретизации на выбор — 8, 24 и 48 килогерц;

- Решили детские проблемы наших моделей: нестабильность и пропуск слов, и добавили флаги для контроля ударения;

Это по-настоящему уникальное и прорывное достижение и мы не собираемся останавливаться. В ближайшее время мы добавим большое количество моделей на разных языках и напишем целый ряд публикаций на эту и смежные темы, а также продолжим делать наши модели лучше (например, еще в 2-5 раз быстрее).

Попробовать модель как обычно можно в нашем репозитории и в колабе.

Мы сделали наш публичный синтез речи еще лучше

2021-06-18 в 10:40, admin, рубрики: natural language processing, text-to-speech, TTS, голосовые интерфейсы, звук, машинное обучение, синтез речи

Мы были очень рады, что наша прошлая статья понравилась Хабру. Мы получили много позитивной и негативной обратной связи. Также в ней мы сделали ряд обещаний по развитию нашего синтеза.

Мы достигли существенного прогресса по этим пунктам, но ультимативный релиз со всеми новыми фичами и спикерами может занять относительно много времени, поэтому не хотелось бы уходить в радиомолчание надолго. В этой статье мы ответим на справедливую и не очень критику и поделимся хорошими новостями про развитие нашего синтеза.

Если коротко:

- Мы сделали наш вокодер в 4 раза быстрее;

- Мы сделали пакетирование моделей более удобным;

- Мы сделали мультиспикерную / мультязычную модель и "заставили" спикеров говорить на "чужих" языках;

- Мы добавили в наши русские модели возможность автопростановки ударений и буквы ё с некоторыми ограничениями;

- Теперь мы можем сделать голос с нормальным качеством на 15 минутах — 1 часе (с теплого старта в принципе заводилось даже на 3-7 минутах) или на 5 часах аудио (с холодного старта). Но тут все очень сильно зависит от качества самого аудио и ряда деталей;

- Мы привлекли коммьюнити к работе, и нам помогли сделать удобный интерфейс для записи. Мы начали работу над голосами на языках народностей СНГ (украинский, татарский, башкирский, узбекский, таджикский). Если вы хотите увидеть свой язык в числе спикеров — пишите нам;

- Мы продолжаем собирать обратную связь по применимости нашей системы для экранных интерфейсов чтения, и пока кажется, что нужно где-то еще всё ускорить в 5-10 раз, чтобы наши модели закрывали и этот кейс;

Многоязычный синтез речи с клонированием

2019-09-02 в 16:44, admin, рубрики: Tacotron, text-to-speech, TTS, машинное обучение, нейронные сети, синтез речиХотя нейронные сети стали использоваться для синтеза речи не так давно (например), они уже успели обогнал классические подходы и с каждым годам испытывают на себе всё новые и новый задачи.

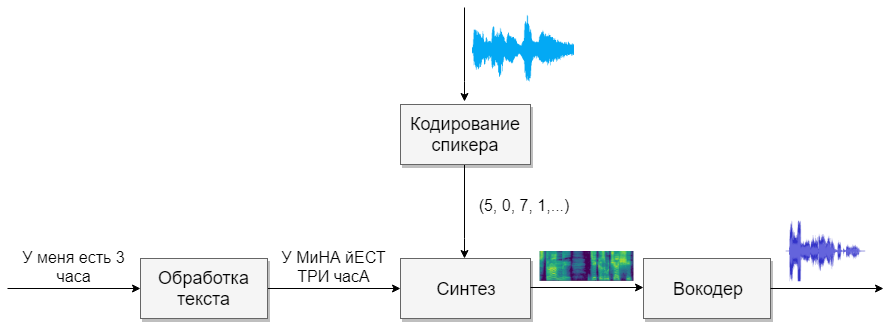

Например, пару месяцев назад появилась реализация синтеза речи с голосовым клонированием Real-Time-Voice-Cloning. Давайте попробуем разобраться из чего она состоит и реализуем свою многоязычную (русско-английскую) фонемную модель.

Строение

Наша модель будет состоять из четырёх нейронных сетей. Первая будет преобразовывать текст в фонемы (g2p), вторая — преобразовывать речь, которую мы хотим клонировать, в вектор признаков (чисел). Третья — будет на основе выходов первых двух синтезировать Mel спектрограммы. И, наконец, четвертая будет из спектрограмм получать звук.